本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

在质疑自家发表在Nature上的论文成果后,这位谷歌研究员被解雇了。

去年6月,谷歌在Nature上发表了一篇文章:A graph placement methodology for fast chip design,其中Jeff Dean是作者之一。

文章中表示,AI能在6个小时内生成芯片设计图,而且比人类设计得更好。

但这位研究员认为文章的一些论断站不住脚,以及实验尚未经过充分的测试。

不过他只是在内部表达了下想法,结果验证自己观点的论文,直接被谷歌拦截、没能对外发表。

(网友想看预印本都看不到)

随后谷歌的最新回应证实,这位研究员已于今年3月“因故”被解雇。

值得一提的是,这已经不是第一次谷歌员工“因言获罪”了。

也就一年半的时间,谷歌已经传出三位技术人员遭解雇。

AI芯片设计能力超过人类?

这次牵涉其中的论文,于去年4月13日被《Nature》接收,6月9日发表。

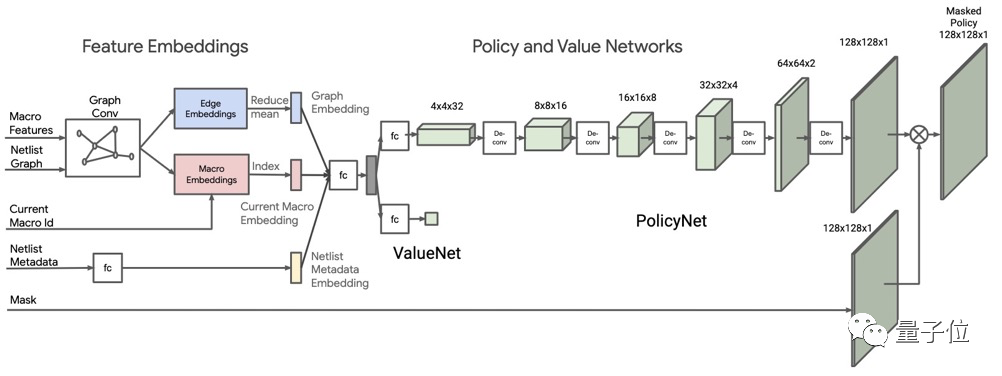

它主要讨论了一种用深度强化学习来快速设计芯片的方法。

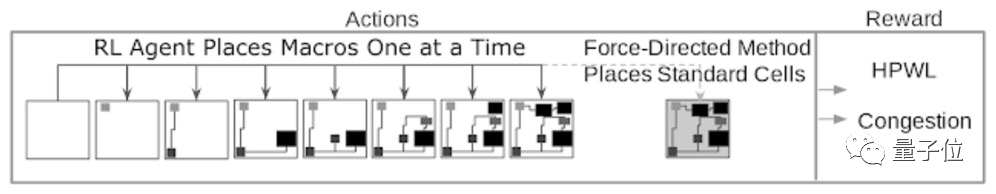

论文中表示,通过此方法,AI只需不到6小时的时间,就能设计出一块芯片;而人工往往要花费数周或数月才能做到。

具体来看,这是一种具有泛化能力的芯片布局方法。

AI通过学习10万个芯片布局,这种方法就能自己设计出新的方案来,并且所有关键指标(包括功耗、性能和芯片面积)都和人工设计的不相上下。

为了提高AI的学习效率,研究人员还设计了一种奖励机制,基于线路长度和布线拥塞的近似代价函数进行计算。

具体来说,需要将宏和标准单元映射到一个平面画布上,形成具有数百万到数十亿节点的“芯片网表”。

然后,AI模型会对功率、性能和面积(PPA) 等进行优化,并且输出概率分布。

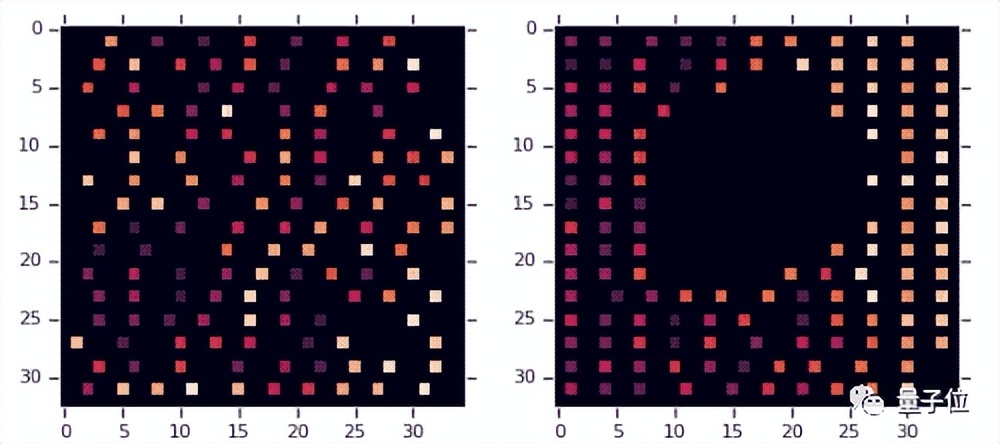

下图分别是零样本生成和基于预训练策略微调的效果,其中每个小矩形代表一个宏块。在预训练策略中,中间留出了用于放置标准单元的空间。

这篇论文的共同通讯作者Anna D Goldie表示,

这种方法适用于任何类型的芯片设计,并且已经被用在生产下一代Google TPU上。

质疑起始于2020年

但在“取得重大突破”的背后,谷歌内部关于这项技术的质疑,其实从2020年就开始了。

提出质疑的正是今年3月被解雇的谷歌大脑员工——Chatterjee博士。

他毕业于UC伯克利计算机系,曾在英特尔工作过,主要从事通信协议高层建模和验证方面的研究。

2020年,谷歌提出了一种利用机器学习设计芯片的方法,它可以被视作是登上Nature成果的前身。

当时,谷歌曾向Chatterjee博士询问这种方法可否出售或者授权给一些芯片设计公司。

在回复邮件中,Chatterjee博士表示,对论文中的一些说法持保留意见,并质疑这项技术是否经过了严格的测试。

不过这些质疑似乎并未影响到谷歌的脚步。

一年之后,他们便将这一尚存在质疑的成果,投稿到了Nature而且成功发表。

与最初研究不同的是,登上Nature的论文对此前方法做了一些调整,同时还删除了两位作者的名字。

因为他们曾与Chatterjee博士密切合作,并同样对这项成果存在疑虑。

而谷歌的骚操作到这还没完,他们还亲自示范了一遍,什么叫“规矩是死的人是活的”。

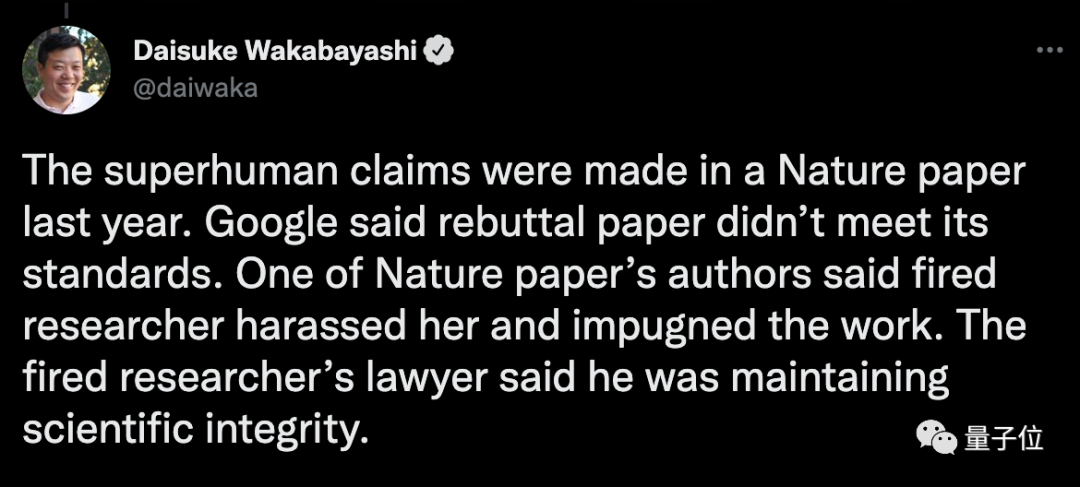

这一边,投稿到Nature的论文被质疑,没有严格遵循发表审批流程。

谷歌和该论文的共同通讯作者Anna D Goldie对此回应称,因为这篇论文对此前成果的改动不大,因此不需要走完整的审批流程。

但是另一边,Chatterjee博士开展的关于质疑这一成果的论文,最终却没通过审查。

他们将反驳此方法的论文提交给了一个决议委员会,以获批发表。

结果几个月后,这篇论文被拒了。

理由是:不符合标准。

据《纽约时报》披露,Chatterjee博士团队被谷歌告知,他们是不会发表一篇质疑《Nature》成果的论文的。

而且一份书面报告证明,Chatterjee博士已经被谷歌解雇。

谷歌副总裁Zoubin Ghahramani对此事回应称:

我们彻底调查了那篇《Nature》论文的底稿,并坚持同行审议的结果。

同时我们也严格调查了随后提交的一份文件,它不符合我们的出版标准。

与此同时,有知情人士透露,这项成果的作者之一说“被解雇的人员骚扰她、质疑她的工作”。

而“被解雇人员”的律师对此回应:他是在维护科学的完整性。

意见不合就解雇?

前面提到,这也不是第一次谷歌管理层与研究人员之间的冲突了。

此前最典型一次,就是谷歌AI伦理团队联合负责人Timnit Gebru解雇事件。

当时这件事直接引发1400名谷歌员工和1900名AI学术圈人士对谷歌的行为表示谴责,并让Jeff Dean成为众矢之的。

据本人推文以及之后姐夫哥回应显示,核心矛盾正是双方在内部论文评审上的分歧。

在公开的邮件内容显示,她一直希望发表一篇“大语言模型存在偏见”论文,但是一直遭到上级反对。

此外她在邮件中透露,谷歌对黑人这一弱势群体的不公平对待,以及对AI伦理的不重视。

正是因为这封邮件,被爆出“不符合谷歌管理者的期望”,因而被解雇。

两个月后,AI伦理团队另一位负责人Margaret Mitchell,因用脚本在公司内网搜索支持Gebru的证据而被解雇。

又在去年4月,谷歌大脑创始成员之一Samy Bengio也离职加入苹果,不少人推测离职原因跟这件事情有关。

如今,又一位谷歌大脑成员遭解雇,一方面被认为是谷歌研究人员内部动荡的最新例证。

此前,谷歌的另一大研究团队DeepMind,也时不时爆出闹独立、与母公司闹掰等传闻。

另一方面是正如这位网友所说,整个科技行业所应对的难题:研究人员与企业之间的“适配”。

即便连谷歌这样的大厂,也没办法完全解决这一难题。

从企业角度来看,当然是将科研成果快速商业化实现营收为主。

但从技术人员的角度来看,任何一项科研都是件长期投入的事情,怎能容许为了短期利益而降格。

一旦遇到不适配,留给他们的只有两条路:

一条是仍留在产业界,换公司或者自己创业;

比如百度首席科学家吴恩达,负责百度研究院的领导工作,尤其是Baidu Brain计划,但待了三年之后离职,有了自己的创业项目。

另一条则是回归学界。

斯坦福大学教授李飞飞,17年入职谷歌,成为谷歌云AI负责人,一年之后离职重新回到斯坦福。

而这个难题对企业而言,目前还没有最优解。