本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

机器学习今年的热门研究,会是什么?

近日,有网友在Reddit开了这么一个盘,立刻吸引了大批MLer的注意。

有人提名自监督模型,有人认为表征学习越来越受到关注,还有人认为基于物理的机器学习才是未来的方向……

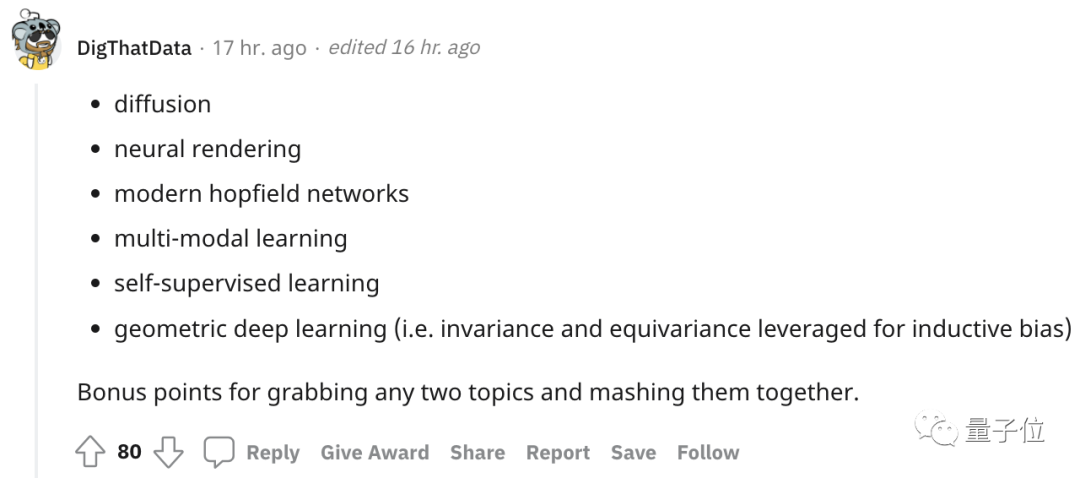

然而,目前从评论区最高赞数来看,上述的这几个方向都不是“赢家”。

截至目前,获赞最多的选手是——几何深度学习。

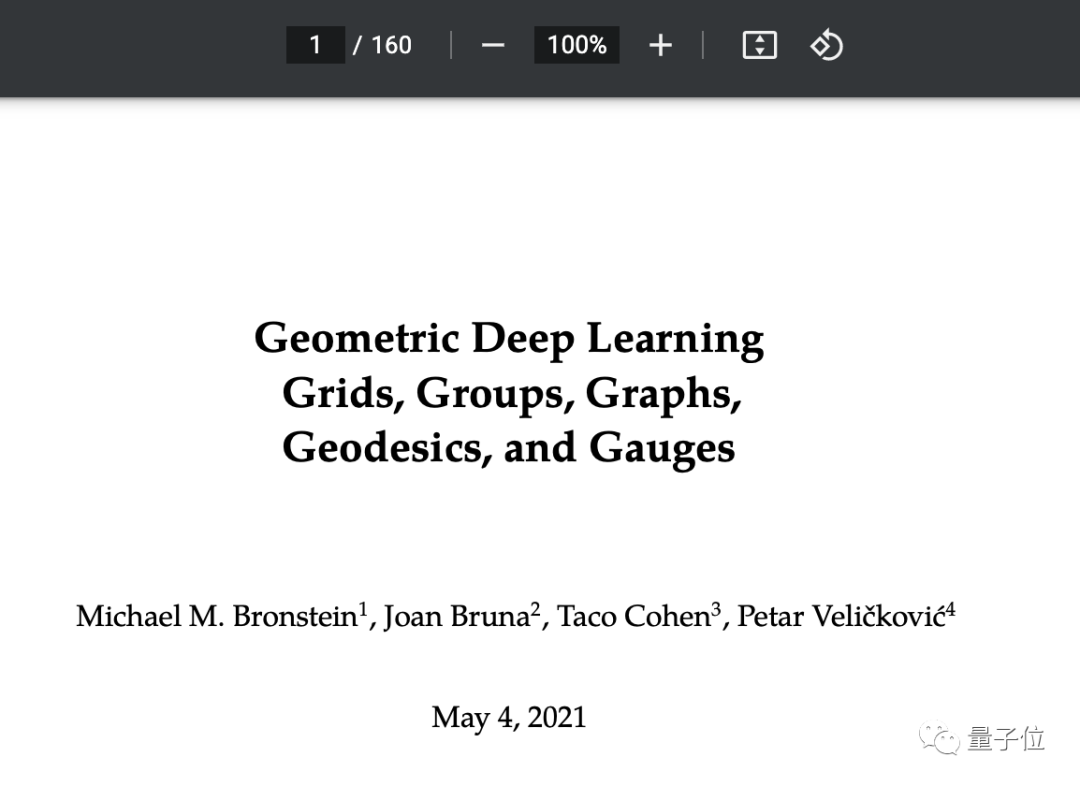

这项技术是因Twitter首席科学家、图机器学习大牛Michael Bronstein去年发表的一篇论文走入了大众视线。

(顺带一提那篇论文有160页)

那么问题就来了:

Top人气从何而来?

几何深度学习全名Geometric Deep Learning,最早是Michael Bronstein在2016年的一篇论文中引出的一个概念。

简单来说,这是一种试图从对称性和不变性的视角出发,从几何上统一CNNs、GNNs、LSTMs、Transformers等典型架构的方法。

在高赞评论的下方,有人用一个简单的例子解释了这种“对称性”:

传统网络认为“E”和“3”是不同的,但是具有镜像对称性(或π键旋转)的网络却会认为它们是一致的。

CNN就是这样,当不变性变得可平移(或者可转换)时,右上角的3和中心的3当然就是一样的。我们希望将CNN的这种特性“推及”到其他架构上。

这就对称带来的稳定性,因为在视觉上,许多物体其实是同一个物体,会具有“这是同一个物体,只是翻转了一下”的3D几何相似性,因此很多问题都可以基于对称性得到解决。

而传统卷积网络更多地使用数据增强,如旋转,平移,翻转来补偿这一目的。

所以,几何深度学习希望几何学中的“不变群”的概念范围放得更宽,让网络除了旋转平移对称的常规操作之外,还能囊括“不变”这种操作。

比如在一段视频中,有两辆小车相向而行,无论速度如何,有无遮挡,视频的语义就是两辆小车相向行驶。

总的来说,几何深度学习既能使卷积网络更加稳定,也能更好地面对复杂度爆炸的拟合函数。

其他热门提名

除了几何深度学习这个大热门,还有不少我们熟悉的方法也进入了“提名”。

比如,在在评论区中被提及的次数最多的“民推之子”——自监督学习。

监督学习是目前机器学习领域主流的方法,而自监督学习作为一种新的学习方法,利用输入数据本身作为监督信号,从未标记的数据中学习信息表示,几乎有利于所有不同类型的下游任务。

在图像分类、语言翻译等诸多CV和NLP领域都是随处可见,LeCun也一直十分推崇这种研究方向。

△LeCun2018年演讲

也有人认为表征学习和可解释性 (interpretability)越来越受到关注。

他首先解释道,提名表征学习是因为理论深度学习领域似乎正在经历一个从“规范”问题(如深度与宽度、近似理论、动态)到更抽象问题的转变:

比如什么才是好的表示?表示的哪些属性是重要的?如何用数学的方式定义这个概念?我们如何执行它们?

可解释性与表征学习也有一定关系:如果能够理解什么是好的表现,能够在它上面强加属性,那么它就更具有可解释性。

还有提名检索、应用于强化学习上的迁移学习、多模态以及大规模语言模型上的偏好学习的:

其中的“检索”指的是从外部数据集中检索信息,就像是deepmind近期的这项实验一样。

这位帖主还提到,也可以利用检索来补救长尾问题。

有意思的是,评论区有位提名“量子机器学习”的,引来了一位搞物理的,真诚向搞AI的发问:

这玩意儿是真的有用,还是只是民科?

其实在2017年时,图灵奖得主姚期智就在一次演讲时说过“如果能够把量子计算和AI放在一起,我们可能做出连大自然都没有想到的事情。”

这是一个量子计算和机器学习交叉的的跨学科技术领域,借助于量子特性开发高性能的量子机器学习算法,从而加快或拓宽人工智能的应用场景。

不过目前还没有影响广泛的应用出现,因此楼主谨慎地回复:不了解,不过好多人说这是机器学习的最新趋势来着…….

评论区中,我们熟悉的扩散模型、联邦学习、差分算法、元学习也都有人提及。

等到了今年年底的时候,我们可以再挖坟,看看是不是真的有提名中了奖。