对特斯拉死磕的“纯视觉路线”,笔者一直是持质疑态度的。质疑的点在于:算法的进步,能弥补摄像头物理性能的局限性吗?比如,视觉算法足够牛逼时,摄像头就有测距能力了?晚上就能看见了?

前一个疑问,在2021年7月份被打消——当时,特斯拉被曝已开发出“纯视觉测距”技术。而后一个疑问,则持续存在。

笔者甚至一度认为,如果把摄像头类比为人眼、把视觉算法类比为人的大脑中“跟眼睛配合的那一部分功能”,那么,“视觉算法足够牛逼时,就可以不需要激光雷达”这种观点就相当于说“只要我的脑子足够聪明,眼睛高度近视也没关系”。

但前段时间,马斯克提到的HW 4.0将“干掉ISP”的计划,却颠覆了笔者的认知。在接受Lex采访时,马斯克说,接下来特斯拉全车摄像头的原始数据不会再经过 ISP 的处理,而直接输入 FSD Beta 的 NN 推理,这将让摄像头变得超紧急强大。

带着这一话题,笔者跟地平线BPU算法负责人罗恒、于万智驾CTO刘煜、均联智行首席架构师汪浩伟、挚途科技首席科学家黄浴、车右智能联合创始人等诸多业内专家都做了一系列交流,然后明白,自己先前的那些质疑,纯属“自作聪明”。

视觉算法的进步,确实在一步步拓展着摄像头物理物理性能的边界。

一.何为ISP?

ISP 的全称 Image Signal Processor,即图像信号处理器,是车载摄像头的重要构成组件,主要作用是对前端图像传感器CMOS输出的信号进行运算处理,把原始数据“翻译”成人眼可以看懂的图像。

通俗地说,只有依赖于ISP,驾驶员才能借助摄像头“看”到现场细节。

基于第一性原理,自动驾驶公司也用ISP,主要是根据周围环境的实际情况对摄像头数据进行白平衡、动态范围调整、滤波等操作,以获得最佳质量的图像。例如,调节曝光以适应明暗变化,调节焦距以专注在不同距离的物体等等,尽量地让相机性能接近人眼。

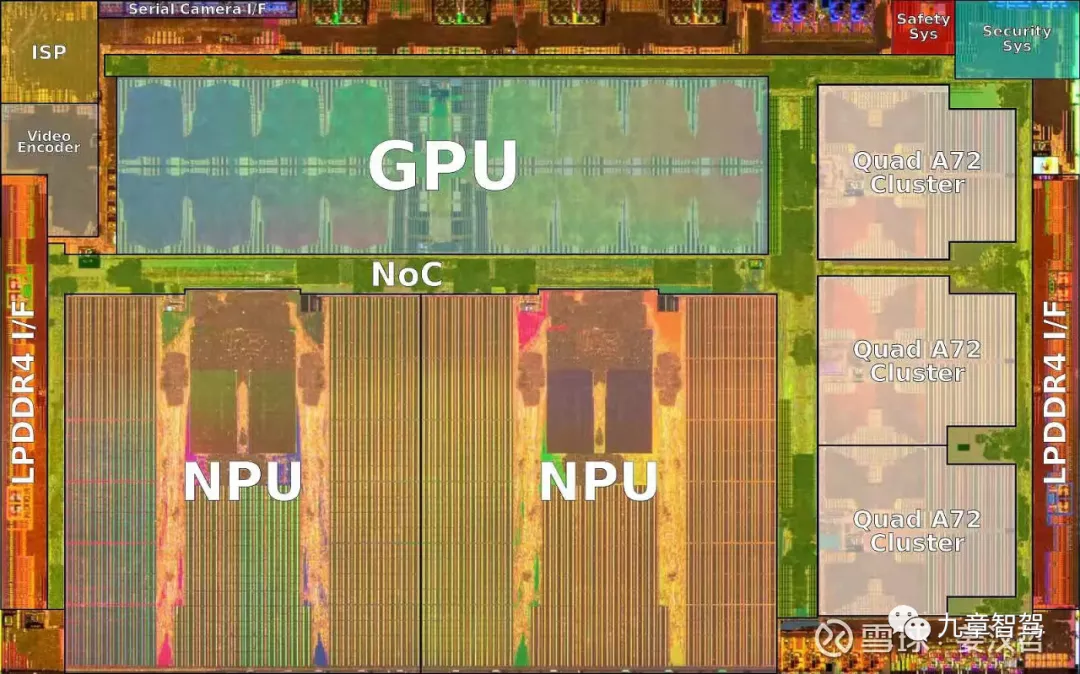

(图为特斯拉的FSD芯片)

不过,让相机“尽量接近人眼”显然还无法满足自动驾驶的需求——算法需要摄像头在强光及弱光等人眼也“失灵”的场合下也能正常工作。为了实现这一目标,有的自动驾驶公司不得不专门定制能增强摄像头在强光、弱光及干扰情况下性能的ISP。

2020年4月8日,阿里达摩院宣布依托其独有的3D降噪和图像增强算法自主研发出用于车载摄像头的ISP,保障自动驾驶车辆在夜间拥有更好的“视力”,“看”得更清晰。

据达摩院自动驾驶实验室的路测结果显示,使用该ISP,车载摄像头在夜间这个最富有挑战的场景下,图像物体检测识别能力相比业内主流处理器有10%以上的提升,原本模糊不清的标注物也得以清晰识别。

二.干掉ISP的动机及“可行性”

然而,ISP的设计初衷是为了在多变的外部环境下获得一张“好看”的图片,但这究竟是不是自动驾驶最需要的图片形式,业界尚无定论。按马斯克Elon 的说法,神经网络不需要漂亮的图片,它需要的是传感器直接获取的原始数据、是原始光子计数(Raw photon counts)。

在马斯克看来,无论ISP采用何种处理方法,总有一部分原始光子在通过镜头到达CMOS、转换成可见光子的过程中会被丢失。

关于原始光子丢失与未丢失的差别,挚途首席科学家黄浴说:“光子转化成电子信号时候,确实有噪声被抑制了,更不用说ISP对原来的电信号做了很多处理。”

车右智能联合创始人在《From photon to control——从光子到控制,Tesla的技术口味越来越重》一文中拿人眼对感知信息的处理做类比,做了比较详尽的解释,在此摘要如下:

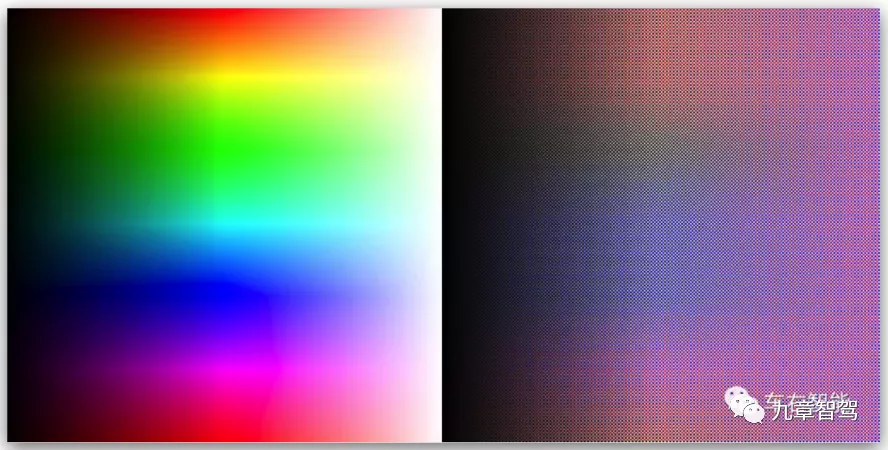

(图片摘自公众号“车右智能”)如上图所示,人类的视觉系统和电子成像系统在逻辑上是完全一致的。视网膜颜色和像素矩阵其实是更可以代表外部客观世界的信息,而真正的人类感知颜色,是需要大脑(等同于ISP和更高层的后端处理)的参与的。

(图片摘自公众号“车右智能”)

上图左侧是一幅标准的带有饱和度渐变和强度渐变的颜色图,右侧是其对应的带元颜色的原始图幅。对比可见,以人类视觉感官为核心而设计的成像系统会给我们提供愉悦和符合人类主观的图像信息,却未必全真反映客观的真实世界。

马斯克认为,为了做得“更好看”、更适合“给人看”,很多原本很有用的数据却在ISP负责的“后期处理”环节被处理掉了。但如果只是为了给机器看,这些被处理掉了的数据其实也是有用的,因此,如果“后期处理”这一步可以被省略,则有效信息量便会增加。

按于万CTO刘煜的解释,马斯克的逻辑是:

1.由于有了更丰富的原始数据,未来,相机的探测范围可能比人眼大,即光照强度很低或者很高的时候,我们人眼可能就看不见了(因为太黑或者太亮),但机器仍然可以测光子数量,因而仍然能有图像输出;

2.相机对光照强度的分辨率可能更高,即看上去很类似的两个光点,人眼可能分辨不出那么细小的亮度或者颜色差别,但是机器或许可以。

某AI四小龙工程师的解释是:好的摄像头的动态范围比人眼大很多(在相对静止状态下),即摄像头能观测到的“从最亮到最暗”的范围,比人眼所能观测的更宽。在极暗的条件下,人眼看不到什么东西(几乎没有光子),但是摄像头的CMOS可以接收到很多光子,因而能看到黑暗状态下的事物。

多位专家在接受《九章智驾》采访时均表述认可马斯克的逻辑。

地平线BPU算法负责人罗恒解释道:“特斯拉现在的数据标注有人工标注和机器自动标注两种,其中,人工标注其实并不全是基于当前的图像信息,也包含了人类对世界的知识,这种情况下,机器同样有概率利用信息更丰富的原始数据;而机器自动标注是结合事后观测、结合大量几何分析一致性得出的,如果使用原始数据,机器有很大概率找到更多的相关性,做出更准确的预测。”

除此之外,均联智行首席架构师汪浩伟解释道:“特斯拉在原始图像数据进入DNN网络前就对其做了拼合,因此,就不需要对每个摄像头的感知结果做后处理。”

通过干掉ISP来提升摄像头在夜间的识别能力,这看起来跟阿里达摩院自研ISP的思路是相反的啊。那么,这两者矛盾吗?

据曾某自动驾驶公司视觉算法专家解释:两家的诉求其实是相同的。在本质上,无论阿里达摩院还是特斯拉,都是希望通过芯片和算法的配合来提升摄像头的能力。

但两者的区别在于,阿里达摩院的思路是,为了人眼能看到,对原始数据进行了各类算法处理和增强;而特斯拉则是去除了算法中为了“照顾”人眼所做的那部分数据处理,转而开发了用于增加摄像头在弱光下及强光等环境下的算法所需的数据及相应能力。

除此之外,马斯克还说,不经 ISP 处理可以实现 13 毫秒的延迟下降,因为有 8 个摄像头,每个摄像头 ISP 处理会产生 1.5 - 1.6 毫秒的延迟。

一旦马斯克这一设想经过实践验证是可行的,其他芯片厂商应该也会“跟进”。甚至,有的芯片厂商已经在这么做了。

如安霸中国区总经理冯羽涛1月份在接受焉知采访时就提到:“如果客户想把原始数据直接喂进神经网络进行处理,CV3 完全可以支持这种方法”。

三.摄像头的“物理性能”也需要提升

并非所有人都完全相信马斯克这一计划。

某头部Robotaxi公司技术VP说:“特斯拉说的也没错,但我觉得算法的开发难度会非常大、周期会很长,然后开发的时间可能会非常久。如果加个激光雷达,首先可以直接把三维的问题解决了,拿纯视觉去构建三维当然也可以,但要消耗很多算力。”

车右智能联合创始人认为,马斯克是个“煽动大师”,“他的宣传方式是把你搞晕,让你不由自主地产生技术崇拜”。

他说:“有的图像学专家认为放弃所有ISP级别的后处理是不现实的,比如获取强度和颜色的debayer图像,会给后续的NN识别head造成很多困难。”

在《车右智能》最近的一篇文章中提到,原始数据染过ISP直接进入神经网络的方案在哪种场景下可行?是可以兼容特斯拉现有的摄像头还是需要更好的视觉传感器?是否存在于FSD beta全部的NN head任务还是局部NN head任务?这都是不确定的答案。

我们再回头笔者开头提出的那个问题:视觉算法的提升,能突破摄像头的物理性能本身的瓶颈吗?

某视觉算法背景的Robotaxi公司CEO说:“逆光或者是车辆从隧道里出来突然面对强光时的感知,人眼很难解决,摄像头也不行,这个时候,就必须要有激光雷达了。”

刘煜认为,理论上,如果你不计成本,可以造一个摄像头,性能是可以超过人眼的,“但我们现在这些车上用的这种低成本的摄像头,似乎还远没有达到这个性能级别。”

言外之意,解决摄像头在弱光或强光下的感知,并不能仅靠视觉算法的提升,还得围绕着摄像头的物理性能“做文章”。

如摄像头若要在夜间探测目标,就无法通过可见光成像,而是得基于红外热成像原理来做(夜视摄像头)。

某“AI四小龙”工程师认为,photon to control非常有可能意味着特斯拉跟HW 4.0芯片搭配的摄像头会升级成多光谱。

这位工程师说:当前,行车摄像头都将非可见光部分滤去,但现实中,物体发出的光线光谱非常广泛,可以用来进一步区分物体特征。比如白色的货车和白云,在红外波段可以被轻易区分;有行人或者大型动物防撞,用红外摄像头会比较容易,因为恒温动物身体发出的红外线是很容易区分的。

《车右智能》在文章中也提到了这样一个问题:Tesla是否会针对photon to control的概念而更新相机硬件,推出真正的光量子相机,或者还是基于现有的camera进行ISP旁路? 与此同时,作者也指出,如果摄像头硬件也要升级,“那特斯拉将不得不从头开始完全重新训练其神经网络算法,因为输入是如此的不同”。

此外,无论摄像头技术如何进步,可能都无法摆脱鸟屎、泥水等脏污的影响。

激光雷达采用的是主动光源,先发光、再接收光,像素点很大,一般的脏污很难将其完全遮挡掉。据某激光雷达厂商提供的数据,在表面有脏污的情况下,其激光雷达的探测距离只衰减15%以内;而且,有脏污的时候,系统会自动发出警报。但摄像头是被动传感器,每个像素点很小,很小的灰尘技能挡住几十个像素,因此,在表面有脏污的时候就直接“瞎了”。

如果不能解决这个问题,那试图通过视觉算法的进步来省掉激光雷达的成本,岂不是个妄想?

几点补充:

1.芯片厂商怎么设计只是问题的一个方面,但客户如果没能力充分利用好原始数据,他们也无法绕过ISP。

2.哪怕芯片厂商和客户都有能力绕过ISP,在今后相当长一段时间里,多数厂商仍然会保留ISP,一个关键原因在于,在L2阶段,驾驶责任主体依然是人,而ISP处理后的信息显示到屏幕上,方便交互,也可以给驾驶员“安全感”。

3.要不要绕过ISP,仍然是“纯视觉派”与“激光雷达派”两种技术路线之争的延续,对此,上文提到的Robotaxi公司技术VP的观点很有启发性:

其实纯视觉方案跟激光雷达方案并不是拼“谁行谁不行”,真正拼的就是纯视觉方案算法开发能开发到激光雷达方案这种水平要多长时间,以及激光雷达的成本降到跟纯视觉方案成本差不多的时候需要多长时间。简言之,是前者的技术进步快,还是后者的成本降得更快。

当然,若日后纯视觉派需要增加传感器,而激光雷达派需要减少传传感器,算法受到的影响有多大、修改算法需要多长时间、成本如何,这些都是有待进一步观察的问题。