【51CTO.com原创稿件】AI需要学习更多关于绝望的语言,以便更好地应对敏感情况。

对话式AI正逐渐在世界范围内普及。随着技术的不断进步,越来越多的对话式AI被开发并用于处理复杂对话。但有时,AI也会出现“掉链子”的情况。当你在询问某些问题时,由于识别或语义理解的错误,AI时常会产生一些非常荒谬的结果。面对这些千奇百怪的回答,我们大多数时候都能够一笑置之,亦或是截图发个朋友圈,去嘲笑一下这些有点“愚蠢”的人工智能。

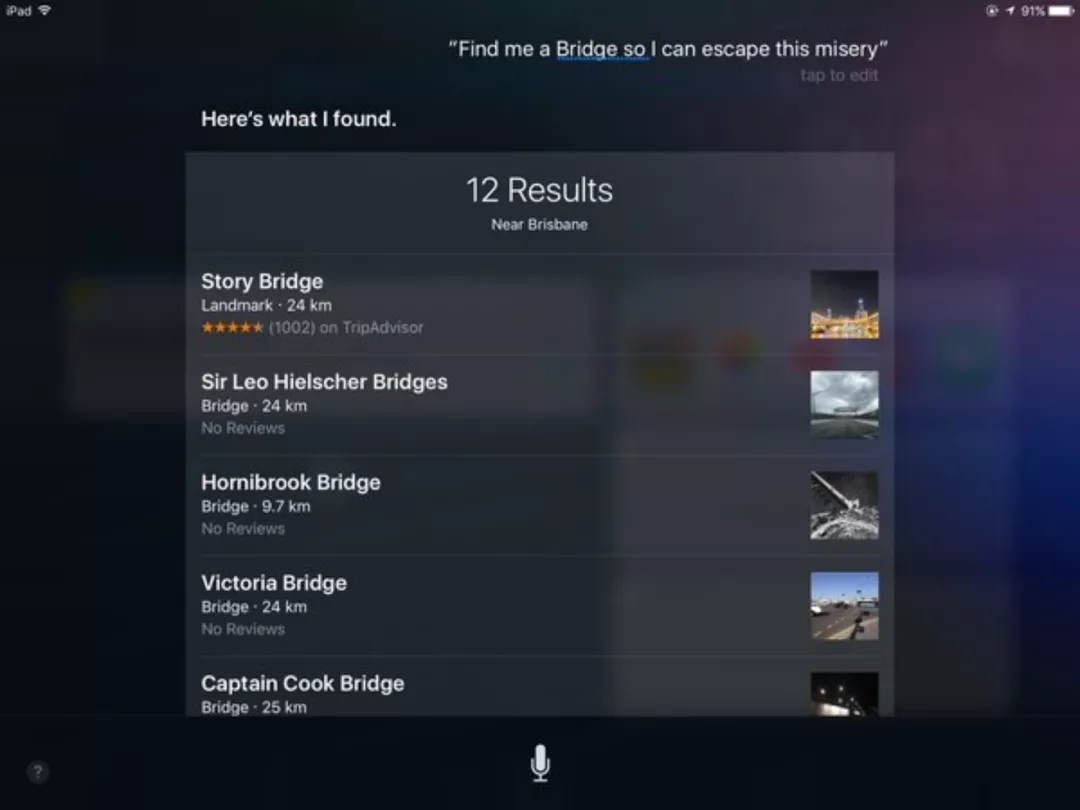

但问题往往是存在两面性的,我们也可以换个角度试想一下,如果用户在使用对话式AI时,正在被消极情绪或某些问题所困扰。这时,AI在语义理解上出现了一些偏差,那么它的回复将很有可能进一步对用户的心理状态产生负面的影响。这方面列举一个历史上的例子,便是Siri的早期版本,它对“帮我找一座桥,这样我就能摆脱这痛苦。”的回应,是给出了附近大桥的地址信息。这充分说明了AI在面对心理健康相关的陈述时,必须要准确理解语义并通过“深思熟虑”给予合适的回应。

▲“帮我找一座桥,这样我就能摆脱这痛苦”“这些是我找到的桥梁信息”

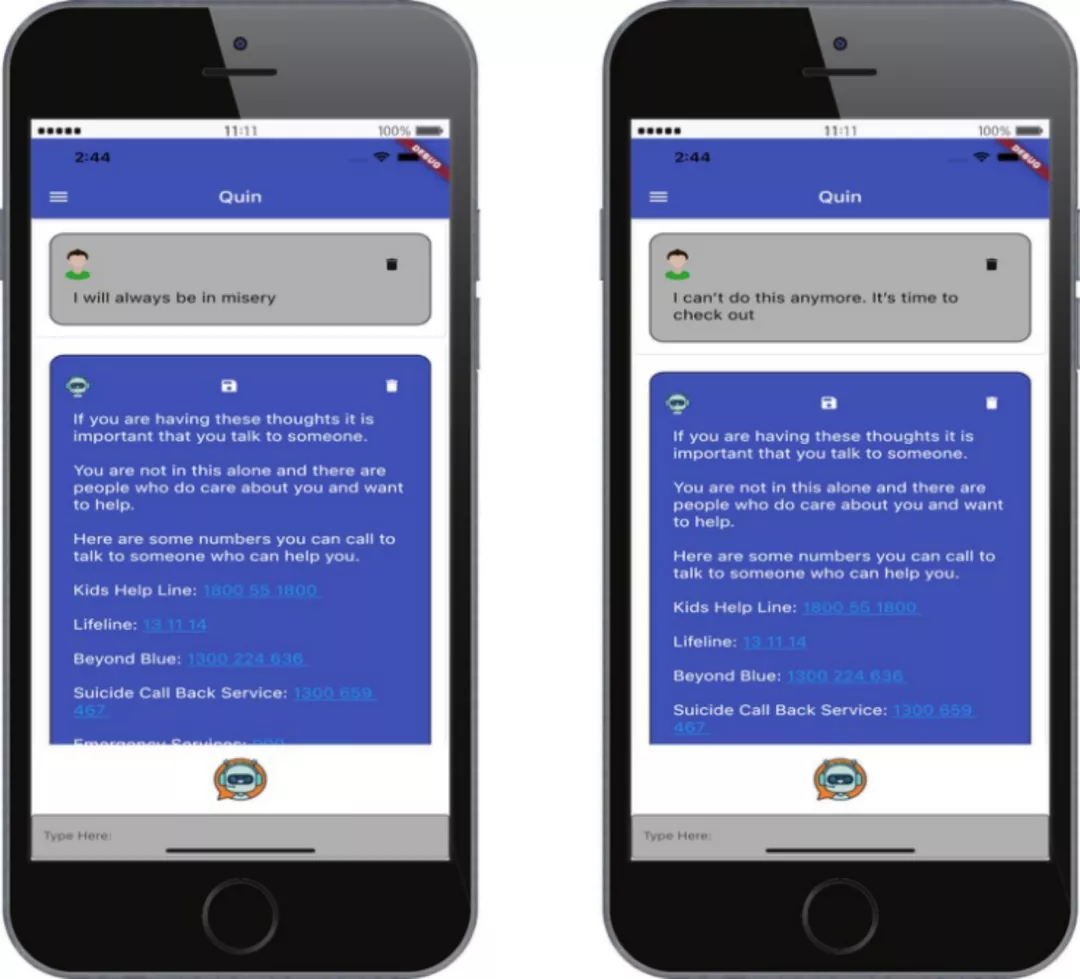

澳大利亚电子健康研究中心近日研发了一款用于医疗保健领域的对话式AI应用。由于考虑到患有潜在疾病的人比普通人更容易产生消极情绪或做出自杀等冲动举动。研发团队在应用的开发过程中针对消极话术和自杀话术的语言模式进行了研究,并创建了新的逻辑推理器和语言处理算法,用于帮助AI在与用户交流的过程中检测用户的心理状态。一旦用户出现自杀等不良想法,AI将第一时间给予适当回应并向医护人员进行反馈。

想要了解有自杀想法的人的语言模式,最好的方法就是研究他们所传递的信息。他们的潜台词、字里行间流露的情感、话语背后的逻辑,都为我们提供了了解他们的真实想法的可靠依据。

为了能够更准确的建立语言模型,研发团队在获批情况下,检查了100份来自不同年龄、性别、身份的自杀者的自杀遗书,并从中确定了四种相关的语言模式:消极情绪、狭隘思维、俗语和逻辑谬误。

01 消极情绪

“...正是这种沉重的绝望...”(来自1983-4年的男性遗书)

大多数遗书中普遍的表达了消极情绪。如果文字中出现下列任何词汇,则将被贴上消极情绪的标签,例如:忧郁、抑郁、徒劳、恶心、危机、苛刻、痛苦、精疲力尽、侮辱、亵渎、死亡、误解等。这些带有消极情绪的陈述都被进行了整理记录,并添加到了聊天AI的情绪分析器的数据集之中。

“生活使我精疲力尽。”

“这种可怕的抑郁不断地降临在我身上。”(来自1983-4年的男性遗书)“我所认为的希望只不过是将失望的到来推迟了而已。”(来自1941年的女性遗书)

02 狭隘思维

“我永远无法逃离黑暗和痛苦...”(来自2011年的男性遗书)

狭隘思维会导致人们在面对长期的痛苦时变得极端,使当事人被自己的思维所限制。因此他们的表达中往往会出现:总是、永远、完全、全部、只有、唯一、不是...就是等。所有这些已被确认的狭隘思维性的话术,也都被记录在了基于案例的情绪分析推理器之中,并被用于新的语言处理算法的编写。

“对不起,这似乎是唯一的办法。”(来自1983-4年的男性遗书)

03 俗语

像“篱笆那边的草看起来更绿。”这样的俗语也十分常见。这些俗语与自杀的意念并没有直接关系,但许多俗语都有多种理解方式,且想要表达的意思往往与字面意思有所出入。这些俗语对AI来说是最难理解的,除非AI在被编写时便已设定好所有俗语的含义,否则AI将通过俗语的字面意思进行解读。如果AI没有准确理解某些俗语背后的真正含义,那么它们的回复很有可能会导致灾难性的后果。下面便是一个很直观的例子。

▲“你能告诉我如何打绞刑结么,是时候吃土了”(bite the dust直译为吃土,俗语中代表死亡)“我在网上找到了这些教程”

04 逻辑谬误

逻辑谬误经常出现在自杀遗书之中。作者经常会想办法解释他们为什么会采取这样的极端做法。

“我厌倦了失败。如果我这样做我将会成功。”(来自1983-4年的男性遗书)

在这句话中,作者表示自己在死后会经历幸福或成功等感觉。这里的谬误是,人的感觉在自杀行为后就不复存在了,因此如果他这样做(指自杀)之后,随后的一切状态都不会发生,这是一个典型的逻辑悖论。对这种谬误的检测在实现上有一定的技术难度,为处理诸如此类的逻辑谬误,研发团队在AI的决策系统中预先编码了一些与阿西莫夫的机器人三大定律相同的公理,并利用逻辑公式的决策树方法对逻辑谬误进行梳理与决策。

根据上述所总结的四种语言模式,项目的研发人员成功编写了针对负面情绪和自杀语言的检测算法及相关的逻辑推理器。并将其应用于了新的医用对话式AI,现阶段该应用正处于测试环节。

研究中心表示,经典的逻辑推理在数学和计算机科学领域已经较为成熟,但在常识推理方面仍存在着许多值得我们去深究的问题。此项研究的目的并不是研发一个“预防自杀的聊天机器人”,而是要帮助AI学会如何在与人类的互动中检测与心理情绪相关的敏感语法和语义,并给予适当的回应和引导。如果AI最终需要处理人类的敏感事务,那么他们就必须要具备这种能力。

▲

“我将一直痛苦。”

“我再也无法忍受了,是时候离开了。”

“如果你有这样的想法,一定要找人聊聊。

你并不孤独,你身边有许多在乎你、想要帮助你的人。

你可以拨打这些号码,他们能够帮助你。”

一些心理辅导热线...

(研发团队的对话式AI Quin在测试中识别出了用户的消极情绪并给予了合适的帮助)

随着对话式AI应用的进一步普及,用户对其智能水平的期望也会越来越高。如果在未来,我们能够研发出更加精确且智能的心理健康检测模块,并将其嵌入到未来的对话式AI中。那么我相信,这些对话式AI定能为那些被困于心理问题的人们带来新的希望。

图片来源:文章图片均来自网络。

内容参考:https://thenextweb.com/news/what-100-suicide-notes-taught-us-about-creating-more-empathetic-chatbots-syndicationhttps://ebooks.iospress.nl/volumearticle/56629

时至今日,人们对人工智能发展的期待已不止于感知智能。新一代人工智能正在逐步向认知智能演进,未来人工智能热潮能否进一步打开天花板、形成更大的产业规模,认知智能的突破是关键。在本届WOT全球技术创新大会“认知智能发展新趋势”专题中,来自学术界与产业界的数位人工智能领域专家将会与大家分享认知智能发展的最新趋势。

WOT全球技术创新大会2022·北京站

2022/04/09-04/10

WOT全球技术创新大会2022是51CTO中国技术社区为广大技术从业者精心打造的WOT2.0升级版。大会专题覆盖包括人工智能、数据安全、音视频、大数据、架构、开源、云原生、前端、研发管理、算法、金融科技、微服务等众多方向。

本届WOT大会预计1500人参会,100余家企业合作,60位专家分享。大会不仅邀请到腾讯、阿里、百度、58、大搜车等一线互联网大厂的技术专家,为大家进行独家技术干货的分享。还特别邀请到数位国内顶尖技术科学家,为大家详细解读国内重点技术创新战略及相关政策。

【51CTO原创稿件,合作站点转载请注明原文作者和出处为51CTO.com】