很多人以为的逻辑:

现在自动泊车都出来了,在雷达和摄像头的帮助下,车辆都能直接入库了,而且遇到障碍物都会先判断,再预警,再自动调整位置避开障碍。

如果不是自动泊车,就是最简单的辅助倒车,也是基本的功能,每辆车都有,在检测到后面有障碍物的时候,就会蜂鸣报警,而且精度还超高,甚至凭借报警声音,老司机都可以控制到了厘米的级别,和后面障碍物贴着停。

那么,为什么汽车不能设计成行驶的时候快撞车就自动刹车呢?

然后,懂得一些自动驾驶 AEB 的人就出来解释了,什么 AEB 的原理啊,什么摄像头要辨别出是什么玩意,才能刹车啊,辨别不出来就得撞上去了。

然后吃瓜群众就更懵逼了,说啥呢,把我当傻子忽悠呢。

我倒车的时候,开着简配的车,没后置摄像头的那种,但车后面放箱子,放购物车,站着人,有堵墙,随便是啥,只要是车后面有障碍物,那个都报警。那技术不就是一个雷达,反射到了障碍物,然后雷达波回来告诉我有障碍物,管他什么障碍物,都不能倒了,随着障碍物距离接近不断报警(好一点的辅助驾驶还会刹停)啥的,有啥难度,要啥摄像头。

那么把这个功能放在车辆前面,检测到障碍物,管他什么障碍物,只要雷达检测到有东西,直接停下就好了啊!凭什么倒车能做到,开车就不能做到了。

往往到这个时候,逻辑就卡住了,为什么不行,我看过很多大佬的高赞回答,都没把这个简单的问题说清楚,而是转而去说什么智能 AI,大数据的算法,或者去科普 AEB 是啥玩意,顺便扯下自动驾驶分几个等级啥的,弄一堆英文名词,说得大家不明觉厉,肃然起敬。但回头一想,好像都没说到点上啊,还是不明白啊。

但是,如果说明白了,就是简单一句话:

辅助驾驶的单一感知设备,不能适应全路况,全环境的一个事情。

打个比方,就是人可以通过手去触碰某个装菜的盘子,得知这个菜是热是凉,但是你要人去判断 10 米开外的一盘菜是热菜还是凉菜,那是真的只能靠蒙了。100 米开外,还要人的触摸去判断,那就真的只有上超能力了……

用来自动泊车报警的感知设备,叫做超声波雷达。而这个雷达的目前最远探测距离(保持精度)为 5 米。

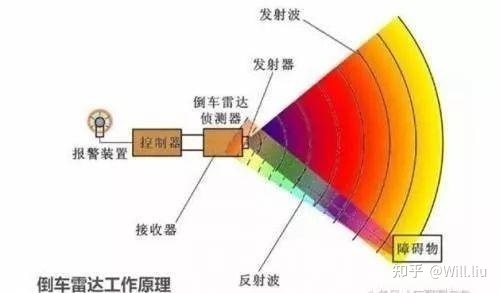

啥叫超声波雷达?

就是一个发射超声波的装置,再弄一个接收超声波的装置,根据来回的时间差,就能估算出雷达距离障碍物的相对距离,精度可以达到 1-3CM。

现在我们常见的,也是用了几十年的超声波雷达叫 UPA,UPA 的探测距离一般在 15CM-250CM。通常安装在汽车前后保险杠上,用于辅助泊车。

而自动泊车就需要装侧面雷达,这里用的则是更长距离的探测超声波雷达 APA. APA 的探测距离在 30-500CM。

APA 用于测量侧方障碍物的相对距离,因为其探测距离较远,也可用在驾驶的时候探测后方、侧面是否有来车过于靠近本车,可以用于侧后方来车报警。

一辆车从检测到障碍物到刹停,要经过感知 - 思考 - 决策的过程。而一辆 100 公里时速的车,一秒就是 28 米,指望 5 米感知距离的超声波雷达来帮助刹停,等探测到了再到刹停,那简直就是 100%碰撞,对于驾乘人员的生命简直就是开玩笑。

那么为什么超声波雷达不能检测远一点的位置,比如 100 米开外?

因为超声波是机械波, 散射角大,方向性不集中,无法精准描述障碍物位置 ,离障碍物距离越远灵敏度越差,现阶段 5 米以上就无法判断障碍物的精准相对距离。

讲清楚了上述的超声波雷达原理,我们再回来说下 AEB(Automatic Emergency Braking)的判定标准。

现有的 AEB 用的感知设备基本是由 毫米波雷达和高清摄像头 组成的。

而毫米波雷达即便最近才开始配在某些高端车型上的 77GHZ 的,其精度也只有 10-40CM 级。

这是个什么意思呢?就是一个人,在毫米波雷达的感知里,可能就是由几个反射点到十几个反射点所组成。一辆比人大很多倍的面包车、卡车,倒是反射点多一些,可能会有一个大概的轮廓勾勒出来。

但从稀疏的几个反射点里面判断前方是个人还是个什么玩意,还要从一大堆反射点里把这几个点给摘出来,不和其他的反射点融为一体,对于算法来说,也是个让它头疼的事情,反正我看过毫米波雷达反射的点云图,我是弄不清楚左边这十几个点,右边那几个点是啥玩意的……

觉得反射点少了,想多来点那个反射点,那么我们调高毫米波雷达的灵敏度,降低探测阈值行不行呢?

也不行。因为毫米波雷达对金属敏感度高,在高灵敏度下,这就和照相一样,灵敏度越高,无用的噪点也会增多,这样就会造成 大量的误判,导致“鬼影”,“虚影”的出现。

所以,AEB 很想采纳毫米波雷达的数据,但这个玩意的精度太低,而且还经常弄些“魔幻”的反射点出来,如果回回采纳它的数据,那汽车很有可能在一马平川的道路上,突然就是一个急刹,因为毫米波雷达判断前方有个“障碍物”。然后司机一脚油门,继续走,过一下又是一个刹停……还是误判…………这样的 AEB 估计会让司机和乘客抓狂…………

所以,为了防止汽车出现这种状况,现在 AEB 的逻辑,毫米波雷达要求刹停的要求还得经过高清摄像头的确认把关才行,这样就可以防止毫米波雷达误判。只有在两者判断一致的情况下,比如前面有辆车停了,毫米波雷达说前面有辆车,摄像头也说前面有辆车,那么 AEB 才会下决定开始刹车。当然,根据权重的不同,也可以调整为摄像头说前面有辆车,毫米波雷达懵的情况下,也可以开始刹车。

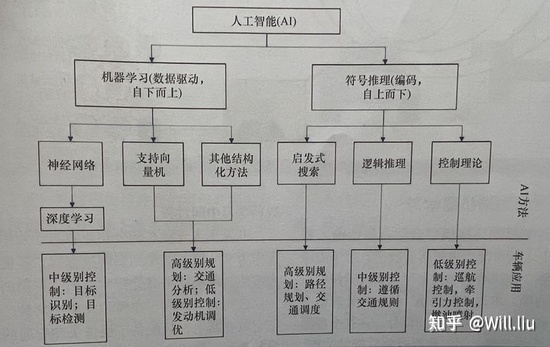

说回 高清摄像头,通过提供高分辨率的图像,再把图片转为二维数据,然后进行图像匹配进行识别。 前面这个到底是车辆,还是行人,还是电动车,摩托车,这种方式就是我们常说的神经网络学习得来的。

(神经网络是一种模拟大脑认知的机理,解决各种机器学习的应用任务,从海量的数据中进行深度学习。)

我们现在用的人工智能的学习,基本是采用的自下而上的方法,使用 深度神经网络(DNN)或卷积神经网络(CNN) 进行深度学习。(深度学习:一类机器学习算法,使用多层从原始输入中逐步提取更高层次的特征。)

而摄像头感知的数据,如果算法没有见过类似的,无法解析出来,很有可能认为这是个错误的感知。

比如前面道路,车的前方突然出现了一棵大树,还是枝繁叶茂的那种。

我们人眼当然知道,前面是一个装载一棵大树的大卡车,它停下来了,我不能再开了,否则就撞了。

但毫米波雷达示警,这前面的反射点告知车前面有个庞大的物体。但这反射点的轮廓,让雷达处于懵的状态,这到底是个啥?天边的一朵云彩?还是金属反射的虚影?不会又是出现了“鬼影”的误判吧。

摄像头拍摄后,也是懵的,这图片转成的二维数据我没学过啊,我对比了好多次,完全和我之前学过的东西不沾边啊。不会是算法错误得到的吧,刚才是不是摄像头过了坑抖动了?

然后两个合计,估计都是错误感知,应该前面没障碍物,那就别通知 AEB 了。

不用刹车了,直接开吧,反正根据深度学习经验,之前这么判断了好多次了,都没出事,没问题的,反正前面肯定不是一辆车……

然后……车辆继续高速疾驰,而某位司机还在笃信“自动”驾驶,闭着眼休息…………

所以,别相信目前阶段的辅助驾驶,还是得时刻关注路况才行……