本文转自雷锋网,如需转载请至雷锋网官网申请授权。

我们的大脑是一个包裹在颅骨中重达三磅的组织块,它是如何从感觉中创造出感知的?这一直以来都是个谜。

数十年来,有大量的研究和证据表明,大脑不可能只是简单地像拼凑拼图一样感官信息将感官信息组织在一起,来感知周围的环境。即使传入的信息杂乱无章、模糊不清,大脑依旧可以根据进入眼睛的光线构建一个场景,这一事实恰巧证明了上述观点。

因此,越来越多的神经科学家开始将大脑视为 "预测机器"。通过预测处理,大脑利用其对世界的先验知识来推断或产生假设,来解释传入感官信息的原因。这些假设在我们的脑海中产生了感知,并不是感官输入本身产生的感知。输入的感官信息越模糊,对先验知识的依赖性就越强。

荷兰拉德堡大学预测性大脑实验室的神经科学家 Floris de Lange表示,预测性处理框架的魅力在于它有一种非常强大的能力可以解释不同系统中许多不同的现象。

然而,越来越多的神经科学证据表明,支持这一观点的想法主要是间接的,并且可以有其它替代解释。

拉德堡大学的Tim Kietzmann 致力于研究机器学习和神经科学的跨学科领域,他表示:"如果你研究人类的认知神经科学和神经成像,将会有很多证据,但这些证据都是非常含蓄的、间接的。"

因此,研究人员开始试图通过计算模型来理解和测试预测性大脑的想法。计算神经科学家通过研究生物神经元的行为,建立了人工神经网络,可以学习对输入信息进行预测。这些模型可以近似模仿真实大脑的能力。用这些模型进行的一些实验甚至暗示:大脑必须要进化成预测机器才可以满足能量限制。

随着计算模型的增加,研究活体动物的神经科学家们也越来越相信大脑会学习推断感官输入的原因。虽然关于大脑如何做到这一点的具体准确的细节仍然模糊不清,但大体的情况变得越来越清晰。

1. 感知中的无意识推理

预测处理起初看起来可能像是一种违反直觉的复杂感知机制,但科学家们一直以来非常偏向于它,因为似乎没有其它更好的解释。甚至在一千年前,穆斯林阿拉伯天文学家、数学家Hasan Ibn Al-Haytham在他的《光学书》中就强调了预测处理的一种形式,用来解释视觉的各个方面。这一想法在19世纪60年代得到了有力支撑,德国物理学家兼医生Hermann von Helmholtz认为,大脑推断出其传入的感知输入的外部原因,而不是从这些输入"自下而上"地构建其感知。

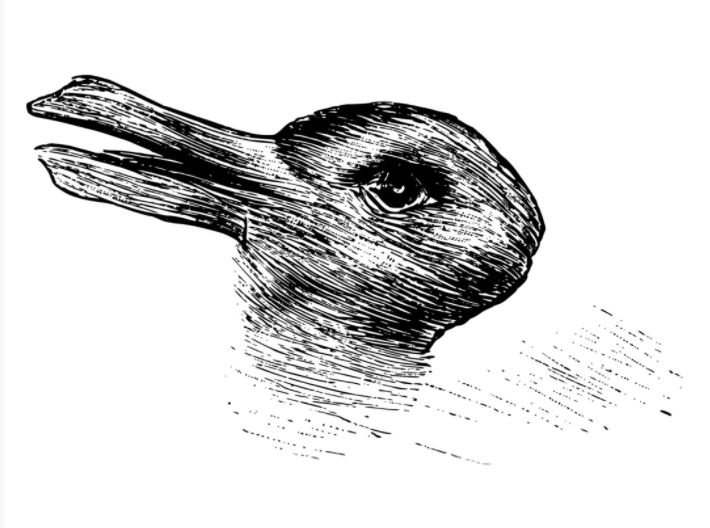

20世纪中叶的认知心理学家用这种看起来既像鸭子又像兔子的图像来研究人类的感知

Helmholtz 阐述了"无意识推理(unconscious inference)"的概念,来解释双稳态或多稳态感知,即一个图像可以以不同方式被感知。例如,在一些的模棱两可的图像上,像上图所展示的那样,我们可以感知它为一只鸭子,又可以认为它是一只兔子,我们的感知在两种动物图像之间不断转换。Helmholtz 表示在这种情况下,由于在视网膜上形成的图像没有变化,所以感知必须是一个自上而下推断感官信息原因的无意识过程的结果。

在20世纪,认知心理学家们继续提出了这样的观点:感知是一个主动建构的过程,它同时借鉴了自下而上的感知和自上而下的概念性输入。

Richard Langton Gregory在1980年发表了一篇非常有影响力的论文“Perceptions as Hypotheses”。该论文中,作者认为感知错觉本质上是大脑对感官印象原因的错误猜测。同时,计算机视觉科学家们在努力使用自下而上的重建,使计算机在没有内部 "生成 "模型参考的情况下进行观察。

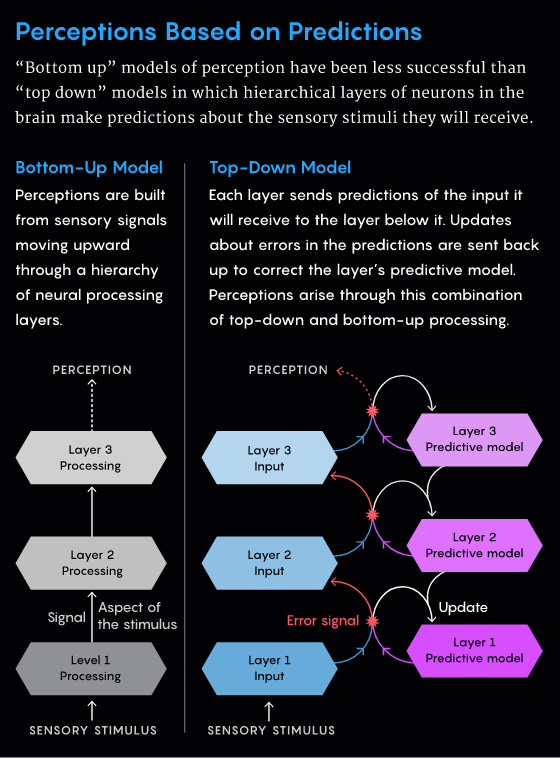

尽管预测处理的接受度在不断提高,但是,关于它是如何在大脑中实现的这一问题仍然存在。流行的一种被称为预测编码的模型,认为大脑中的信息处理水平是有层次的。最高级代表最抽象、最高级的知识,例如,对前方阴影中的蛇的感知。该层通过向下发送信号来预测下一层的神经活动。下层将其实际活动与上面的预测进行比较。如果存在不匹配,该层会生成一个向上流动的错误信号,以便更高层可以更新其内部表征。

这个过程同时发生在每一对连续层,一直到接收实际感知输入的最底层。从外界接收到信息和预期结果之间的任何差异都会导致一个错误信号,并在层次结构上产生涟漪。然后最高层最终更新了它的假设,那不是一条蛇,只是地上的一根卷曲的绳子。

"一般来说,预测性编码的原理是大脑基本有两个神经元群体,特别是当它应用于大脑皮层时,一个编码关于正在感知的东西的当前最佳预测,另一个是该预测的错误信号"de Lange 说。

1999年,计算机科学家 Rajesh Rao和Dana Ballard 分别在索尔克生物研究所和罗切斯特大学建立了一个强大的预测编码计算模型,其中有明确用于预测和纠错的神经元。他们对灵长类动物大脑视觉处理系统中的部分路径进行了建模,该路径由负责识别面部和物体的分层组织区域组成。他们的研究表明,该模型可以重现灵长类动物视觉系统的一些不寻常行为。

然而,这项工作是在现代深度神经网络出现之前完成的。而深度神经网络有一个输入层、一个输出层和夹在两者之间的多个隐藏层。到2012年,神经科学家们开始使用深度神经网络来模拟灵长类动物的腹侧视觉流。但几乎所有这些模型都是前馈网络,其中信息只从输入流向输出。"大脑显然不是一个纯粹的前馈机器,"de Lange说,"大脑中有很多反馈,和前馈信号一样多"。

因此,神经科学家们转而研究另一种类型的模型——递归神经网络(RNN)。纽约西奈山伊坎医学院的计算神经科学家和助理教授Kanaka Rajan表示:这些模型的特点使它们成为模拟大脑的 "理想基质",他的实验室使用RNNs来理解大脑功能。RNNs的神经元之间既有前馈连接,也有反馈连接,它们持续不断地活动,这与输入无关。Rajan说:"这种长时间产生这些动态的能力几乎是永久性的,然后使这些网络能够接受训练。"

2. 预测是为了节能

RNNs引起了William Lotter 和他在哈佛大学的博士论文导师 David Cox 以及Gabriel Kreiman的注意。

2016年,该团队构建了PredNet,这是一个递归神经网络,其架构设计用于执行预测编码。该团队按照预测编码的原则将RNN设计成一个由四层组成的层次结构,每一层都预测它从下面一层预测到的输入,如果出现不匹配,则向上发送一个错误信号。

William Lotter

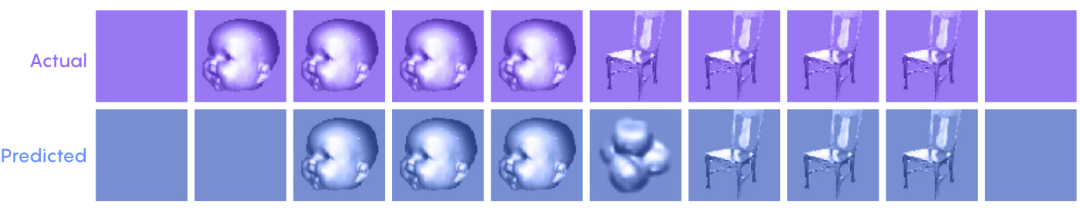

然后,他们在汽车摄像拍摄的城市街道视频上训练该网络。PredNet学会了连续预测视频中的下一帧。"我们起初不确定它是否真的能工作,后来尝试了一下,发现它确实在进行预测。这非常酷"Lotter说。

下一阶段是将PredNet与神经科学联系起来。去年在《Nature Machine Intelligence》杂志上, Lotter及其团队在报告中说:PredNet展示了在猴子大脑中看到的对意外刺激的反应行为,包括在简单前馈网络中难以复制的一些行为。

Kietzmann认为PredNet是一项非常了不起的工作。但是他与 Marcel van Gerven以及他们的团队所追求的是更根本性的东西:无论是Rao和Ballard模型,还是PredNet,都纳入了用于预测和纠错的人工神经元,以及导致正确的自上而下预测抑制错误神经元的机制。但如果这些都没有明确规定呢?Kietzmann表示很想知道是否真的需要这些架构来约束,或者是否可以用一种更简单的方法来解决这一问题。

一个想法突然浮现在Kietzmann和van Gerven的脑海中:神经通讯是有能量成本的(大脑是人体中能量最密集的器官)。因此,为了保存能量,生物体内任何进化的神经网络的行为可能都会受到限制。

研究人员决定观察是否有任何预测编码的计算机制可能出现在 RNN 中,这些 RNN 必须使用尽可能少的能量来完成任务。他们认为,他们网络中的人工神经元之间的连接强度(也被称为权重),可以作为突触传输的代理,这也正是在生物神经元中需要消耗大部分能量的原因。Kietzmann说:"如果你减少人工神经元之间的权重,这意味着你用更少的能量进行交流。我们把这看作是最大限度地减少突触传输。"

当PredNet这个具有预测编码架构的神经网络,被呈现在视频序列中的帧(上图),它学会了预测它们(下图)。

然后,该团队在多个连续数字序列上以升序、环绕顺序训练 RNN:1234567890,3456789012,6789012345等。每个数字都以28×28像素的图像形式显示给网络。RNN学会了一个内部模型,可以从序列中的任何随机位置开始预测下一个数字。但该网络被迫用单元之间尽可能少的权重来做这件事,类似于生物神经系统中的低水平神经活动。

在这些条件下,RNN学会了预测序列中的下一个数字。其中一些人工神经元充当 "预测单元",代表预期输入的模型。其他神经元作为 "错误单元",在预测单元尚未学会正确预测下一个数字时最为活跃。当预测单元开始变得正确时,这些错误单元就变得“低调”了。值得一提的是,该网络之所以采用这种架构,是因为它必须要尽量减少能量的使用。Kietzmann说:"它只是学会了做人们通常明确地建立在系统中的那种抑制,我们的系统开启即用,作为一个突发事件来做,以达到节能的目的。"

将能量使用降到最低的神经网络最终会实施某种预测性处理,这证明生物大脑可能也在做同样的事情。

Rajan称Kietzmann的工作是一个 "非常巧妙的例子,说明了像能量最小化这样的自上而下的限制是如何间接地导致像预测编码这样的特定功能的"。这促使她思考RNN中特定错误和预测单元的出现是否可能是一个意外,是否只有网络边缘的神经元在接收输入。如果输入分布在整个网络中,"我下意识的猜测是,虽然你不会发现错误单元和预测单元之间的分离,但你仍然会发现预测活动"她说。

3. 脑行为的统一框架

尽管这些来自计算研究的见解看起来很有说服力,但最终只有来自活体大脑的证据才能说服神经科学家相信大脑中的预测处理。为此,麦吉尔大学和魁北克人工智能研究所Mila的神经科学家和计算机科学家 Blake Richards和他的同事们制定了一些明确的假设,来说明他们应该在学习对意外事件进行预测的大脑中看到的事物。

“大脑中的锥体神经元似乎在解剖学上适合预测性处理,因为它们可以分别整合来自邻近神经元的‘自下而上’的信号和来自更远处的‘自上而下’的信号。”

——selvanegra

为了验证他们的假设,他们同西雅图艾伦脑科学研究所的研究人员对小鼠进行了实验,同时监测其大脑中的神经活动。特别令人感兴趣的是,大脑新皮质中的某些锥体神经元从解剖学上来说适合预测处理。它们既能通过对其细胞体的输入接收来自附近神经元的局部自下而上的感觉信号,又能通过其顶端树突接收来自更远的神经元的自上而下的预测信号。

小鼠看到了许多Gabor斑块的序列,这些斑块由光和暗的条纹组成。小鼠们也开始期待每个序列中的所有四个斑点的方向大致相同。然后,研究人员意想不到地的突然将第四个Gabor补丁随机旋转到不同的方向。动物们起初很惊讶,但随着时间的推移,它们也开始期待这种惊喜。在这期间,研究人员一直在观察小鼠大脑中的活动。

他们观察到,许多神经元对预期和意外的刺激有不同的反应。重要的是,在测试的第一天,这种差异在局部的、自下而上的信号中很强烈,但在第二天和第三天就减弱了。在预测处理的背景下,由于刺激不那么强烈了,新形成的自上而下的期望开始抑制对传入的感觉信息的反应。

与此同时,顶端树突的情况则相反。它们对意外刺激的反应的差异随着时间的推移而增加。神经回路似乎正在学习更好地表示令人惊讶事件的特性,以便在下一次做出更好的预测。

"这项研究为类似预测性学习或预测性编码的东西正在新皮层中发生的想法提供了进一步的支持,"Richards说。

诚然,对神经元活动或动物行为的个别观察有时可以用大脑的一些其它模型来解释。例如,神经元对同一输入的反应减弱,而不是被解释为错误单元的抑制,可能只是由于适应过程。但是,"你会得到这整个‘电话簿’中对不同现象的解释,"de Lange说。

另一方面,预测处理提供了一个统一的框架,可以一次性解释许多现象,因此它作为一种大脑工作原理的理论具有吸引力。"我认为目前的证据是相当有说服力的,"Richards说,"实际上,我愿意在这个说法上投入大量资金。"