汽车机器人是如何看清世界的?汽车机器人的眼睛应该是什么形态?机器人视觉的未来技术趋势可能会是怎么样的?11月13日,集度联合欧菲光作了一场以“机器人之眼”为主题的技术交流会,围绕自动驾驶的感知硬件基础之一——摄像头做了深入的解答。

自动驾驶的核心技术之一——感知

自动驾驶一直是一个很容易触发社会热点的“流量密码”,总有很多争议性的事件发生——比如有车主过分相信智能驾驶辅助,注意力放松、完全没有控制车辆导致伤亡事故。这些事故的背后是因为现阶段的辅助驾驶技术有不足之处,例如三角锥桶和前方静止车辆的识别困难,而这,都指向了自动驾驶的核心技术之一——感知技术。

在“软硬一体“的时代,感知的硬件基础非常重要,是在给”大脑“提供视觉数据。机器人或自动驾驶汽车,在视觉上需要三个信息:详细的平面信息,高速及全天候的预判信息,精确的距离信息。为了解决信息输入的准确,车企已经先纷纷在硬件上“内卷”起来。一些车企选择多传感器融合的路线,不吝啬在车上搭载激光雷达,激光雷达从1个逐步堆积到4个,足够让大家感到“内卷“。当然,也有深耕自动驾驶多年的百度Apollo以及特斯拉选择纯视觉自动驾驶的道路。

无论是激光雷达加多传感器的技术路径,还是纯视觉的技术实现手段,摄像头一直是自动驾驶的灵魂所在。

自动驾驶需要哪些摄像头?

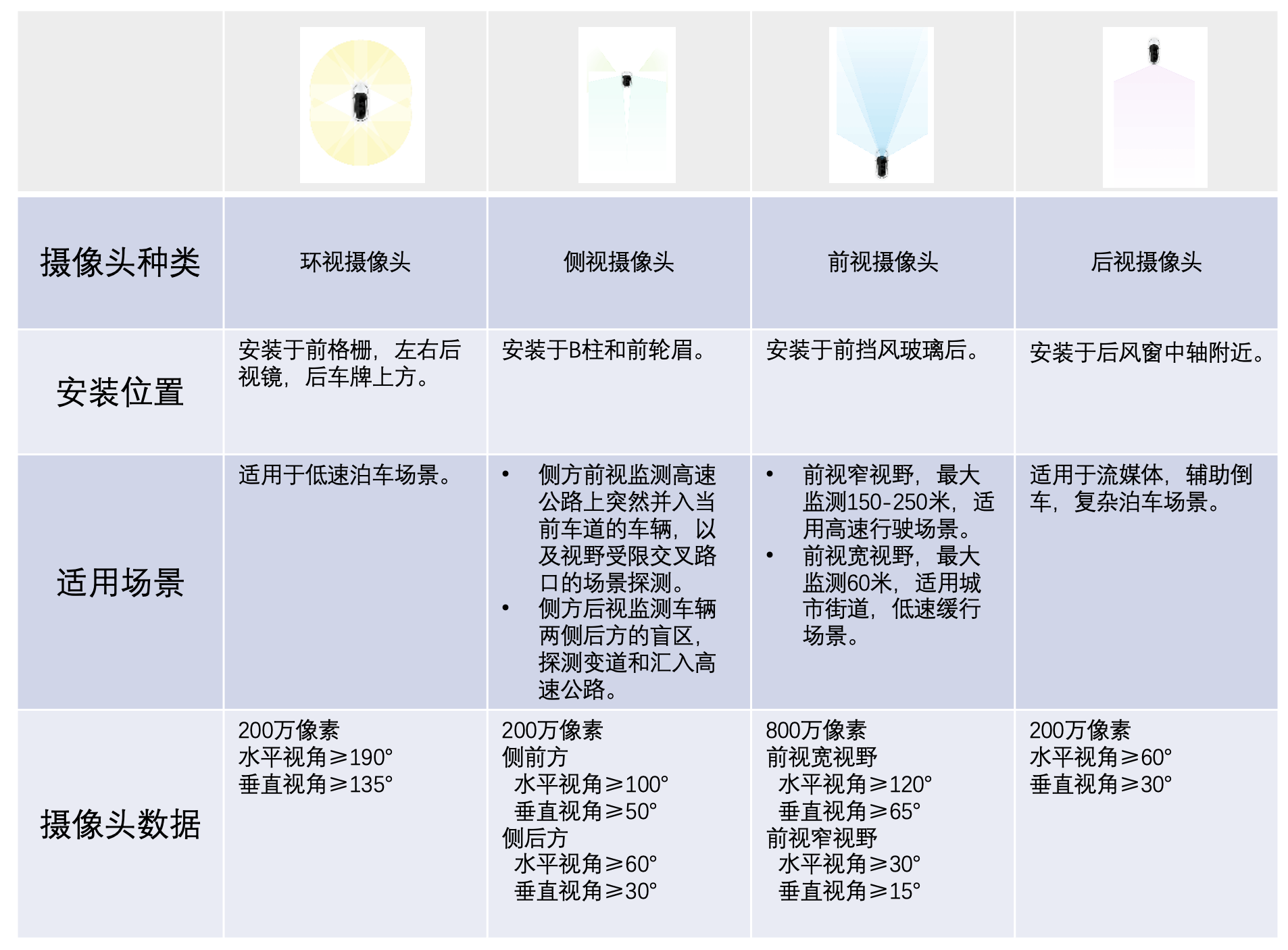

目前的自动驾驶功能摄像头一般有12-13个,按照功能进行分类,分别用于环视、侧视、前视和后视。环视摄像头一般用于低速泊车;侧视摄像头用于补充后方盲区的监测,探测变道和并入主路;前视摄像头主要用于高速和低速的自动驾驶;后视摄像头则主要用于复杂环境下的泊车。

通过这四种摄像头布局在全车四周,就能达到近乎无死角的视觉覆盖,为自动驾驶决策提供足够的视觉感知数据。

随着自动驾驶的技术进步,目前摄像头的发展也在动态地调整,正朝着高像素、低照度、宽动态等方向发展。

2023年,头部图像传感器厂家将陆续量产车规1500万像素的Sensor,其应用将有效减少摄像头个数,实现大于200米距离范围识别20x20cm目标,为路径规划保留足够的时间余量。

夜晚,摄像头处于低照度环境下,识别的精度会受到影响。目前,头部图像传感器厂家都已开发出可在0.1Lux(勒克斯,光照单位)下成像的传感器,可在没有路灯的情况下识别车辆和行人。而一些高清摄像头,也可以将四个小像素合成一个大像素组合输出,有效提升了灵敏度。图像传感器的感知范围也从可见光谱向近红外光谱延伸,还可以通过红外补光灯+红外线摄像机+感知算法,保证在低照度下的视觉感知功能。

宽动态HDR是图像传感器面向自动驾驶应用的关键指标。反映了极大光比情况下对于环境的感知能力。图像传感器受光线影响较大,在强光或是极暗的情况下,可能出现曝光过度和曝光不足的问题。另外,传感器对于光线的快速变化也很难及时做出调整,鲁棒性相对较低。对于自动驾驶来说,是极为严峻的考验。目前车规级COMS图像传感器动态范围已达140dB,160dB的Sensor也在开发中。

此外,3DTOF相机、事件驱动的图像传感器、视觉传感器与空间传感器的前融合等技术,也是目前摄像头以及图像传感技术的发展方向。

机器人视觉的未来

现实场景中,机器视觉既需要事件信号做快速的预判,也需要图像信号做精细的判断或重建,还需要深度信息做精准的距离判断。因此既需要事件相机捕捉动态信息,也需要传统 CIS (视觉识别系统)呈现细节丰富的静态信息,还需要类似3DTof(将二维视觉转换为三维信息)输出的深度信息。

而机器人视觉的未来,可能是有一款相机,可以集成基于帧的图像传感器,基于事件驱动的传感器,基于3DTOf 的传感器技术。除了可以输出与普通图像传感器相同的帧图像,还能同时输出以事件流的数据形式异步输出变化的信息(包括时间、空间及变化的属性信息),并能同步分离深度信息。

李彦宏曾说,AI的最终体现是一个完全自动驾驶的机器人。AI的表现其实就是智能机器人。至于这个机器人的形状,可能更像一个人,也可能更像一辆车。集度是第一个要做汽车机器人的公司,致力于打造可自由移动、可自然交流、可自我进化的汽车机器人。随着摄像头向高像素、宽动态、低照度的方向发展,汽车机器人的眼睛也会更加明澈,为自由移动实现更坚实的基础。