近日,伦敦帝国理工学院研究小组提出一种新的算法,能在不改变图像内容的情况下,轻松骗过图像内容扫描算法,使得人眼看起来相同的照片在算法面前显得不同。这其中就包括苹果的CSAM扫描算法。

什么是CSAM扫描算法?

CSAM(儿童性虐待材料)是苹果公司今年早些时候推出的一份提案,具体内容是为了阻止非法图像的传播,苹果公司专门开发了一项算法,对用户私下分享和保存在 iCloud 云端的照片,利用算法进行哈希值比对。一旦与第三方CSAM数据库中的照片比对成功,苹果将选择屏蔽这张照片,甚至报警。

因为未经授权访问用户图片信息严重侵犯了用户隐私,该项提案推出不久便遭到用户及媒体的强烈反对,最终导致该提案在今年9月被撤回。然而苹果公司并未放弃CSAM,而是将其推广时间延迟到2022年,并承诺将对该算法进行进一步的改进。

图像扫描算法能精准检测非法图像吗?

针对苹果提出的CSAM扫描算法能否像它说的那样,精准检测出非法图像并进行拦截,研究人员在一开始就提出质疑。实际研究结果表明:无论是苹果的CSAM还是任何其他图像扫描算法都不能实现非法图像的精准检测。

研究人员解释说,论文研究针对基于离散余弦变换的算法,提出两个白盒攻击和一个黑盒攻击,成功改变了图像上的独特特征,并帮助它躲过算法扫描。

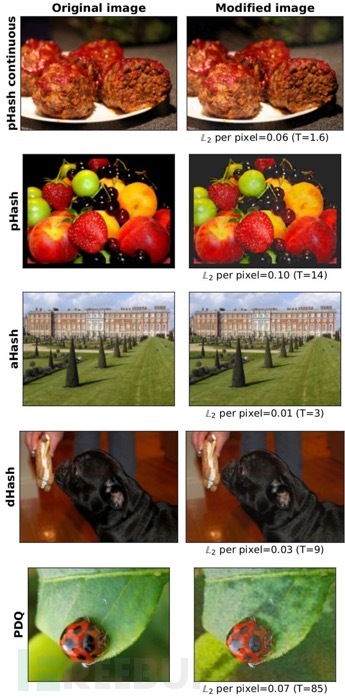

简单而言,仅需要在图像上应用一种特殊的哈希过滤器,就能使两张人眼看起来相同的图像在算法检测面前显得不同。

图片来源:伦敦帝国理工学院

如何防止图像扫描算法”上当受骗“?

为保障图像扫描算法做到”有效“工作,不被算法欺骗,研究人员提出两种方法:一是扩大检测阈值;二是在图像ID匹配达到某个阈值后才标记用户。

但这两种方法都不能从根本上让图像扫描结果变得更可靠,反而会造成更多问题,比如无可避免地侵犯更多用户隐私。

参考来源:

https://www.bleepingcomputer.com/news/technology/researchers-show-that-apple-s-csam-scanning-can-be-fooled-easily/