大家好,我是Python进阶者。

前言

前几天【冯诚】大佬在群里分享了一个抓取读书目录并实现邮件定时发送的代码,感觉还是蛮不错的,这里分享给大家学习。

一、思路

思路倒是不难,构造一个爬虫任务,抓取某书网站上的目录,之后将获取的内容返回,然后利用Python实现邮件发送的功能,剩下的就是定时任务构建了,下面一起来看看具体的实现过程。

二、具体实现

这里直接丢大佬的代码了,如下所示:

- # -*- coding: utf-8 -*-

- import requests, bs4

- import smtplib

- import schedule

- import time

- from bs4 import BeautifulSoup

- from email.mime.text import MIMEText

- from email.header import Header

- # account = '{0}'.format('发件人qq邮箱')

- # password = '{0}'.format('qq邮箱授权码')

- # receiver = '{0}'.format('收件人163邮箱或者qq邮箱')

- account = '{0}'.format('2352180977@qq.com')

- password = '{0}'.format('awmowqginzdijg')

- receiver = '{0}'.format('2352180977@qq.com')

- # 爬虫任务,获取sobooks网站上的书名和作者,其中页面的话,可以根据自己需求进行修改

- def recipe_spider():

- list_all = ''

- num = 0

- for a in range(1, 3):

- n = '{0}{1}'.format('https://sobooks.cc/page/', a)

- res = requests.get(n)

- res.encoding = res.apparent_encoding

- bs = BeautifulSoup(res.text, 'html.parser')

- # print(bs)

- books = bs.find_all('h3')

- authors = bs.find_all('p')

- for i in range(len(books)):

- num = num+1

- book = books[i].text.strip()

- author = authors[i+1].text.strip()

- #list_books.append([book,author])

- # list_books.append(list_book)

- n = '''

- 书名%s: %s,作者: %s

- ''' % (num, book, author)

- list_all = list_all + n

- return list_all

- # 将获取到的内容发送邮件

- def send_email(list_all):

- global account, password, receiver

- mailhost = 'smtp.qq.com'

- qqmail = smtplib.SMTP()

- qqmail.connect(mailhost, 25)

- qqmail.login(account, password)

- content = '亲爱的,今天书单' + list_all

- print(content)

- message = MIMEText(content, 'plain', 'utf-8')

- subject = '今天看什么'

- message['Subject'] = Header(subject, 'utf-8')

- try:

- qqmail.sendmail(account, receiver, message.as_string())

- print('邮件发送成功')

- except:

- print('邮件发送失败')

- qqmail.quit()

- def job():

- print('开始一次任务')

- list_all = recipe_spider()

- send_email(list_all)

- print('任务完成')

- if __name__ == '__main__':

- # 定时任务,其中0.05是间隔的意思,以分钟为间隔,时间默认是整数。

- schedule.every(0.05).minutes.do(job)

- while True:

- schedule.run_pending()

- time.sleep(1)

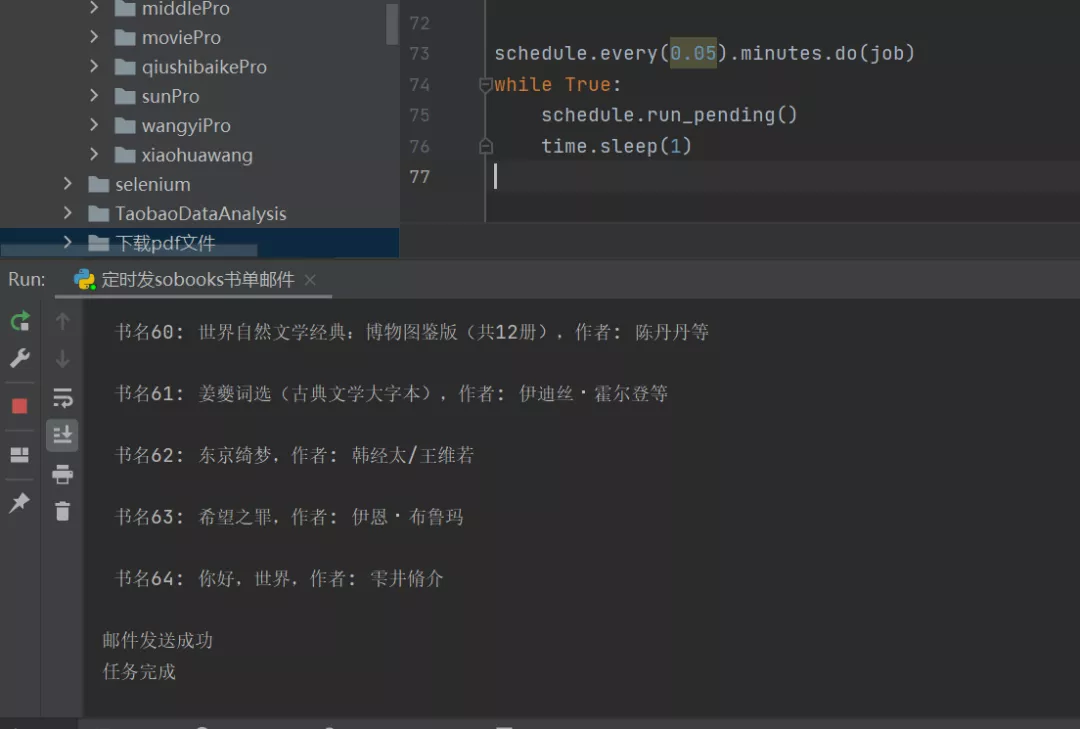

程序运行之后,即可实现邮件自动发送了。

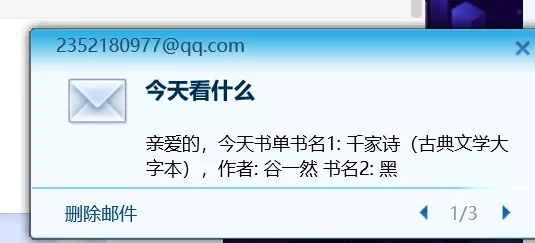

稍等片刻,邮件便会自动给你发送过去,下图是邮件通知。

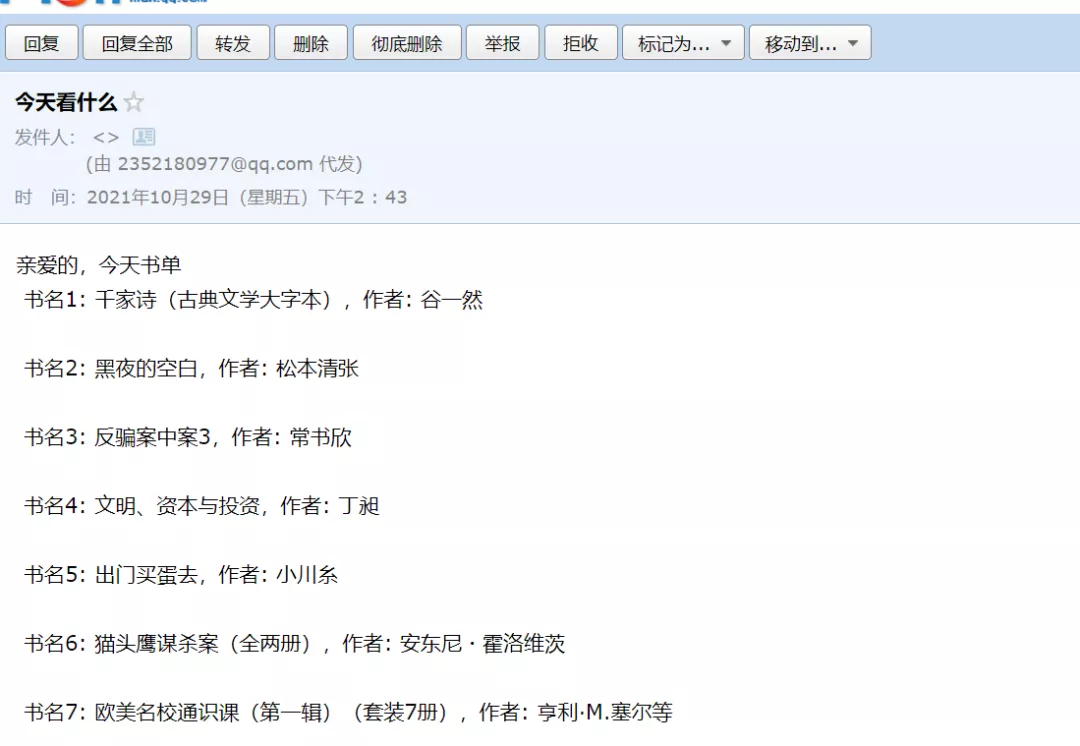

下图是邮件的具体内容:

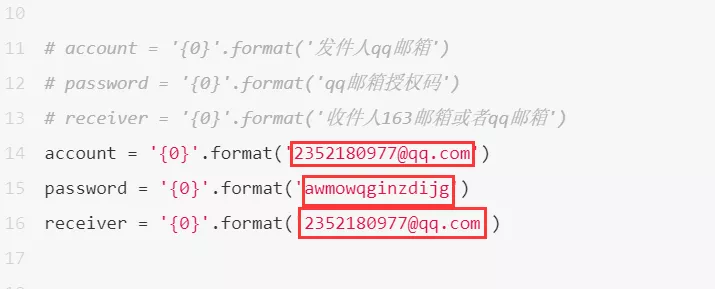

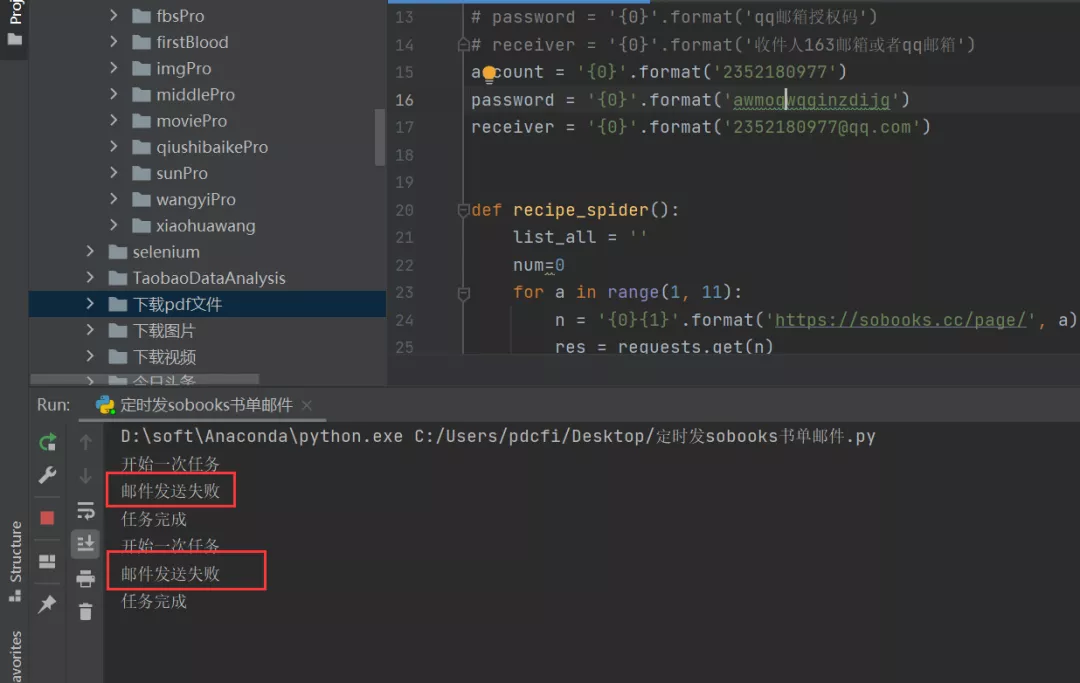

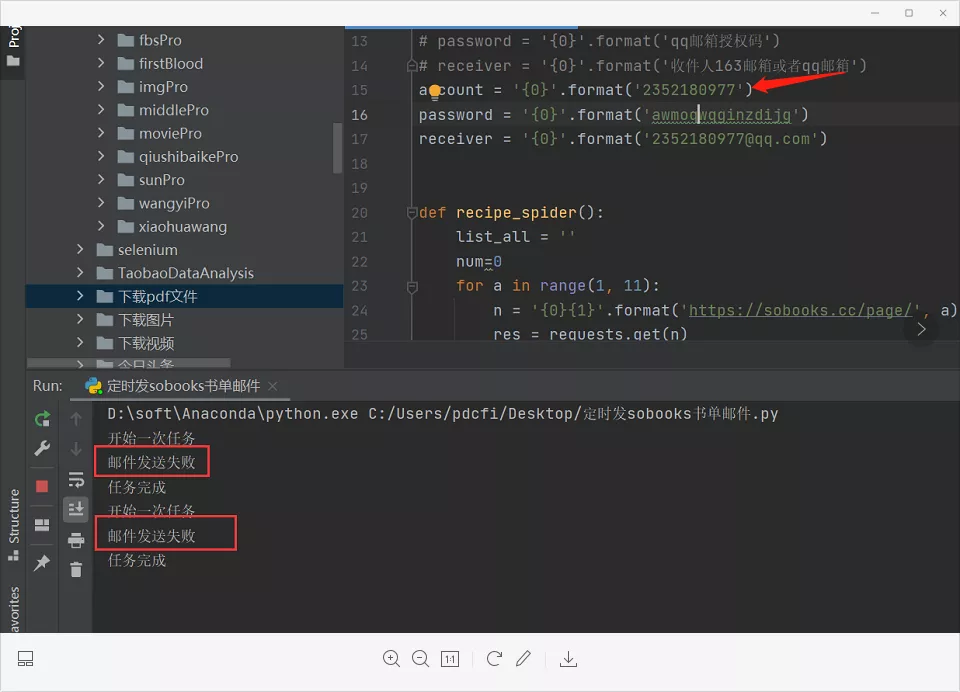

针对上述代码,你只需要更改三个地方,其一是发件人的qq邮箱,其二是qq邮箱的授权码,其三是收件人的邮箱,如下图红色框框所示。

三、常见问题

在运行过程中小伙伴们应该会经常遇到这个问题,如下图所示。

这个很可能是因为你的邮箱没有填对或者授权码错误,检查下邮箱后缀是否添加或者检查下授权码是否复制完整。

有的小伙伴还不知道qq邮箱授权码怎么获得,这里引导下,首先你得打开自己的qq邮箱,然后点击设置-->账户,如下图所示:

拉到最下方,如下图所示:

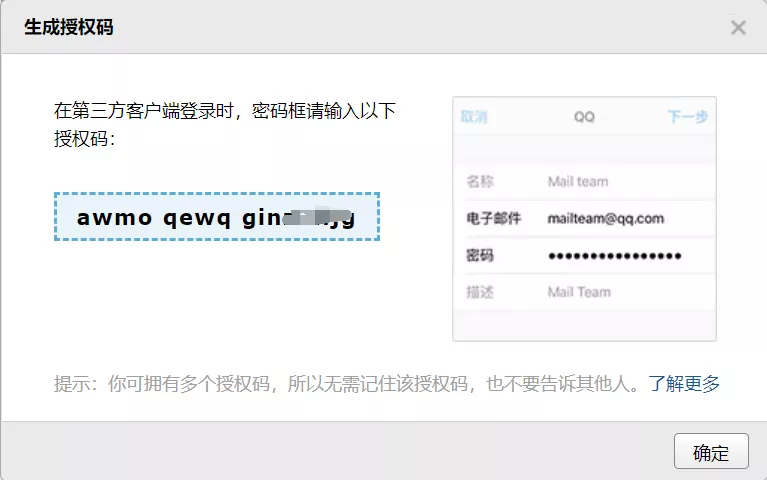

点击生成授权码,之后会弹出下图界面:

手机发送“配置邮件客户端”关键字,记得,是“邮件”,而不是“邮箱”,小编之前就是因为发错了字,所以导致没成功,论细心的重要性!发送成功之后,就会弹出下图:

上图左侧中的条框字母部分就是qq邮箱的授权码了,将其复制到代码中进行粘贴即可。

四、总结

我是Python进阶者,这篇文章主要给大家介绍了使用Python网络爬虫并实现邮件自动定时发送的小项目。实现的主要思路是构造一个爬虫任务,抓取某书网站上的目录,之后将获取的内容返回,然后利用Python实现邮件发送的功能,并进行定时任务构建,在最后还给大家例举了常见问题的处理方法。

小伙伴们,快快用实践一下吧!