自监督学习在计算机视觉中的应用十分广泛,能够在没有人工标注的情况下学到输入数据的有效表示。

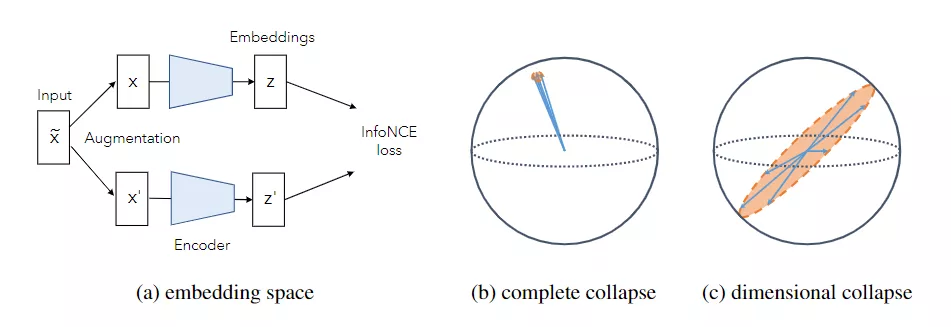

目前基于联合嵌入方法(joint embedding method)的自监督视觉表征学习研究进展表明,自监督学习得到的表示性能和有监督表示相比相差不大。这些方法的目标通常是通过最大限度地利用同一图像不同失真度的嵌入向量之间的一致性来学习对数据增强保持不变的表示。

但自监督模型存在崩溃问题,即将所有输入映射到同一常数向量,因此研究人员提出了各种方法来解决该问题,这些方法依赖于不同的机制,虽然成功地防止了所有表示向量收缩到单个点的完全崩溃情况,但在非对比学习方法中可以观察到,虽然嵌入向量不会完全崩溃,但它们会沿着特定的维度崩溃(dimensional collapse),这导致嵌入向量只能在较低维度的子空间中有效。

按照直觉来说,对比学习中应当不会出现这种崩溃问题,因为对比学习的方法中明确使用损失函数中的正例和负例,可以直观地利用所有维度推测负例的排斥效来防止这种维度崩溃。然而,与直觉恰恰相反,对比学习方法仍然受到维度崩溃的影响。

对于这种现象的成因一直没有定论,Facebook的LeCun和田渊栋博士最近发布了一篇文章,从理论上研究了这一现象背后的动因。

田渊栋博士是Facebook人工智能研究院研究员、研究经理,上海交通大学获得计算机本科和硕士学位,2013年获得卡耐基梅隆大学机器人系博士,致力于深度强化学习、表征学习和优化。

论文中,研究人员发现有两种不同的机制可能会导致崩溃:

1、沿着特征方向,当数据增加引起的方差大于数据分布引起的方差时,权重会崩溃。

2、即使数据增强的协方差在所有维度上都小于数据方差,由于不同层面上权重矩阵的相互作用(隐式正则化),权重仍将崩溃,这种崩溃只发生在网络具有多个层的网络中。

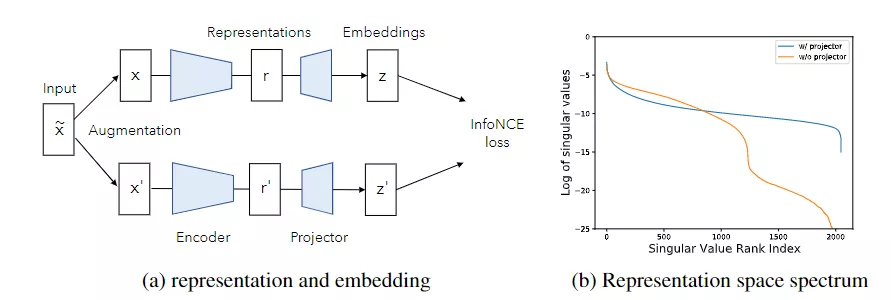

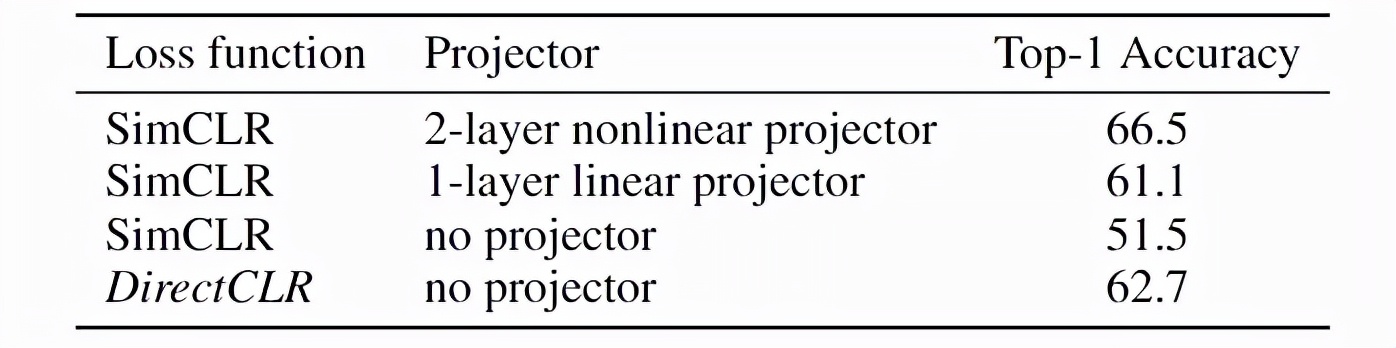

受这种理论的启发,文章提出了一种新的对比学习方法DirectCLR,它直接优化编码器(即表示空间),而不依赖可训练的投影(projector),DirectCLR在ImageNet上具有线性可训练投影仪,其性能优于SimCLR。

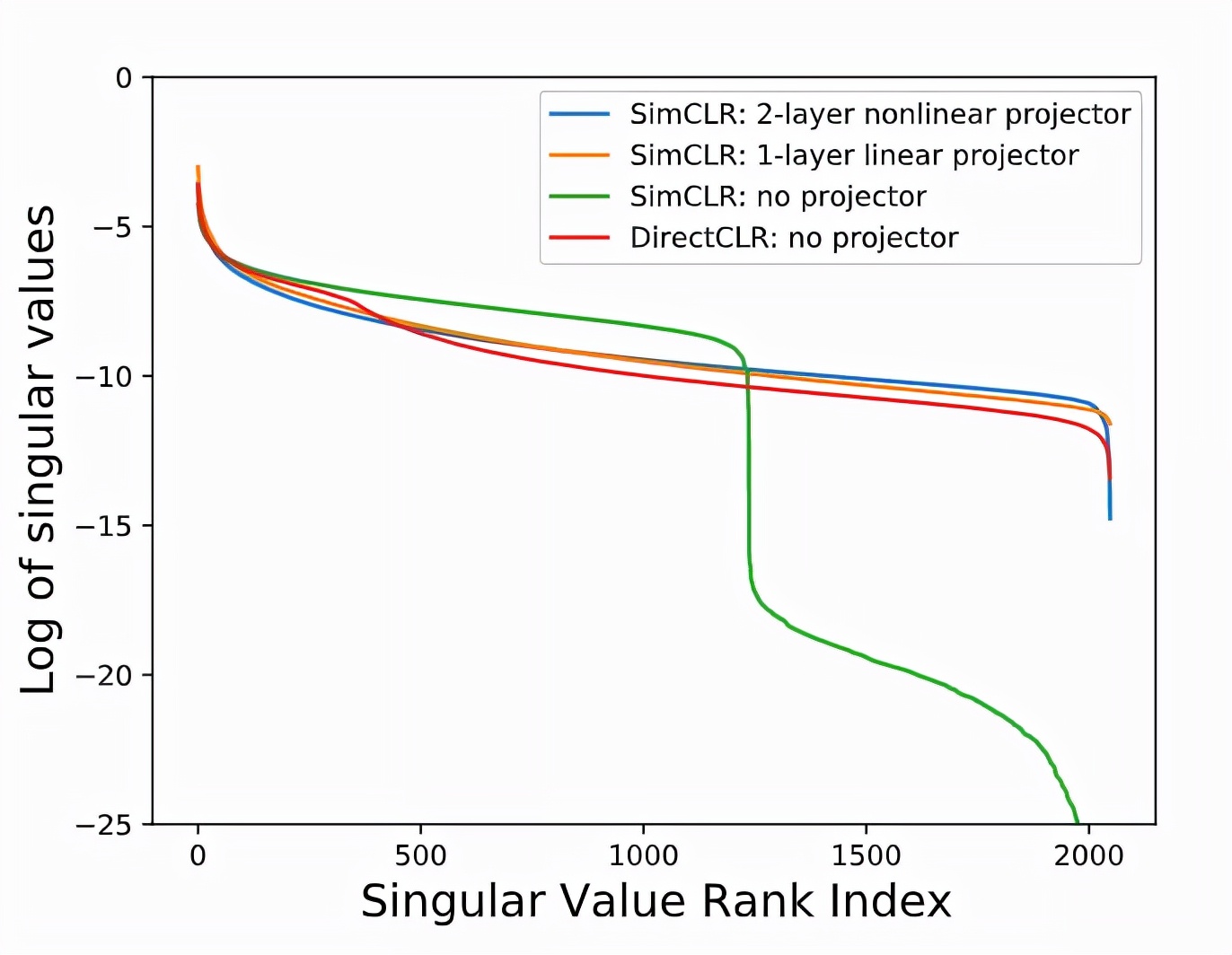

从经验上看,增加projector可以显著提高学习到的表现和下游表现的性能,检查表示层的spectrum也会发现有无projector的差异。研究人员训练了两个带projector和不带projector的SimCLR模型,当模型在没有projector的情况下进行训练时,SimCLR 会发生表示空间中的维度崩溃。

对比学习中的projector对于防止表征空间中的维度崩溃至关重要,基于这个理论,研究人员提出:

- 梯度将会驱动projector权重矩阵与编码器主干的最后一层对齐,因此projector 权重矩阵只需要是对角的(diagonal)即可。

- projector 仅对表示的子空间应用梯度,因此权重矩阵只需是一个低秩矩阵。

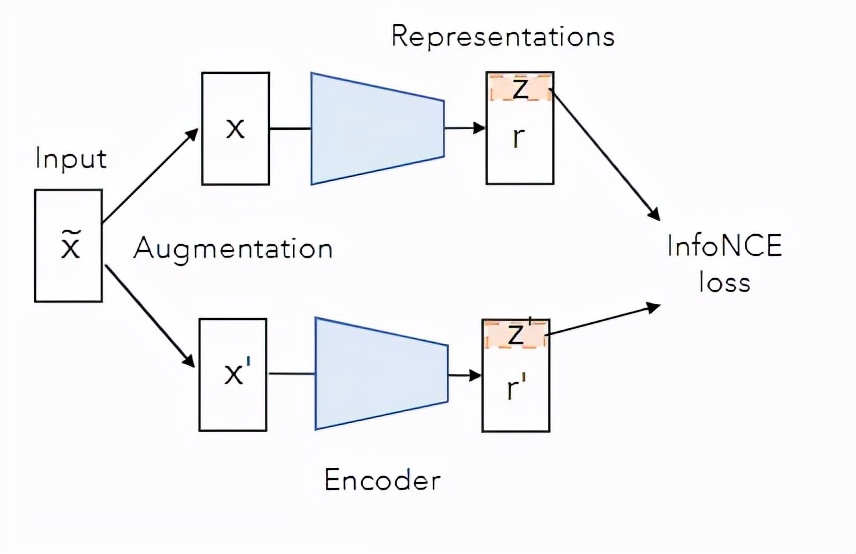

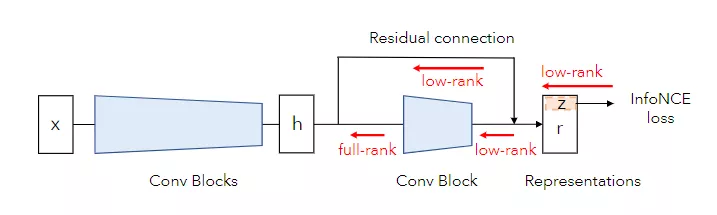

作者提出在对比学习中通过直接向损失函数发送表示向量的子向量来移除projector,这个操作也称为DirectCLR。与所有最新的自监督学习方法相比,这种方法能够直接优化表示空间。

随后研究人员在ImageNet上为DirectCLR训练了100个epoch 的标准Sim-CLR,主干编码网络是一个ResNet50。DirectCLR与使用ImageNet上可训练线性projector 的SimCLR相比表现出更好的性能。

DirectCLR 也能够实现似于SimCLR中可训练projector 的功能来防止表示空间中的维度崩溃。

有人可能会认为DirectCLR 中的对比损失没有在表示向量r[d0:]的其余部分应用梯度,事实上,整个表示向量r 经过训练并包含有用的信息。表示向量的其余部分通过残差连接从最后一个剩余块之前的层复制。表示的这一部分不直接经历来自损失函数的梯度,而是通过卷积块由梯度更新,残差连接通过最后一个卷积块的满秩梯度。

研究人员还进行了三项消融实验:

- 固定的低秩projector:这时DirectCLR退化为一个带有固定线性、对角矩阵projector的SimCLR。实验结果观察到,当使用固定的低秩矩阵作为projector 时,它在ImageNet上的性能类似,从而达到62.3%的线性probe 精度。该低秩矩阵的奇异值设置为d0数为1,其余为0。该矩阵对应的奇异向量都是随机生成的。因此,它们唯一的区别是,这个固定的projector 有一个额外的固定正交矩阵。这表明表示空间(或相当于前一层)在训练期间已进化为与该正交矩阵对齐。

- 可训练的对角线projector:研究人员训练了一个SimCLR模型,该模型带有一个可训练的projector ,但仅限于对角线的数值。该模型在ImageNet上实现了60.2%的线性probe 精度,与带有1层线性投影仪的SimCLR相当。这也可以通过projector 与主干中的前一层对齐的对齐现象来解释。但研究人员怀疑初始化问题是该模型比具有1层线性可训练投影仪的SimCLR稍差的原因:随机矩阵的奇异值不同于均匀分布。

- 在子向量z上的线性probe:对于DirectCLR,研究人员仅在子向量z上执行线性probe,并在ImageNet上获得47.9%的精度。这表明即使r 没有看到直接来自损失函数的梯度,但它其余部分仍然包含有用的信息。

为了保证论文可以成功复现,论文的附录中还提供了每个引理和定理的详细证明、代码以及参数。