创造类似人类的人工智能不仅仅是模仿人类的行为--技术也必须能够像人类一样处理信息,或"思考",如果它要被完全依赖的话。由格拉斯哥大学心理学和神经科学学院领导的发表在《模式》杂志上的新研究,使用 3D 建模来分析深度神经网络处理信息的方式,也就是更广泛的机器学习家族的一部分,以可视化它们的信息处理如何与人类相匹配。

人们希望这项新工作将为创造更可靠的人工智能技术铺平道路,这种技术将像人类一样处理信息,并出现我们可以理解和预测的错误。人工智能发展仍然面临的挑战之一是如何更好地理解机器的思维过程,以及它是否与人类处理信息的方式相匹配,以确保准确性。深度神经网络经常被认为是目前人类决策行为的最佳模型,在一些任务中达到甚至超过人类的表现。然而,即使是欺骗性的简单视觉辨别任务,与人类相比,人工智能模型也会显示出明显的不一致和错误。

目前,深度神经网络技术被用于人脸识别等应用,虽然它在这些领域非常成功,但科学家们仍然没有完全理解这些网络是如何处理信息的,因此何时可能出现错误。

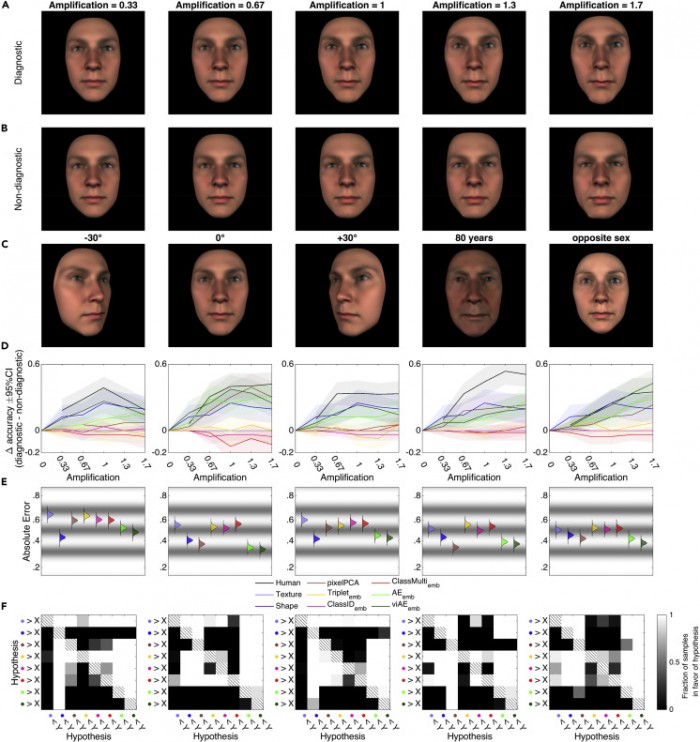

在这项新的研究中,研究小组通过对深度神经网络得到的视觉刺激进行建模,以多种方式进行转换,从而解决了这一问题,他们可以通过处理人类和人工智能模型之间类似的信息来证明识别的相似性。

该研究的资深作者、格拉斯哥大学神经科学与技术研究所所长 Philippe Schyns 教授说。"在建立行为"像"人类的人工智能模型时,例如,只要看到一个人的脸,就能像人类一样识别出来,我们必须确保人工智能模型使用与另一个人相同的信息来识别它。如果人工智能不这样做,我们可能会有这样的错觉,即该系统的工作方式与人类一样,但随后发现它在一些新的或未经测试的情况下会出错。"

研究人员使用了一系列可修改的 3D 面孔,并要求人类对这些随机生成的面孔与四个熟悉身份的相似性进行评分。然后他们用这些信息来测试深度神经网络是否出于同样的原因做出了同样的评价--不仅测试人类和人工智能是否做出了同样的决定,而且还测试它是否基于同样的信息。研究人员希望这项工作将为更可靠的人工智能技术铺平道路,使其行为更像人类,并减少不可预知的错误。