arXiv上2021年9月28日上传论文“SafetyNet: Safe planning for real-world self-driving vehicles using machine-learned policies“,来自Level 5, Toyota收购的Lyft自动驾驶团队。

本文介绍的是,通过来自于专家演示的训练,实现一个安全自动驾驶控制系统。因为机器学习(ML)方法存在安全问题,风险不可预测,故此加入一个基于规则的退却层(rule-based fallback layer),对ML决策做健全检查(sanity checks),这样可减少ML规划器的碰撞95%。整个实验采用300小时的驾驶数据做模仿学习(IL),并在三番市进行了测试。

更多信息参见 Autonomy 2.0 - 2022-SafetyNet

代码 GitHub - lyft/l5kit: L5Kit - level5.lyft.com

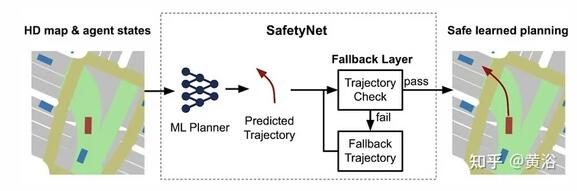

如图是SafeNet的基本框架:ML规划给出轨迹预测,通过一个fallback layer进行验证。

下面的图像是一个SafeNet在三番市区进行自动驾驶的例子:

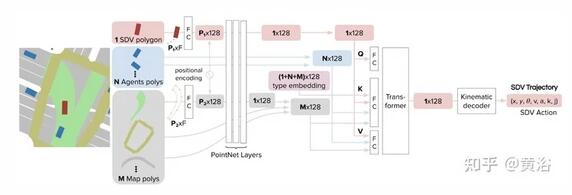

如图是模型的架构图:类似谷歌WayMo的VectorNet,一个分级图网络;采用PointNet网络进行输入信息(车辆姿态和大小,其他智体的姿态、大小和目标类型,HD地图的静态信息和动态信息,以及路线规划routing)的局部编码,基于Transformer做全局嵌入推理智体和地图特征之间的交互。这个结构会通过运动解码器做控制信号,基于自行车模型。

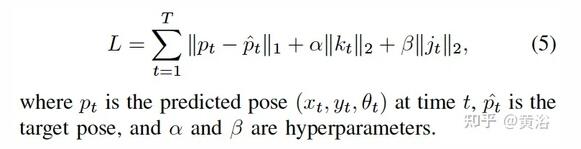

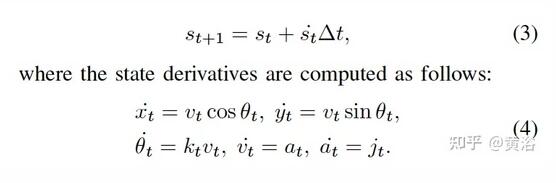

网络训练基于模仿学习,加入扰动,扩展分布减少covariance shift的影响。损失函数考虑曲率kt和抖动jt的因素改进舒适度,即

这里补充一下运动解码器的模型如下:

在fallback层,考虑几个维度进行轨迹评估:

- dynamic feasibility :包括约束的longitudinal jerk, longitudinal acceleration, curvature, curvature rate, lateral acceleration, 和 steering jerk (curvature rate X velocity);

- legality:交通规则,比如stop sign、红灯、离开道路或者让路等等

- collision probability:碰撞检测

这样给轨迹做标记【Feasible, Infeasible】,最后产生一个最接近ML预测轨迹的Feasible结果。

训练规模如此:

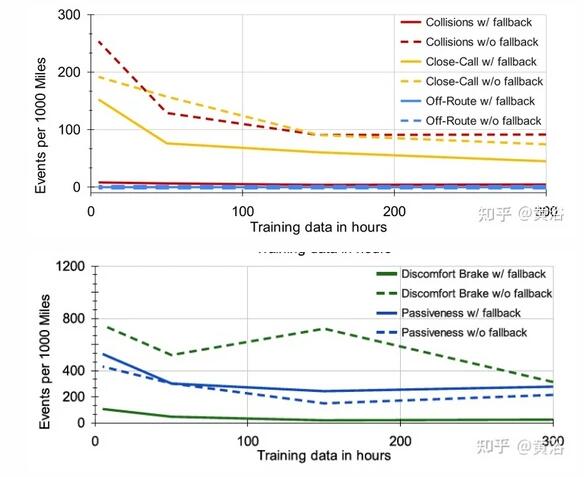

fallback层的影响:

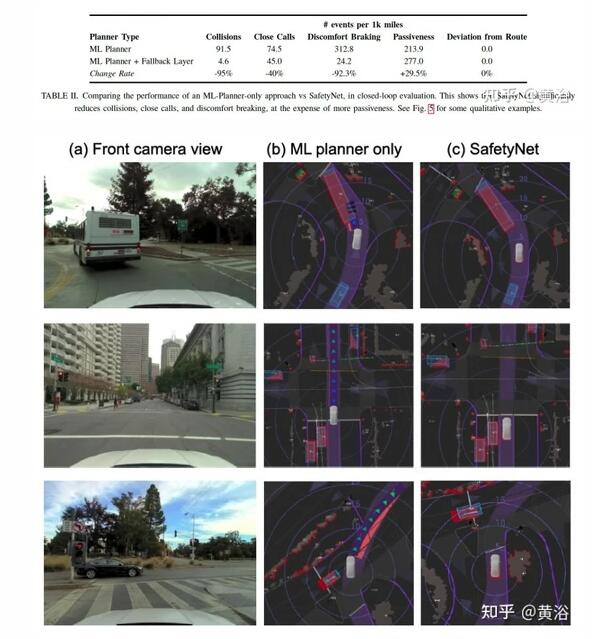

实验的性能比较:ML规划和ML规划+fallback层

SafetyNet将 ML 规划器与基于规则的系统fallback层相结合,与纯基于机器学习的系统相比,安全性和舒适性指标得到改进,在具有挑战性的旧金山街道测试。

今后可将fallback层细化,不那么保守,不增加被动性。另外,可以借鉴基于模型的强化学习 (RL) 、离线 RL 或数据驱动模拟的闭环训练等进行改进。