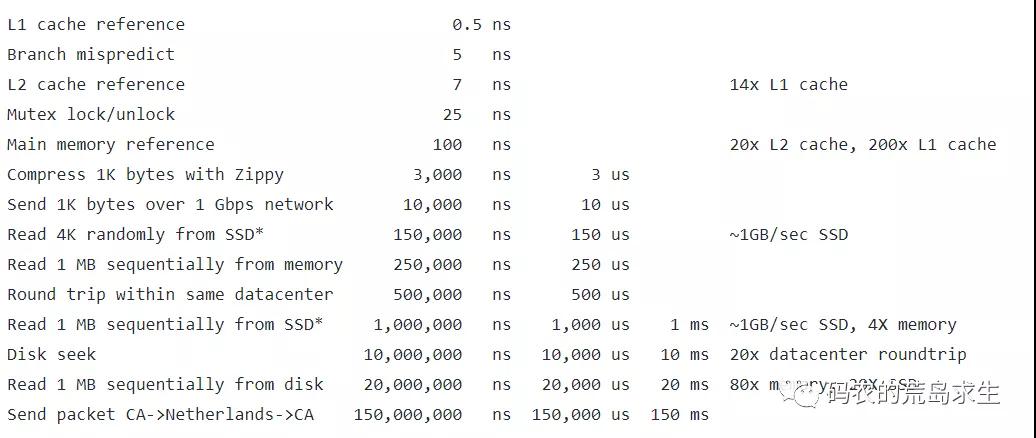

Google大神 Jeff Dean在之前的一次演讲中展示了这样一张表,非常有意思:

从这张图里我们可以清楚的看到,计算机系统中各种关键操作其典型耗时到底有多少(注意,各种不同的系统架构精确的数据可能与此不同,但数量级上差别应该不会很大)。

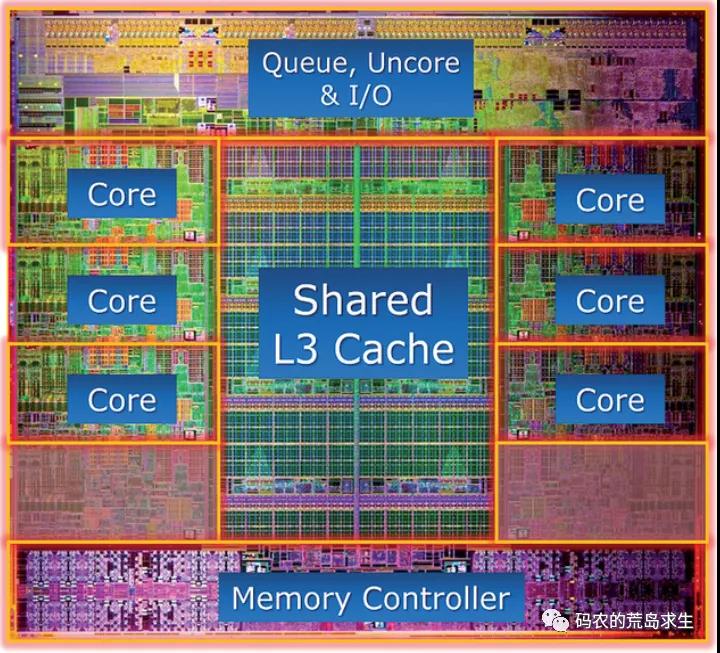

访存与cache

访问L2 cache的时延大概是访问L1 cache的10几倍左右,而访问一次内存的时延则高达访问L2 cache的20倍,是访问L1cache耗时的200倍。

这一部分清楚的告诉每个程序员,编写出对cache友好的程序是至关重要的,尤其你的场景如果对性能要求很高则更是如此。

分支预测失败的惩罚大概只有5ns这个量级,博主在之前的文章《特斯拉遇上CPU:程序员的心思你别猜》这篇文章中专门讲解过CPU的分支预测功能。

分支预测

该功能主要针对 if 语句,由于现代CPU内部采用流水线方式来处理机器指令,因此在 if 对应的机器指令还没有执行完时后续指令就要进到流水线中,此时CPU就必须猜测到底 if 语句是否为真,如果CPU猜对了,那么流水线照常运行,但如果猜错了流水线中已经被执行的一部分指令就要作废。

很多同学看到这篇文章后表示if语句是不是尽量少用,从这张表可以看出,分支预测失败的惩罚不高,并且现代CPU的分支预测成功率很高,根本不必在意这点性能损失。

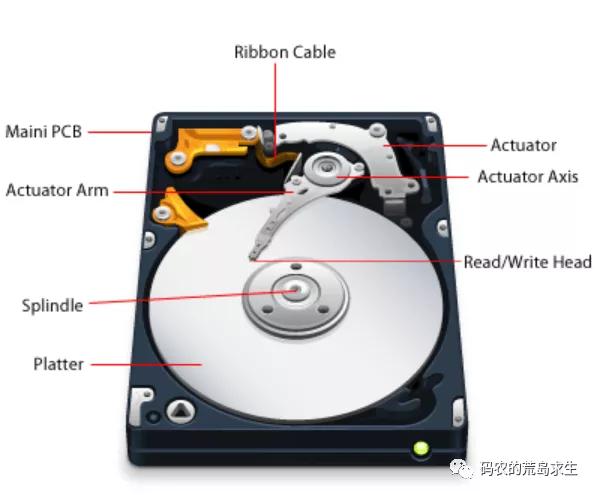

内存、SSD与磁盘

程序员都知道访问内存的速度比SSD块,访问SSD速度比磁盘快,那么到底能快多少呢?

同样顺序读取1MB数据,内存花费的时间为250,000 ns,SSD为1,000,000 ns,磁盘为20,000,000 ns。

我们可以看到,同样读取1MB数据,磁盘花费的时间是 SSD 的 20 倍,是内存的80倍。

同样读取1MB数据,SSD耗时是内存的4倍。

这组数据告诉我们,相对内存来说磁盘真的很慢,如果你的经费充足就用SSD吧,如果你是土豪,那么就把数据库直接放到内存吧。

网络与磁盘

一般来说我们认为内存比磁盘快,磁盘比网络快,但这这张表告诉我们用1Gbps网络发送1K数据仅仅需要20,000 ns,而磁盘的一次寻道则高达10,000,000ns(10ms),网络IO可不一定比磁盘IO慢。

当然,这也要看网络两端距离有多远。

网络

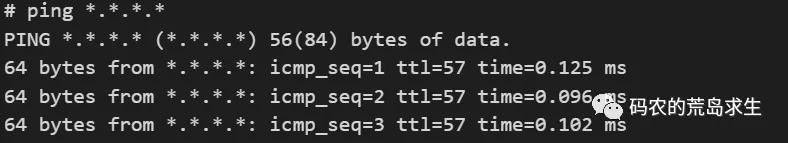

想测量数据包在网络两端来回一趟需要耗时多少?ping命令再简单方便不过了。

首先,博主在数据中心内部ping一台主机(注:ip地址用*来代替):

一圈下来耗时仅在100 us左右,速度非常快,在数据中心内部空间距离几乎可以忽略不计。

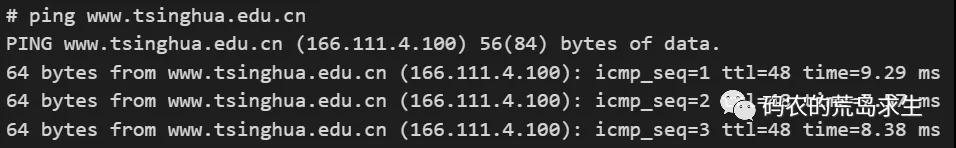

我的坐标在北京,接下来我们ping一下清华大学,哈哈,注意现在由于云服务商的存在,清华大学的官网服务器主机可不一定在清华大学里,为简单起见我们认为所ping的机器都在相应的地理位置上。

这个耗时就很可观了,我们姑且用市中心到清华大学的直线距离评估一下数据包路径长度(实际数据包的路径肯定和这里不同),可以看到大概在10公里左右的数量级,用时将近10ms,不要觉得10ms很耗时,磁盘一次seek就是这个量级。

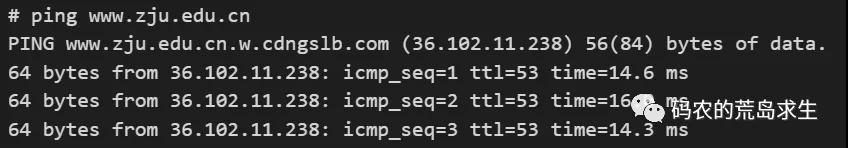

接下来出个省,ping一下浙大:

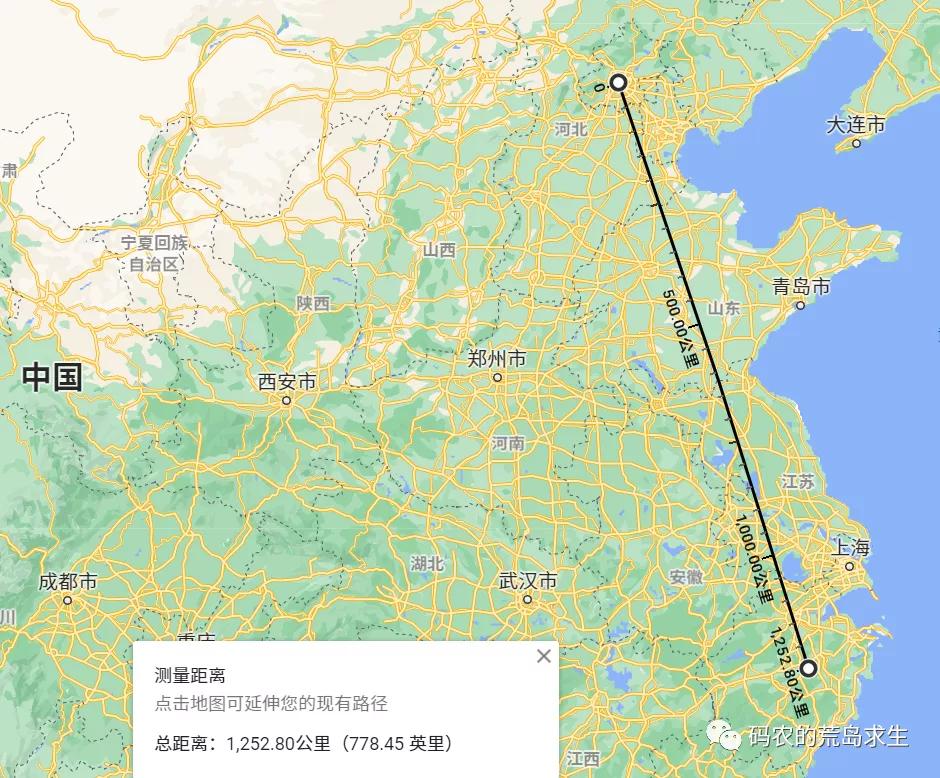

出了省就是不一样,北京与浙江的直线距离大概在1200公里,网络上走一圈耗时来到了将近15ms。

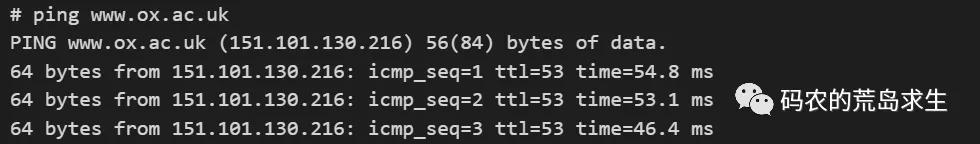

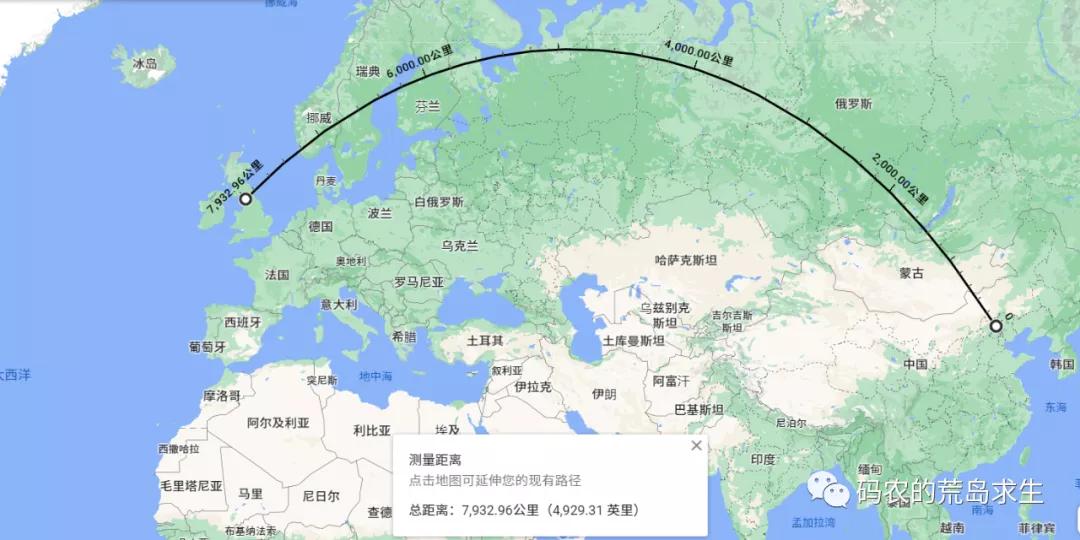

接着我们出趟国吧,去英国转一圈,ping下牛津大学:

出了国就更不一样了,北京与英国直线距离(球体表面)大概在7000公里,网络耗时将近50ms。

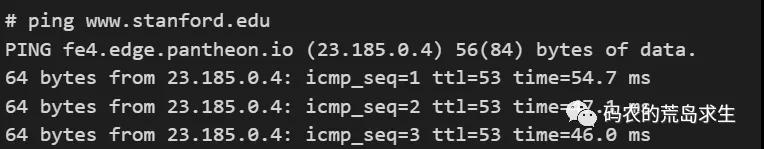

最后让我们去趟美国,ping下斯坦福大学:

和预想的差不多,北京与斯坦福直线距离大概在10000公里,耗时也在50ms左右。

从这组测试我们可以看出,网络的耗时和空间距离有很大关系,但在数据中心内部网络其实是非常快的,这一点在进行系统设计时需要意识到。

总结

系统设计一种工程实践,不是艺术遐想,每一个关键决策都要有依据而不能拍脑袋,本文的这张表就是你的依据(之一)。

希望这篇文章对大家理解系统时间有所帮助。

本文转载自微信公众号「码农的荒岛求生」,可以通过以下二维码关注。转载本文请联系码农的荒岛求生公众号。