如今,企业组织越来越依赖人工智能和机器学习模型进行决策,可以说这些决策正在影响我们生活的方方面面,例如,银行使用人工智能来确定是否向客户提供信贷以及信贷额度;医疗放射科部署人工智能来帮助区分健康组织和肿瘤;人力资源团队使用人工智能从海量简历中筛选合适的应聘者。

2019年,欧盟出台的《人工智能道德准则》中明确提出,人工智能的发展方向应该是“可信赖的”,能够包含安全、隐私和透明、可解释等多个方面。但随着人工智能技术不断普及,由此产生的风险也浮出水面,主要体现在两大方面:

- 信任危机,即能否信任和依赖人工智能算法输出的结果。

- 道德危机,Deepfake技术的出现在带来新鲜感的同时,也引发了人们对于深度学习和人工智能技术滥用的担忧。

“黑盒”人工智能

如今,许多机器学习应用程序不允许人们完全理解其功能或背后的逻辑,以实现称为“黑盒”的效果,鉴于此,如今的机器学习模型大多是“黑盒”。

这个特性被认为是人工智能技术应用的最大问题之一,它让机器决策变得不透明,甚至专家或开发人员自己也常常难以理解,这也降低了企业对特定领域的机器学习和人工智能的信任感。

【黑盒AI和XAI】

可以说,传统的“黑盒”人工智能程序存在以下问题:

- 难以验证输出是否“正确”;

- 难以理解人工智能系统“哪里出错”,然后进行改进;

- 难以理解创作者的偏见和不公。

因此,了解人工智能算法预测背后的原因至关重要,这不仅可以增强人们对人工智能算法的信心,还可以提供对模型的见解或允许对开发的算法执行调试过程。

公众愈发有兴趣了解这些算法背后的过程,原因之一是各种国际法(例如欧盟GPDR)的引入提高了公众对隐私的敏感度,这些法律对隐私领域施加了高水平的保护,同时在信息处理过程中要求了更高的透明度,这也是人工智能算法目前正在努力实现的目标。

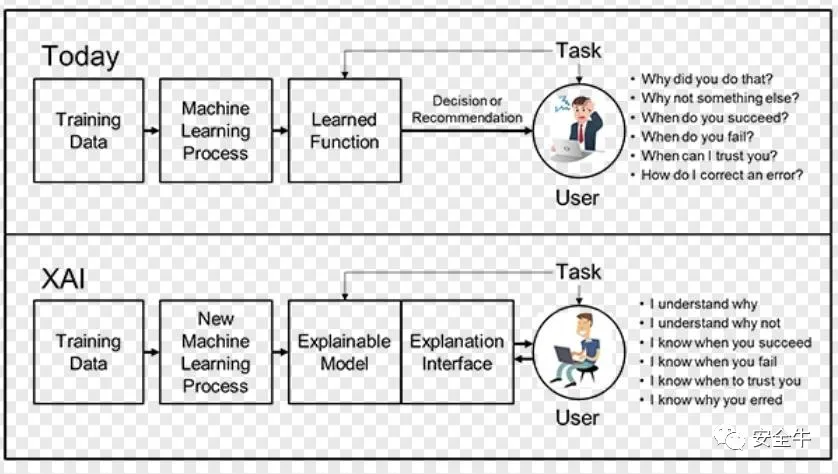

所有这一切都转化为对人工智能算法透明度日益增长的需求。而人工智能背景下对透明度的需求也进一步推动了所谓的“可解释的”人工智能(XAI)的发展,它代表了一组技术,可以理解和呈现机器学习模型和人工智能算法的透明愿景。

什么是“可解释的”人工智能?

“可解释的”人工智能并不是一个新的研究领域,它是自80年代以来就存在的支持复杂AI系统的推理架构,可以看作是人工智能设计的自然结果。

人工智能的未来可能取决于它允许人们与机器协作解决复杂问题的能力。与任何高效协作一样,这需要良好的沟通、信任和理解,而可解释的人工智能旨在应对这些挑战。

简单来说,可解释的人工智能是组织用来帮助人们更好地理解模型为何做出某些决策及其工作原理的一组工具和技术。XAI是:

- 一组最佳实践:它利用数据科学家多年来一直使用的一些最佳程序和规则来帮助其他人了解模型是基于哪些数据进行训练的,还揭示了模型可能暴露于哪些偏见来源;

- 一组设计原则:研究人员越来越关注简化AI系统的构建,使其本质上更易于理解;

- 一组工具:随着系统变得更容易理解,可以通过将这些知识融入其中来进一步完善训练模型,并通过向其他人提供这些知识以纳入他们的模型。

XAI为什么很重要?

对于组织而言,通过模型监控和人工智能问责制全面了解人工智能决策过程,而不是盲目信任它们,这一点至关重要。可解释的人工智能可以帮助人类理解和解释机器学习(ML)算法、深度学习和神经网络。

ML模型通常被认为是无法解释的黑匣子;深度学习中使用的神经网络是人类最难理解的部分;偏见(通常基于种族、性别、年龄或位置)一直是训练AI模型所面临的长期风险。此外,由于生产数据与训练数据不同,人工智能模型性能可能会受到影响甚至降低。这使得持续监控和管理模型以促进人工智能可解释性变得至关重要。

可解释的人工智能有助于促进最终用户的信任、模型可审计性和人工智能的高效使用,同时还降低了使用人工智能所面临的合规性、法律、安全和声誉风险。此外,借助可解释的人工智能,企业可以排除故障并提高模型性能,同时帮助利益相关者了解人工智能模型的行为。

其优势可以概括为:

- 简化模型评估过程,同时提高模型透明度和可追溯性;

- 系统地监控和管理模型以优化业务成果,不断评估和改进模型性能;

- 加快获得AI结果的时间;

- 降低模型治理的风险和成本;

可解释的人工智能是实施“负责任的”人工智能的关键要求之一,具有公平性、模型可解释性和问责制。为了实现负责任地采用人工智能,组织需要通过构建基于信任和透明度的人工智能系统,将道德原则嵌入人工智能应用程序和流程中。

XAI的应用实例

如今,可解释的人工智能正在改变各种垂直市场的游戏规则:

- 医疗卫生:加速诊断、图像分析和资源优化,提高患者护理决策的透明度和可追溯性,同时还能简化药品审批流程。

- 金融服务:通过透明的贷款和信贷审批流程改善客户体验,加快信用风险、财富管理和金融犯罪风险评估,加速解决潜在的投诉和问题,提高对定价、产品推荐和投资服务的信任度。

- 刑事司法:优化预测和风险评估流程。在DNA分析、监狱人口分析、欺诈检测和犯罪预测方面使用可解释的人工智能加速解决问题。检测训练数据和算法中的潜在偏差。

可解释的人工智能的五个注意事项:

- 公平和消除偏见:管理和监控公平,扫描用户部署以查找潜在的偏见;

- 模型偏离缓解:分析模型并根据最合乎逻辑的结果提出建议。当模型偏离预期结果时发出警报;

- 模型风险管理:量化和减轻模型风险。当模型表现不佳时发送警报。了解当偏差持续存在时会发生什么;

- 生命周期自动化:构建、运行和管理模型作为集成数据和AI服务的一部分。统一平台上的工具和流程以监控模型和共享结果,解释机器学习模型的依赖关系;

- 多云就绪:跨混合云部署AI项目,包括公共云、私有云和本地。通过可解释的AI促进信任和信心。

当今时代,人们迫切需要可解释的人工智能,而“负责任”和“可解释”的人工智能也确实将会是取得利益双方信任及满足未来合规需求的基石,但想要实现这一目标无疑是道阻且长的。

【本文是51CTO专栏作者“安全牛”的原创文章,转载请通过安全牛(微信公众号id:gooann-sectv)获取授权】