如果在你的爱车里,有一款能像人一样表达情绪的智能车载语音助手,它媲美人声,不用反复唤起就能流畅对话,会对你说“好滴”而不是“好的”,这样的语音助手你会心动吗?

不久前,小鹏汽车P7车型进行了一次重要的OTA(Over-The-Air,远程空中下载)系统升级,其中语音助手小P媲美人声的更新,再次拉高了智能汽车语音助手的水平线。

“耗时十个月上线,这是一次汽车界对车载语音的前沿探索。”小鹏汽车AI产品高级专家郝超说道。

对于车载语音来说,“媲美人声”为什么很重要,小P的更新到底高明在什么地方?我们跟郝超以及微软云计算与人工智能事业部产品总监丁秉公聊了聊关于车载语音的那些事儿。

车载语音“媲美人声”为什么很重要?

不知道大家有没有这种感觉,在手机上或者智能音箱上听机器人播新闻,好像总没有真人主播播得痛快;特别是无聊的时候,想跟语音助手逗个乐,三两句话下来,总会无奈地自言自语一句:“它真的好傻啊。”

在业界,这种同语音助手互动不流畅带来的不适感,可以用“听觉疲劳”来形容。而相对于家常环境场景下的语音互动,如在长时间开车的场景下,车主很大程度上会放大对听觉疲劳的感知。换句话说,车主对语音助手语音流畅度、自然度敏感性更高,对车载语音助手更逼近人声的需求也更高。

“小P升级后,很多车主半夜蹲点儿去车里抢先试听新声音。”郝超说起小P刚更新时一些车主的反应。

这与车载语音产品不断追求“媲美人声”的效果,形成了一种默契。“原来我们可能只追求让大家把声音听懂就行,后来我们认为不仅要听懂,还要像人声一样更加自然,最后我们觉得自然还不够,还想用多情感的声音来代替单调的声音。”丁秉公表示。

因此早在2018年,为了让人工智能的声音更自然,微软就已经在神经网络语音合成技术上做了很多工作。最近两年来,该技术的不断创新使合成声音错误率进一步减少、显著提升了句子韵律的合成质量和语音的高保真度。

数据显示,经行业公认的、专业评估语音自然度的MOS(Mean Opinion Score平均意见评分)测试,微软AI语音评分4.49分(真人录音得分 4.5分),这证明在音质、发音、说话准确性和清晰度等方面,合成语音已经能够与真人录音样本相媲美。

这种更自然的合成声音也推动了车载语音场景的应用的落地,小鹏汽车在这个过程中成了那个率先吃螃蟹的人。

不过需要强调的是,微软提供的神经网络语音合成技术、及其背后的语音模型,都是平台化的可匹配多行业的通用产品,要将这种通用产品与小鹏汽车的特定场景融合,双方还要在“车载”场景上做很多融合。

“车规级”语音需要克服哪些难点?

有人可能会说,车载语音不就是语音交互吗,现在不管是手机还是音箱,但凡带点“智能”,让它“说话”似乎并不是什么难事。这种质疑并没有什么问题,但仔细想来,就像芯片也有车规级一样,汽车的语音交互系统也在不断追求“车规级”的完美。

据郝超和丁秉公介绍,车规级语音需要克服的挑战主要有3个:

第一,应对汽车移动状态下的网络抖动,在保证声音保真率的情况下尽量压缩对流量及硬件性能的消耗,同时还要解决合成语音上比较难的歧义、分词问题。

为了应对网络抖动,小鹏汽车采取了多级缓存的方法,把好的声音提前进行各级缓存然后下发,尽量减少对网络的依赖。“比如系统判断前方500米有摄像头,该播报了,但可能在‘前方’两个字播出之后会因为网络抖动导致这句话播不全,那系统会启动语意动态等待。”郝超说,“等个1-2秒,网络抖动过去,再播报。虽然多开了两米,但在可接受范围内。”不过,像“前方右转”等这类特殊情况除外,系统则不会启动动态等待。

第二个比较大的难点是语音高保真度带来的连锁挑战。

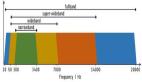

一般情况下,大部分车载语音系统的语音采样率为16k HZ(一秒钟有1万6千个采样点),量化水平在8比特(每个采样点数据量为8比特)。而小鹏汽车使用的语音模型在采样率上达到了24k HZ,量化水平为16比特,这也就意味着一秒钟的信息量是几十KB,那么一分钟可能就是几十兆,一小时可能就是接近一个G,一天就是几十G。不压缩的话,这么大流量的压力是非常大的。

“除了刚才谈到的多级缓存,云计算在这里也起到了很大的作用。这些高质量的声音与微软云相结合,在不降低声音质量的情况下,能够实现用户对高保真语音体验上的实时传输。”丁秉公表示。

高保真的声音也增加了对整车CPU的资源占用。因此,在实践过程中,小鹏汽车尽量不占用本地的计算资源,在网络条件好的情况下尽量对在线模型发起请求,而不是依赖本地,尽量平衡单位周期内对CPU的占用。

另外一个挑战是解决合成语音中歧义的问题。中文的分词,多音字,数字读法等都有歧义问题。一个典型的例子是比如“南京市长江大桥”,合成语音可能断句为“南京 市长 江大桥”,这类乌龙在AI合成语音中目前仍然很常见。“在不同的场景下,受众对歧义的容忍度有很大差别。因此我们希望针对合成语音的使用场景进行优化,减少歧义对用户体验的影响。”丁秉公强调。

比如,还是上文谈到的人工智能播新闻的场景,这个时候AI分词出现错误最严重可能就是对某个句子听不懂,但在车载场景下可能直接影响到车主的车况。这些都要在车载端做优化,保证车主在开得比较快、噪音比较大的听音环境下也能够听到高保真的声音。这也是车规级语音同我们日常用的智能手机语音助手、智能音箱助手比较大的不同。

车载语音“媲美人声”是壁垒还是趋势?

技术在产业落地的过程,往往被看作是技术寻找场景的过程。场景找到了,技术是否高深、前沿便显得没那么重要。

小鹏汽车的媲美人声的车载语音助手也正是运用了微软的通用语言模型才达到了当前的效果。但对于使用了通用技术的小鹏来说,小P的炼成是一次前沿技术的探索,还是通用技术落地的其中一环呢?

对于这个问题,郝超的答案更偏向于前者。“当大家不知道AI能做什么事情的时候,可能认为,找场景更重要。把现有的这些技术落地到某一个场景,可能就有AI了。这是因为大家对这个事情理解不深。”他说,“当对整个车载场景,或者对出行有足够深的理解的话,就会发现这里面有太多太多的问题要解决。”

郝超认为,智能汽车非常依赖高精尖技术,甚至现在很多技术做不到的事情,他们也希望能尝试通过技术来解决。也就是说,对于新技术的应用,小鹏汽车的思路是,不是有这样一个技术能用到什么样的场景,而是我们看到这样一个场景,去探索、寻找有没有更好的技术来解决。

“作为一个造车新技术的探索者,可能踩的坑会比较多,甚至成本也很高,但其实我们一直是希望探索明白了之后,路趟平了之后,告诉业内同行们,这个方向用户是认可的。以此推动整个行业的进步。”郝超总结。

事实证明,小P的上线确实达到了这样的效果。

当下,作为提供通用技术平台的微软也正在将小鹏汽车对于语音模型的应用经验,反哺到通用语音模型中。

“从技术上面,我们其实想大道至简,用一套模型可以服务所有的用户。”丁秉公说道。他认为,微软在不同行业里的积累,正在扩大微软的模型能力,触类旁通后,使得像小鹏这样的企业能够在他们的基础模型上,享受到平台级的AI模型红利。