在外界的压力下,苹果最终还是选择了「让步」。

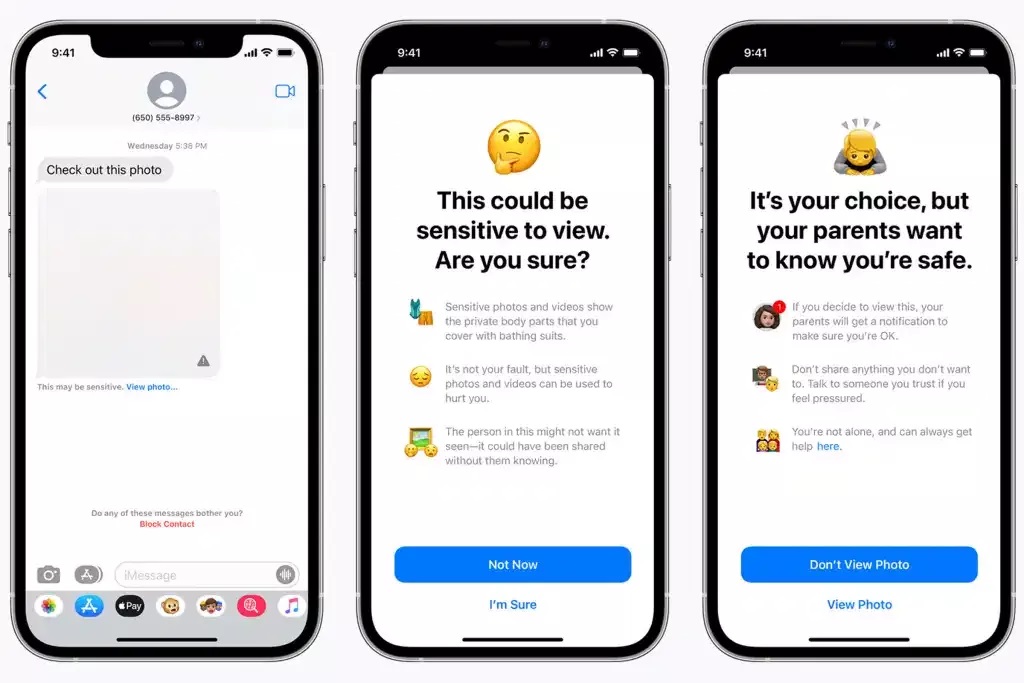

上个月,苹果公司宣布推出了几项保护儿童的技术功能,包括 Messages 信息应用中敏感图像筛查、iCloud 中儿童性虐待内容的检测(CSAM)以及 Siri 和搜索功能的相关内容的支持。并且,针对 iCloud 中的儿童性虐待图片,苹果表示还将向执法部门报告上传。

这一系列的儿童保护功能原定于在 iOS 15、iPadOS 15、watchOS 8 和 macOS Monterey 等苹果各平台操作系统更新时一并推出。

图源:Apple

不过,苹果公司的 CSAM 检测技术一经宣布,便引发了公众对隐私方面的担忧。隐私倡导者纷纷予以批评与抵制,苹果内部员工也担心政府利用这一功能来对人们进行审查,并担心苹果的声誉会因此受损。

面对隐私方面的担忧,苹果公司也曾对 CSAM 检测技术做出过回应,表示:「苹果不会扫描机主的整个照片库来寻找虐童图片,而是使用密码学把图片与美国国家失踪与受虐儿童中心提供的已知数据库进行比对。」苹果称,这一功能并不是为政府监控公民而设计,并且只在美国提供,只有用户打开 iCloud 时才启用。

但是,苹果的回应显然无法消除公众的质疑,争议一直未停。

终于,苹果公司于近日宣布推迟 CSAM 儿童保护功能,并表示「在面向公众推迟之前,公司将投入更多时间来完善这些功能。」

计划推迟,延迟时间长短尚不清楚

苹果表示,来自客户、非营利组织和倡导团体、研究人员以及其他人的反馈,促使苹果推迟了这项计划。苹果公司就其决定发表了以下声明:

| 上个月我们宣布了一些功能改进计划,旨在帮助保护儿童,让他们免受那些通过通信工具来利用他们的人,并限制儿童 CSAM 的传播。根据客户、倡导团体、研究人员和其他人的反馈,我们决定在未来几个月内花更多时间收集意见并进行改进,然后再发布这些至关重要的儿童安全功能。 |

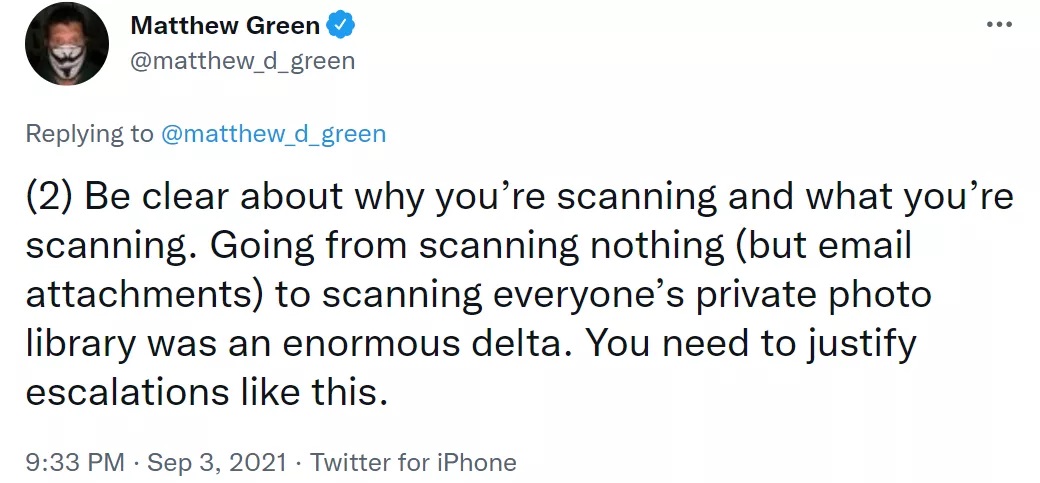

翰霍普金斯大学安全研究员 Matthew Green 在推特上表示,苹果公司应该清楚你为什么要扫描以及你在扫描什么。

此前,Green 就曾批评过苹果的这项举措,他认为不论苹果的长远计划是什么,他们都发出了一个明确信号,即他们认为建立一个监测和扫描用户手机中违禁内容系统是安全的。至于最后结果是对还是错几乎无关紧要。关键是这将打开闸门 - 各国政府将会要求每个人都这样做。

从什么都不扫描(除了电子邮件附件)到扫描每个人的私人相册,这是一个巨大的变化。你需要证明这样的升级是合理的。

「如果苹果必须扫描图片,他们应该扫描服务器上未加密文件,这是其他公司的标准做法,比如 Facebook,它们不仅定期扫描 CSAM,还会扫描恐怖主义和其他不允许的内容类型。」Green 还建议苹果应该对 iCloud 存储进行端到端加密。

数周以来,苹果一直在为该计划辩护,并且已经提供了一系列解释和文件,以表明误检测的风险很低。

不过,也有人表达了不同的观点。

NSPCC 儿童安全在线政策负责人 Andy Burrows 表示道,「这是一个令人非常失望的延迟。苹果正在努力推出真正意义上的重大技术解决方案,这些解决方案无疑将在保护儿童免受网络虐待方面起到重大作用,并可能制定行业标准。」苹果试图采用一种适当的方法,以保护隐私的方式扫描虐待儿童照片,从而平衡用户安全和隐私。

图源:thesun

目前尚不清楚苹果计划何时推出这些至关重要的功能,但该公司似乎仍有意推出这些功能。

【本文是51CTO专栏机构“机器之心”的原创译文,微信公众号“机器之心( id: almosthuman2014)”】