《芝麻街》中有一个游戏,叫做「其中一个不一样(One of These Things Is Not Like the Other)」。顾名思义,参与该游戏的小朋友需要从几个东西中找出那个不一样的。对于人类幼崽来说,这个任务着实太简单了,换着花样玩一百次可能也不会出错。

但是,对于神经网络来说,这个游戏就没那么简单了。以强大的卷积神经网络(CNN)为例,经过训练的 CNN 可以完成一系列复杂任务,甚至比人类完成得还要出色,但最近的研究表明,CNN 只能在非常有限的条件下区分两个简单的图案是否相同。只要稍微改变这些条件,该网络的性能就会随之下降。

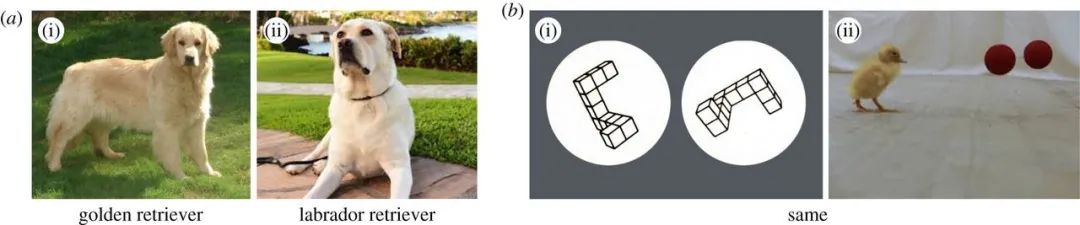

2018 年的一项研究表明,虽然 CNN 能够区分图 (a) 中两只狗的品种,但却不知道图 (b)(i) 中的两个图案其实是一样的,只是经过了旋转。

这些结果在深度学习研究者和认知科学研究者中引起了争议。如果工程方面得到提升,CNN 能否像人类幼崽一样区分「相同」和「不同」?还是说 CNN 的抽象推理能力本身就是有限的,无论设计得多么精巧,用多少数据训练?

无论哪种猜想是对的,大多数研究者都同意一个观点:理解异同关系是智能的重要标志,无论这种智能是人工的还是其他形式的。

「不只你我能够区分『相同』和『不同』,很多动物也能做到,比如鸭子和蜜蜂,」在约翰 · 霍普金斯大学研究视觉认知的 Chaz Firestone 表示。

成功区分异同的能力可以被看作人类作出各种推理的基础。DeepMind 研究者 Adam Santoro 表示,他们公司正在「以一种整体的方式研究异 - 同关系」,即不仅局限于视觉场景,还扩展到了自然语言和物理交互。

「当我让一个 AI 智能体『捡起玩具车』的时候,我的意思是让它捡起我们玩的这辆玩具车,而不是隔壁房间那辆。」他解释说。去年 10 月份一项关于异同推理的研究也强调了这一点。来自布朗大学等机构的研究者在文中写道:「如果没有识别『相同』的能力,打造真正智能的视觉推理机器的梦想就会变得无望。」

自 2013 年起,异同关系就一直困扰着神经网络。当时的人工智能先驱 Yoshua Bengio 及其合作者 Caglar Gulcehre 在论文《Knowledge Matters: Importance of Prior Information for Optimization》中的研究表明:CNN 无法判断若干组俄罗斯方块形状是否相同。但这个盲点并没有阻止 CNN 主宰 AI。卷积神经网络曾帮助 AlphaGo 击败了世界上最好的围棋棋手,近 90% 支持深度学习的 Android 应用都依赖于卷积神经网络。

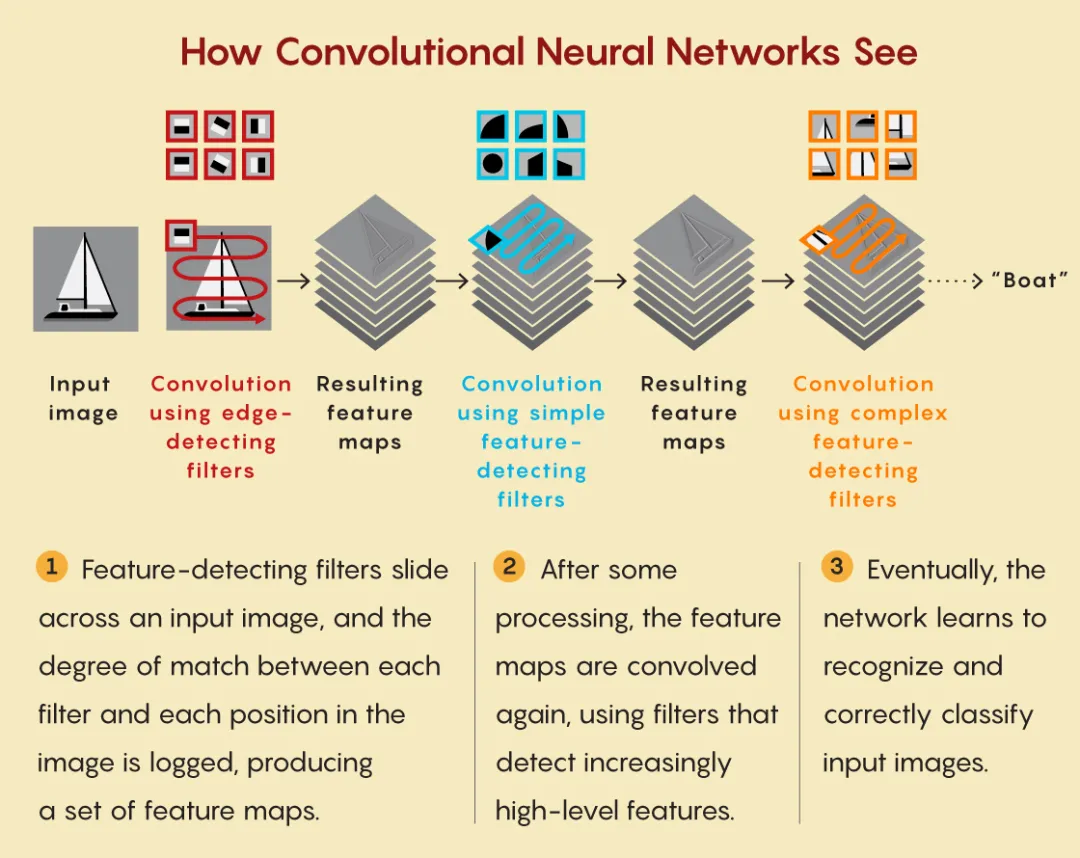

这种能力的激增重新点燃了一些研究人员对探索神经网络无法做到的事情的兴趣。CNN 通过粗略模仿哺乳动物大脑处理视觉输入的方式来学习视觉处理。神经网络中一层人工神经元检测原始数据中的简单特征(例如亮度和对比度差异)。然后神经网络再将这些特征传递给连续的层,这些层将它们组合成更复杂、更抽象的类别。

根据布朗大学机器学习研究员 Matthew Ricci 的说法,异同关系似乎是对 CNN 局限性一个很好的测试,因为它们是「与图像特征无关的最简单问题。」也就是说,两个对象是否相同并不取决于它们是一对蓝色三角形还是一对红色圆圈。特征之间的关系比特征本身更重要。

2018 年,Ricci、Junkyung Kim 和 Thomas Serre 在来自合成视觉推理测试 (SVRT) 的图像上测试了 CNN,SVRT 是一组旨在探索神经网络抽象推理技巧的简单图案。这些图案由在白色方块上以黑色轮廓绘制的成对不规则形状组成。如果一对图案在形状、大小和方向上都相同,则被归类为「相同」;否则,这一对被标记为「不同」。

Ricci 等人的研究发现,使用来自 SVRT 图像集中的新样例训练 CNN,辨别异同的准确率将高达 75%。但是只要以非常简单的方式修改形状(比如只是让它们变大,或者拉远它们之间的距离),CNN 的准确率就会严重下降。研究人员因此得出结论,神经网络仍然专注于特征,而不善于学习「异同」等关系概念。

去年,图宾根大学的 Christina Funke 和 Judy Borowski 的研究表明,将神经网络的层数从 6 层增加到 50 层可以将其在 SVRT 异同任务上的准确率提升到 90% 以上。然而,他们并没有测试这个层数增加的 CNN 在 SVRT 数据集以外的样例上性能如何。因此,该研究没有任何证据表明更深层的 CNN 具备概括「异同」定义的能力。

布里斯托大学的认知科学家 Guillermo Puebla 和 Jeffrey Bowers 在今年早些时候进行了一项后续研究。Puebla 以人类的智能举例说:「人们一旦理解一种事物关系,就可以将它应用到任何相关事情上」,他认为 CNN 也应该遵守这个标准。

Puebla 和 Bowers 使用 4 种不同的初始设置(其中包含 Funke 和 Borowski 使用的一些设置)在 SVRT 异同任务的几种变体上训练了四个 CNN。他们发现图案低级特征的细微变化(比如将形状轮廓的厚度从一个像素更改为两个像素)通常就足以让 CNN 的性能降低一半,从接近完美到几乎无用。

这对人工智能意味着什么?不同人有不同的回答。Firestone 和 Puebla 认为最近一些研究中的实验结果表明:当前的 CNN 缺乏基本的推理能力,并且无法通过添加更多数据或设计更精巧的训练来解决这个问题。Puebla 表示:「尽管 CNN 越来越强大,但它不太可能解决辨别异同的问题。也许引入其他方法能够解决,而只依靠 CNN 自己则无望。」

Funke 同意 Puebla 的结论。但她建议:「声称深度卷积神经网络无法学习一个概念要非常谨慎。」DeepMind 研究员 Santoro 表示同意:「缺乏证据并不代表着证据不存在,神经网络历来如此。」Santoro 指出:神经网络在数学上已被证明能够在原则上逼近任何函数,并说道:「研究人员在这方面需要做的就是确定函数所需的实际条件。」

Ricci 则认为:让任何机器学会辨别异同都需要在对学习本身的理解上取得突破。人类幼崽玩一次游戏就能够区分异同,不需要长期训练。鸟类、蜜蜂和人类都可以通过这种方式学习,除了辨别异同,还有许多认知任务也是如此。Ricci 说:「我认为在弄清楚如何从少量样本和新数据样本中学习之前,很多问题都不能完全解决。」

2011-05-31 09:51:23

2017-03-16 14:59:47

2017-08-16 09:55:36

2022-12-27 08:01:09