CVPR 2021 车道线检测方向论文: Keep your Eyes on the Lane: Real-time Attention-guided Lane Detection 。

论文:

https://arxiv.org/pdf/2010.12035.pdf

代码:

https://github.com/lucastabelini/LaneATT

0

动机

车道线检测是自动驾驶领域非常重要的子任务之一。作者提出了一个实时、高性能的车道线检测算法,将其命名为LaneATT。

该方法基于anchor实现,且应用了注意力机制,轻量级版本的推理速度达到250FPS。

01

网络结构

1.1 总体流程

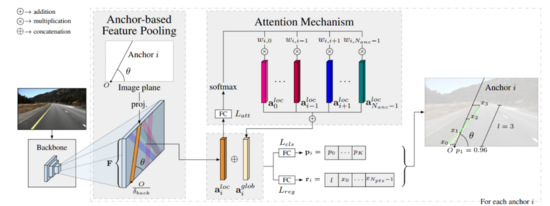

算法总体流程如下图所示:

将车辆前视相机采集到的RGB图像作为输入,输出车道线位置。

从上图中可以看出,该算法将backbone的输出结果进行池化操作,以提取每个anchor的特征;将提取到的特征与注意力模块产生的全局特征进行融合,以解决遮挡、光照等原因导致车道线检测不到的问题;融合后的特征作为全连接层的输入,全连接层输出车道线的置信度和相关参数。

1.2 车道线和anchor的表示方法

车道线的表示

沿图片纵向做等分操作,得到的等分点记作,其中。

对于每条车道线,令固定,因此决定了每条车道线的差异;每个都与对应的形成车道线上的一个点。

由于车道线不会贯穿整张图像,令和分别表示的开始索引和结束索引,用于表示车道线的连续有效点。

anchor的表示

使用原点和方向表示anchor,其中。

原点总是位于图像的左、右、下三个边界上。

1.3 Backbone

使用诸如ResNet的通用网络作为LaneATT的backbone;将backbone的输出特征记作。

为减少后续模块计算量,对做卷积,将输出结果记作。

1.4 feature pooling

对于每个anchor,都要从中提取特征,使用坐标索引要从中提取的特征点。先定义这些坐标点的方向坐标:,使用如下公式求它们对应的坐标:

上式中的和表示anchor的原点和方向,表示特征对应原图的步长。

对于每个anchor,使用上述的和,从中提取到特征;若上述计算得到的某个点的坐标值超出的范围,则中对应位置的值为0。

1.5 注意力机制

上文提到的feature pooling操作得到的为局部特征。为了能够应对遮挡、光照等复杂场景,需要将局部特征与全局特征融合。

作者使用注意力模块,该模块的输入为局部特征,输出为全局特征。

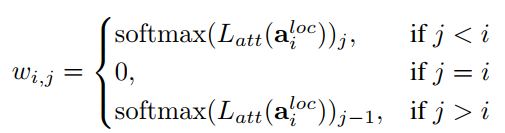

注意力模块中包含一个全连接层,对于索引为的anchor,该anchor对应的局部特征作为的输入,的输出为权重:

用于融合除第i个anchor以外的其他anchor对应的局部特征从而形成全局特征:

以上内容只是针对索引为i的anchor;对于所有的anchor,可以使用矩阵乘法快速实现。假设anchor的数量为,令,,使用如下矩阵乘法计算所有anchor对应的全局特征:

上式中,且。

1.6 prediction head

对于索引为i的anchor,其局部特征和全局特征做concat操作,输出结果记作。作为2个并行的全连接层的输入,其中一个全连接层用于分类,输出信息为;另外一个全连接层用于回归,输出信息为。

对于每个anchor,网络最终输出3类信息:

(1)个概率值,用于预测该anchor对应的车道线类别和背景的概率。对于不包含车道线类别标注信息的数据集,令。

(2)个offset值,指出anchor中个点和预测出的车道线上点的横向偏移。

(3)车道线的长度,是anchor中实际用来表示车道线的点的数量。根据1.2节中的信息,和分别表示的开始索引和结束索引,其中可由anchor原点的坐标决定,长度可用于确定的值:

1.7 NMS

定义2条车道线和的距离为:

上式中,。

使用上述定义的距离对网络预测结果进行NMS操作,减少false positive的数量。

02

模型训练

2.1 训练

在训练时,依然使用1.7节中定义的距离来衡量anchor和ground truth的距离。当两者距离小于阈值时,该anchor被当作正样本,当两者距离大于时,该anchor被当作负样本;否则忽略该anchor。

构造如下损失函数:

上式中的和分别表示网络的分类分支和回归分支的输出结果,和为真值。为Focal Loss,为Smooth L1损失函数;用于平衡2个损失函数。回归损失是基于对应anchor和ground truth之间共同的横坐标计算的。

2.2 模型加速

在训练和推理时,共有2782个anchor,如此庞大的anchor数量会降低计算效率。有相当一部分anchor在训练和推理时都是无效的,比如起点在地平线以上的anchor。测量在训练集中每个anchor作为正样本的次数,作为评价anchor是否有用的指标。在后续的训练和推理时,选取个使用次数最多的anchor。

03

实验结果

在训练时,网络输入图片分辨率为,使用translation、rotation、scaling和horizontal flip用于数据增强。设置,,,。

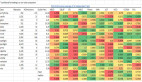

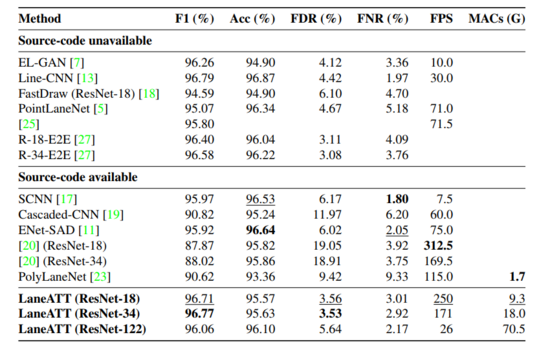

在TuSimple数据集上的结果如下表所示:

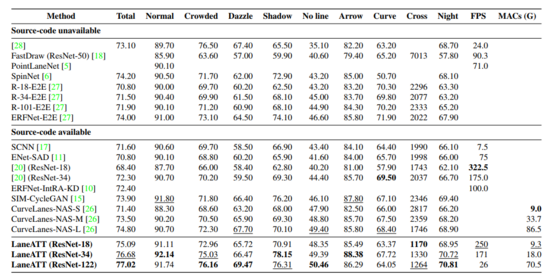

在CULane数据集上的结果如下表所示:

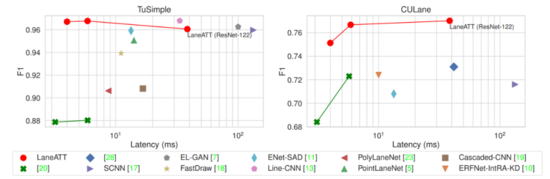

在2个数据集上模型运行时间和性能的对比情况如下图所示:

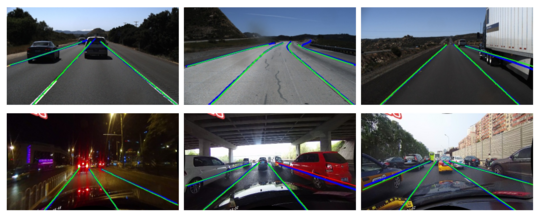

可视化的结果如下图所示:

上图中第一行为TuSimple数据集的可视化结果,第二行为CULane数据集的可视化结果。图中蓝线为ground truth;绿线和红线均为网络输出结果,绿线为true positive,红线为false positive。

04

总结

-

提出了实时、单阶段、基于anchor的高性能车道线检测算法LaneATT;

-

在LaneATT中应用注意力机制,提高算法性能;

-

LaneATT能够很好地平衡精度和推理速度。