谷歌人工智能研究人员和印度卡哈拉格普尔理工学院(Indian Institute of Technology Kharagpur)一起合作开发了一个新的框架,可以从音频内容中综合有声头像。

该项目的目的是开发出经过优化且资源合理的方法,实现根据音频创造「会说话的头像」视频,在交互式应用程序和其他实时环境中实现同步口型动作的配音或机器翻译的音频,并添加到头像。

论文地址:https://arxiv.org/pdf/2106.04185.pdf

机器学习模型LipSync3D

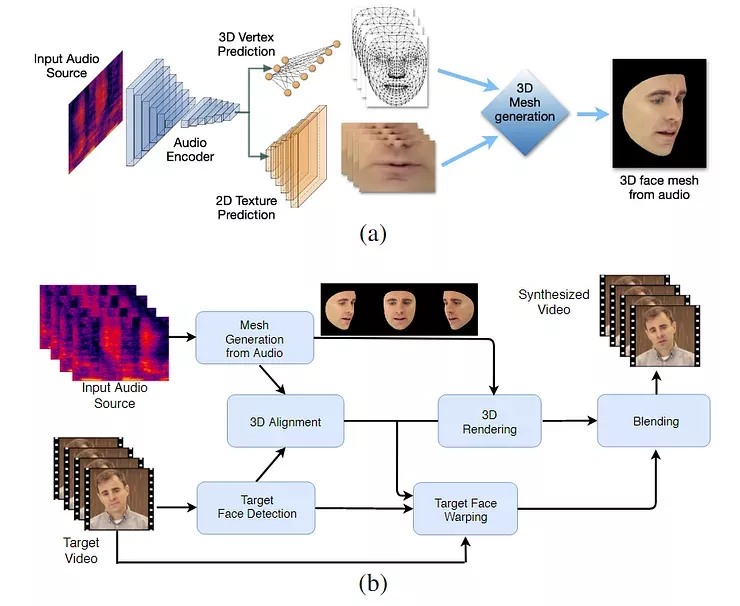

在这个过程中训练的机器学习模型LipSync3D,只需要一个目标人脸识别的视频作为输入数据。

数据准备管道将面部几何的提取与输入视频的灯光和其他方面的评估分离开来,允许更经济合算和更集中的训练。

LipSync3D的两阶段工作流程。上图是从「目标」音频生成的动态纹理三维人脸; 下图是将生成的网格插入到目标视频中。

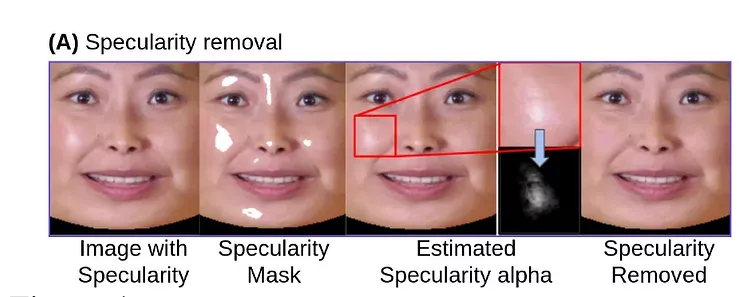

事实上,LipSync3D对这一领域研究工作最显著的贡献可能是其照明归一化算法(lighting normalization algorithm),该算法将训练和推断照明解耦。

从一般几何解耦照明数据有助于LipSync3D在具有挑战性的条件下产生更真实的口型变化。最近几年的其他方法已经将自己限制在「固定」的照明条件下,这样就不会暴露出它们在这方面的有限。

在输入数据帧的预处理过程中,系统必须识别和删除镜像点,因为这些镜像点是特定于拍摄视频光照条件的,否则会干扰重现过程。

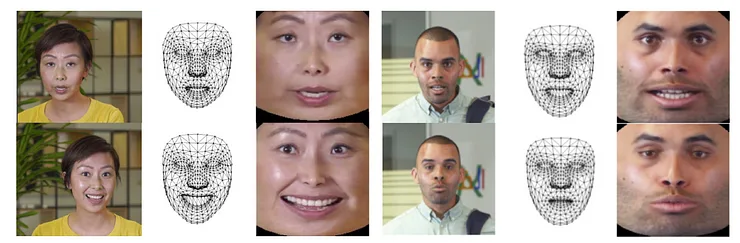

LipSync3D,顾名思义,不仅仅是对它评估的面孔进行像素分析,而是积极地使用已确定的面部标志来生成运动的CGI风格的网格,以及通过传统CGI管道包裹在它们周围的「展开」(unfolded)纹理。

LipSync3D 中的姿势归一化。左边是输入帧和检测特征; 中间是生成的网格评估的规范化顶点; 右边是相应的纹理图谱,为纹理预测提供了基础真实性。来源: https://arxiv.org/pdf/2106.04185.pdf

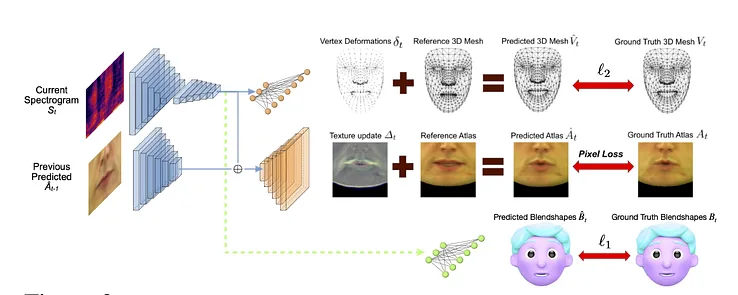

除了这种新颖的照明重现方法,研究人员声称,LipSync3D在以前的工作中提供了三个主要创新: 将几何、光照、姿态和纹理分离到规范化空间中的离散数据流中; 一个易于训练的自回归纹理预测模型,可以生成时间上一致的视频合成; 以及通过人类评级和客观度量来增加真实感。

分裂出的视频面部图像的各个方面允许在视频合成中实现更大的控制。

通过分析语音的音素和其他方面,LipSync3D可以直接从音频中推导出适当的唇部几何运动,并将其转化为嘴部周围已知的相应肌肉姿势。

这个过程使用一个联合预测管道,其中推断的几何形状和纹理在自动编码器设置中有专门的编码器,但与打算施加在模型上的语音共享一个音频编码器:

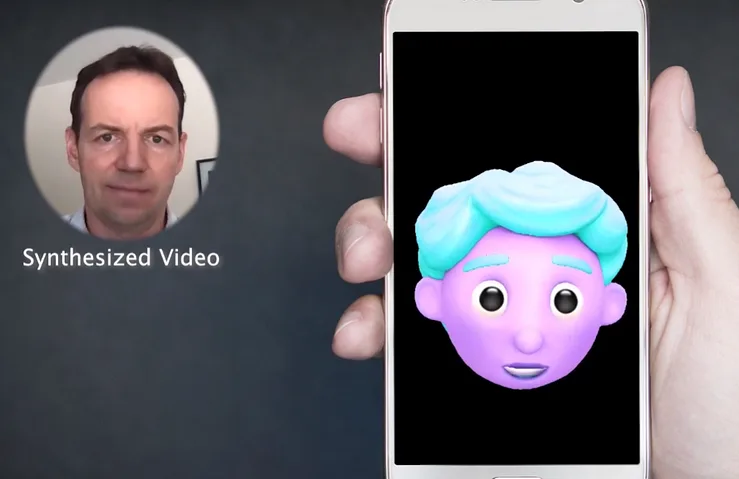

LipSync3D 的动作合成也助力提升程式化的CGI头像,实际上它们只是和真实世界的图像一样的网格和纹理信息:

一个个性的3D头像的嘴唇动作实时动力源扬声器视频。在这种情况下,最优结果将通过个性化的预训练获得。

研究人员还希望使用更加真实的头像:

在 GeForce GTX 1080上使用 TensorFlow、 Python 和 C + + 的管道中,视频的示例训练时间从2-5分钟的视频所需3-5小时不等。训练课程使用了一批大小为128帧超过500-1000epoch,每个epoch代表一个完整的视频评估。

未来:动态的口型再同步

过去几年,口型再同步适应新的音轨已经在计算机视觉研究中吸引了大量的关注,尤其是它还是有争议的deepfake技术的副产品。

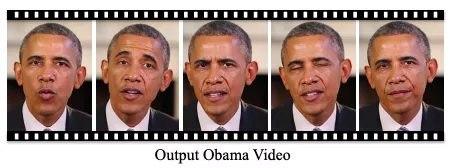

2017年,华盛顿大学展示了一项能够通过音频学习对口型的研究,还用当时的总统奥巴马的图片做了视频。

https://grail.cs.washington.edu/projects/AudioToObama/siggraph17_obama.pdf

2018年,马克斯·普朗克计算机科学研究所进行了另一项研究计划,实现了身份 > 身份视频转换(identity>identity video transfer),还带来了口型同步; 2021年5月,人工智能初创公司 FlawlessAI 发布了其专有的对口型同步技术 TrueSync,该技术被媒体广泛认可为跨语言的主要电影的发行改进配音技术。

当然,deepfake开源资源库的持续发展也为面部图像合成这一领域提供了另一个活跃的用户贡献的研究分支。