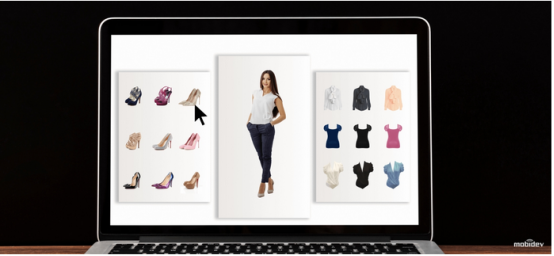

【51CTO.com快译】随着科技的进步与发展,虚拟试衣间正在进入人们的生活。那么如何为衣服、鞋子、配饰、手表、眼镜以及帽子提供虚拟试穿体验,就需要了解虚拟试衣间的工作原理。

为了让消费者获得在实体商店购物的体验,从事虚拟试验人工智能技术开发的数据科学开发商MobiDev公司开发出一种虚拟试衣间。以下对虚拟试衣间技术的工作原理进行阐述和分析。

虚拟试验室技术的工作原理

多年来,“先试后买”策略一直是服装店行之有效的客户互动方法。现在,这种策略能够以虚拟试衣间的形式存在。根据调研机构《财富商业洞察》预测,到2027年,全球虚拟试衣间市场规模有望达到100亿美元。

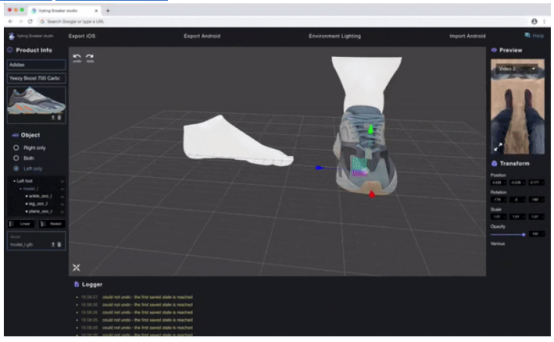

为了更好地理解虚拟试衣间技术的工作原理和技术逻辑,将以MobiDev公司近日开发的一个关于增强现实 (AR) 鞋类试衣间开发的项目为例。虚拟试衣间的工作方式如下:

- 将输入视频分割成帧,并用深度学习模型进行处理,该模型估计一组特定试衣者腿部和双脚关键点的位置。

- 根据检测到的关键点来放置鞋类的3D模型。

- 渲染3D鞋类模型,以便每个帧显示逼真的纹理和光线。

MobiDev公司在使用ARKit(苹果设备的增强现实框架)时,发现它存在渲染限制。从发布的视频中可以看出,其跟踪精度太低,无法用于鞋类定位。这种限制的原因可能是在忽略跟踪精度的同时保持推理速度,这对于实时工作的应用程序可能至关重要。

另一个问题是ARKit 算法对身体部位的识别效果不佳。由于该算法旨在识别试穿者整个身体,如果处理后的图像仅包含身体的一部分,它不会检测任何关键点。这正是鞋类试衣间所面临的情况,而算法应该只处理试衣者的腿部。

其结论是,虚拟试衣间应用程序可能需要附加功能以及标准AR库。因此,建议让数据科学家参与开发自定义姿势估计模型,该模型应该只检测帧中一只脚或双脚的关键点并实时操作。

虚拟试验室解决方案

虚拟试衣间技术可以提供配饰、手表、眼镜、帽子、衣服等产品的试穿功能。以下了解这些解决方案中是如何在幕后工作的。

(1)手表

AR-Watches应用程序就是试戴虚拟手表的一个很好的例子,它允许用户试戴各种手表。该解决方案基于ARTag技术,利用印在表带上的特定标记,将表带佩戴在用户的手腕上以代替手表,以便开始虚拟试戴手表。计算机视觉算法仅处理帧中可见的那些标记,并识别摄影头相对于它们的位置。之后,需要正确渲染手表3D图像,虚拟摄影头应放置在同一位置。

总的来说,该技术有其局限性。但是,如果它与业务用例相匹配,那么创建要使用的正确3D图像并不困难。

(2)鞋类

Wanna Kicks和SneakerKit应用程序很好地展示了AR和深度学习技术如何应用于鞋类。

从技术上来说,这种解决方案利用了基于深度学习的足部姿态估计模型。该技术可用于全身3D姿态估计模型的特殊情况,该模型直接或通过将检测到的2D关键点的位置推断为3D坐标,来估计3D维度中所选关键点的位置。

3D足部姿势估计

一旦检测到试穿者足部的3D关键点的位置,就可以用于创建足部的参数化3D模型,并根据参数化模型的几何特性对鞋类3D模型进行定位和缩放。

在检测到的足部参数化模型上定位鞋类的3D模型

与全身/面部姿态估计模型相比,足部姿态估计仍然存在一定的挑战。主要问题是缺乏模型训练所需的3D注释数据。

但是,避免这一问题的最佳方法是使用合成数据,该数据假设渲染具有关键点的逼真3D足部模型并使用该数据训练模型;或者使用摄影测量法,它假设从多个2D视图重建3D场景,以减少需要标记的数量。

这种解决方案在技术方面要复杂得多。为了使其解决方案推出市场,需要收集足够大的足部关键点数据集(使用合成数据、摄影测量或两者的组合),训练定制的姿态估计模型(即将结合足够高的准确性和推理速度),测试其在各种条件下的稳健性并创建足部模型。从技术上来说,这是一个中等复杂度的项目。

(3)眼镜

FittingBox公司和Ditto公司考虑将虚拟现实(AR)技术用于虚拟眼镜试戴。用户应该从虚拟目录中选择一款眼镜然后戴上。

虚拟眼镜试戴和镜片模拟

该解决方案基于深度学习的姿态估计方法,用于面部标志点检测,其中通用注释格式包括68个2D/3D面部标志点。这种注释格式允许以足够的准确度区分面部轮廓、鼻子、眼睛、眉毛和嘴唇。用于训练人脸标志估计模型的数据可能取自FaceAlignment等开源库,提供开箱即用的人脸姿势估计功能。

从技术的角度来看,这种解决方案并不复杂,尤其是如果使用任何预先训练的模型作为人脸识别任务的基础。但重要的是要考虑到低质量的摄像头和光线条件差可能是限制因素。

(4)医用口罩

在冠状病毒持续蔓延期间,ZapWorks公司推出了基于AR的教育应用程序,旨在指导用户如何正确佩戴医用口罩。从技术上来说,该应用程序也是基于3D 面部标志检测方法。与试戴眼镜应用程序一样,这种方法允许接收有关面部特征的信息和进一步的蒙版渲染。

(5)帽子

鉴于面部标志检测模型运行良好,另一个经常模拟的AR项目是帽子。正确渲染戴在头上的帽子所需的一切就是几个关键点的3D坐标,这些关键点指示太阳穴和前额中心的位置。而QUYTECH、Banuba和Vertebrae等公司已经推出了虚拟帽子试戴应用程序。

(6)服装

与鞋子、帽子、眼镜和手表相比,虚拟试穿3D衣服仍然是一个挑战。原因是服装由于质地柔软会变形。因此,为了获得正确的AR体验,深度学习模型不仅要识别人体关节上的基本关键点,还要识别3D身体形状。

以深度学习模型DensePose为例,它旨在将一个人体的RGB图像像素映射到人体图像的3D表面,研究发现它仍然不太适合增强现实。DensePose的推理速度不适合于实时应用程序,人体网格检测对三维服装项目的拟合精度不够。为了提高结果,需要收集更多的带注释的数据,这是一项耗费时间和资源的任务。

另一种方法是使用2D服装项目和2D人物轮廓。Zeekit公司就是这么做的,让用户可以将多种服装类型(连衣裙、裤子、衬衫等)应用到他们的照片中。

严格来说,2D服装图像传输的方法不能被视为增强现实,因为“现实”意味着实时操作,但它仍然可以提供不同寻常的沉浸式用户体验。其背后的技术包括生成对抗网络、人体姿势估计和人体解析模型。2D服装转换算法如下所示:

(1)识别图像中与身体各个部位相对应的区域。

(2)检测已识别身体部位的位置。

(3)产生转换衣服的扭曲图像。

(4)将扭曲图像应用于具有最少产生伪影的人物图像。

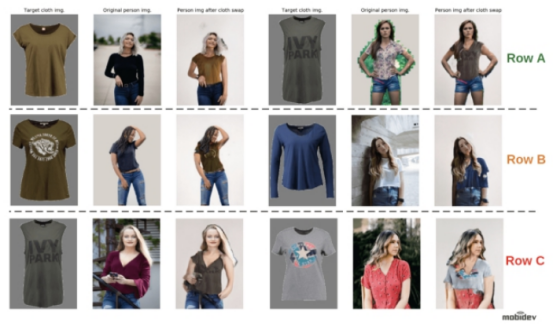

2D布料转移实验

由于虚拟更衣室并没有现成的预训练模型,因此使用ACGPN模型对该领域进行了研究。其想法是在实践中探索该模型的输出,通过利用各种方法进行2D布料转换。

该模型应用于约束条件下(训练数据集样本、VITON样本)和无约束(任何环境)条件下的人物图像。此外,不仅通过在自定义人物图像上运行模型,而且还使用与训练数据完全不同的自定义服装图像来测试模型能力的限制。

以下是在研究期间收到的结果示例:

(1)使用原始数据和预处理模型复制MobiDev公司研究论文中描述的结果:

衣服更换成功(A1-A3)和不成功更换(B1-B3)。

结果:

- B1——修补效果不佳。

- B2——衣服重叠。

- B3——边缘缺陷。

(2)定制服装在默认人物图片中的应用:

使用定制衣服更换衣服。

结果:

- A 行——无缺陷。

- B行——需要纠正的一些缺陷。

- C行——严重缺陷。

(3)将默认服装应用于自定义人物图像

具有无约束环境的图像上的服装更换输出。

- A行——边缘缺陷(轻微)。

- B行——掩饰错误(中等)。

- C行——修复和屏蔽错误(严重)。

(4)定制服装在定制人物形象中的应用:

用不受约束的环境和自定义服装图像替换衣服。

结果:

- A行——从模型中获得的最佳结果。

- B行—— 许多缺陷需要审核。

- C行——最扭曲的结果。

结论

在分析输出时,发现虚拟试衣仍然存在一定的局限性。关键是训练数据应该包含目标布料的配对图像,以及穿着服装的人物。如果给出一个真实世界的业务场景,完成它可能具有挑战性。而这个研究的其他要点是:

- ACGPN模型在来自训练数据集的人物图像上输出相当好的结果,如果应用定制服装项目也是如此的话。

- 当处理在不同光线、不同环境条件和不寻常姿势中拍摄的人的图像时,模型不稳定。

- 用于将虚拟2D服装图像传输到野外人物图像上的虚拟更衣室系统的技术尚未投入商业应用。但是如果条件是静态的,则其预期结果会好得多。

- 阻碍更好模型开发的主要限制因素是缺乏在室外条件下捕获人员的多样化数据集。

总而言之,当前的虚拟试衣间非常适合与身体各个部位有关的项目,例如头部、面部、足部和手臂。但是需要完全检测、估计和修改人体的试穿项目,虚拟试衣间技术仍处于起步阶段。然而,AR技术发展正在突飞猛进,最好的策略是进行调整并不断尝试。

原文标题:How Virtual Fitting Room Technology Works,作者:Maksym Tatariants

【51CTO译稿,合作站点转载请注明原文译者和出处为51CTO.com】