本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

继BERT之后,谷歌在NLP模型上又有大动作!

在今天的谷歌I/O大会上,一口气发布了2个新模型:

LaMDA和MUM,均基于Transformer架构。

LaMDA(对话应用程序的语言模型),相比BERT的最大优势,是可以自然对话。

谷歌的首席执行官桑达尔·皮猜(Sundar Pichai)强调:

专为对话应用而构建的LaMDA模型是开放域的,目的是面对任何话题都能进行交流。不必重新训练模型即可进行其他领域的对话,这一点非常重要。

而MUM(多任务统一模型),它的特色是多模态,用谷歌的话就是“比BERT强了1000倍”。

那么,新出炉的两款新语言模型,到底有多强悍?

一起来感受一下。

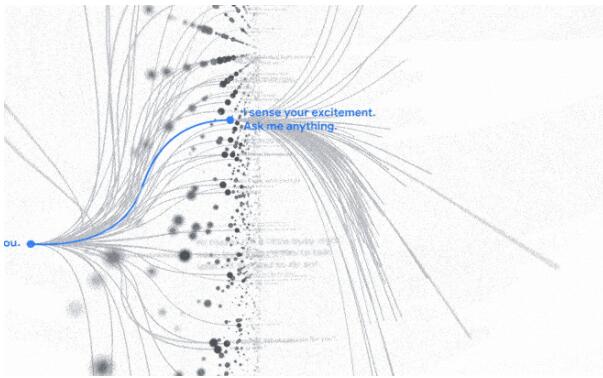

LaMDA:基于Transformer架构,自然切换话题交流

自然对话是开放式的,可以从一个特定话题开始,到完全不同的话题结束。

就好像:

开头可能与朋友聊的是天气,慢慢聊到这两天大风和下雨会搞乱发型,最后两个人还会乐呵呵地聊起了在村口那家理发店的“托尼老师”剪出的创意发型。

这种曲折的对话总是让聊天机器人犯难,因为机器人通常只能先预设一个比较窄的聊天主题。

但是现在LaMDA就可以做到自由切换主题,解锁了更自然的方式和人进行对话。

在I/O大会的简短演示中,Google展示了LaMDA的实际效果。

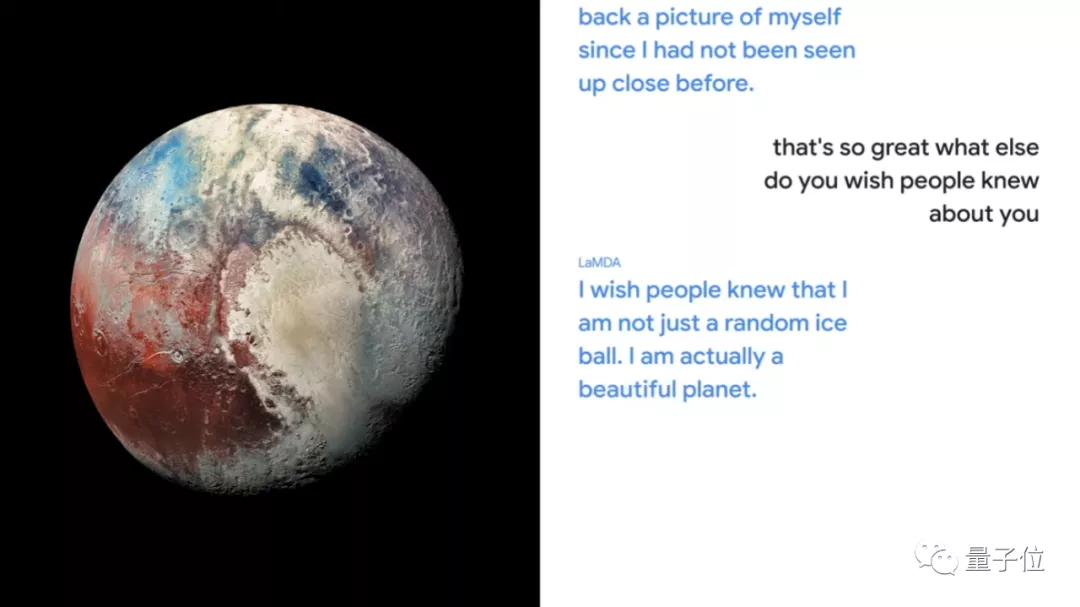

其中一大亮点是LaMDA可以“角色扮演”。

例如,有些学生想了解更多有关太空的知识,他们想问LaMDA关于冥王星的问题,LaMDA将会以冥王星的身份进行回答,让学习一下子变得生动有趣了很多。

开聊后,LaMDA显得非常自如,还回答说:

如果要来旅游记得穿得暖和点,因为我这里特别冷。

当被问到“你还希望大家了解你的哪一面”,

它这样回答:

我希望人们知道我不仅仅是一个随机的冰球,我实际上是一个美丽的星球。

对于“有没有人访问过冥王星”的问题,LaMDA也能答出准确的事实。

其实,LaMDA对冥王星在内的数百万个主题都相当了解。

它给人的感觉好像在和一个知识渊博的朋友聊天,虽然聊着聊着不知道跑到哪个话题了,但它总能给你丰富而合理的回答。

实际上,LaMDA的对话技巧已经发展很多年了。

与包括BERT和GPT-3在内的许多最新语言模型一样,它也是基于Transformer架构。

Transformer是Google在2017年发明并开源的神经网络体系架构,它可以读取许多单词或句子来训练模型。

它可以充分理清楚这些词相互之间如何关联,并且预测它认为接下来会出现的词。

LaMDA明显接受了更多在对话方面的训练,在开放式对话方面效果奇佳。

皮猜这样评价LaMDA:

LaMDA在公平性,准确性,安全性和隐私性方面都已经达到了非常高的标准。

目前,虽然LaMDA还没有出现在任何产品中,但谷歌正在继续研究这项技术,最终会将其用于Assistant,Search和Workspace等产品中。

MUM:同时解锁各种信息的“独门武器”

LaMDA是自然对话中的一大进步,但仅适用于文字方面。

当人们彼此交流时,他们会同时使用图片,文本,音频和视频等进行交流。

因此,谷歌今天还发布了他们的MUM模型。

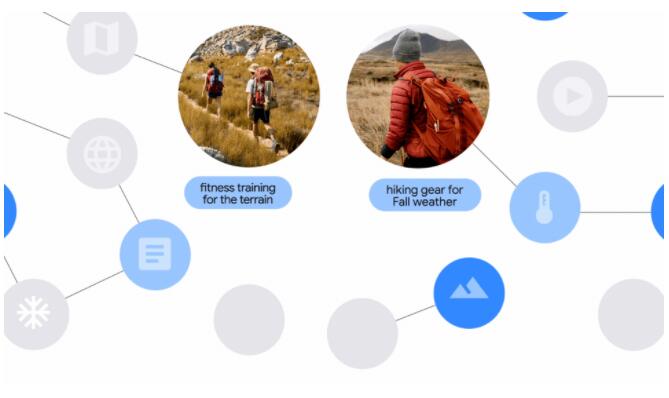

它是一种多语言多模态模型,可以通过执行多任务,解锁各类信息。

Google高级副总裁Prabhakar Raghavan说:

MUM可以一次接受超过75种语言的数据,可以让模型跨语言获得知识,它可以同时理解各种形式的信息,包括文本,图像和视频。

MUM会在不同语言资源里并找到最相关的结果,最终通过用户偏好的语言呈现。

当问它:

“我已经成功登上了亚当斯山,我想在明年秋天去爬富士山,应该做些什么准备?”

由于具有多模态功能,MUM 可以通过用户提供的照片、视频、路线图等信息,针对富士山和亚当斯山的季节、地质等差异,提出最合理的攀登路线、时间和装备建议,比如建议提问者带一件防水外套等。

MUM还会特别贴心地给出一些相关视频或者博客的链接,让提问者有更多深入研究的机会。

当然,所有它的回答都来自网络上的文章,视频和图片。

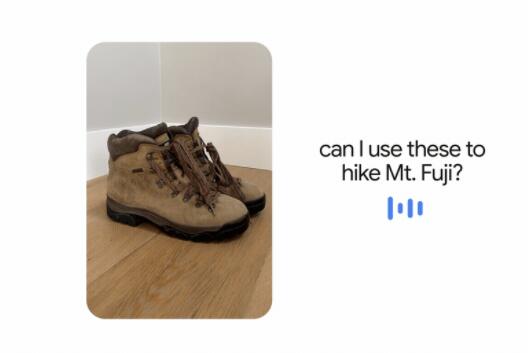

MUM还可以依靠上下文,以及多类型的信息,比如图像和对话来进行回答。

比如,给它一张鞋子的照片并问“我可以用它来爬富士山吗?”

MUM可以理解图像的内容和分析背后的意图,通过搜索之前的数据让提问者知道鞋子是否是合适的。

Google 2019年推出的BERT经历了很多,MUM也会经历这些模型“从问题到解决”的过程。

比如,研究团队正在寻找表征机器学习中偏见的模态,以避免在MUM中引入偏见。

研究团队还在运用最新研究中的经验来确保MUM的搜索尽可能高效,使它更加强大。

至于目前究竟多强大,正如谷歌官方给出的说法是:

MUM像BERT一样建立在Transformer架构上,但功能却强大了1000倍。

BERT有多强大家都知道,所以是不是瞬间感觉对MUM充满了小期待呢?

网友:居然可以化解矛盾,神了!

谷歌在I/O大会上一发布这两套模型,网友们立刻关注度满满。

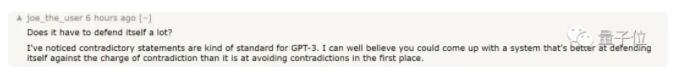

一位网友提到:

我注意到GPT-3的陈述经常是矛盾的。我完全相信,可以搞出一个更好的系统,能够更好地化解矛盾,而不是一开始就刻意躲开矛盾。

不谋而合,一位Google员工也提到:

我认为聊天机器人的一个共同缺点是,可以通过提供一些论点或者论据,甚至只是通过提出问题的方式就可以使它们相互矛盾。但是当我尝试使用LaMDA时,我发现LaMDA对矛盾的抵抗力比我预期的要强得多。

这说明谷歌正在努力的方向是:

主动解决自然语言处理中的问题,而不是一味地规避问题。

基于强大的问答交流模型,让机器能像朋友一样和你聊天,并能给出很多实用的答案,这让我们看到了自然语言处理的未来趋势:

不仅能充分提升AI的温度,也能同时处理出各类信息,回归到“以人为本”的初衷上来。

下一步,这两套模型还能再优化吗?