本文转载自微信公众号「菜J学Python」,作者游世九黎。转载本文请联系菜J学Python公众号。

大家好,我是J哥,本文来自我的好友游世久黎的投稿。

相信很多设计小伙伴有好的灵感,但是没有好的设计素材,今天它来了。摄图网4000张设计素材,取之不尽,如下图所示:

好了,废话不多说,开始用Python采集。

01需求分析

采集摄图网的素材图片,目标网址-->请求数据-->解析数据-->提取数据-->保存数据。

02技术栈

首先我们用到的技术包括:urllib,requests,bs4等。

03采集流程

1、分析网页结构

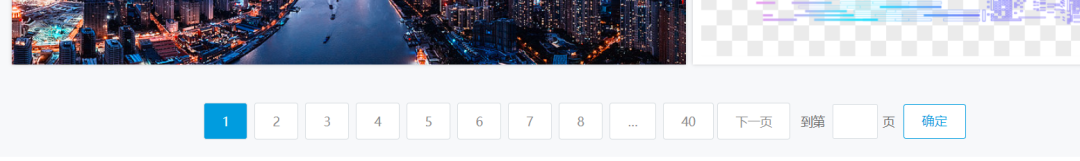

打开网址:https://699pic.com/paihang/tupian.html,分析网页结构,我们可以看到首页图片数据杂论,这里我们爬取的是"今日热门"的图片,点击发现更多:来到目标页面,拖动滚轮滑到底部,发现有40个分页,也就是我们今天要爬取的4000张设计图片:

2、发起请求

接着对列表中的每一条url进行遍历,然后发起请求:

- for url in urllist:

- resp = requests.get(url,headers=hd)

- html = resp.content.decode('utf-8')

3、数据解析

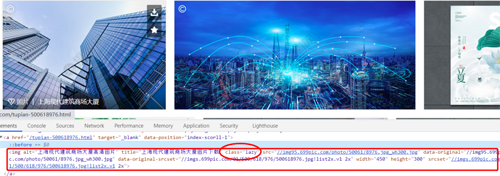

得到了一个html对象,爬取页面数据信息后,需要对页面进行解析,这里我使用到的解析库是bs4(偏爱),当然xpath也是可以的。通过分析页面元素,我们发现每个翻页里面的图片都有这样的规律:

因此可以通过bs4的select方法抓取所有class='lazy'的img标签,得到一个列表,然后通过测试发现图片的链接存放在img标签的data-original属性里,通过img.attrs['data-original']得到,再与'https:'进行字符串拼接,得到完整图片链接。

- for img in imgs:

- img_url = img.attrs['data-original']

- total_url = base_http_str + img_url

- print(total_url)

- # print('--'*60)

- imgurllist.append(total_url)

4.提取保存数据

最后运用urllib中的urlretrive方法,把图片保存到本地。

- def writeData(imgurllist):

- for index,url in enumerate(imgurllist):

- urllib.request.urlretrieve(url,'image/'+ '%s.png'%index)

- print('第%s张图片下载完成'%index)

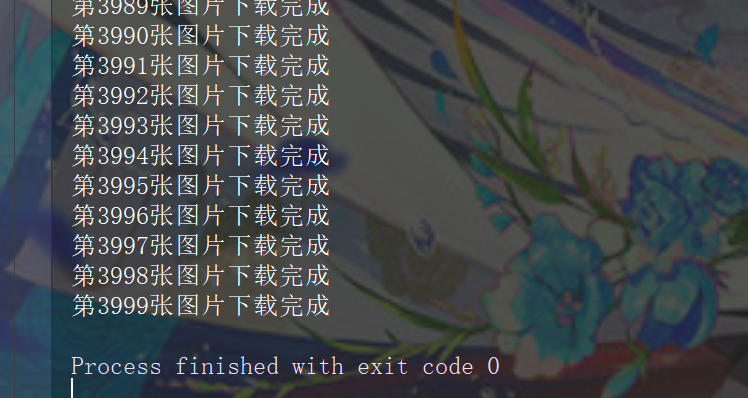

04运行爬虫

运行爬虫代码,效果如下:

图片就下载完成了,不过运用传统方法有点慢,下次试试多线程,提升爬虫效率。