近十年来,数据科学和机器学习领域取得了巨大的进展。借助深度学习方法,许多高维学习任务(例如计算机视觉、蛋白质折叠)在适当的计算规模下也能够完成。虽然在高维空间中,学习通用函数是一个非常困难的问题,但大多数任务上方法不是通用的,并且物理世界的基础低维和结构存在一些必要的预定义规律。

图神经网络和几何深度学习近期的一系列进展,有希望帮助机器学习解决更加深入复杂的问题。

几何深度学习,是从对称性和不变性的角度对广义机器学习问题进行几何统一的尝试。这些原理不仅是卷积神经网络的突破性性能和图神经网络的近期成功的基础,而且还为构建新型的、面向特定问题的归纳偏差提供了一种有原则的方法。

近日,一本名为《几何深度学习》的新书通过可在各种应用程序中应用的几何统一原理来揭示其中的规律性。这种「几何统一」具有两方面的意义:一方面,它提供了一个通用的数学框架来研究一些神经网络架构,例如 CNN,RNN,GNN 和 Transformer。另一方面,它提供了一个建设性的程序,可以将先验物理知识整合到神经架构中,并提供原则性的方法来构建一些新的架构。

教你如何组建机器学习架构

《几何深度学习》(Geometric Deep Learning, Grids, Groups, Graphs, Geodesics, and Gauges)是深度学习几何统一项目的第一版在线书,作者们表示该书自 2020 年 2 月起开始写起,目前版本的页数已超过了 150 页。

该研究的四位作者 Michael M. Bronstein、Joan Bruna、Taco Cohen、Petar Veličković来自帝国理工、纽约大学、DeepMind 等研究机构。

链接:

https://geometricdeeplearning.com/

arXiv 论文:

https://arxiv.org/abs/2104.13478

在这本书中,研究者从对称性,不变性和群论的角度出发,试图提炼出「构建所有常用神经架构所需的知识」。涵盖了诸如 CNN、GNN、Transformer 和 LSTM 之类的常用模型,同时还包括球面卷积神经网络(Spherical CNN)、SO(3)-Transformer 和 Gauge Equivariant Mesh CNN 等新模型。

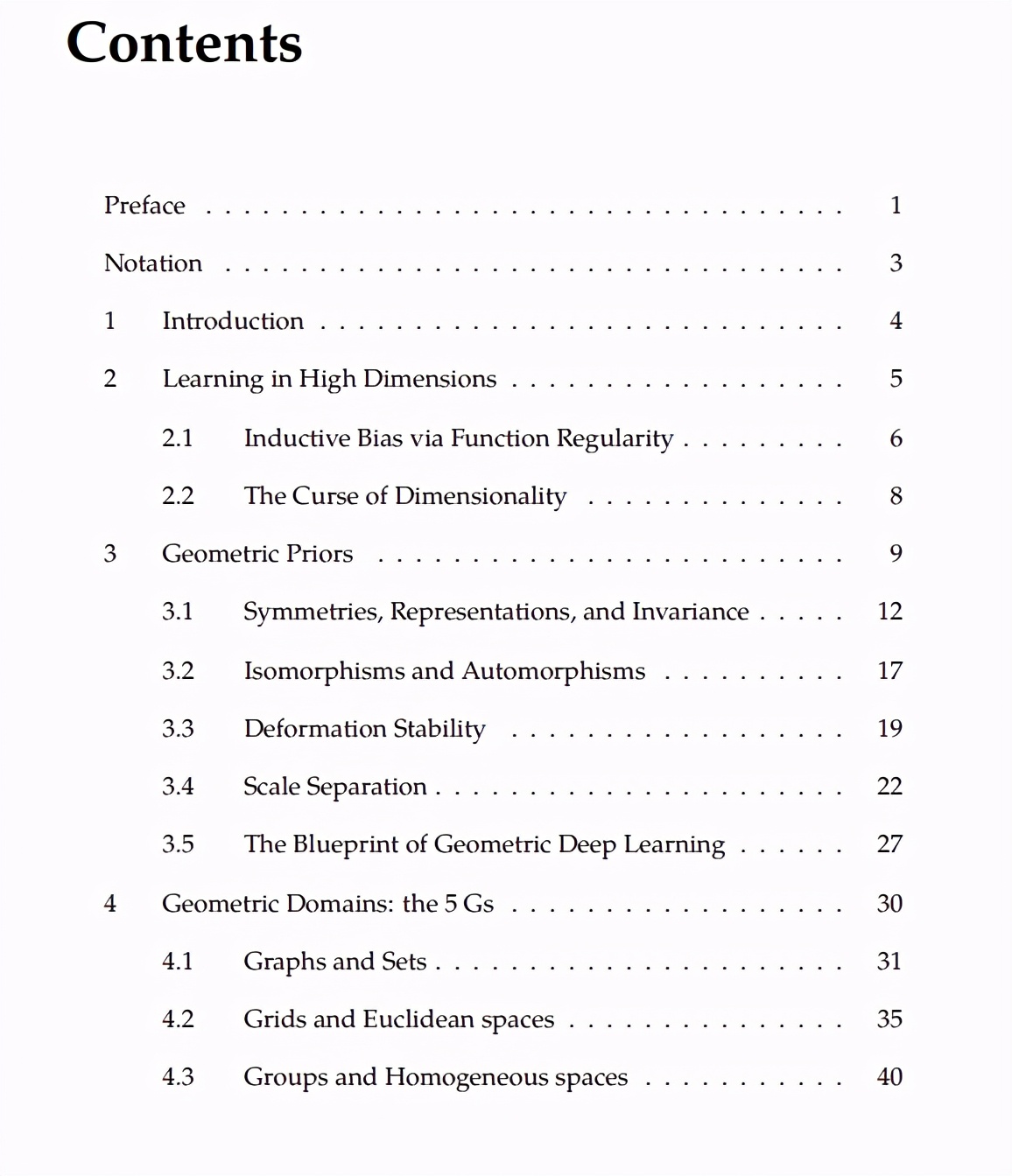

全书包括内容简介、高位空间中的学习、几何先验知识、几何域、几何深度学习模型、存在的问题与应用、历史观点共 7 章内容。以下是该书目录:

预备知识

该书作者之一,DeepMind 资深研究科学家 Petar Veličković表示:「如果你此前尚未接触过群论知识,则我们构建的一些概念看起来会有些不太真实。

为此,你可以事先观看一些作者之间视频分享的内容作为前置,也许这可以使某些无法以文字准确描述的内容变得更加「生动」。

Petar Veličković在剑桥大学的分享——图神经网络的理论基础:

https://www.youtube.com/watch?v=uF53xsT7mjc

Michael Bronstein 在 ICLR 2021 上的 Keynote:

https://iclr-conf.medium.com/announcing-the-iclr-2021-invited-speakers-db4aba84038a

此外,书中内容包括如下一些概念:

域:定义数据的所有「点」的集合。例如,对于图像来说,域是所有像素的集合;对于图来说,域是所有节点和边的集合。注意,该集合可能是无限的或者连续的,但是将其想象为有限的可能会让一些数学运算变得容易。

对称群:集合Ω到Ω自身双射的集合(g: Ω → Ω)。例如,通过将图像上每个像素向右移动一个 slot,并不会改变图像上的对象。

由于要求对象在进行对称变换时保持不变,因此引入了如下属性:

对称操作必须是可组合的。例如,如果将球体绕 x 轴旋转 30 度,然后绕 y 轴旋转 60 度,并假设每次旋转不会改变球体上的对象,那么连续使用多次变换,那么球体上的对象也没有发生改变,即绕 x 轴旋转 30 度,然后绕 y 轴旋转 60 度也是一种对称操作。通常,如果 g 和 h 是对称操作,那么 g o h 也是对称操作。

对称操作必须是可逆的——如果我没有更改底层对象,那么我必须能够返回自己的来源(否则意味着丢失信息)。因此如果将球体顺时针旋转 30 度,那么是可以通过逆时针旋转 30 度来「撤消」原动作的。如果 g 是对称的,则 g ^-1 必须存在(并且也是对称的),这就使得 g o g ^-1 = id (恒等)。

保持域不变的恒等函数(id)也必须是对称的。

所有这些属性相加,你就会发现所有对称集与组合运算符(o)一起组成了一个 group,这是在书中广泛使用的数学结构。

在机器学习社区中,对称性的重要性早已被人们认可,尤其是在模式识别和计算机视觉应用中,有关等变特征检测的早期工作可以追溯到 Shun’ichi Amari 和 Reiner Lenz 在上个世纪的研究。在神经网络的领域中,Marvin Minsky 和 Seymour Papert 提出的感知器的群不变性定理对(单层)感知器学习不变性的能力进行了基本界定。这是其后多层架构研究的起点,最终引向了深度学习。