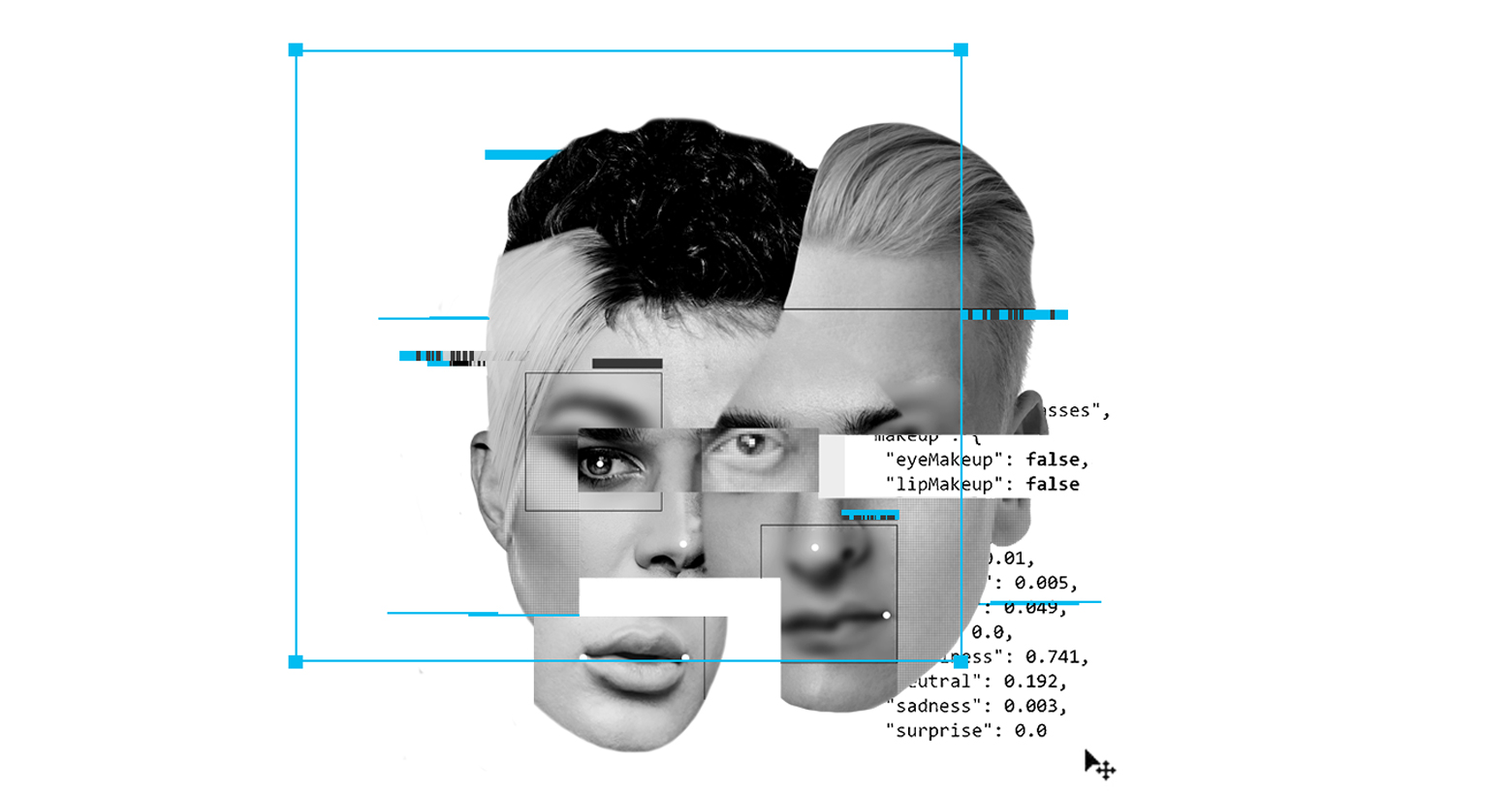

情感识别技术(Emotion Recognition Technology)实际上是一种新兴的技术,使用人工智能从面部表情中检测情绪,也是数十亿美元的产业。然而该技术背后的科学支撑颇有争议,系统中存在“偏见”。

从食品到游戏行业的各种公司使用ERT测试用户对它们产品的反应。当然可用在其他场景,比如在职场、机场安防或边防识别人员情绪,以便维持秩序,还可监督学生做家庭作业等。想想也是不错的。

但是,人脸识别技术正在受到公众的关注,因为它涉及到隐私及歧视问题。最近在奈飞上映的获奖电影《Coded Bias》记录了一个发现,许多人脸识别技术不能准确检测深色皮肤的人脸。管理ImageNet(一个用于视觉对象识别软件研究的大型可视化数据库)的团队最近也不得不模糊了150万张图片,为了回应隐私问题。

曾披露,人脸识别技术中有“算法偏见”和歧视性数据库,导致包括微软、亚马逊和IBM在内的大型科技公司停止销售该类技术。该技术在英国警务中的应用也面临法律指控。在欧盟,由40多个民间社会组织组成的联盟呼吁禁止使用人脸识别技术。

像其他形式的人脸识别一样,ERT也出现了关于偏见、隐私和大规模监管的问题。但ERT还出现了另一个问题,支撑它的情感科学是有争议的。大多数ERT系统是基于“基本情绪”理论的,该理论认为,情感是与生俱来的,世界各地的人都以同样的方式表达情感。

然而,该理论慢慢地有些站不住脚了。人类学研究表明文化和社会不同,人们情绪的表达方式不同。2019年心理科学协会(Association for Psychological Science)对“基本情绪”理论的证据进行了审查,结论是人们所普遍认为的一个人的情绪可以很容易地从他们的面部表情中推断出来没有科学依据。简而言之,ERT没有坚实可靠的科学理论基础。

此外,ERT中含有种族歧视的代码。正在进行的研究中已经显示该系统认为不管这个人的表情如何,黑人的脸比白人的脸更显愤怒。

人工智能研究员黛博拉·拉吉(Deborah Raji)在接受麻省理工科技评论(MIT Technology Review)采访时说,“这项技术有两种情况‘伤害’到人们,一种是系统不起作用,识别有色人种的错误率高,使人们面临很大的风险;另一种情况是当它发挥作用时,即系统已经很成熟了,便很容易作为某种工具骚扰人们的生活。”

所以即使人脸识别技术可以去除偏见,也很准确,也未必公平公正。我们会看到很多不和谐,比如当人脸识别技术用在有歧视的警局和司法系统时,会发生什么;当它们在一个不和谐的世界中有效运行时,它们也有可能是危险的。

人脸识别技术所带来的挑战至今没有明确的答案。要解决ERT的问题,就必须从抽象的理论转向生活的实践。我们需要集体审视系统中有争议的情感科学理论,并分析潜在的种族歧视。我们还需要问自己,即使ERT可以准确地读取每个人的内心感受,我们是否想要在生活中被如此亲密的监控?这些都是需要大家深思熟虑的,投入精力和行动的问题。