也许你觉得人工智能离你还有点远,只存在于谷歌那巨大无比的数据中心机房,或者充满神秘感的麻省理工学院机器人实验室。其实,透过互联网和智能手机,人工智能已经开始渗入我们每天的日常生活。

假设你生活在笔者老家,福建美丽的海滨城市厦门。早晨起来,当你打开手机里的“今日头条”APP,看看今天有什么新闻时,“今日头条”的人工智能推荐系统会根据你过去的阅读情况,给你推荐你特别喜欢的NBA篮球明星库里的赢球消息。上班路上,当你打开“百度地图”APP,用语音直接说出了目的地“厦门大学”时,“百度地图”会自动识别你略带福建口音的普通话,并为你导航了一条不那么堵车的线路。到了公司,当你打开邮件系统时,基于人工智能的反垃圾邮件算法已经为你屏蔽了几十条垃圾邮件,默默地帮助你提高工作效率。你还可以利用“科大讯飞”的人工智能语音输入软件口述完成一篇重要文件,并采用“谷歌翻译”将文件翻译成英文和西班牙文,然后发给你国外的客户。中午吃完午餐,你和同事到附近的公园散步,看到草坪上有一棵树开着红花,非常美丽,你想知道这种花叫什么,于是你打开手机中的“形色”APP,拍照上传,很快,人工智能图像识别算法识别出这种花学名叫红花羊蹄甲,又称紫荆花,花语象征着兄弟情谊……

在这些给我们带来方便和快乐的人工智能算法背后,最核心的就是目前人工智能领域最火热的深度学习技术。第2章讲述了人工智能在象棋和围棋领域超越人类世界冠军的故事,Alpha Go围棋软件特别强大的原因,是它的策略网络和估值网络,而这两个子系统的产生,靠的也是深度学习。

也许你会问,什么是深度学习?简单地说,机器学习是人工智能中很重要的一个学科,而深度学习是机器学习的一个分支。机器学习实现的是让计算机透过大量的数据或以往的经验来学习,不断优化计算机程序的性能,实现分类或预测等功能。深度学习可以让拥有多个处理层的神经网络计算模型来学习具有多层次抽象数据的表示,简单地说,深度学习能够发现大数据中的复杂结构。这些概念虽然听起来有点复杂,但是在本书的后续部分会作进一步的解释。

近几年来,深度学习在图像识别、语音识别、自然语言处理、机器人、医学自动诊断、搜索引擎等方面都取得了非常惊人的成果,并且通过手机和互联网开始全面影响人类的工作和生活。在本章中,让我们来一起重温深度学习的历史,并且探讨人工智能和深度学习的各种应用。

早期的人工神经网络

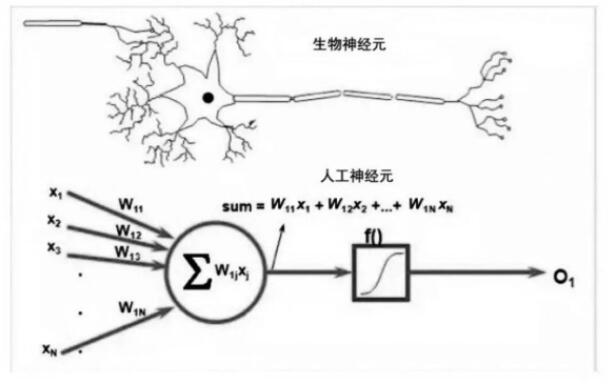

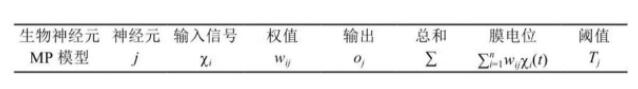

深度学习的概念源于人工神经网络的研究,早期的神经网络模型试图模仿人类神经系统和大脑的学习机理。1943年,神经生理学家沃伦·麦卡洛克(Warren Mc Culloch)和逻辑学家沃尔特·皮茨(Walter Pitts)联合发表了重要论文《神经活动中内在思想的逻辑演算》(A logical calculus of the ideas immanent in nervous activity)。在论文中,他们模拟人类神经元细胞结构提出了麦卡洛克-皮茨神经元模型(McCulloch-Pitts Neuron Model,简称MP模型,见图3.1),首次将神经元的概念引入计算领域,提出了第一个人工神经元模型,从此开启了神经网络的大门,表3.1是生物神经元与MP模型。

图3.1 MP模型

表3.1 生物神经元与MP模型

MP模型大致模拟了人类神经元的工作原理,就是将一些输入信号进行一些变换后得到输出结果。在图3.1中,图的下部是一个人工神经元,有N个输入信号x1,x2,…,xN(对应于人类神经元的N个树突,每个树突与其他神经元连接得到信号),每个信号对应于一个权重(对应于每个树突连接的重要性),即W11,W12,…,W1N,计算这N个输入的加权和,然后经过一个阈值函数得到“0”或者“1”的输出。输出的结果,在人类神经元中,“0”和“1”可以代表神经元的“压抑”和“激活”状态,在人工神经元中,“0”和“1”可以代表逻辑上的“No”和“Yes”。

1958年,心理学家弗兰克·罗森布拉特(Flank Rosenblatt)教授提出了感知机模型(Perceptron),感知机是基于MP模型的单层神经网络,是首个可以根据样例数据来学习权重特征的模型。对于线性可分为两类的数据,按照感知机的误差修正算法,可以根据样例数据经过多次迭代运算,最终实现运算收敛,确定每个输入x对应的权重W。我们把迭代运算的过程称为“神经网络的训练”,最终训练好的神经网络可以对新的数据作分类预测。这就是最简单的“机器学习”的过程。

受感知机模型的启发,20世纪60年代,有不少数学家、物理学家和计算机工程师投身于神经网络的研究。1969年时,著名的人工智能专家明斯基教授和西蒙·派珀特(Seymour Papert)教授出版了《感知机:计算几何学导论》一书(Perceptrons∶An Introduction to Computational Geometry),书中证明了感知机模型只能解决线性可分问题,明确指出了感知机无法解决异或问题等非线性可分问题。同时,书中也指出在当时的计算能力之下,实现多层的神经网络几乎是不可能的事情。明斯基教授和派珀特教授对感知机研究的悲观预测,导致了神经网络研究的第一次低潮,此书出版后的十多年,基于神经网络的研究几乎处于停滞状态。

一代宗师杰弗里·辛顿

1986年,深度学习的一代宗师杰弗里·辛顿(Geoffrey Hinton)教授开始崭露头角,这一年,辛顿教授、大卫·鲁梅哈特(David Rumelhart)教授和罗纳德·威廉姆斯(Ronald Willliams)教授在《自然》杂志上发表了重要论文《通过反向传播算法实现表征学习》(Learning Representations by Back-propagating Errors),文章中提出的反向传播算法大幅度降低了训练神经网络所需要的时间。直到30年后的今天,反向传播算法仍然是训练神经网络的基本方法。同时,辛顿教授倡导的深层神经网络,也可以很好地解决异或问题和其他的线性不可分问题。

辛顿教授(见图3.2),1947年出生在英国。他出生于一个非常传奇的家族,他爷爷的外公就是伟大的数学家乔治·布尔(George Boole),布尔代数的奠基人。乔治·布尔的太太叫玛丽·埃佛勒斯(Mary Everest),是一位作家,著有《代数的哲学和乐趣》。玛丽·埃佛勒斯的叔叔是乔治·埃佛勒斯(George Everest),英国著名的测绘学家和探险家,曾经担任当时的英国殖民地印度的测量局局长,领导了喜马拉雅山脉的测量工作。后来英国人以他的姓氏命名了世界最高峰——珠穆朗玛峰,英文名为Mount Everest。辛顿教授全名Geoffrey Everest Hinton,当年他家人给他命名Everest时,也许已经对他未来勇攀科学高峰许下了祝福。顺便帮文艺青年“八卦”一下,乔治·布尔的小女儿伏尼契(Ethel Lilian Voynich),就是中国读者特别喜欢的一本小说《牛虻》的作者,她本人的生活和爱情也极其精彩,传说她与超级间谍西德尼·雷里(Sidney Reilly,电影《007》中詹姆斯·邦德(James Bond)的原型人物)还有过一段浪漫的爱情,在这里就不再赘述了。

图3.2 一代宗师辛顿教授

辛顿教授的父亲霍华德·埃佛勒斯·辛顿(Howard Everest Hinton)是昆虫学家,曾祖父查尔斯·霍华德·辛顿(Charles Howard Hinton)是一个知名的数学家和最早期的科普作家和科幻小说家。从高中时代开始,辛顿就对人类大脑和神经网络的奥秘深深着迷。1970年,辛顿毕业于剑桥大学,本科拿的是实验心理学的学士学位。1978年获得爱丁堡大学的人工智能博士学位,曾经在卡内基梅隆大学计算机系工作过5年。后来,他移居加拿大,成为多伦多大学的一位著名教授。

在辛顿教授科研生涯的前20多年里,虽然取得了不少成果,但是因为计算机的计算速度还不够快,深层神经网络的优化较为困难,所以基于深层神经网络的深度学习并未在学术界取得足够的重视,发表文章和获取科研经费也都比较困难。辛顿教授非常坚定地默默坚持自己的研究工作,同时培养了不少优秀的学生和合作者,包括后来深度学习领域大名鼎鼎的延恩·乐存(Yann LeCun)和约书亚·本吉奥(Yoshua Bengio)。

2004年,依靠来自加拿大高级研究所的资金支持,辛顿教授创立了“神经计算和自适应感知”项目,简称NCAP项目。NCAP项目的目的是创建一个世界一流的团队,致力于生物智能的模拟,也就是模拟出大脑运用视觉、听觉和书面语言的线索来做出理解并对它的环境做出反应这一过程。辛顿教授精心挑选了研究人员,邀请了来自计算机科学、生物、电子工程、神经科学、物理学和心理学等领域的专家参与NCAP项目。后来的事实证明,辛顿教授建立这样的跨学科合作项目对人工智能的研究是一个伟大的创举,定期参加NCAP项目研讨会的许多研究人员,比如延恩·乐存、约书亚·本吉奥和吴恩达(Andrew Ng),如图3.3所示,后来也都取得了非常突出的成果。最核心的是这一团队系统地打造了一批更高效的深度学习算法,最终,他们的杰出成果推动了深度学习成为人工智能领域的主流方向。2012年,辛顿教授获得有“加拿大诺贝尔奖”之称的基廉奖(Killam Prizes),这是加拿大的国家最高科学奖。

图3.3 左至右为乐存、辛顿、本吉奥和吴恩达

2013年,谷歌公司收购了辛顿教授创立的DNN Research公司,实际上,这家公司没什么产品和客户,只有3个深度学习领域的牛人,辛顿教授和他的两个学生,分别是曾经赢得2012年的Image Net大赛的埃里克斯·克里泽夫斯基(Alex Krizhevsky)和以利亚·苏斯科夫(Ilya Sutskever)。有人调侃Google花了几千万美元买了几篇论文,笔者认为,谷歌这种大手笔引进世界最顶尖人才的方式,正好体现了谷歌两位老板拉里·佩奇(Lawrence Edward Page)和谢尔盖·布林(Sergey Brin)面向未来的雄才大略,非常值得中国的企业家学习。2014年,谷歌花4亿美元收购Deep Mind公司时,Deep Mind公司也就是刚刚在《自然》杂志发表了一篇利用强化学习算法玩计算机游戏论文的小公司,很多人都不理解为什么这家公司值这么多钱。后来Deep Mind研发了震惊世界的Alpha Go之后,人们才开始相信佩奇和布林的远见。