本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

现在,Adobe不想让你用手P图了——动动口就行。

只需要你说一句话,计算机就能P出你想要的效果。

例如,说出想要的发型,马斯克就会立刻被剃头:“Hi-top Fade(扫把头),变!”

肤色、妆容也都能轻松改变,一句“face with/without makeup”就能上妆/卸妆:

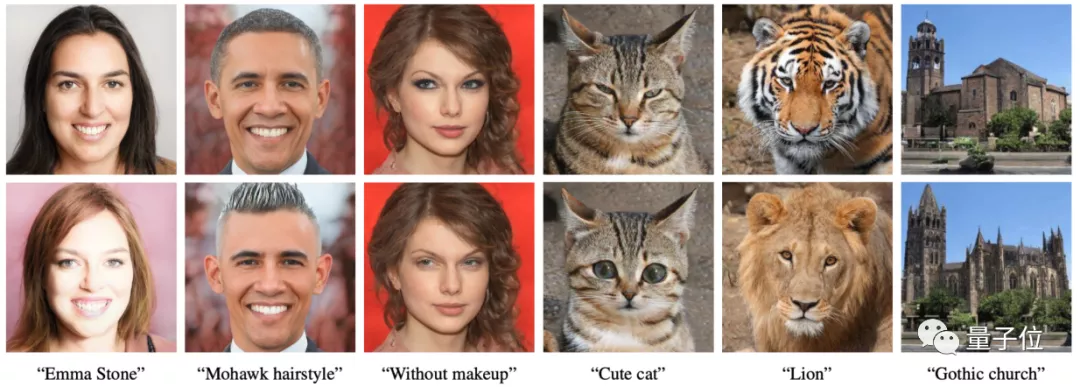

△给霉霉上妆/卸妆

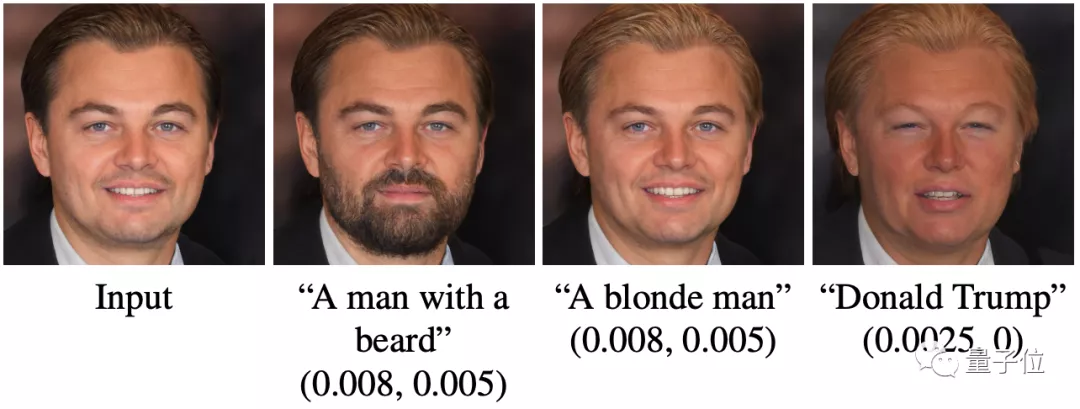

甚至还能直接改变人样,给小李子变出胡子、金发后,变成特朗普!

除了人,动物、景物也能P。

输入“cute cat”,就能让图中的猫变成“大眼萌猫”:

说一句“classic car”,它就能把你的车P成经典古老的车型,还能手动调复古程度:

简直是手残P图玩家的福音。

没错,这是来自Adobe、希伯来大学、特拉维夫大学的新操作,只需要一句话,就能让计算机“修”出你想要的图片。

现在,项目已经开源。

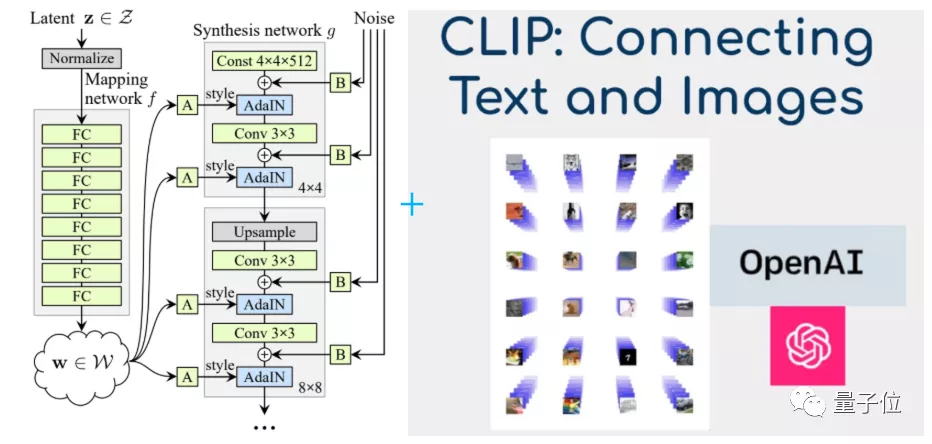

当GAN遇上CLIP

这一神奇的操作,来自一种新算法:StyleCLIP。

没错,就是将目前最先进的GAN——StyleGAN,和OpenAI搞出来的CLIP模型结合到一起。

为何选择这两个模型?

其中,CLIP不能自己生成图像,但具有很好的图像分类效果。

它不仅可以理解输入的词语,还能将语义和图像特征联系起来。

也就是说,CLIP有着和人脑极为相似的工作方式,不仅能将CV和NLP从技术上打通,还给他们分配了专门的处理区域。

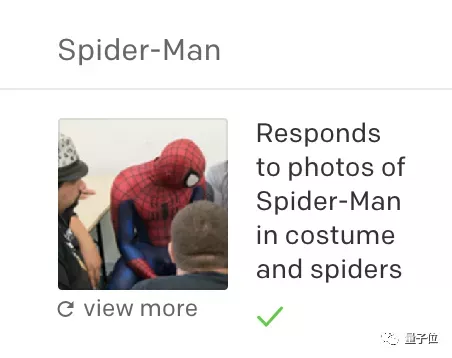

例如,一旦听到“蜘蛛侠”三个字、或是看到蜘蛛侠的照片,CLIP的某个特殊区域就开始响应,甚至原本用来响应红色和蓝色的区域也会“躁动”。

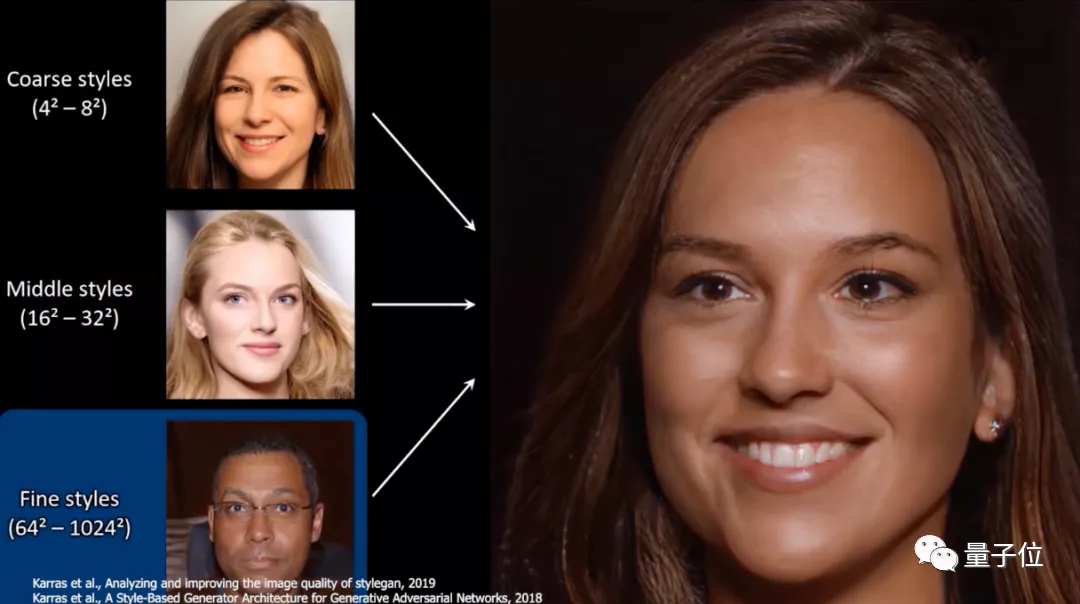

而StyleGAN,虽然能实现照片级模拟,生成非常逼真的图像:

但StyleGAN、StyleGAN2等一系列GAN模型,却没办法独立更改如面部外观、形状或表情等参数,只能像下面这样,从整体、中等、微调等大方向去改变形象:

如果将CLIP和StyleGAN合成新模型,只需要一句文本信息,它就能帮你P出既逼真、又能控制细节的图像来。

点点鼠标,就能调整效果

事实上,模型的效果也确实不错,功能非常全面。

还自带一个图形界面窗口:用一句话说出需求后,用鼠标就能进行调节。

例如,一键将英国首相鲍里斯·约翰逊(Alexander Boris de Pfeffel Johnson)变成女人:

还能让他愁眉不展、或是开口大笑:

不仅能记住一整个人的面部特征,并根据需要换脸、换头发、换妆;还能应用在动物身上,甚至将老虎变成狮子:

当然,将普通的房子变成哥特式(gothic)建筑也行。

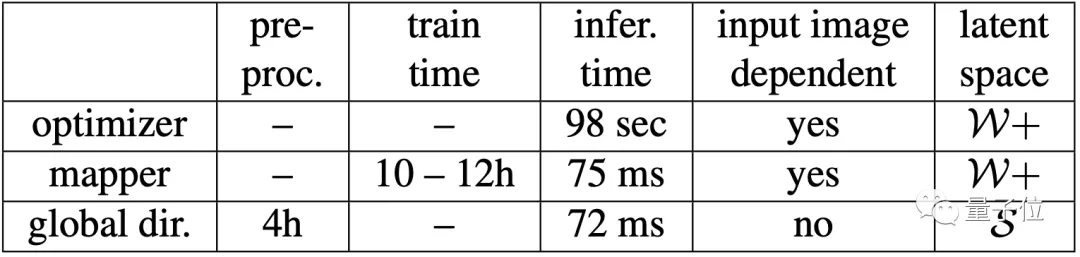

在单个NVIDIA GTX 1080Ti GPU上,进行全局预处理的时间是4个小时。预处理后,就能将不同的文本-图像对应用在上面了。

至于训练的时间,则需要跑10~12个小时,加上优化器后的推理时间是98秒。

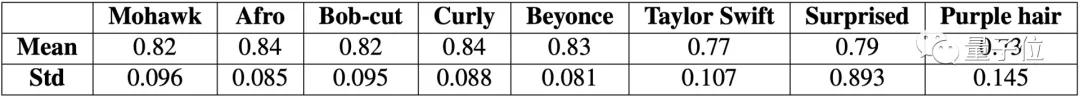

那么,模型的稳定性如何?

即使背景人物不同,在用一句话P图后,它们之间的相似度也能达到73%以上,最高能达到84%。

也就是说,模型改变特征的效果还是很稳定的。

当然,即使测试效果很好,网友们还是发现了一些图片生成的bug。

例如,网友发现,长着胡子的男性,看起来要比没有胡子的男性更生气?

有网友在测试后表示,个别效果如“加深男性肤色”(tanned man)确实不够好,需要进行数据清洗。

除此之外,也有网友建议作者尝试进一步研究,如模型中的偏见性。

例如,试试“成功的男人/女人”、“罪犯”等形容词,看看这个模型会生成什么。

作者介绍

一作Or Patashnik,来自特拉维夫大学(Tel-Aviv University),主要研究方向是计算机视觉。

共同一作吴宗泽(Zongze Wu),来自希伯来大学(Hebrew University of Jerusalem),主要研究方向是计算机视觉,包括GAN、图像处理、图像翻译等。

三作Eli Shechtman,来自Adobe,研究方向是计算机视觉,包括视频分析与合成、目标和动作识别、图形视觉、图像和视频检索等。

此外,来自特拉维夫大学的Daniel Cohen-Or、和希伯来大学的Dani Lischinski对这篇论文也有贡献。

说不定,Adobe真会将“动口P图”这一功能放进PS中呢。

项目地址:

https://github.com/orpatashnik/StyleCLIP

论文地址:

https://arxiv.org/abs/2103.17249