GPT-3开源了?Eleuther AI推出的名为GPT-Neo的开源项目:公开发布的GPT-3同等复现预训练模型(1.3B & 2.7B),可在Colab上完成微调。

……当然此 GPT-3非彼 GPT-3。

近日,Eleuther AI在GitHub上推出了一个名为GPT-Neo的开源项目:GPT-3同等复现预训练模型(1.3B & 2.7B),并可在Colab上完成微调。

虽然GPT-Neo与真正的GPT-3比,参数量仍然很小(较大版本也只与GPT-3最小模型的参数量),但开源又免费,仍然得到了「同性好友们」的认可!

项目目前在GitHub上已经得到了近3k的star。

Eleuther AI也表示,未来会进一步开源10B版本和原始大小版本的GPT3模型参数。

「莆田版」GPT-3

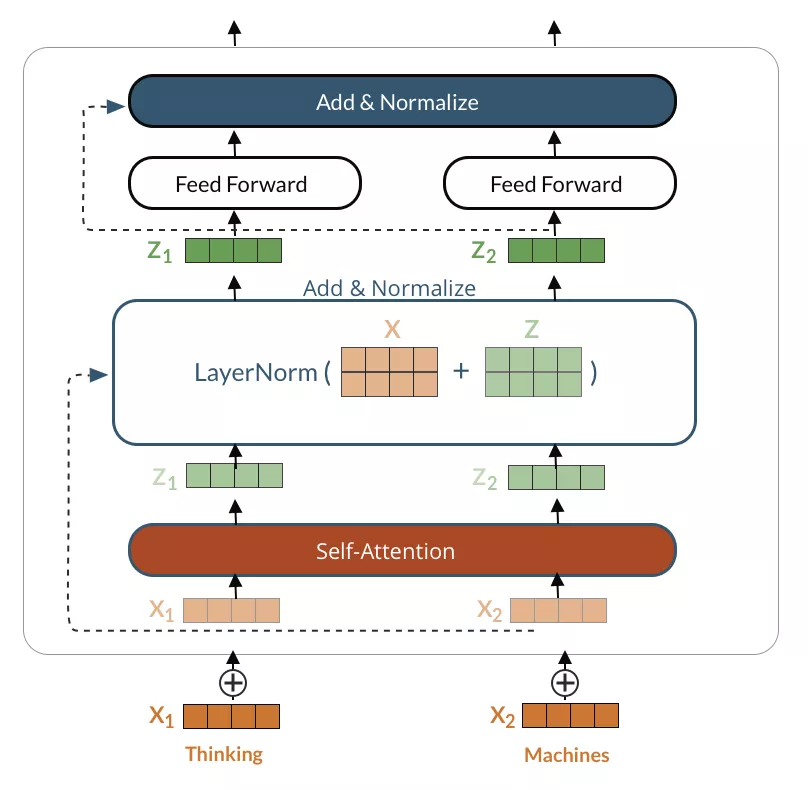

在Eleuther AI官网上,他们对GPT-Neo的描述是,「一系列基于变换器的语言模型的代码名称,这些模型的风格松散地围绕着GPT架构,我们计划对其进行训练和开源。我们的主要目标是复制一个GPT-3大小的模型,并将其免费开源给公众。」

在这一过程中,我们将对替代架构和注意力类型进行实验,发布任何中间模型,并在我们的博客上写出任何发现。

GPT-Neo模型是在Tensorflow-mesh中构建的,这将使他们能够使用同步的模型和数据并行来扩展到GPT-3和更大的规模。

据Eleuther AI称,他们已经建立了大部分的模型,训练了GPT-2大小的模型,并实施了几个实验性的架构。

目前的代码库应该能够扩展到GPT-3规模的模型。

而他们接下来的步骤,将是正在努力完成GPT-2规模的模型复制。

「到目前为止,2 们得到的单步训练的最大模型是200B参数。」

GPT3: 一般人玩不起

6月,OpenAI发表了一篇论文,详细介绍了GPT-3,这是一个机器学习模型,在一些自然语言基准上取得了强大的效果。在1750亿个参数——模型从历史训练数据中学习的部分——它是同类模型中最大的模型之一,也是最复杂的模型之一,能够进行原始类比,以某种风格写作,甚至完成基本代码。

与GPT-3的前身GPT-2和GPT-1相比,OpenAI选择不将模型或训练数据集开源,而是选择通过商业API提供前者。该公司选择将GPT-3独家授权给微软,进一步缩减了访问权限,而OpenAI与微软有业务关系。

微软已经向OpenAI投资了10亿美元,并建立了一台Azure托管的超级计算机,旨在进一步推动OpenAI的研究。

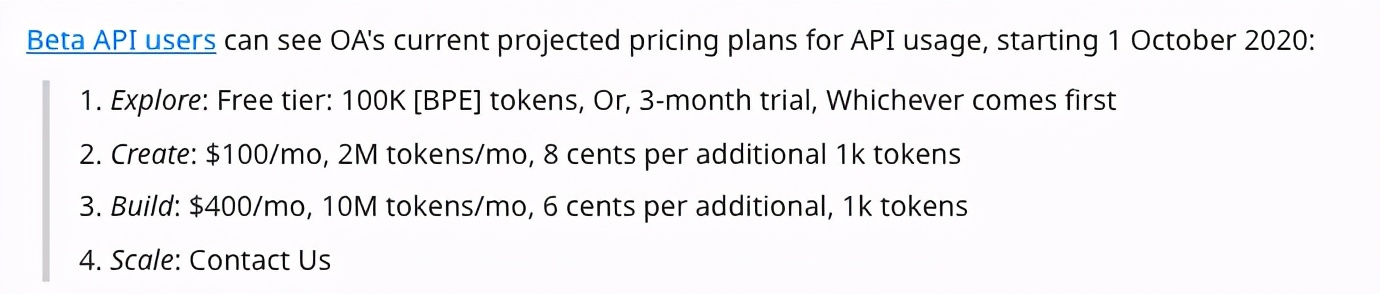

来看下OpenAI的定价策略。

自由探索Explore版 (我等):可以免费使用3个月,或者10万token,哪个先到按哪个算,占着不用可不行。

Create版(普通用户): 100美元一个月,200万token每月,超出的部分1k token按8美分计算;

Build版(VIP): 400美元一个月,1000万token每月,超出的部分1k token按6美分计算;

Scale版(尊享版):如果你是也就是生产级的大规模用户,联系官方就好,有专人服务。

这个200万token,能有多少字呢?大约相当于3000页的文本。

这样说可能还是不直接,举个例子,莎士比亚全集是大约有90万个单词,折算到token的话大概能有120万。

贫穷使人进(fu)步(ke)。

现在,一些人开始在开源中重新创建GPT-3,但可能目前最值得期待的就是GPT-Neo了。

关于Eleuther AI

Eleuther AI是一个由研究人员组成的草根集合,致力于开源人工智能研究。

Connor Leahy,Leo Gao和Sid Black三人联合创立,于去年11月宣布推出GPT-Neo的开源项目,该项目基于GPT系列的设计原理,旨在复现GPT系列的各种项目。

其中Sid是目前世界上最牛的TPU黑客之一。

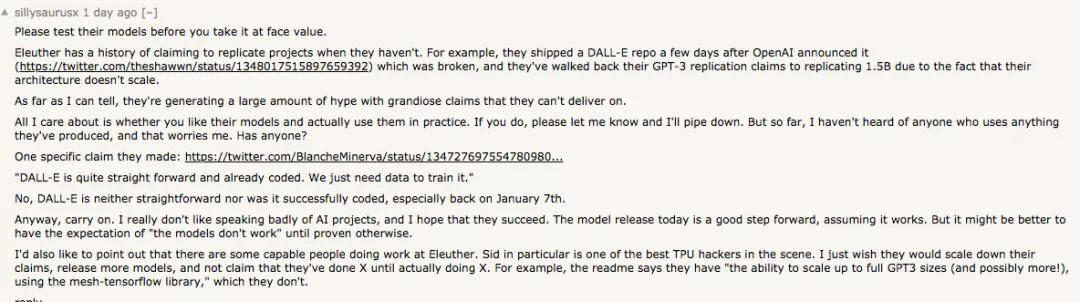

不过,也有人也认为这伙人炒作太多!

「据我所知,他们正在大肆宣传他们无法兑现的夸大其词。」

「例如,他们在OpenAI宣布几天后就运出了一个DALL-E repo,这是坏的,而且由于他们的架构不能扩展,他们已经把他们的GPT-3复制宣称走回了复制1.5B。」

项目地址:

https://github.com/EleutherAI/gpt-neo