这几年,AI的趋势只增不减,每年各大机器学习会议开得那叫一个如火如荼,大家仿佛都对这个领域永远充满了旺盛的探索欲。

不过最近,对于机器学习会议出版的各种论文出现了质疑的声音,并也获得了不小的关注:

近日,Reddit上,一位出身于传统工程领域的小哥发布了一则帖子,上面记录了他对近期机器学习出版论文的观察:

「 我注意到,有很多研究人员致力于诸如优化、控制、信号处理等“老”领域的交叉领域,他们会突然发表大量的声称要解决某个问题的论文。

而问题本身通常是最近产生的,有时会涉及到一些深度神经网络。

然而,经过仔细检查,这些论文唯一的新奇之处,是这个问题(通常是由其他不相关的团体提出的),而不是研究人员提出的旨在解决这个问题的方法。

我很困惑,为什么大量看似 「 很弱」的论文,居然可以被接受。

接着,这位小哥发现了这些论文能投中会议的秘诀:

1.只发机器学习会议

这些研究小组只会在机器学习会议上发表文章(而不会在优化和控制会议/期刊上发表文章,而这些可能是他们工作的核心)。

例如,在一篇关于对抗机器学习的论文中,整篇论文实际上是关于解决一个优化问题的,但优化的算法基本上只是在其他前人优秀方法的基础上稍微变化了一点而已。

此外,这位小哥还注意到,如果一篇论文没有通过NeurIPS或ICLR,它们将被直接发送到AAAI和其他一些小型会议,在那里它们将被接受。

所以,在这个领域里,并没有什么东西被浪费掉。

2.审稿人们不知道发生了什么

通过openreview,国外小哥发现审稿人(不仅仅是研究人员)对他们的特定领域一无所知,而似乎只会评论论文的正确性,而不是新颖性。

事实上,他怀疑审稿人自己是否知道这种方法的新颖性。

在这里所说的新颖性,是指某项技术的最新发展是多么新颖,尤其是当它与运筹学、优化、控制和信号处理相交叉时,而实际上,最先进的技术可能远远超乎了主流机器学习研究者的认知。

3.随意引用

通常情况下,研究人员只会引用他们自己或过去几年的“机器学习人”的文献。

偶尔,会有一条引用来自于几百年前的柯西、牛顿、傅里叶、古诺、图灵、冯·诺伊曼等人,接着,又回向后跳跃几百年到2018年或者2019年。

所以,他们可能想表达:“这个问题在1930年被一些「名人」研究过,然后在2018年又被「某个家伙」研究过很多次。”

4.数学公式的堆砌

通常,会有大量的数学公式,来证明一些关于特征值、梯度、雅可比矩阵的深奥条件,以及关于他们研究问题的一些其他奇怪的事情(在其他深奥的假设下)。

还会有几个定理,但是没有一个是适用的,因为在运行它们的高度非凸深度学习应用时,所有条件都被违反了。

因此,从这些复杂的定理+堆砌的数学公式中得到的唯一东西是「一些微弱的直觉」(然而马上就会被违背),接着什么也没说。

5.“被抛弃的技术”

这位国外小哥发现,某些技术在作者声称它击败了许多基准测试之后,似乎将会被抛弃,并永远不会再使用。

机器学习研究人员似乎喜欢频繁的跳过一些话题,所以这可能是其中一个愿意。

但是,通常情况下,在其他领域,一旦一项技术被提出,同一组研究人员就会用多年来改进它,有时甚至贯彻了研究人员的整个职业生涯。

这位小哥表示:

「在某些方面,这使得某些机器学习区域就像一个回音室,在那里,研究人员正做着一些几乎重复的事情,而这一点却被问题的新奇性所掩盖了。

这些论文被接受,因为没有人可以检测论文本身真正的新颖性(或者,三个审稿人中只有一个会注意到)。

我只是觉得机器学习会议好像被当成了「自动收纸的摇钱树」。

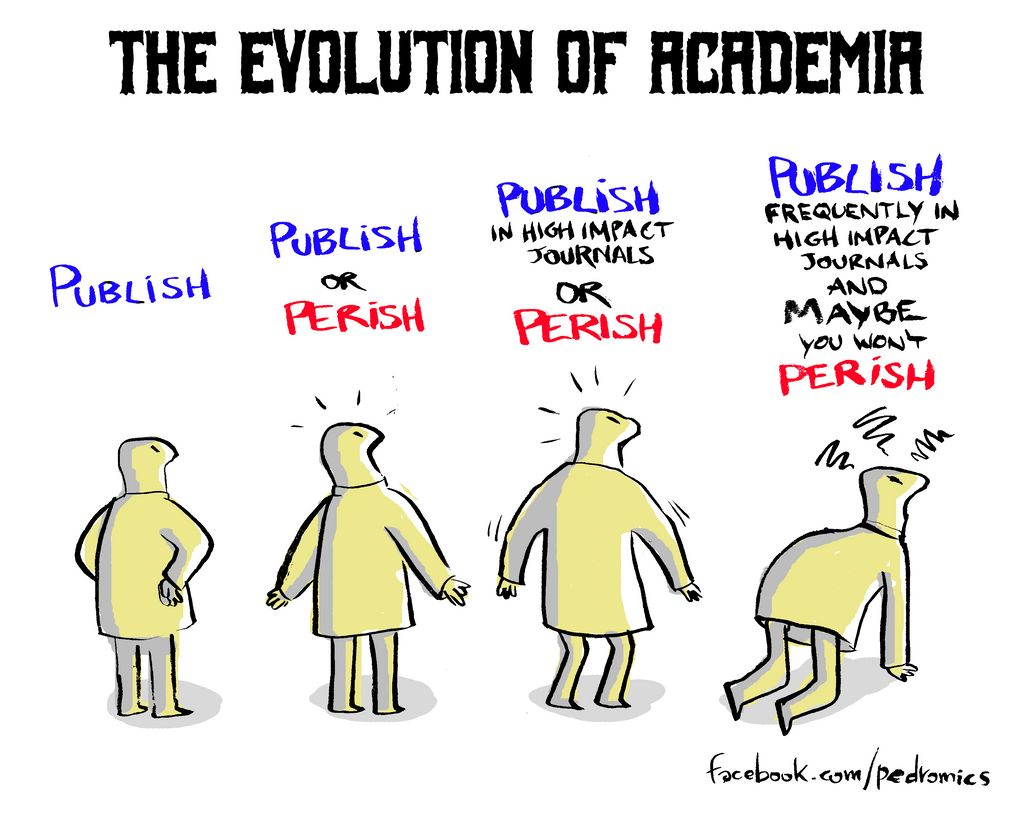

一石惊起千层浪,共鸣声层出不穷:要么发表,要么灭亡?

这则帖子仿佛引起了大家的共鸣:

一个自称是理论物理学家的网友回复道:

「这就是当今理论物理学(和其他大多数『硬科学』学术研究的真实状态。

“要么发表,要么灭亡”的心态根深蒂固。没有人会在头脑清醒的情况下尝试解决实际困难和有意义的问题。只需要在这里调整一个魔性的特征,在那里混合搭配一些方法,你的简历里就会有一堆出版的论文了。

另外一个方面是,审查过程和所使用的方法缺少透明程度。比如一些半斤八两的评论,让学生替他们评论文章,以及一些政治原因等等。

用几年的时间发表一篇可以实际解决科学问题的论文的时代已经一去不复返了。运气越来越成为一个几乎比努力工作更重要的因素。

彼得·希格斯(因提出希格斯玻色子的存在和粒子获得质量的机制而获得诺贝尔奖)多次说过,按照现在的标准,他永远不会成功。

还有网友曾经的研究方向是CNN,他表示:

「我曾经的工作是有关CNN的应用,然而,我们后来被告知说,需要添加一些数学公式,因为这有助于在会议上被接受。

但是,实际上,这些方程式根本没有任何作用,既证明不了什么新东西,也没有提供额外的见解,而仅仅只是基本描述了用矩阵表示的深度学习。

在我度过的其他论文中,我经常看到非常复杂的数学公式,如果你花一个小时去理解它,最后的结果其实用一小行话就可以描述出来。这很可悲。

这导致我在刚开始非常沮丧,认为自己永远都不会擅长数学。

的确,我可能的确不擅长,但是这些论文做的也并不是数学。

在数学公式的应用上,一位研究气候变化的工程博士也有共鸣:

「“堆砌的数学公式”是很普遍的一点。我们经常被明确告知,需要用希腊字母写出各种难以理解的数学公式,因为这样可以令论文看起来更好。

“要么发表,要么灭亡”是学术圈残酷的毒瘤。」

还有网友吐槽了各种对已有模型的魔改论文:

「此外,略好一些的SOTA“之类的论文,除了一些参数调整或者向DNN添加额外的层之外,没有提出任何新颖的方法或者方面,并且阅读起来也非常累人,最后却被会议接受了。

堆砌的数学公式的存在,只是为了提供一种严谨感和新奇感,并掩盖了缺乏实际创新能力的本质。

当然,对已有方法进行迭代是正常的,但是在机器学习领域下,很多论文都感觉好像是在并没有完全理解所提出方法为何有效的情况下进行了边际的改进。」

结语

的确,每年大量的机器学习会议,接受着大量的论文投稿,而这每年数万篇描述「学术进展」的论文中,到底有多少真正的发现?