2020年并不缺重磅新闻,但人工智能依然够杀出重围,走进主流视野。

尤其是GPT-3,它展示了人工智能即将以全新的方式深入我们的日常生活。

这些进步赋予了未来很多可能,预测未来变得并不容易,但伴随着技术应用的成熟,另一些领域的突破也是可预见的。

以下是2021年人工智能有望取得突破的几个方面。

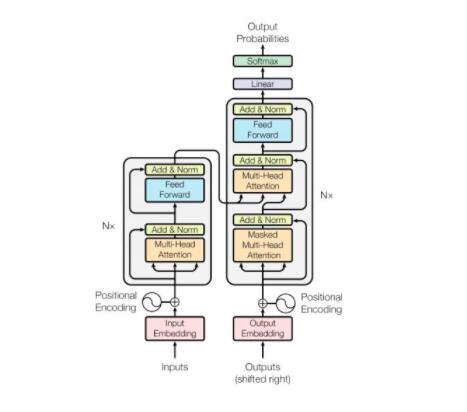

GPT-3和AlphaFold背后的Transformer

2020年最大的两项人工智能成就悄无声息地共享着相同的基本结构。OpenAI 的 GPT-3和 DeepMind 的 AlphaFold 都是基于Transformer.

尽管 Transformer 自2017年以来就已经存在,但 GPT-3和 Alphafold 展示了 Transformer 的非凡能力,它比上一代序列模型学习得更深入、更快,并且在自然语言处理(NLP)之外的问题上也表现出色。

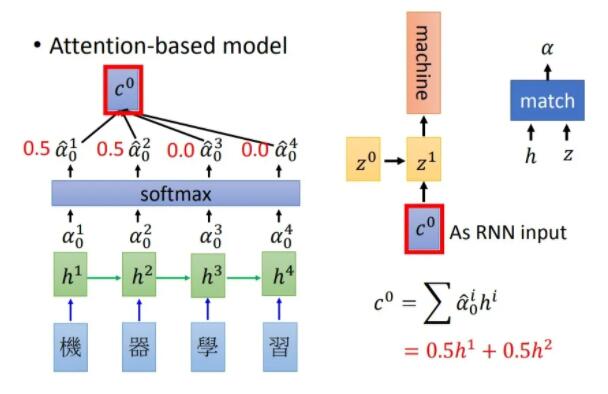

与循环神经网络(RNN)和 长短期记忆网络(LSTMs)等之前的序列模型结构不同。

Transformer能够一次处理整个输入序列,并且引入「注意力」机制来了解输入的哪些部分与其他部分相关。

这样,Transformer就能够轻松解决「长期记忆」的问题,这是循环模型一直在努力解决的问题。

另外,Transformer还允许并行训练,能够更好地利用近年来出现的大规模并行处理器,大大减少了训练时间。

毫无疑问,2021年研究人员将为Transformer寻找新的用武之地,对Transformer将要带来突破也充满信心。

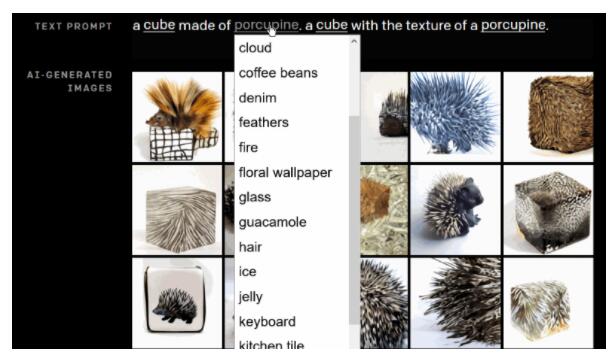

2021年,OpenAI 已经修改了 GPT-3,发布了DALL-E,使其完成从文本描述生成图像。Transformer已经准备好要在2021年大展拳脚了。

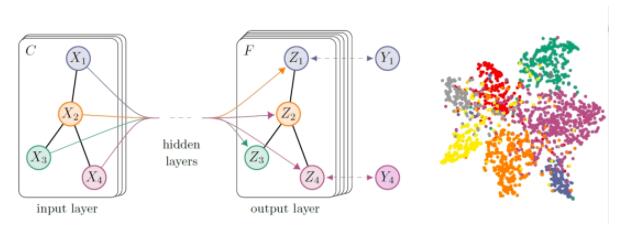

2021年,图神经网络(GNN)发展的两大看点

许多领域的数据自然而然地适用于图形结构,比如计算机网络、社交网络、分子/蛋白质和运输路线等。

图神经网络(GNNs)使深度学习应用于图形结构化数据,我们期望 GNN在未来发挥更大的作用。

2021年,我们预计在几个关键领域的方法进步将推动更广泛地应用GNN.

「动态图」是第一个重要的领域。尽管迄今为止大多数 GNN 研究都假定了一个静态图,但这些情况会慢慢发生变化: 例如,在社交网络中,新成员的加入会产生新的节点 ,关系也会发生变化。

在2020年,我们看到了一些将时间演化图建模为一系列快照的做法,2021年这个新生的研究方向将会扩展,侧重于将动态图表建模为连续时间序列的方法。

这样的连续建模,除了通常的拓扑结构外,还应该使 GNN 能够发现和学习图中的时态结构。

对「消息传递范式」的改进将是另一大可操作的进展。消息传递是实现图神经网络的一种常用方法,它是通过沿着连接邻居的边「传递」信息来聚集节点信息的一种方法。

虽然直观,消息传递难以捕捉到需要信息在图上长距离传播的效果。

2021年,我们期待突破这一范式,例如通过迭代学习哪些信息传播路径是最相关的,甚至学习一个全新的关系数据集的因果图。

2021年的AI应用

去年许多头条新闻都强调了AI在实际应用中的新进展,2021年这些进展有望投入市场。

值得说明的是,由于GPT-3的API将更加可行,依赖于自然语言理解的应用程序也会越来越多。API允许用户访问GPT-3的功能,并且无需耗费精力训练自己的AI。

Microsoft已经获得了GPT-3独家使用授权,这项技术也许会出现在Microsoft的产品中。

在2021年,其他应用领域也将从AI技术中获益。AI和机器学习虽然已经进入了网络安全领域,但2021年将会爆发更大的潜力。

正如太阳风黑客事件所揭露的那样,一些公司已经面临网络犯罪分子和先进的恶意勒索软件的威胁。

而AI和行为分析对于帮助识别新威胁甚至早期威胁至关重要。所以在2021年,希望能够推动最新的行为来分析AI,增强网络防御系统。

2021年,我们还期待有更多默认在边缘设备上运行机器学习模型的应用程序。

像谷歌的 Coral这样具有TPU的设备,随着处理能力和量化技术的进步,也能够推广普及。

图为Carol加速器模块,带有Google Edge TPU的新型多芯片模块。

Edge AI则消除了把数据发送到云上参照的需求,既节省了带宽又减少了执行时间,这两点对医疗保健等领域都至关重要。

边缘计算的应用程序还可以在一些需要隐私、安全和低延迟的区域,甚至世界上无法访问高速Internet的区域中打开。

未来难测,未来可期

随着AI技术在实际领域的运用越来越广泛,Transformer和GNN的进步也会促使它们在现有的AI技术和算法更进一步。以上只是重点介绍了几个有望在今年取得进展的领域,不过相信伴随进展的还会有更多的惊喜。

未来难测,但无论对错,2021年对于AI都将是令人兴奋的一年。