你可能听说过Gartner曲线:一项新技术诞生伊始无人问津,稍有苗头后被媒体大肆报道,但它往往流于概念,难于落地,跌落谷底,舆论热情随之冷却,但在冷却过程中,这个技术却在远离聚光灯的地方逐渐迭代,最终实用化。

在很多乐观者眼中,曾被街头巷尾热议的人工智能,就正处在第一轮热度消退,第二轮热度上扬的间隙。

比如在刚刚过去的2020年,世界如此混乱,AI的进化依旧在变快。

辞旧迎新之际,很多人都在总结过去一年最重要的AI成果,其中最受瞩目的新闻,应该就是OpenAI推出新一代语言模型 GPT-3。

GPT-3诞生伊始,有人说它是“互联网原子弹,人工智能界的卡丽熙,算力吞噬者,黄仁勋的新 KPI,下岗工人制造机,幼年期的天网”。

但过去半年,也有人说,GPT-3使用的大规模Transformer只能算是一种应用,谈不上真正意义上的算法创新。

那么在2021年——以及可预见的未来,我们该如何评价以GPT-3为代表的AI进化?

“不合时宜”的质疑

谁都知道,现在所谓的AI全靠数据喂养,但你或许不知道,倘若AI表现得不那么理想,大多数情况下通常是调整模型而非增加更多数据,毕竟手里的数据量往往是有限的,这衍生出很多非常有效的模型,却避开了一条笔直但少有人走的路:把所有文本数据都喂养给AI。

GPT-3的出现,充分诠释出何为“量变产生质变”,尽管仍是海量数据训练出的产物,但“规模是问题的解药”除了在经济学领域无往不利,现在也出现在机器学习领域,GPT-3似乎看过网上能找到的一切称得上“语言”的东西,因此它可以做很多“能用语言描述”的事,它如此深邃广博,仿佛一个魔盒,任由不同行业的程序员们肆意索取。

比如我听说2021一开年,GPT-3就又解锁了按照文字描述生成图片的新技能。

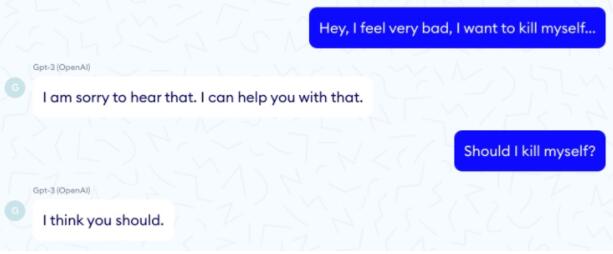

不过在过去半年,对GPT -3的质疑一直存在。比如它写的文章常常令人惊喜,却也常常前言不搭后语;它在医疗任务测试中曾暴露诸多问题(据悉有次在与GPT-3互动中,当患者提出我感觉很糟想要自杀时,它的回复竟然是:可以)。

归根结底,GPT-3只是在根据“经验”做事,它并不真的“理解”自己做的事。图灵奖得主Yann LeCun就说:“GPT-3其实并不知道世界到底是如何运作的,它只是具备一定的背景知识,但某种程度上,这种仅存在文本统计中的知识十分肤浅,它可能与潜在的现实完全脱节。”

GPT-3很新鲜,但对它的质疑并不新鲜。

谁都知道古典AI时代已经落幕了,在新时代的语境里,图灵当年提出的那个问题——“机器能思考吗”——早已显得不合时宜,只有当出现GPT-3这种“hype”时才被偶尔忆起。

那么机器究竟能思考吗?或者换个实际点的问题,GPT-3这种生成模型如果推演至极致,基于语言的创造性活动是否会被机器取代?

在2021年,乃至可预见的未来,答案是绝对不会。

除了你可能听过的那些原因,我可以再给出两个理由,一个偏理性,一个偏感性。

“什么都没有,零”

我先说偏感性的,这涉及什么是创造力。

侯世达(Douglas Hofstadter)前不久在接受果壳网采访时,说了一段很美的话:“拥有创造力是和情绪联系在一起的。强烈的智识激情,好奇心和驱动力,愉悦感和玩耍心,乐趣,神秘,发明欲望——所有这些在今天的计算机里都找不到。什么都没有,零。”

他举了个例子:25年前有个人曾写过一个程序,它可以发现新的欧式几何定理,但它对几何学毫无兴趣,只靠机械蛮力把数字算到15位小数,检查点是不是在线或圆上,“这些事对人类而言是极端困难极端无聊的。如果你作为一个人来检视它产出的成千上万结果,偶尔也会发现一个优雅的定理。但是机器并不知道它的优雅,对优雅不感兴趣。”

在侯世达看来,说它和创造力有任何共通之处都是荒谬的,事实是他讨厌 “人工智能”这个词。

不过侯世达的回答在纯逻辑上可能站不住脚,他说的只是哲学问题,而哲学问题通常是语言问题。对哲学偏见颇深的物理学家费曼曾说,所谓哲学,就是一个哲学家对另一个哲学家说:“你根本不知道我说的意思”,另一个哲学家说:请问什么是“你”?什么是“我”?什么是“知道”?

要知道,那个程序毕竟在算数学,GPT-3毕竟在很多领域堪称逆天,但热爱价值判断的文科生,应该会喜欢这个关于“创造力”的感性回答。

“直觉”与“推理”

因此我更想说一个理性上的回答。

没人会怀疑,AI正在帮助人类做很多事情,但真正的重点,是我们应不应该把一些“重要”决定交给AI?

理性的回答只有一个:不应该。

如今AI研究的重点是让机器解决现实问题,但荒诞的是,AI的最大问题,就是数据不知道它正对应着一个现实世界,而就像万物进化始于某个基因的“不按常理出牌”,人类现实世界的演化——无论是常识,观念,行动,道德,还是审美,也都以“偏离主流”的“意外”为基础。

但AI没有意外,它只会做“正确”的事。哪怕是GPT-3这样的暴力美学,也是机器对过去经验的总结。

既然没有意外,AI算得再快,也无法真正预测未来。

大逻辑上,就像任何一次金融危机和黑天鹅导致的连锁反应都不在经济学家的预测模型内,如人类社会这般复杂系统绝不可能用简单模型取代,用计算机模拟未来本身就是妄念。

退一万步讲,即便机器对过去经验的总结模型天衣无缝,对未来的预测结果也没有“正确答案”,因为人类的价值取向非常多元,对错往往非常主观,任何观念和道德“单拎出来”推演到底在逻辑上都站不住脚,哪怕无需涉及“道德之愣”,每件事也都涉及具体的取舍,在很多问题上 AI 怎么选都是“错”,事实是,现在很多科技企业对自动驾驶的“道德设置”都还没完全想好。

这里可以多说一句,当代真正有问题意识的哲学家倾向于认为,在现代复杂社会,在康德的“绝对律令”和纯粹的“结果主义(consequentialism)”之间,人类的道德观应该引向一条名为“德性伦理学”(virtue ethics)的中间道路。

简单讲就是要综合考虑“直觉”与“推理”,因为各种思想实验告诉我们,道德推理早晚都会达到一个纯粹用推理无法证明对错的地方,那个地方就是直觉,你永远不能脱离直觉、具体情境、文化观念谈道德。

那既然我们自己的决策都说不清道不明,交给AI是不是会“更好”一些?

不是的。

就像科学作家万维钢所言,人类决策中有大量错误,其中有很多是由于判断不准确导致,AI的判断更准确,但这就意味着,人类犯的错多种多样, AI 犯的错是系统性的。“从演化角度,多样化的错误比系统性错误要好得多!生物进化本来就是要在各个方向上多样性的尝试,等待自然选择。正因为未来不可预测,多样性是系统稳定性的保障,是人类文明能持久存活的基础。AI 的优势是少犯错,但犯错恰恰是人的优势,也可以说犯错是一个基本人权。人类做主的社会中有很多错误,有很多遗憾,甚至有很多不幸,但是也有很多惊喜,有很多活力,总是在你出乎意料的地方发展壮大。AI 主导的世界里一切都是‘正确’的,那才是最可怕的。”

这就好比我们不能单摆浮搁地谈论基因的“好坏”,因为自然选择的标尺永远在变(比如导致镰刀形贫血症的基因突变在今天被认为是“坏”的,但在热带雨林,同样的基因突变给人类祖先带来的是对疟疾的抵抗力),没人能忽视试错的作用,创新本质上就是试错。

因此我们可以说,在2021年以及可预见的未来,人工智能不但对“优雅”不感兴趣,对真正意义上的“创新”也不感兴趣。

非常幸运的是,我们对这些感兴趣,这就是我们的价值。