纽约大学心理学和神经科学教授Gary Marcus和深度学习先驱和2018年图灵奖得主Yoshua Bengio在线上进行了一场“神仙打架”,邀请了包括李飞飞在内16位全球知名的AI学者、生物科学家和法律界专家,讨论近一年内AI各领域的进展突破,以及下一个十年如何将人工智能提升到下一个阶段。

此次圆桌论坛围绕着“如何用跨学科方法推动AI前进(Moving AI Forward: An Interdisciplinary Approach)”的主题,下分三个模块:架构与挑战(Architecture and Challenges)、神经科学与心理学带来的洞见(Insights from Neuroscience and psychology)、构建可信任的AI(Towards AI we can trust),共持续了三个多小时。

演讲主题汇总:https://montrealartificialintelligence.com/aidebate2/readings.pdf

辩论视频:https://montrealartificialintelligence.com/aidebate2/

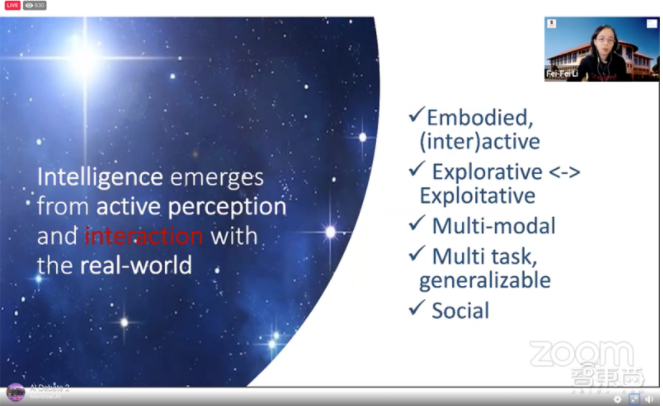

一、李飞飞:与环境交互是下一颗AI“北极星”

作为首位发言嘉宾,斯坦福大学教授李飞飞提到了AI领域的“北极星”,即未来学科的发展方向。在过去五十年中,AI领域有一颗很重要的“北极星”就是物体识别,这也是人类认知能力中很重要的部分。物体识别的进步也带来了如ImageNet等AI基准测试水平的巨大突破。

李飞飞援引了1963年一项基于动物的“与环境交互产生行为刺激”的研究,提出培养下一代AI与环境交互是未来很重要的研究方向。

她也提到互动是智力很重要的组成部分,就像婴儿通过与外界的互动认识世界一样,下一代AI也应该具备通过与外界交互发展自身智能的能力,而这一代AI的实体也不仅限于物理机器人,智能体(Agent,可以自主活动的软件或者小型硬件)也可以。

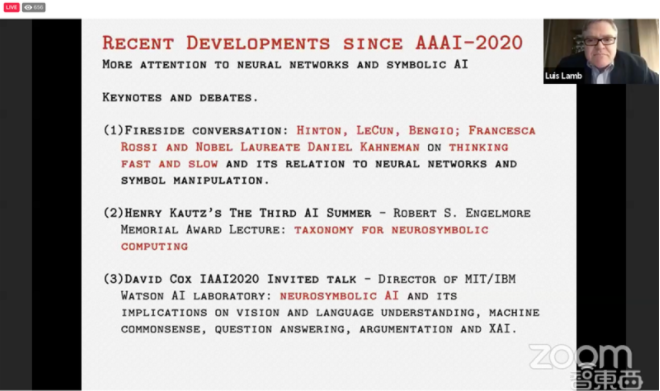

二、Luís Lamb:架起符号AI和神经网络的“桥梁”

巴西南里约热内卢联邦大学计算机科学教授Luís Lamb延续他上周在NeurIPS AI会议上的话题,谈到了“神经符号AI(neurosymbolic AI)”。

神经符号AI即将上世纪70年代AI学界流行的符号主义与目前主流的神经网络算法融合。

简单言之,符号AI可以对物体进行分类及定义,存在自己的知识库中,但如果需要回答更复杂的问题则需要构建足够庞大的知识库,因为符号AI只能回答知识库中已有的分类。

神经符号AI具体的实现办法,是利用深度神经网络构建符号AI所需要的知识库,然后使用符号AI对任务进行推理。

Lamb提到连接符号AI和神经网络的通用方法是未来很重要的研究方向,Marcus在《代数思维(The Algebraic Mind)》提到的在神经网络中控制符号AI的方法也非常有借鉴意义。

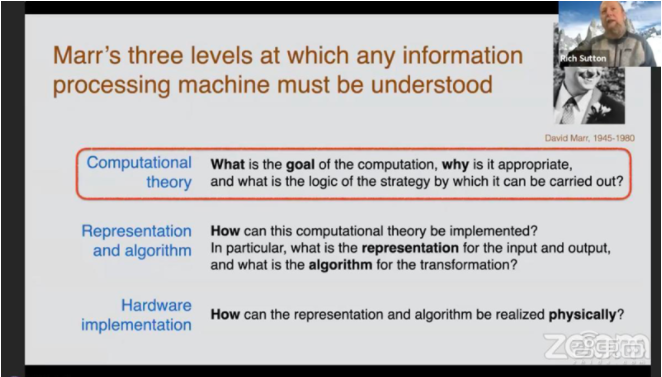

三、Rich Sutton:强化学习或是AI的第一个计算理论

DeepMind科学家Rich Sutton认为AI需要一种公认的智能计算理论。

他引用了神经科学家David Marr三个处理级别的概念:计算理论、表征和算法以及硬件设备,提出当前AI届中并没有计算理论,梯度下降等可以被称为AI的方法,但远称不上理论。

在发言的最后,Sutton总结道,强化学习或许会是智能的第一个计算理论,预测编码和贝叶斯推断也可能可以被称为AI的计算理论。

四、Judea Pearl:模型要“明白”因果关系

图灵奖获得者、贝叶斯网络之父、畅销书《为什么(Why)》的作者Judea Pearl探讨了如何让模型理解因果关系。

Pearl认为如果我们想让模型知道“目前是什么情况”、“如果发生了这个情况要怎么办”以及“只有这一种情况吗”,那么深度理解是最好的办法。

模型的深度理解是建立在深度学习基础上的,Pearl说,自己新开发的、可以表征模型“心理状态”的计算模型就是基于对模型因果关系的深度学习。

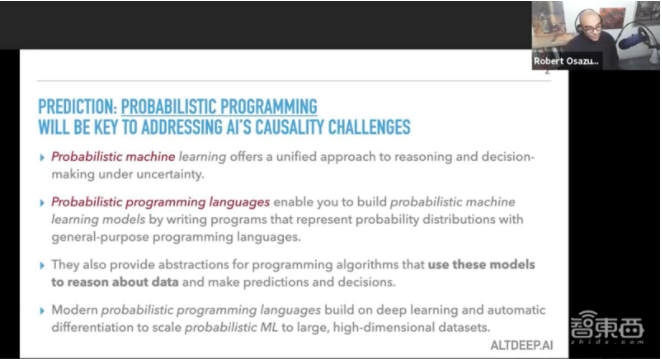

五、Robert Ness:概率编程辅助因果推理

机器学习专家Robert Ness演讲的主题是“因果推理与(深度)概率规划(causal reasoning with (deep) probabilistic programming)”。

Ness说,概率编程能够帮助我们在面对不确定性时做出决策,这很大程度地规避了因果推理中过于依赖先验事实的缺点,也可以解决一部分Pearl所提到的“只有这一种情况吗”的问题。

Ness以新冠病毒传播模型为例,概率编程可以利用自身“不确定性”,基于先前的传染病数据进行流行病学建模,为“抗疫”贡献自己的力量。

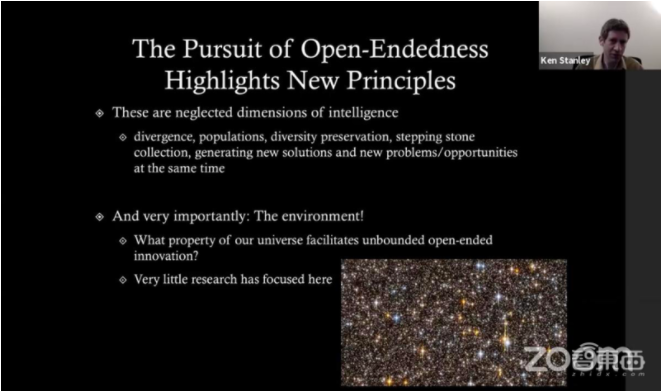

六、Ken Stanley:计算机的进化之路

中佛罗里达大学(the University of Central Florida)计算机科学教授Ken Stanley探讨了进化与创造性,计算机能解决很多问题,但人类也能做到很多计算机做不到的事情,那就是开放性的创新。

“在过去数千年,从钻木取火到太空空间站,我们怀抱着一个开放的心态,在旧事物上发展出新事物。”Stanley认为,但计算机的进化路径却是“现象型(phenomenal)”的,不同的阶段会出现不同的应用需求和新方法,我们需要去理解这些现象,才能持续计算机的“进化之路”。

Stanley也承认目前看来,计算机或者说AI的“进化”并不那么完美,像AI仿制一些艺术画作,或许看起来像模像样,但其实不算真正的艺术,还会对那些艺术初学者造成打击。

Stanley认为,这时候就需要我们去正确看待AI,它是帮助我们的工具,真正的目的是帮助人类进步,它的进化与人类的进步是相辅相成的。

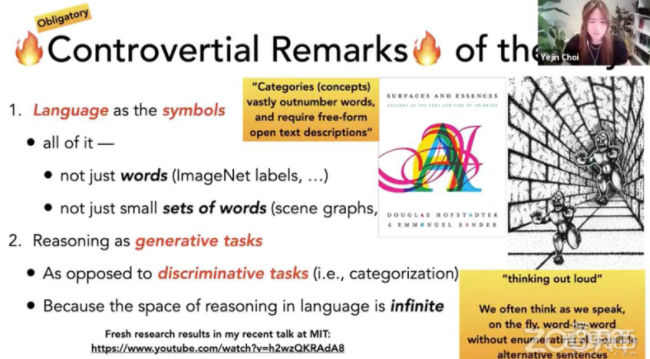

七、Yejin Choi:AI语言模型还需要有大突破

华盛顿大学计算机科学系副教授Yejin Choi通过著名的视觉幻觉“隧道中的怪物”,谈到大脑是如何基于视觉情景理解图像内容。

随即,Choi也指出语言理解是未来AI应用很重要的一部分,人类大部分信息和推理都是依靠语言获取和传播的,未来AI的语言能力也应该像人类一样,能够即时基于当前信息进行推理。她认为这将成为未来AI发展的关键和根本性挑战之一,但目前如GPT-4/5/6等未来新的语言模型都远远不足以达到这个目标。

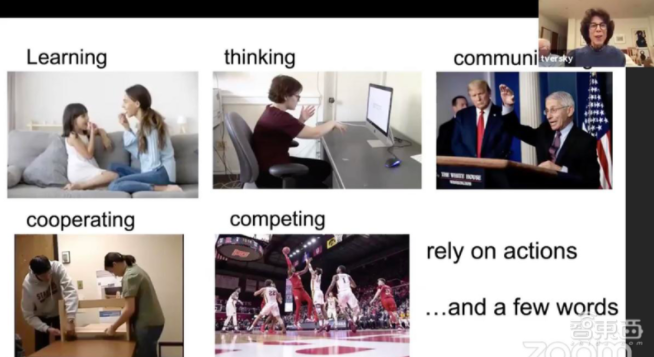

八、Barbara Tversky:生命在于运动

在以上七位科学家讨论完关于AI算法的未来预期后,本次圆桌论坛还邀请了五位生物、神经科学领域的专家,讨论生物和AI“跨界”合作。

斯坦福大学心理学名誉教授Barbara Tversky认为,所有的生物都必须在空间中运动,运动停止,生命也就终结了。Tversky还谈到了人们如何做手势以及能够影响人类思维变化的运动。

她说:“学习、思考、沟通、合作以及竞争,都依赖于行动以及少量话语。”

Tversky也同样担心当AI模仿人的行为去学习的时候,是否也会“继承”人类的一些错误。如何让AI有创造力地不断进化更新,同时规避人类行为中负面的部分,Tversky表示很感兴趣。

九、Daniel Kahneman:人类思考范式可被AI借鉴

诺贝尔经济学奖得主、AI推理问题权威书籍《快思慢想》(Thinking, Fast and Slow)作者Daniel Kahneman认为世界上存在两种思考范式,一种是直观的认知,比如依靠生活经验,我们可以预测到绝大多数可能将会发生的事,另一种是更高级的推理形式,比如我们能从更宽阔的视角,推测那些可能“反常识”的事件。

Kahneman认为这种人类思考范式可以被AI所借鉴,发展出AI模型自己的思维,也能回答Pearl之前提到过的因果推理问题。

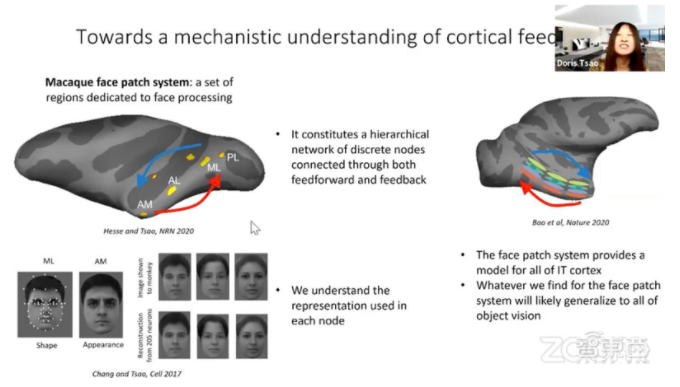

十、Doris Tsao:机器学习与神经科学携手共进

加州理工学院生物学教授Doris Tsao基于对神经元的研究,认为反馈系统不仅在生物神经传导中非常重要,在多层神经网络的反向传播中也有很大作用。

她说道,反馈或许不仅能让人们构建出鲁棒性更强的视觉系统,也能帮助人类理解为什么会产生幻觉。

Tsao同时也对机器学习与神经科学跨学科合作的未来充满希望。

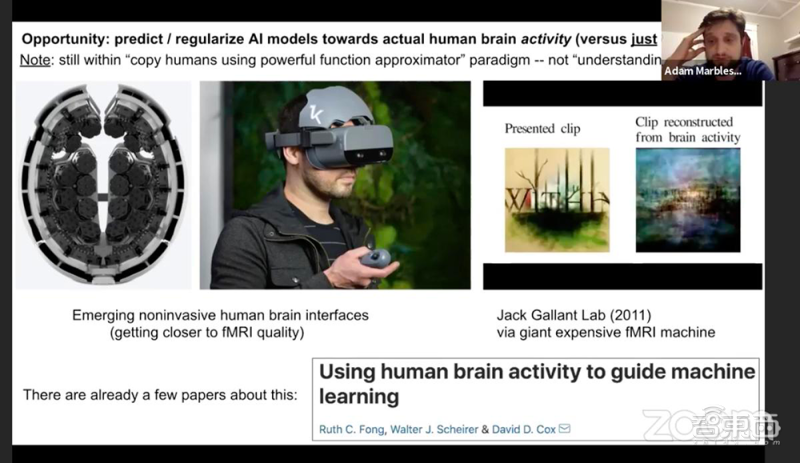

十一、Adam Marblestone:卷积神经网络对人脑的模范还非常“初级”

前DeepMind教授、加州理工学院神经科学专家Adam Marblestone探讨了人类大脑运行规律和神经网络算法的异同。

在讨论中,Marblestone提到目前用功能核磁共振成像技术对人类脑部活动进行分析,研究人类是如何对物体进行分类。他认为目前科学家对大脑的研究还处于非常原始的阶段,像卷积神经网络之类的算法也只是简单地复制了人类思维过程。

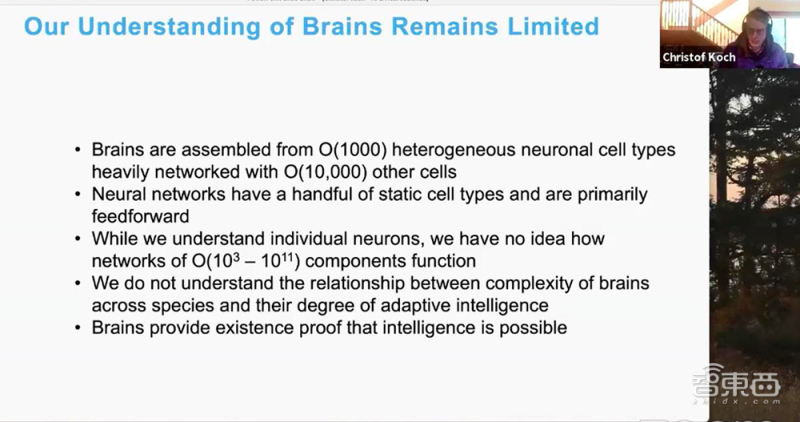

十二、Christof Koch:借鉴人脑发展AI尚不可行

西雅图艾伦脑科学研究所研究员Christof Koch则提出了不一样的观点。他认为科学家了解人脑至少还需要一两百年的事件,指望借助神经科学来助力人工智能的发展是行不通的,人脑与AI等人造物体的特性完全不同。

Koch的观点与上述几位神经学家的观点发生了激烈的碰撞。

针对Koch和Marblestone关于“细胞的传导与神经网络中节点的传导具有相似性”的反驳,Koch回答,即使是人类细胞自身也大不相同,例如视觉神经元与前额叶皮质神经元就非常不同,而换到神经网络等人造算法上,情况则更加多样。

Marblestone则认为Koch的观点需要更多实症证明。

十三、Celeste Kidd:AI偏见助长社会中已有的歧视情绪

随着论坛进入了第三个模块,四位受邀专家开始讨论AI对人类社会伦理道德和生活的影响。

加州大学伯克利分校教授Celeste Kidd的研究课题是人类如何形成认知。Kidd认为,AI系统的偏见强化了使用者的偏见,内容推荐系统会使人们对已有偏见坚信不疑,而亚马逊和领英的AI招聘系统则会对女性候选者造成负面影响。

Kidd说:“像Timnit Gebru被谷歌解雇这件事一样,因为AI引起的纷争可能会成为常态。”

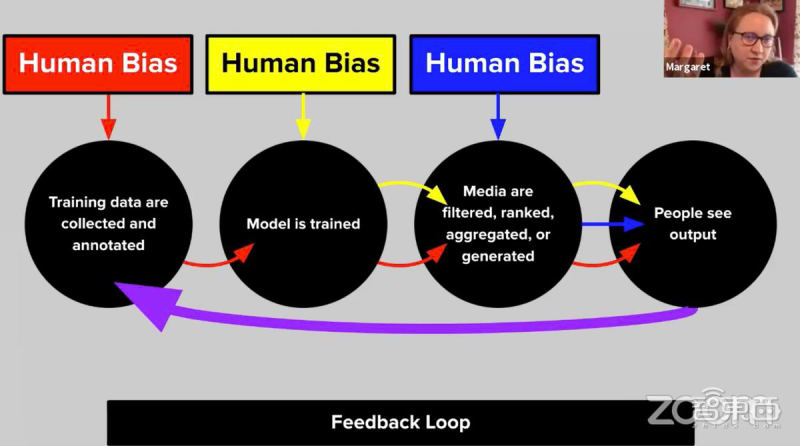

十四、Margaret Mitchell:用技术攻破技术“偏见”

谷歌高级研究科学家Margaret Mitchell认为这些偏见是源于模型本身的创建过程。

通常开发机器学习算法,需要经历收集数据、训练模型、评估模型以及使用的过程。但在收集、标记数据的过程中,人类参与必不可少,这就注定了模型会带有一些来自于开发者的偏见。

Mitchell说:“技术有技术的优势,但技术本身确实会带有一定风险。我们试图解决这些问题,用如洗刷偏见(bias laundering)等方法去减少系统中的偏见。”

十五、Francesca Rossi:如何建立可信任的AI生态系统

承接着Mitchell的话题,IBM的Rossi谈到如何创建可信任的AI生态系统。

Rossi说道,一个成熟的AI系统需要涵盖许多特点,比如准确性、一致性、公平性和可解释性。如何向人类同伴们,解释机器是如何工作的非常重要,这也是Mitchell所提到的洗刷偏见的问题。

Rossi认为,这个过程依旧需要大量的研究和试验,保证模型如何在训练阶段就能很大程度上消除偏见,神经符号AI以及Kahneman所提到的两种人类思维范式都会是今后的研究方向。

十六、Ryan Calo:AI将会给法律带来改变

本次论坛最后一个演讲嘉宾是华盛顿大学法学教授Ryan Calo。

他认为技术是很难被监管的,我们只有让法律跟着AI的变化进行相应的规定,而实施的第一步就是评估AI对人类生活在哪些方面产生影响,每个方面又有多大程度的影响,再让法律灵活地进行调整。

AI也必然会带来法律的修改,无论是目前公众关于AI“公平”与否的争论,还是法律界内部的讨论,目的都只有一个,就是保证AI技术成本和收益平均分配,在便利人民生活的同时,防止对个人隐私的侵犯。

结语:让世界变得更好的AI初心

当三个小时的论坛快结束时,主持人Marcus问了所有嘉宾一个问题:“AI走到哪一个地步你们会满意,我们构建AI的终极目标是什么?”

尽管每位学者回答的角度和内容都不同,但有三个词反反复复地出现:有趣、友善和公平,而最后的落脚点也只有一个,用技术让所有人过上更好的生活。

或许这个过程会有偏差和坎坷:算法会不公、监管会不全……但每位AI研究者依旧怀抱着纯粹的初心,在2020末尾的冬夜里,隔着遥遥网线,畅谈着AI的下一个十年。