尽管人工智能的诞生已经超过半个世纪,但近十年来人工智能领域发展非常迅速。自2012年ImageNet竞赛开始深度学习的现代时代以来,只有8年的时间。自那时以来,人工智能领域的进步令人震惊,现在人工智能已经深入我们日常工作生活的方方面面。

有专家表示,这个惊人的步伐只会越来越快。从现在开始的五年后,人工智能领域将与今天大不相同。当前被认为是最先进的方法将已经过时;今天刚刚出现或处于边缘的方法将成为主流。

下一代人工智能将是什么样子?哪种新颖的AI方法将释放当前在技术和业务方面难以想象的可能性?之前的文章《下一代人工智能的发展方向 (上)》涵盖了AI内的三个新兴领域,(无监督学习、联合学习和Transformer)这些领域将在未来几年重新定义人工智能领域和社会。

本文将再介绍另外三个:

4、神经网络压缩

人工智能正在走向边缘。

能够直接在边缘设备(例如电话、智能扬声器、摄像头、车辆)上运行AI算法具有巨大优势,而无需从云端来回发送数据。

也许最重要的是,边缘AI增强了数据隐私性,因为不需要将数据从其源头移动到远程服务器。由于所有处理均在本地进行,因此Edge AI的延迟也较低。对于诸如自动驾驶汽车或语音助手之类的时间敏感型应用程,这至关重要。它具有更高的能源效率和成本效益,成为机器学习扩大的计算和经济成本日益重要的考虑因素。而且,它使AI算法无需互联网连接即可自主运行。

Nvidia首席执行官黄仁勋(Jensen Huang)是AI商业世界的巨头之一,他认为边缘AI是计算的未来:“ AI正在从云移动到边缘,连接到AI计算机的智能传感器可以加快许多应用的速度,并节省能源。随着时间的流逝,将有数以万亿计的这种由人工智能驱动的小型自主计算机。”

但是,要使边缘智能无处不在的崇高愿景成为现实,就需要一项关键的技术突破:人工智能模型需要变得更小,而且比目前的小得多。因此,在不损害神经网络性能的情况下开发和商业化压缩神经网络的技术已成为AI领域最重要的追求之一。

如今,典型的深度学习模型非常庞大,需要大量的计算和存储资源才能运行。 OpenAI的新语言模型GPT-3于今年夏天成为头条新闻,其模型参数高达1750亿个,仅存储模型就需要超过350 GB的空间。即使是大小不接近GPT-3的模型也仍然需要大量计算:ResNet-50是几年前开发的一种广泛使用的计算机视觉模型,每秒使用38亿个浮点运算来处理图像。

这些模型不能在边缘运行。边缘设备中的硬件处理器(例如手机、Fitbit或Roomba中的芯片)功能不足以支持它们。

因此,开发使深度学习模型更轻量级的方法成了关键:它将释放围绕分散式人工智能构建的一系列产品和商业机会。

这样的模型压缩将如何工作?

近年来,研究人员和企业家在该领域取得了长足进步,开发了一系列使神经网络小型化的技术。这些技术可以分为五个主要类别:精简、量化、低秩分解、紧凑型卷积滤波器和知识蒸馏。

精简需要识别并消除神经网络中的冗余或不重要连接,以使其精简。量化通过使用较少的比特表示值来压缩模型。在低秩分解中,模型的张量将被分解,以构造近似于原始张量的稀疏版本。紧凑型卷积滤波器是经过特殊设计的滤波器,可减少执行卷积所需的参数数量。最后,知识蒸馏涉及使用模型的完整版本来“教”一个较小的模型以模仿其输出。

这些技术大多彼此独立,这意味着它们可以串联部署以提高结果。实际上,其中一些(精简、量化)可以应用于已经存在的模型,而其他一些(紧凑的过滤器、知识蒸馏)则需要从头开始开发模型。

少数新兴公司已经出现,将神经网络压缩技术从研究领域推向市场。更有前途的有Pilot AI、Latent AI、 Edge Impulse 和Deeplite。举一个例子,Deeplite声称其技术可以使神经网络缩小100倍,加快10倍,将电源效率提高20倍,而不会牺牲性能。

“在过去的十年中,世界上具有一定计算能力的设备数量激增,” Pilot AI首席执行官Jon Su解释说。 “Pilot AI的核心IP极大地减少了用于对象检测和跟踪等任务的AI模型的大小,从而使AI / ML工作负载可以直接在边缘IoT设备上运行。这将使设备制造商能够将每年售出的数十亿个传感器(如按钮门铃、恒温器或车库门开启器)转换为可为下一代IoT应用提供支持的丰富工具。”

大型技术公司正在积极收购这一类别的初创公司,突显了该技术的长期战略重要性。今年早些时候,苹果以2亿美元的价格收购了总部位于西雅图的Xnor.ai。Xnor的技术将帮助苹果在其iPhone和其他设备上部署边缘AI功能。特斯拉在2019年收购了该领域的早期先驱者之一DeepScale,以支持对其车辆的推断。

多年来,最重要的技术交易之一-英伟达上个月宣布的以400亿美元收购Arm的交易-很大程度上是由于AI走向边缘而加速向高效计算的转变。

英伟达首席执行官黄仁勋在谈到这一交易时强调了这一点:“能源效率是未来计算领域中最重要的一件事……英伟达和Arm将共同打造这个人工智能时代世界一流的计算公司。”

在未来的几年中,人工智能将变得不受束缚、分散化和环境化,并在边缘的数万亿种设备上运行。模型压缩是一项必不可少的促成技术,它将帮助实现这一愿景。

5、生成人工智能

当今的机器学习模型主要对现有数据进行交织和分类:例如,识别人脸或识别欺诈。生成式AI是一个快速发展的新领域,它专注于构建可生成自己新颖内容的AI。简而言之,生成型人工智能将人工智能超越了感知到创造。

生成AI的核心是两项关键技术:生成对抗网络(GAN)和变分自编码器(VAE)。

两种方法吸引人的是,GAN是Ian Goodfellow在AI先驱Yoshua Bengio在蒙特利尔大学攻读博士学位时于2014年发明的。

Goodfellow在概念上的突破是使用两个独立的神经网络构造GAN,然后将它们相互对抗。

从给定的数据集(例如,一张人脸照片的集合)开始,第一个神经网络(称为“生成器”)开始生成新图像,这些图像在像素方面在数学上类似于现有图像。同时,第二个神经网络(“鉴别器”)被喂入照片而没有被告知它们是来自原始数据集还是来自发生器的输出。它的任务是识别合成的照片。

当这两个网络不断地互相作用时(生成器试图欺骗鉴别器,鉴别器试图暂缓生成器的创造物),它们彼此磨炼了能力。最终,判别器的分类成功率下降到50%,没有比随机猜测更好,这意味着合成生成的照片已经与原始照片变得难以区分。

2016年,AI大神Yann LeCun称GAN为“过去十年中机器学习中最有趣的想法”。

与GAN差不多同时推出的VAE是一种概念上相似的技术,可以用作GAN的替代方法。

与GAN一样,VAE由两个神经网络组成,这两个神经网络协同工作以产生输出。第一个网络(“编码器”)获取一条输入数据并将其压缩为较低维的表示形式。第二个网络(“解码器”)采用这种压缩表示形式,并基于原始数据属性的概率分布和随机性函数,生成新颖的输出,将“riff”输入到原始输入。

通常,GAN的输出质量比VAE更高,但构建起来更加困难且成本更高。

与更广泛的人工智能类似,生成型AI激发了广泛受益的和可怕的现实世界应用。只有时间能说明哪个将占主导地位。

从积极的方面来看,生成AI的最有希望的用例之一是合成数据。合成数据是一种潜在的改变游戏规则的技术,它使从业人员能够数字化地构建他们训练AI模型所需的确切数据集。

如今,访问正确的数据既是AI的最重要也是最具挑战性的部分。通常,为了训练深度学习模型,研究人员必须从现实世界中收集成千上万个数据点。然后,他们必须在每个数据点上贴上标签,然后模型才能从数据中学习。这充其量是一个昂贵且耗时的过程。最糟糕的是,根本无法获得所需的数据。

合成数据使从业人员能够根据需要人为地创建高保真数据集,以适应他们的精确需求,从而颠覆了这种范式。例如,使用合成数据方法,自动驾驶汽车公司可以生成数十亿个不同的驾驶场景供其车辆学习,而无需在现实世界的街道上实际遇到这些场景中的每一个。

随着合成数据准确地逼近现实世界数据,它将使AI民主化,削弱专有数据资产的竞争优势。在可以按需廉价地生成数据的世界中,跨行业的竞争动态将被颠覆。

涌现出了一批有前途的初创公司来追逐这一机会,包括Applied Intuition、Parallel Domain、AI.Reverie、Synthesis AI和Unlearn.AI。大型技术公司(包括Nvidia、Google和Amazon)也在大力投资于合成数据。合成数据的第一个主要商业用例是自动驾驶汽车,但该技术正在迅速遍及各个行业,从医疗保健到零售以及其他领域。

抵消合成数据的巨大积极潜力,另一种生成型AI应用有可能对社会产生广泛的破坏性影响:DeepFakes。

本质上,DeepFakes技术使拥有计算机和互联网连接的任何人都可以创建看起来真实逼真的照片和视频,这些人所说的和做的事情实际上并没有说或做,只是换了张别人的脸而已。

Deepfake技术已被广泛应用的第一个用例是成人内容。根据初创公司Sensity在2019年7月的一份报告,在线上的Deepfake视频中有96%是有关成人内容的。 Deepfake几乎总是在未经同意的情况下进行的,涉及人工合成具有著名名人或私人联系人的露骨视频。

从互联网上的这些黑暗角落,DeepFakes的使用已开始蔓延到政治领域,在政治领域,危害更大。最近在加蓬、马来西亚和巴西与DeepFakes相关的政治事件可能是即将发生的事的早期例子。

布鲁金斯学会(Brookings Institution)在最近的一份报告中严厉地总结了DeepFakes带来的一系列政治和社会危险:“扭曲民主言论;操纵选举;削弱对机构的信任;削弱新闻业;加剧社会分化;破坏公共安全;并造成难以修复的著名人士,包括民选官员和公职候选人的名誉受到损害。”

合成数据和Deepfake的核心技术是相同的。然而,用例和潜在的现实世界影响却截然相反。

技术上的一个大真理是,任何给定的创新都可能给人类带来巨大的利益,也可能给社会带来严重的伤害,这取决于人类选择使用它的方式。核能确实如此;互联网确实如此。人工智能同样如此。生成式人工智能就是一个有力的例证。

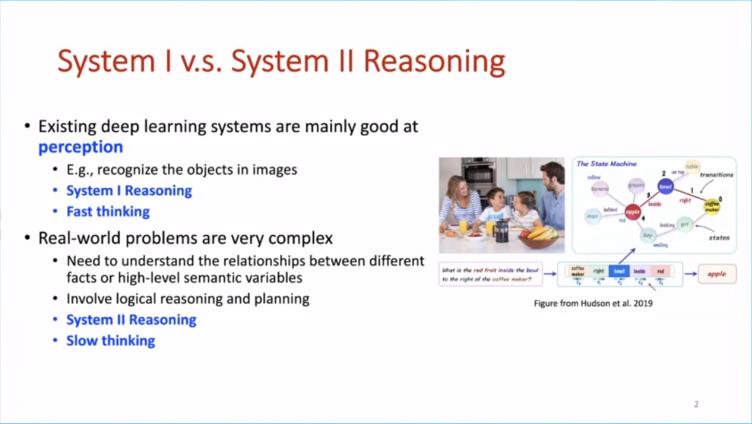

6、“syetem2”推理

诺贝尔奖获得者心理学家丹尼尔·卡尼曼(Daniel Kahneman)在其具有里程碑意义的著作《思考,快与慢》中普及了“系统1”思维和“系统2”思维的概念。

- system1是直觉系统,主要负责快速、无意识、非语言的认知,这是目前深度学习主要做的事情;

- system2是逻辑分析系统,是有意识的、带逻辑、规划、推理以及可以语言表达的系统。这是未来深度学习需要着重考虑的。

system1的思维是直观、快速、轻松而自动的。system1的活动示例包括识别朋友的脸,阅读路过的广告牌上的文字或填写“战争与_______”一词。system1几乎不需要有意识的处理。

系统2的思考速度较慢,更具分析性和审议性。当需要费力的推理来解决抽象问题或处理新颖情况时,人们会使用System 2思维。system1活动的示例包括解决复杂的脑筋急转弯或确定社交环境中特定行为的适当性。

尽管system11 /system12框架是为分析人类认知而开发的,但它可以很好地映射到当今的人工智能世界。简而言之,当今最先进的AI系统在System 1任务上表现出色,但在System 2任务上却举步维艰。

AI领导者Andrew Ng对此进行了很好的总结:“如果一个典型的人可以花不到一秒钟的时间完成一项心理任务,那么我们现在或不久的将来都可以使用AI将其自动化。”

Yoshua Bengio在NeurIPS的2019年主题演讲中探索了这个确切的主题。 Bengio在演讲中呼吁AI寻求新方法,使AI系统能够从System 1任务扩展到System 2功能,例如计划、抽象推理、因果理解和开放式概括。

Bengio说:“我们希望拥有能够理解世界的机器,能够建立良好的世界模型,能够理解因果关系,并且能够在世界上采取行动来获取知识。”

有许多不同的方法来组织AI学科的议程、轨迹和抱负。但是,也许最强大、最紧凑的方式是这样的:为了进步,人工智能需要在system2思维上变得更好。

尚无人确切知道向System 2 AI迈进的最佳方法。近年来,有关如何执行此操作的争论经常引起争议。这场辩论引发了关于智力概念的基本哲学问题。

Bengio坚信,尽管可以对当今的神经网络进行进一步的创新,但System 2推理可以在当前的深度学习范例中实现。

Bengio在NeurIPS的主题演讲中说:“有人认为我们需要发明全新的东西来应对这些挑战,也许可以回到经典的AI来处理诸如高级认知之类的问题。” “但是,我们现在有一条路,扩展了深度学习的能力,可以解决认知系统2的这类高级问题。”

Bengio指出,注意力机制,持续学习和元学习是深度学习中的现有技术,它们对追求System 2 AI具有特别的希望。

但是,其他人则认为,人工智能领域需要更根本的重置。

教授兼企业家Gary Marcus一直特别提倡非深度学习方法来研究System 2智能。 Marcus呼吁将神经网络与符号方法结合起来的混合解决方案,这种方法在AI研究的最初几年中很流行,但最近却不受欢迎。

“深度学习只是构建智能机器的更大挑战的一部分,” Marcus在现代深度学习时代来临之际于2012年在《纽约客》上写道。 “这类技术缺乏表达因果关系的方法,并且在获取抽象思想时可能会面临挑战……。它们没有明显的逻辑推理方法,距离集成抽象知识(例如关于什么是对象,它们的用途以及通常的使用方式。”

Marcus与他人共同创立了机器人初创公司Robust.AI,以寻求通往可以推理的AI替代途径。就在最近,Robust宣布完成了1500万美元的A轮融资。

计算机科学家Judea Pearl是另一位主要思想家,他认为通向System 2推理的道路不只是深度学习。 Pearl多年来一直倡导因果推理(理解因果关系的能力,而不仅仅是统计关联)是构建真正智能机器的关键。正如Pearl最近所说:“深度学习的所有令人印象深刻的成就都等于曲线拟合。”

在本系列文章探讨的六个AI领域中,最后一个目标是最开放和抽象的。通往System 2 AI的途径很多。前方的道路仍然迷雾重重。这可能是一个曲折的旅程,但是在我们有生之年,它将改变经济和世界。