2020年10 月份,深度学习领域顶级会议 ICLR 2021 论文投稿结束。

这次盛会,又有大牛在深度学习领域有了新突破。这次技术的变革会带来哪些影响呢?且听东方林语娓娓道来。

人工智能应用在CV计算机视觉领域中,CNN卷积神经网络一直占据相当主流的地位。

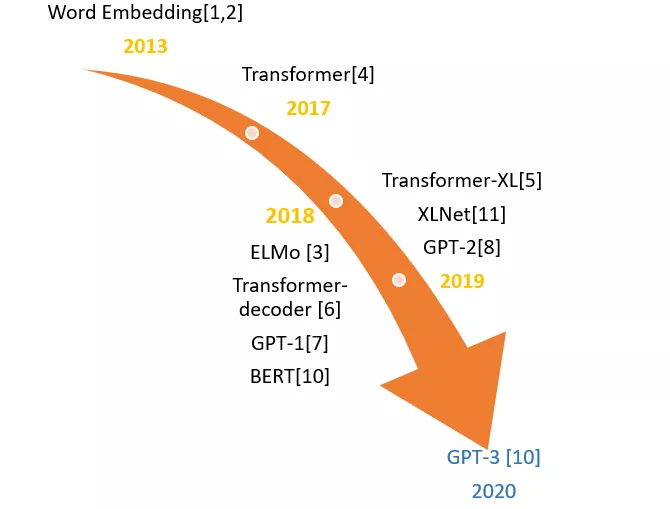

而Transformer 架构,在NLP自然语言处理任务中,得到了广泛应用。

两个领域,每项技术各有所长,彼此之间井水不犯河水。

但是,近年来不断有专家学者尝试将 NLP 领域的 Transformer 进行跨界研究,经过一段时间的试验,在一些图像场景还实现了相当不错的结果。

本次ICLR 2021 就有一篇论文,尝试将标准 Transformer 架构直接应用于计算机视觉领域,提出了一个新的 Vision Transformer 模型,并在多个图像识别基准上实现了接近甚至优于当前 SOTA 方法的性能。

SOTA也就是state-of-the-art,若某篇论文能够称为SOTA,就表明其提出的算法(模型)的性能在当前是最优的。

该研究表明,对 CNN 的依赖不是必需的,当直接应用于图像块序列时,transformer 也能很好地执行图像分类任务。

特斯拉 AI 负责人 Andrej Karpathy 专门转发了该论文,并表示:

乐见计算机视觉和 NLP 领域日益融合。

技术进步,一切皆有可能。

如果能够将NLP VS CV模型的跨界学习进行到底,图像视觉领域的Transformer能把原来的龙头老大CNN拉下马吗?

这就是一个非常有意思的命题了。

ICLR 2021 有什么值得关注的投稿吗?在知乎上,有网友这样表示:

我们正站在模型大变革的前夜,神经网络的潜力还远远没到尽头。一种崭新的强大的,足以颠覆整个 CV 和 AI 界的新模型才露出冰山一角,即将全面来袭。

人工智能是一项综合性学科,需要将基础科学、业务场景、数据质量、工程实践等紧密结合的技术领域,近年来已经融合了更多的其他方向。

人工智能的各个分支,技术上可以互相融合与替代。也可以带给我们更多的启示:

作为人类的我们,其实,如果跳出自己的舒适区,也可以跨界学习、跨界融合,以更好的适应这个多变的社会。

在数字化逐渐一统天下的现在,AI技术融合,与人类的跨界融合, 将为社会进步产生更强大的推动作用。

你认为呢?

关注东方林语,一起了解更多AI知识。