本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

神经网络就像“炼丹炉”一样,投喂大量数据,或许能获得神奇的效果。

“炼丹”成功后,神经网络也能对没见过的数据进行预测了~

然而,这种情况下,神经网络其实成了“黑匣子”——具有一定的功能,但看不见是怎么起作用的。

如果只做简单的图像分类,其实还好;但如果用在医学方向,对疾病进行预测,那么神经网络下的“判断”就不可轻信。

如果能了解它是怎么工作的,就更好了。

出于这种考虑,来自牛津大学的博士生Oana-Maria Camburu撰写了毕业论文《解释神经网络 (Explaining Deep Neural Networks)》。

在这篇论文中,她将这些“黑匣子”一个个打开,对神经网络原理进行了详细的解释。

为什么要打开神经网络“黑匣子”?

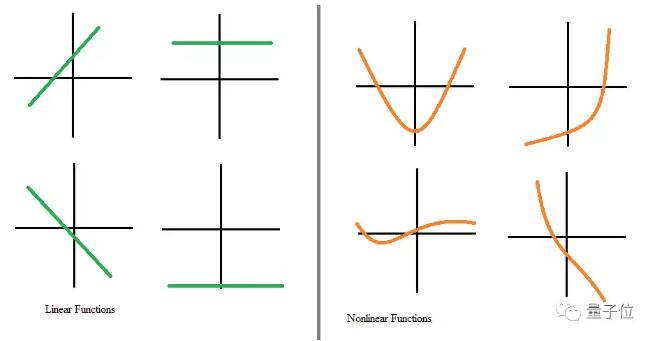

事实上,神经网络之所以起作用,最直观的原因就是,它由大量非线性函数组成。

这些非线性函数,使得网络可以学习原始数据中各种抽象级特征。

然而,也正是因为神经网络中的这些非线性函数,使得人类往往难以理解,它们是如何起作用的。

这就导致神经网络在疾病预测、信用额度、刑法等方向上“不太受欢迎”。

医生和法律相关的研究者往往更乐意采用可解释模型,例如线性回归、决策树,因为神经网络在疾病预测中的确出过问题:

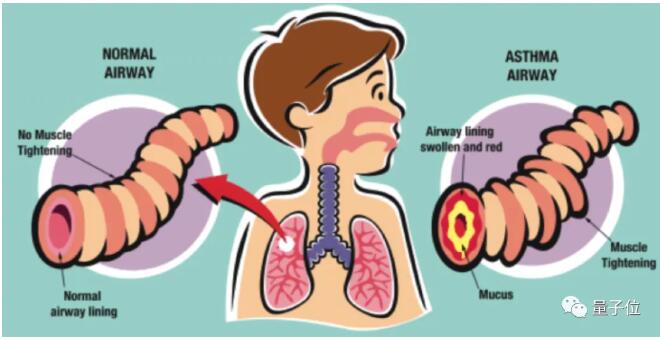

人们利用神经网络预测肺炎患者的病情发展,其中一项患者特征为是否有哮喘病史。

神经网络经过训练后预测,有哮喘病史的患者死于肺炎的可能性较低。

但其实结果恰好相反,哮喘本身会给肺炎带来雪上加霜的效果。

之所以数据表明哮喘患者较少死于肺炎,往往是因为哮喘能被及早发现,所以患者得肺炎后能被及早治疗。

如果这种神经网络被应用于实践中,将会带来非常危险的结果。

此外,即使是神经网络,也会对男女性别产生刻板印象、产生种族偏见。

例如,调查表明,有些语料库和模型,在预测再犯时,会更“偏爱”男性。

除了错误的预测和种族、性别歧视以外,神经网络还很脆弱。

无论是对图像进行小改动欺骗分类算法、还是用语音识别瞒过NLP模型,神经网络被“爆雷”的情况也不少。

为了让神经网络应用于更多的方向,也为了让我们更好地学习它的原理,作者从两个方向对神经网络进行了解释。

2种方法解释神经网络

“事后再解释”

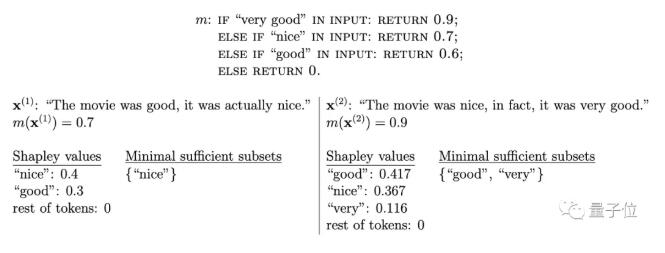

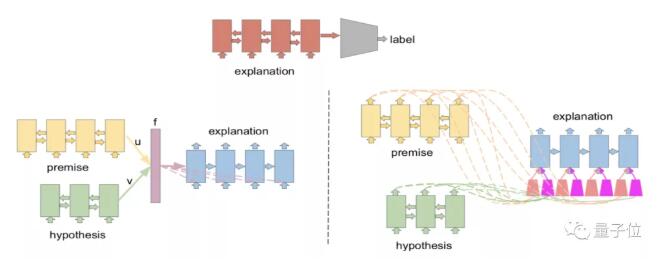

第一种方法,称之为基于特征的解释方法,又叫“事后再解释”——因为这种方法,是在神经网络训练好后,才对其输入特征进行解释的。

这种方法针对文本的词(token)、或是针对图像的超像素(super pixels),进行“事后”解释。

目前这种方法应用较为普遍,不容易出现解释偏见,但需要验证解释方法的真实性。

这里的根本原理,是研究外部解释方法给出的解释、与模型本身生成的自然语言解释之间,是否存在相关性,而相关性具体又是什么。

在论文中,作者引入了一种新的验证方法,来判断解释方法的真实性。

让神经网络自己解释

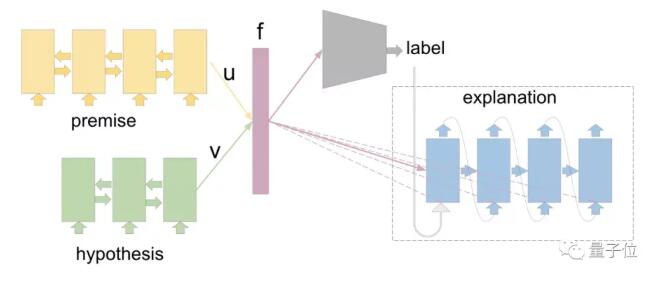

那么,如果能让神经网络一边训练、一边“解释自己”呢?

这是论文提到的第二种方法,即在模型中植入一个生成预测解释的模块,对预测的结果进行解释。

至于神经网络对自己的解释是否正确,还需要人为进行判断。

在这里面,作者同样引入了一种判断方法,对模型自己生成的解释进行判断,从而得出神经网络解释的结果。

对神经网络详细结构、具体解释方法感兴趣的小伙伴,可以戳下方论文地址查看~

作者介绍

Oana-Maria Camburu,来自罗马尼亚,目前是牛津大学的博士生,主修机器学习、人工智能等方向。

高中时期,Oana-Maria Camburu曾获IMO(国际奥数竞赛)银牌。她曾经在马普所、谷歌实习,读博期间,论文被ACL、EMNLP、IJCNLP等顶会收录。