2019年,一场人与机器的游戏对战——Open AI Five以全面压倒性的表现战胜了Dota2世界冠军战队OG。

棋类游戏一直被视为顶级人类智力及人工智能的试金石。

人工智能与人类棋手的对抗一直在不断上演中,从三子棋、五子棋、跳棋、象棋、军棋、国际象棋、再到最高水平的围棋类游戏,计算机人工智能程序都已经打败了人类。

人工智能取得的成绩让人侧目,至少在游戏领域,已经全面压倒人类。

然而在这令人侧目惊叹的表现背后,是人类远远无法企及的大数据训练的结果,以训练Open AI Five为例,看看它的学习过程消耗了多少资源:

12.8万个CPU;

256块P100;

长达数个月的训练……

如果转化成更容易理解的数据,就是相当于一个游戏选手不分日夜的持续练习45000年的游戏,才能达到同样的战果。

按照人类目前的寿命和思维容量,显然这是一个永远不可能完成的任务。

这就是目前人工智能行业,尤其是深度学习领域,当前面临的最大问题与挑战之一,具体主要包括包括:

大量的数据依赖;

长时间的学习与训练;

高昂的软硬件训练成本……

那么,解决方法是什么呢?

2020年,学术界提出了因果关系的小样本学习的概念。

如何进行小样本学习呢?其实这个概念与几年前杨强教授(现微众银行首席人工智能官)与戴文渊(现第四范式首席执行官)提出的迁移学习概念比较类似。

小样本学习与迁移学习,都可以说是学习模仿人类,看看人类是如何快速学习各种知识的。

以玩游戏为例:

星际争霸系列游戏,涉及人族、神族、虫族三个种族,数十个兵种,从战略到战术,可以演化为成千上万种打法。这个游戏,不到最后一刻,往往很难猜出谁胜谁负。因此,也成为了人工智能重点“练手”的即时策略对战游戏。

对于喜欢玩即时策略游戏的人而言,如果会玩星际争霸系列游戏,那么其他的即时策略类游戏,比如:暴雪的魔兽争霸,DOTA2系列;微软的帝国时代系列等等,就很容易上手了。

因为可以运用之前的游戏经验,玩同类型的游戏,其背后的思路方法是类似的,触类旁通,举一反三,就是这个意思。

同样的,对于机器学习而言,在少量样本上快速泛化的核心,就是借助先验知识(类似人类的经验)。

而小样本学习就致力于通过极少的训练数据(1-5个样本/类)来实现模型的泛化(机器学习算法对新鲜样本的适应能力)。

这里面,还要提出一个是指机器学习“预训练”的概念。

具体来说,就是在大型数据集上,学习一个强大的神经网络作为特征提取器,例如:

CV(计算机视觉)里面常见的在ImageNet上预训练的ResNet网络;

NLP(自然语言处理)里面在Wikipedia上预训练的BERT;

都是代表一种特征表达的先验知识,也就是预训练。

迁移学习里面,依据的“库伯学习圈”理论,也是类似的原理。

预训练相当于给了小样本学习一个好的起点,就像一个人在上课前预习了大量的知识点。

当然,如果想获得更好的效果,还要了解一下元学习(meta learning)的概念,简单来说就是通过不断学习,找到更好效果的机器学习方法。

所以,人工智能与机器学习,简单来说,就是不断学习和模仿人类思维的过程。

关注东方林语,一起了解更多人工智能小知识。

附:

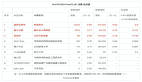

NeurIPS 2020接收的小样本学习论文

Interventional Few-Shot Learning,网址如下:

https://arxiv.org/abs/2009.13000

论文的代码在Github上开源网址:

https://github.com/yue-zhongqi/ifsl