最近,我与我最喜欢的新晋思想家就高性能和低性能AI进行了辩论,这让我想起了自己一年多以前写的东西,因此我决定拾起这些尘封的想法。人工智能的技术炒作太多了,有时应该回到其哲学根源。而在围绕AI的所有哲学争论中,最重要的就是对强弱AI的争论。

从技术角度来看,我赞成这样的想法,即在实现某种形式的强大或通用AI的领域,我们实现了一两个突破。但从哲学的角度来看,仍然存在一些需要调和的挑战。许多挑战都可以通过上世纪奥匈帝国数学家开创的晦涩理论以及神经科学研究的领先领域之一来解释。

在AI理论中,低性能AI系统通常只是看起来智能,而高性能AI机器则真正具备思考能力。这里的思考是指真正的思考,而不仅仅是模拟的思考。这种困境通常被称为“高性能AI假设”。

在一个用数字助理和算法击败围棋世界冠军和魔兽世界2团队的世界中,机器是否可以智能地行动这个问题似乎很愚蠢。在有限的一些环境中,例如医学研究、围棋、旅行等,我们已经能够构建大量可发挥其智能作用的AI系统。大多数专家都认为低性能AI绝对是可能的,但对于高性能AI仍然存在极大的怀疑。

机器可以思考吗?

自从艾伦·图灵在1950年发表著名论文《计算机与智能》以来,这些问题就一直困扰着计算机科学家和哲学家。当大多数科学家甚至无法就思维的正式定义达成共识时,确定这个问题的答案似乎也不公平。

为了说明围绕高性能AI假设的困惑,我们可以借鉴著名计算机科学家Edsger Dijkstra的幽默表达。他在1984年的一篇论文中将机器是否可以思考的问题与诸如“潜艇会游泳吗?”或“飞机能飞吗?”之类的问题进行了比较。

尽管这些问题看起来很相似,但大多数说英语的人都会同意,飞机实际上可以飞行,但潜艇不会游泳。这是为什么?这种比较的基本观点是,如果没有对思维的统一定义,那么对机器是否可以思考的痴迷似乎无关紧要。

在对高性能AI的主要反对意见中,从本质上讲,不可能确定机器是否能够真正思考。该论证源于有史以来最著名的数学定理之一。

哥德尔不完全性定理

当我们谈论历史上最伟大的数学理论对思维方式产生了广泛的影响时,哥德尔的不完全性定理应该有一席之地。

1931年,数学家库尔特·哥德尔(Kurt G?del)通过证明其著名的不完全性定理证明了演绎法的局限性。哥德尔定理指出了任何形式的可以进行算术运算的理论,但有真实的陈述在该理论内没有证据。

长期以来,不完全性定理一直被用作反对强人工智能的对象。该理论的支持者认为,高性能AI主体将无法真正思考,因为它们受到不完全性定理的限制,而人类思维显然不受限制。

该论点引发了很多争议,许多高性能AI的从业者也拒绝接受它。高性能AI学派最常讲的论点是,无法确定人类的思维是否服从于哥德尔定理,因为任何证据都需要形式化人类知识,而我们知道这是不可能的。

意识论证

在人们关于AI的激烈辩论中,我最喜欢的论点是意识。机器真的可以思考还是可以模拟思考?如果机器在将来能够进行思考,这意味着它们将需要有意识(即意识其状态和动作),因为意识是人类思维的基石。

对高性能AI的怀疑引发了各种争论,包括经典的数学理论(例如G?del的不完全性定理)到AI平台的纯粹技术局限性。然而,生物学、神经科学和哲学的交集仍然是争论的焦点,并且与人工智能系统的意识有关。

什么是意识?

关于意识有很多定义和争论,这足以劝退多数人继续追究其在AI系统中的作用的论点。意识的大多数定义都涉及自我意识或实体了解其心理状态的能力,但是,当涉及到AI时,自我意识和精神状态也没有明确定义,因此我们就像飞速掉进兔子洞一样,陷入了迷茫无措。

为了适用于AI,意识理论需要更加务实和技术化,并且要少一些哲学性。我最喜欢的遵循这些原则的意识定义来自物理学奖获得者Michio Kaku,他是纽约大学理论物理教授,也是弦理论的创造者之一。

几年前,Kaku博士提出了他所谓的“意识的时空理论”,将生物学和神经科学等领域对意识的定义汇总在一起。卡库博士在其理论中对意识的定义如下:“意识是使用各种参数(例如温度,空间,时间以及与他人有关的参数)的多个反馈回路创建世界模型的过程,以实现目标(例如寻找伴侣,食物,住所)。”

意识的时空定义直接适用于AI,因为它基于大脑创建世界模型的能力,不仅基于空间(如动物),还基于与时间的关系(向后和向前)。从这个角度来看,卡库博士将人类意识定义为“一种意识形式,它可以创建世界模型,然后通过评估过去来模拟未来,从而及时地对其进行模拟。”换句话说,人类意识与我们对未来的计划能力直接相关。

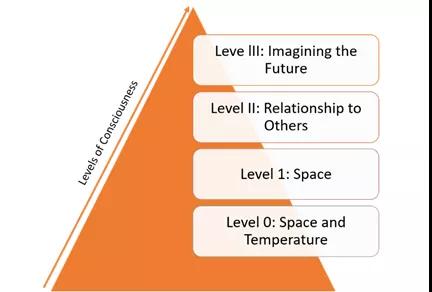

除了其核心定义外,意识的时空理论还包括几种意识类型:

- 级别0:包括行动不便的植物等生物,它们使用诸如温度之类的少数参数创建其空间模型。

- 级别1:像爬行动物这样的生物,它们活动并且具有神经系统。这些生物使用更多其他参数来形成其空间模型。

- 级别2:诸如哺乳动物之类的生物不仅建立在空间基础上,而且还建立在与他人有关的世界模型上。

- 级别3:了解时间关系并具有想象未来的独特能力的人类。

AI系统有意识吗?

意识是AI圈中最激烈的辩论主题之一。这里的AI意识,指的是AI能够自我意识到其“心理状态”的能力。前文介绍了一个由著名物理学家Michio Kaku博士率先提出的框架,用于从四个不同的层面评估意识。

在卡库博士的理论中,0级意识描述了诸如植物之类的生物,它们根据诸如温度之类的一些参数评估其真实性。爬行动物和昆虫在使用包括空间在内的新参数创建世界模型时表现出1级意识。2级意识涉及根据情感和与其他物种的关系创建世界模型。哺乳动物是与2级意识相关的主要种群。最后,我们可以根据涉及未来模拟的世界模型将人类意识归于3级意识。

基于Kaku博士的意识框架,我们可以评估当前一代AI技术的意识水平。大多数专家都认为,当今的AI代理可以分为1级或2级早期意识。将AI代理排名为1级涉及许多因素,包括流动性。

如今,许多AI代理已经能够实现移动性并根据其周围的空间开发其环境模型。但是,大多数AI代理在受限的环境之外进行操作都有很多困难。

空间评估并不是将AI代理置于1级意识的唯一因素。用于创建模型的反馈回路的数量是要考虑的另一个超重要因素。

让我们以图像分析为例。即使是最先进的视觉AI算法,也是使用相对少量的反馈回路来识别对象。如果我们将这些模型与认知能力,昆虫和爬行动物进行比较,它们似乎并不复杂。所以,是的,当前的人工智能技术具有昆虫的意识。

进入二级意识

一些AI技术已经稳定地展现出2级意识的特征,有几个因素促成这一发展。人工智能技术正在获得更高级的理解和模拟情绪,以及感知周围的情绪反应。

除了基于情感的AI技术发展外,AI代理在团体环境中的运行效率也越来越高,在团体环境中,他们需要相互协作或竞争才能生存。在某些情况下,小组合作甚至可以创造出新的认知技能。具有2级意识的AI代理的最新案例,我们能想到DeepMind和OpenAI等公司的工作。

最近,DeepMind进行了一些实验,其中需要AI代理住在资源有限的环境中。当资源丰富和贫瘠时,人工智能代理表现出不同的行为。由于代理需要相互交互,因此行为发生了变化。

在最近的OpenAI模拟实验中也能找到一个有趣的示例,在该实验中,AI代理能够使用少量符号创建自己的语言,以便更好地在其环境中共存。

主流的AI解决方案仍处于早期阶段,但提高AI代理的意识水平是当前AI技术堆栈中最重要的目标之一,2级意识是下一个研究领域。

升至三级意识

目前,人工智能系统中的三级意识仍是一个活跃的辩论主题。但是,最近的系统(例如OpenAI Five或DeepMind Quake III)已经清楚地显示了AI代理进行长期计划和协作的能力,因此我们可能不日实现这个目标。

AI系统有意识吗?我的答案是肯定的。将Kaku博士的时空意识理论应用到AI系统中,很明显AI代理可以表现出一些基本的意识形式。考虑到当前AI技术的能力,我将AI代理的意识置于I级(爬行动物)或II级基本水平。

至于三级,虽然距离尚远,但我认为这绝不是天方夜谭。

本文转载自微信公众号「读芯术」,可以通过以下二维码关注。转载本文请联系读芯术公众号。