By Frank Lee is the co-founder and CEO of Eurika Solutions

在过去的几年中,人工智能领域已进入高速增长阶段,这在很大程度上受诸如深度学习(DL)和强化学习(RL)之类的机器学习方法的推动。这些技术的组合展示了在解决各种问题方面的空前性能,这些问题从以超人的角度玩Go到像专家一样诊断癌症。

在我们以前的博客中,智能物联网和雾计算趋势以及物联网中无处不在的计算机视觉的兴起,我们谈到了物联网中DL的一些有趣用例。应用将是广泛而深入的。它们将在未来几十年内刺激对新型处理器的需求。

深度学习工作流程概述

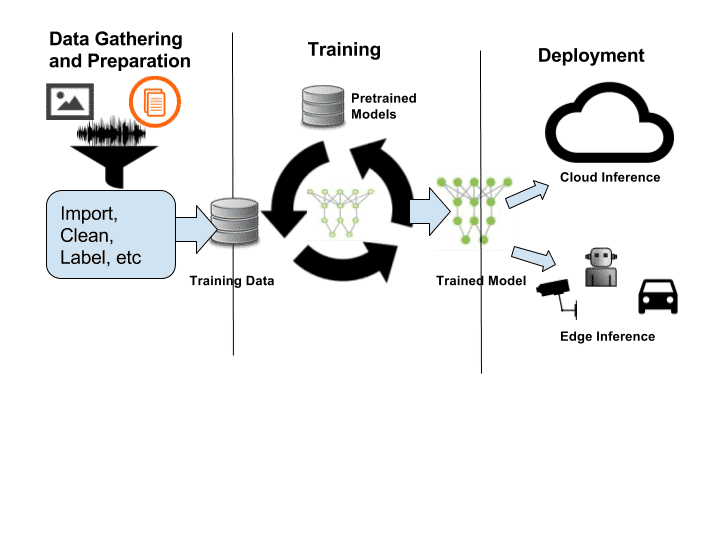

DL / RL创新正以惊人的速度发生(每年在众多与AI相关的会议上发表数千篇有关新算法的论文)。尽管预测最终的解决方案为时尚早,但硬件公司正在争相构建处理器、工具和框架。他们试图利用多年研究人员的经验来确定DL工作流程中的痛点和瓶颈(图1)。

图1:深度学习基础流程

训练DL模型的平台

让我们从培训平台开始。基于图形处理单元(GPU)的系统通常是训练高级DL模型的选择。Nvidia早已意识到将GPU用于通用高性能计算的优势。

GPU有数百个计算核心,它们支持大量的硬件线程和高吞吐量的浮点计算。 Nvidia开发了Compute Unified Device Architecture(CUDA)编程框架,使GPU友好地供科学家和机器学习专家使用。

CUDA工具链改善了耗时问题,为研究人员提供了一种灵活而友好的方式来实现高度复杂的算法。几年前,Nvidia恰当地发现了DL的机会,并为大多数DL运营不断开发CUDA支持。 Caffe、Torch和Tensorflow等标准框架均支持CUDA。

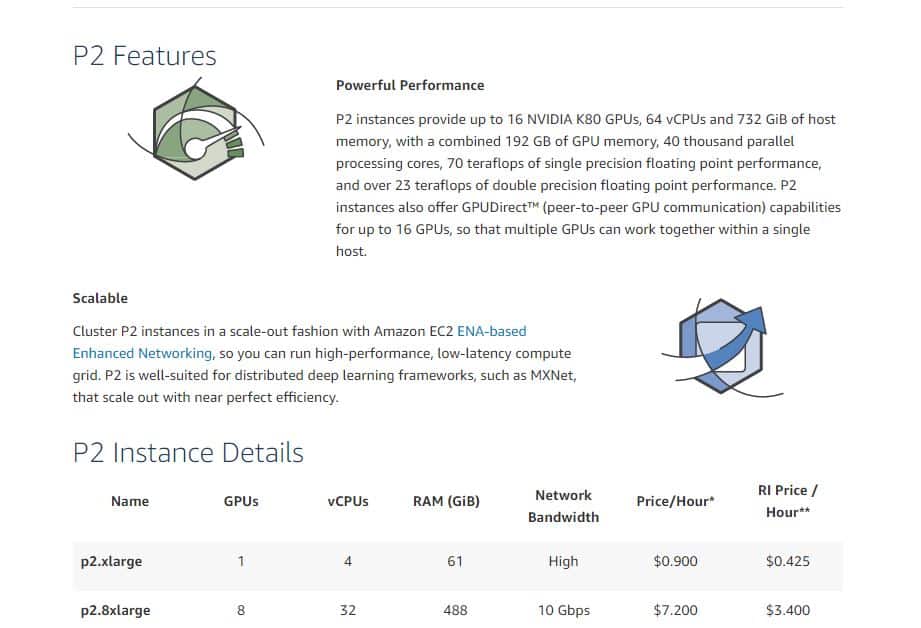

在AWS之类的云服务中,开发人员可以选择使用CPU还是GPU(更具体地说是Nvidia GPU)。平台的选择取决于神经网络的复杂性、预算和时间。基于GPU的系统通常可以比CPU减少训练时间几倍,但价格更高(图2)。

图2:AWS EC2 GPU实例

GPU / CPU的替代品

替代品来了。 Khronos在2009年提出了OpenCL,这是一种用于在各种硬件(例如CPU、GPU、DSP或FPGA)上进行并行计算的开放标准。它将使其他处理器(如AMD GPU)进入DL培训市场,为开发人员提供更多选择。

但是,它在DL库支持方面仍落后于CUDA。希望这种情况在未来几年内会有所改善。英特尔还通过收购Nervana开发了针对DL培训定制的处理器。

DL推理的竞争格局

DL推理是一个竞争激烈的市场。通常可以根据用例的要求在多个级别上部署应用:

- 云/企业:图像分类、网络安全、文本分析、NLP等。

- 智能网关:生物识别、语音识别、智能代理等。

- 边缘端点:移动设备、智能相机等。

云推理

在Google、Facebook、百度或阿里巴巴等互联网巨头的大力推动下,云推理市场将实现巨大的增长。例如,Google Cloud和Microsoft Azure提供了非常强大的图像分类、自然语言处理和面部识别API,开发人员可以轻松地将其集成到他们的云应用中。

云推理平台将需要可靠地支持数百万并发用户。扩展吞吐量的能力至关重要。此外,降低能耗是控制服务运营成本的另一个重中之重。

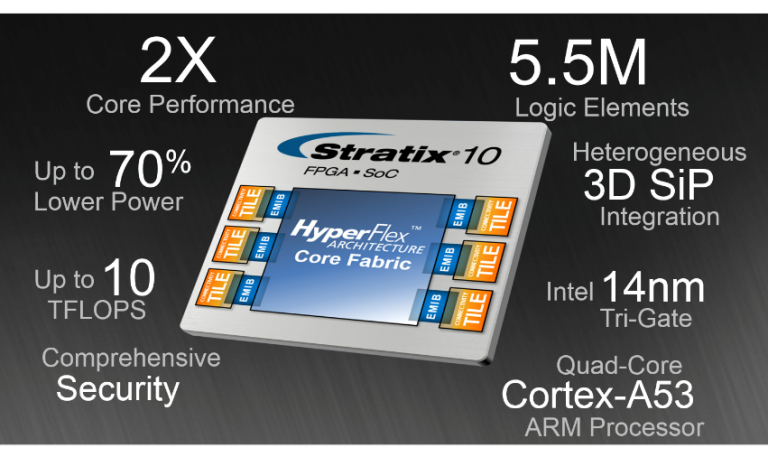

在云推理空间上,除GPU外,数据中心还使用FPGA或定制处理器来使云推理应用更具成本效益和功效。例如,Microsoft Project Brainwave使用英特尔FPGA来证明在运行诸如CNN、LSTM等的DL算法时的强大性能和灵活性。

图3:Intel 14nm Stratix FPGA

FPGA具有优势。硬件逻辑、计算内核和内存配置可针对特定类型的神经网络进行定制,从而使其更有效地处理预训练模型。但是,一个缺点是与CPU或CUDA相比编程困难。如上一节所述,OpenCL将有助于使FPGA对软件开发人员更加友好。

除了FPGA之外,Google还制造了定制的处理器,称为TPU。它是一种专注于高效矩阵计算的ASIC。但是,仅Google自己的服务支持该功能。

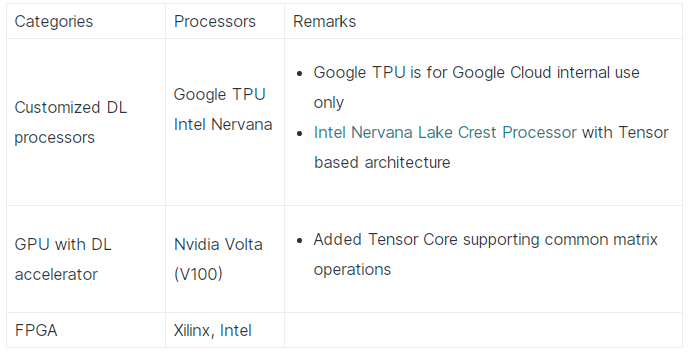

以下是DL云推断中的一些参与者。

用于智能边缘计算的嵌入式DL推理

在边缘,DL推理解决方案需要解决针对不同用例和市场的多种需求。

自动驾驶平台

自动驾驶平台目前是最热门的市场,最新的DL和RL方法正在应用中,以实现最高水平的自动驾驶。 Nvidia一直领导着从Tegra到Xavier的几类DL SoC市场。 例如,Xavier SoC内置于Nvidia的Drive PX平台中,该平台可实现多达320个TFLOP。 它的目标是5级自动驾驶。

移动处理器

另一个快速增长的领域是移动应用处理器。 DL启用了智能手机上以前无法实现的新功能。 一个例子是苹果将神经引擎集成到A11 Bionic芯片中,从而使其能够在iPhone X上添加高精度面部锁定。

中国芯片制造商海思半导体还发布了麒麟970处理器,该处理器具有神经处理单元(NPU)。 华为的一些最新智能手机(图4)已经使用新的DL处理器进行了设计。 例如,使用NPU,智能手机相机会“知道”正在查看的内容,并会根据场景的主体(例如人、植物、风景等)自动调整相机设置。

图4:Huawei Mate 10 Pro –主题识别相机

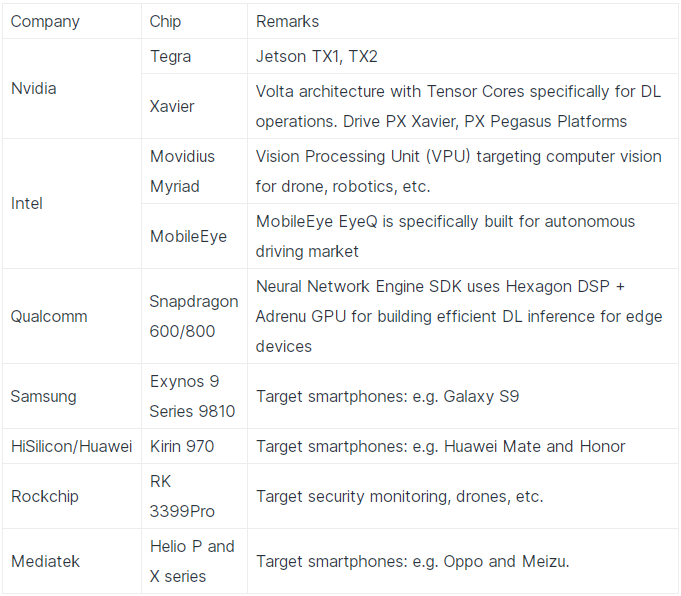

下表列出了一些用于DL推理应用的处理器。

新架构

值得一提的是,有一类新的处理器,称为神经形态处理器,它紧密模仿人类大脑神经元和突触的机制。他们可以实现一种称为“脉冲神经网络(SNN)”的神经网络,它可以在空间和时间域中学习。

原则上,与现有的DL架构相比,它们具有更高的能源效率,并且在解决在线机器学习问题方面具有优势。

IBM的TrueNorth和英特尔的Loihi基于神经形态架构。研究人员正在探索这些芯片的功能,显示出一些潜力。目前尚不清楚何时将新型处理器准备用于广泛的商业用途。诸如Applied Brain Research和Brainchip之类的许多初创公司也专注于这一领域,开发工具和IP。

图5:英特尔Loihi

这是一个有趣的时代

在短短的几年内,AI / DL / RL / ML已成为许多行业的重要工具。从IP、处理器、系统设计到工具链和软件方法论的底层生态系统已经进入了快速的创新周期。新的处理器将支持许多以前无法实现的新物联网应用。

但是,物联网和机器学习应用仍在不断发展。芯片设计人员和开发人员将需要几代处理器才能提出正确的架构组合,从而满足各种市场的需求。