刚刚,IBM宣布达到了量子计算新的里程碑,目前最高的64量子体积。与去年相比,其量子计算机的性能又提高了一倍。

就在几个月前,霍尼韦尔宣称已经研发出世界最强大的量子计算机。

此次,IBM宣布的最新进展直接对飚霍尼韦尔,量子计算领域的竞争逐渐白热化。

霍尼韦尔放狠话,IBM不Care,量子计算谁最强

早在今年3月,霍尼韦尔就「放狠话」:在接下来的三个月,我们将推出世界上性能最高的量子计算机。

可能谷歌、IBM和英特尔也没想到,6月18日会杀出这样一个劲敌。

霍尼韦尔宣布:「我们建造了目前世界上性能最好的量子计算机」。

其最新量子计算机的量子体积得分达到64,是IBM和谷歌竞争对手的两倍。2019年,IBM的量子体积达到了32。

霍尼韦尔这个「最好」可不是自夸的,这是基于IBM的量子计算机衡量基准而得到的结果。

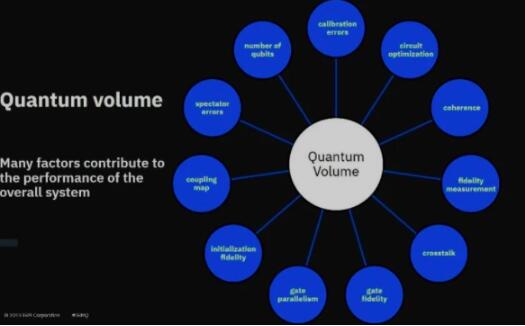

「量子体积」这一概念最先由IBM提出,量子体积是用于度量量子计算机性能的指标,而不是仅仅以量子比特(Quantum Bit)数量作为度量标准,这一指标的提出旨在摆脱该行业原有相对过时的评估方法。

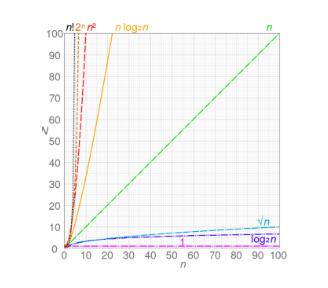

量子体积的影响因素包括量子比特数、门和测量误差、设备交叉通信、以及设备连接和电路编译效率等。量子体积越大,量子计算机就越强大,对时间和空间复杂性的处理能力越好。

量子体积能更全面地度量量子计算机的能力,包括度量可解决问题的复杂程度等。

要更好地理解IBM和霍尼韦尔的量子计算孰优孰劣,首先要知道,他们采用的是两种完全不同的技术路线。

三英战吕布 : 超导量子计算VS离子阱

目前量子计算主要分为固态器件和光学路线两大类路线,谷歌、IBM、英特尔这三家公司属于「固态器件路线派」,霍尼韦尔的离子阱走的技术路线则属于的是「光学器件派」。

光学路线的离子阱在相干时间上就有优势,但是其可操控性上很弱,而且与经典计算很难实现兼容。

目前世界上80%以上的量子计算机都采用了固态器件的路线,在与经典计算兼容等方面固态器件都具有明显优势,离子阱等光学路线更多是在科研上用的比较多。

目前量子计算的主要技术路线(数据来源:华为、赛迪)

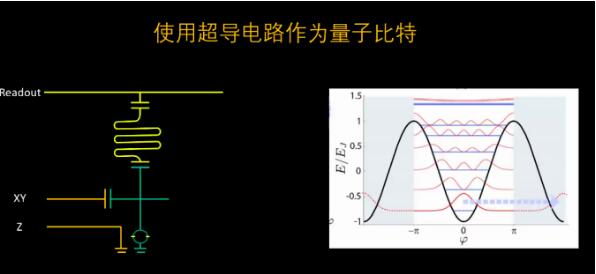

超导量子计算是目前进展最快最好的一种固态量子计算实现方法。

超导量子电路的能级可以通过外加电磁场进行干预 ,电路更容易实现定制化开发,而且现在的集成电路工艺已经十分成熟,超导量子电路的可扩展性优势明显。

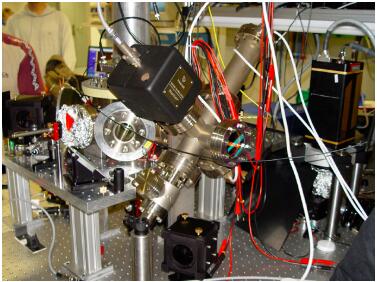

图片来源:腾讯量子实验室

但是也有些问题存在,由于量子体系的不可封闭性,环境噪声、磁通偏置噪声等大量不受控的因素存在,经常会导致量子耗散和相干弱化。此外,超导量子系统工作对物理环境要求极为苛刻,比如,超低温是超导量子计算实现过程中不可避免的问题。

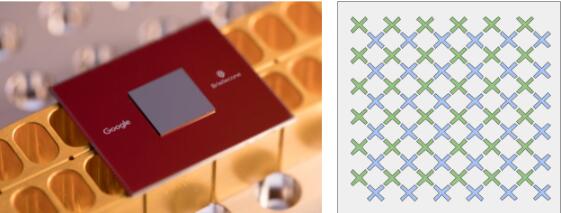

谷歌Bristlecone量子芯片

除了IBM,谷歌和英特尔等企业也在积极开展超导量子研究。谷歌量子人工智能实验室发布的Bristlecone量子芯片,可实现 72 个量子比特长度上的单比特门操纵,单量子比特门最佳保真度达到了99.9%。

此前,曾有专家表示,霍尼韦尔声称拥有世界上最快量子计算机有炒作嫌疑,因为没有解决世界上任何问题,只是参数上的进步。

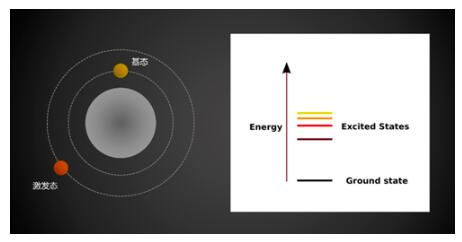

霍尼韦尔的离子阱是利用电荷与电磁场间的交互作用力牵制带电粒子的运动,将受限离子的基态和激发态两个能级作为量子比特。

量子态被存储在单个离子阱中,并从其中读取信息。量子比特可以通过它们在阱中的运动直接相互作用,也可以通过光和微波的发射和吸收相互作用。

尽管离子阱技术本身的发展可以追溯到 1980 年,但是利用离子阱技术实现量子计算由奥地利的量子科学家 Circa 和 Zoller 于 1995 年首次提出。

2003年,该实验室实现利用失谐激光束照射和激光冷却控制非门,同年该实验室第一次成功地利用离子阱技术实现了 Deutsch-Jozsa 算法。

奥地利因斯布鲁克的离子阱量子计算机

离子阱量子计算具有量子比特品质高,相干时间长、量子比特制备和读写效率高的优点。

然而,离子阱技术也面临不少问题,由于外加激光不稳定,电磁场噪声导致量子比特相干性弱化,而且离子阱难以多条离子链共存,可扩展性差。

霍尼韦尔之所以能在离子阱量子计算方面实现飞跃,部分原因是其在2015年突破了一项目关键技术,能够使用激光捕获处于叠加状态的带电粒子。

自2017年以来,IBM的量子体积每年都翻一番。在2019年,IBM表示,其名为Raleigh的量子计算机的量子体积达到32,而一年前只有16。

有分析指,霍尼韦尔的离子阱更学院派,IBM的方案更有实用价值。

量子计算:超低温也能加热人工智能

尽管量子计算仍处于早期阶段,但已经有了许多创新和突破。那它在人工智能领域将发挥着什么样的作用呢?

数据增强变的简单易行

现在的生成模型是不仅限于回答问题,还能够输出图像、音乐、视频等等。

假设你有很多人脸照,但其中很多不是正面照,生成模型可以帮你从中创建更精确的「正脸」。

将量子处理单元插入经典框架可能会大幅度提高生成图像的质量。

这如何帮助我们提升经典机器学习模型?如果你尝试使用少量的人脸数据集训练经典的人脸检测模型,但性能并不是很好,可以使用量子增强的生成模型来增强数据集,从而显着改善模型性能。

自然语言处理更懂「人话」

自然语言处理(NLP)算法将在量子计算上取得「意义感知」的突破。

「意义感知」是指计算机实际上可以理解整个句子,不仅仅是单词,并且可以将其感知能力扩展到整个短语,甚至整篇文章。而BERT等语言模型的进一步提升,有赖于量子计算的强大算力。

随着量子计算机发展,自然语言处理的应用将更加广泛。

执行效率更高,新的算法设计成为可能

AI和ML是基于过去的经验学习解决方案的好方法。

比如,告诉计算机什么是猫可能会有点儿挑战,因为它学不会。如果你用足够多的「猫片」训练神经网络,计算机就能够正确识别出其他的猫。

将这些数据放在量子计算机上运行,就可以大大提升AI和ML算法的执行效率。

对于某些算法,甚至可达到指数级增长。量子计算机不只是执行任务更快,而且它能够执行以前不可能完成的任务。

让金融模型更智能

当前,人工智能在金融领域的应用也越来越广泛。

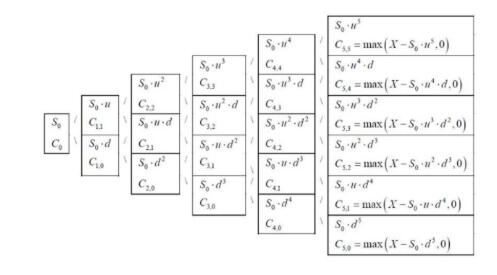

量子物理学是概率论,金融市场预测某种程度上也是,量子计算机可以无限制地建立候选模型,有潜力更好地预测分布,从而得出更准确的答案。

基本思想就是,一些问题是需要AI生成新的数据才能做出决定。解决此问题可能需要提出一个潜在的模型来解决未知状况下的概率分布问题,而这是量子计算的强项。

量子计算和经典计算是协同而非竞争

就机器学习而言,经典计算和量子计算有着协同工作的潜力,可以利用云计算的弹性,以及量子计算强大的计算能力来协同工作。

经典计算和量子计算两者都有优势,量子计算目前的发展使其成为解决方案的一部分。随着时间的流逝,这两种计算方式都将继续发展。

在传统GPU和ASIC上加速工作负载的能力的同时还利用量子计算的能力,能够让量子计算更快,结果更可靠。

在不久的将来,也许我们能用上量子计算,用它的无限算力来降低这个世界的复杂性。