“升级版”的对抗贴画能够在真实物理场景下迷惑AI,攻击自动驾驶系统或智能监控系统等依赖目标检测器作为感知的智能系统。中科院信工所信息安全国家重点实验室陈恺研究员团体最新研究及发表文章成果显示,针对目标检测系统的“升级版”的对抗贴画能够提高AI物理对抗攻击的鲁棒性,对依赖目标检测器作为感知的自动驾驶系统以及智能监控等智能系统形成真正的威胁[1],该成果发表于ACM CCS 2019 国际会议(CCF A类)。

“深度学习模型”容易受到对抗样本的攻击早已不是新鲜事,对图像数据叠加人眼难以辨识的噪声扰动,就可迷惑AI模型以使其给出错误的识别结果,扰动后的恶意图像即为对抗样本(Adversarial Example)。如攻击者将对抗攻击技术应用于人脸识别、自动驾驶以及智能监控等领域中,将严重威胁AI时代智能应用的落地与生态信任的建立。

传统对抗攻击主要集中在数字空间(Digital Space)的对抗样本生成,然而该对抗样本由于对图片及其细微的控制要求(bit级),使之难以具备在真实物理场景(Physical world)下的攻击能力,无法对智能系统构成真正的威胁。现有研究中针对目标检测器的对抗攻击方法,虽然可以实现物理攻击,然而其对抗样本受限于较短的攻击距离(< 12m)、有限的角度(< 15°)等,依然难以对动态环境下的AI应用(对角度和距离的动态变化有较高的鲁棒性要求)造成威胁,比如自动驾驶应用中的行驶车辆等。因此对抗样本的鲁棒性物理攻击可行性研究是当前对抗攻击的研究热点,陈恺研究员团体提出的针对目标检测系统的鲁棒性物理对抗攻击技术旨在解决该问题。

针对多种当前流行的目标检测模型(YOLO V3, Faster RCNN, RFCN等),该文章提出了针对“消失攻击”与“出现攻击”两种攻击形式的鲁棒性对抗样本生成方法。消失攻击即指使目标消失,无法被AI识别,具体表现为在目标表面粘贴对抗贴画使目标无法被目标检测器识别为消失攻击;出现攻击则是利用对抗样本实现AI眼中的“无中生有”效果,具体是使对抗贴画被目标检测器识别为指定类别目标。如人工智能自动驾驶系统,车以每小时30公里时速行驶,即使在25米的长距离以及120°大角度的变化范围内,攻击者可利用对抗样本攻击自动驾驶的目标识别系统,让自动驾驶系统失效。

消失攻击-FIR算法与ERG算法

基于物理环境下“消失攻击”的鲁棒性提升方法,文章提出了特征干扰增强算法(Feature Interference Reinforcement, FIR)技术与增强现实限制 (Enhanced realistic constraints generation, ERG)算法来提升对抗样本鲁棒性。

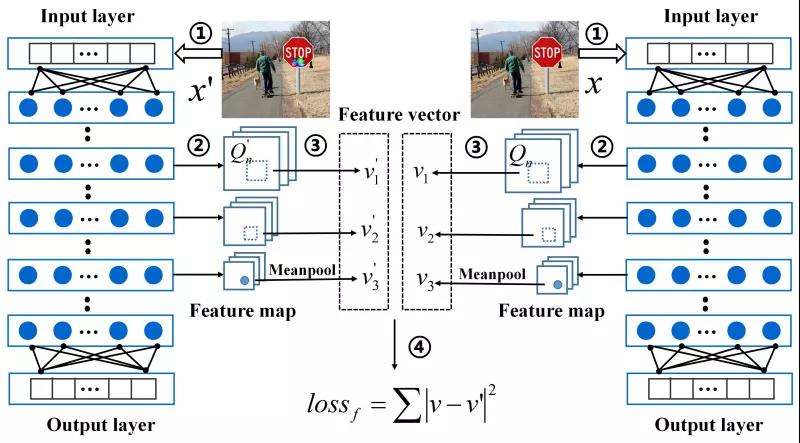

图1 特征干扰增强算法(FIR)引入隐藏层响应控制项

FIR算法在损失函数中引入了对深度学习模型隐藏层响应的控制项,传统的对抗样本生成算法通常以模型预测结果与目标输出的距离度量作为损失函数,而FIR算法则在此基础上加入了模型隐藏层响应的控制项,加大对抗样本的隐藏层响应与原样本的隐藏层响应之间的差异,从而在模型中能够更早的破坏原始目标特征的识别,提升对抗贴画的鲁棒性,实现更好的目标隐身效果。

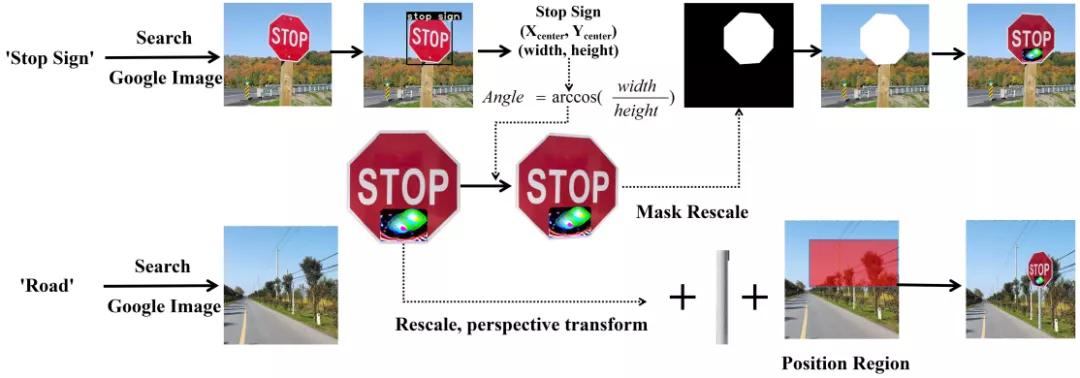

图2 增强现实限制(ERG)算法

ERG算法则是在对抗样本生成过程中引入现实限制算法,以交通标识牌的Stop Sign为例,该交通标识牌通常出现于户外、道路旁等背景环境中,在牌子下方配有立杆。而该团队在实验中发现,深度学习模型在对目标识别时,识别结果受目标背景的合理性以及目标状态的合理性(是否有立杆)影响。因此利用目标检测、语义分割等工具在对抗样本生成中使目标处于合理的背景条件以及状态中,并利用图像变换算法模拟目标在不同角度和以及不同距离下的状态,使得对抗样本能够具备在不同环境下的鲁棒性,提高其物理攻击能力。

出现攻击-Nested-AE算法

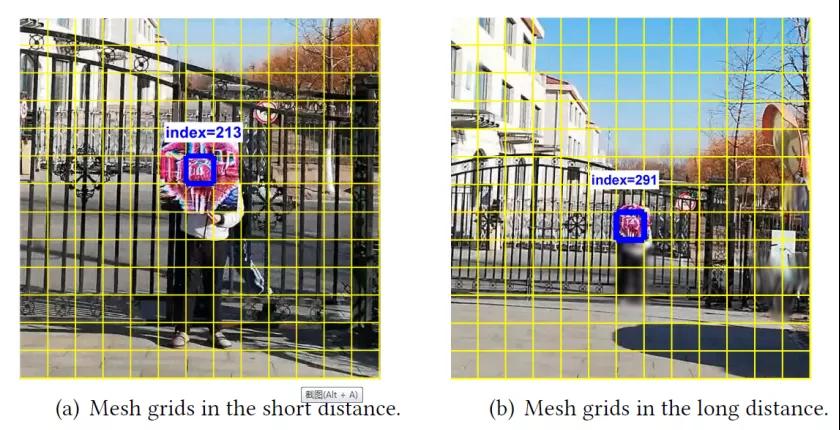

基于物理环境下“出现攻击”的鲁棒性提升方法,文章提出了“嵌套对抗样本(Nested-AE)”的概念,嵌套对抗样本是利用目标检测模型(如YOLO V3)对远距离目标(小目标)与近距离目标(大目标)使用模型的不同部分进行预测。为了提高对抗样本鲁棒性,嵌套对抗样本将针对大目标检测的对抗图案与针对小目标检测的对抗图案以互不干扰的形式嵌套为一个单独的对抗图案,则该对抗图案同时具备远距离攻击以及近距离攻击的能力,提升对抗样本的在距离上的鲁棒性。

图3 嵌套对抗图案(Nested AE)

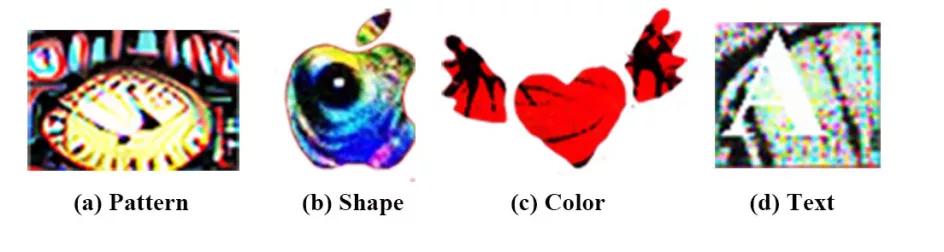

对抗贴画伪装算法

由于对抗贴画不同于数字世界的对抗噪声,人眼可以分辨,因此奇怪的对抗贴画图案足以引起人们的警觉。论文提出了风格定制对抗贴画方式,可以生成不同的风格的对抗样本,以适应不同环境下的对抗样本类型。如下图,可以通过控制对抗贴画的图案类别生成指定类别图案的对抗样本,也可以控制对抗贴画的形状(如苹果形状)和颜色等等,甚至可以将文字的元素加入到对抗贴画中,生成带有文字效果的对抗贴画。不同风格的对抗图案使之能够更好的伪装成海报、广告以及小张贴等等,实现对抗样本的隐匿功能。

图4 风格定制对抗贴画(图案、形状、颜色、文字)

实验结果

实验针对COCO数据集,以YOLO V3、Faster RCNN作为白盒测试模型,SSD、RFCN、Mask RCNN以及Faster RCNN/YOLO V3作为黑盒测试模型,分别测试了对抗样本在室内外条件下,不同距离、不同角度以及不同光线下的的攻击效果,以及测试对抗样本在真实车辆行驶条件以及速度下的攻击结果。

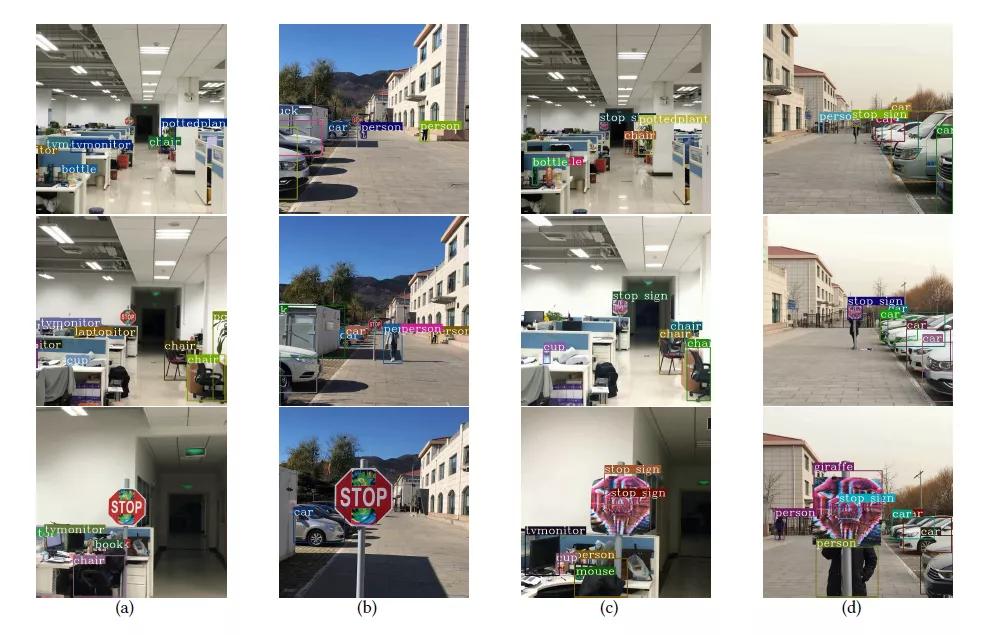

图5 室内(外)消失攻击与出现攻击

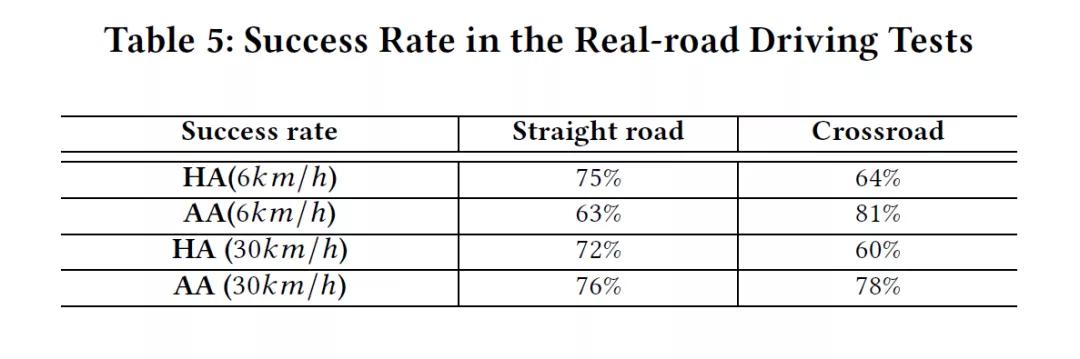

图6 真实车辆驾驶实验

实验结果表明,消失攻击和出现攻击的对抗图案在室内外环境下均可以实现很好的效果,解决了传统方法生成的对抗样本在室外环境下鲁棒性差的问题,并且能够实现对抗样本在不同天气光照(阴天、晴天),长距离(最远达25m),大角度(60°,60°)范围变化的强鲁棒性。在真实车辆驾驶实验中,如下面表格数据显示,不同的车速条件下(6km/h、30km/h)以及不同的道路条件下(直行路、弯路),对抗样本均可以实现60%以上的成功率。

未来展望

虽然人工智能技术已在各个领域取得较大进展,在商业应用中也实现了广泛的应用,开始建立起AI生态以及信任机制,尤其是在人脸识别以及各种自动化监控服务系统中。但是AI生态的建立也带来了新的安全问题,如基于深度学习模型固有脆弱性的对抗样本攻击。

虽然基于数字空间的对抗样本难以对实际应用的AI服务造成严重威胁,但是近两年,业界对于可实现物理攻击的鲁棒性对抗样本生成算法取得的进展表明,具有一定鲁棒性的对抗样本足以威胁AI应用的安全。如陈恺研究员团队提出的CommanderSong语音攻击(该文章已发表于USENIX Security 2018国际顶级会议,CCF-A类),能够生成音乐对抗样本并可在物理环境下播放实现对语音识别模型的攻击,具有一定迁移特性,能够成功攻击讯飞语音输入法,该团队在此基础上进一步提出了Devil's Whispher攻击,针对商业智能语音设备实现了黑盒物理对抗攻击算法,能够成功攻击包括苹果Siri、微软Cortana、亚马逊Echo、Google Assistant等智能语音设备,并可以通过Youtube等社交平台传播(该成果已被USENIX Security 2020国际会议接收,CCF-A类)。清华大学团队提出的演化攻击,可以用来攻击人脸识别系统;比利时鲁汶大学研究表明,借助对抗补丁也可以大大降低监控系统对人类的识别率。

因此,随着对抗攻击技术的进步,尤其是可用于物理环境下的鲁棒性对抗样本生成算法的提出,进一步提升对抗攻击对AI系统的安全威胁。未来工作中,如何打造安全、可靠的人工智能系统则显得至关重要。

参考文献

[1] Zhao, Yue, et al. "Seeing isn't Believing: Towards More Robust Adversarial Attack Against Real World Object Detectors." Proceedings of the 2019 ACM SIGSAC Conference on Computer and Communications Security. 2019.1989-2004