代码的迁移和语言转换是一件很困难且昂贵的事情,澳大利亚联邦银行就曾花费5年时间,耗费7.5亿美元将其平台从COBOL转换为Java。而Facebook最近宣称,他们开发的一种神经转换编译器(neural transcompiler),可以将一种高级编程语言(如C ++,Java和Python)转换为另一种,效率飞起!

从 COBOL 到 Java,TransCoder能帮你省下7.5亿美元

不同的编程语言之间也可以自动转换了!

要知道,将现有的代码库迁移到现代或者更有效的语言,如 Java 或 c + + ,需要精通源语言和目标语言,而且无论是金钱还是时间耗费都十分高昂。

澳洲联邦银行在过去五年中花费了大约7.5亿美元将其平台从 COBOL 转换为 Java。

但是,Facebook最近开发的神经转换编译器TransCoder让代码转换出现了新的转机。该系统可以将代码从一个高级语言转换成另一个,比如 c + + 、 Java 和 Python。

这个系统是弱监督的,可以在没有标签的数据集中寻找以前未检测到的模式,只需要少量的人工监督。研究人员称,这比基于规则数据集的模型要高效得多。

理论上,代码转换编译器能够提供很多的帮助,让开发者无需从头重新写代码。但实践中,代码转换是一件很困难的事情,因为不同语言依赖于不同的语法准则,不同的平台api、标准库函数和可变类型。

因此,TransCoder的面世,无疑是企业的福音。因为他们不必像澳洲联邦银行那样,再去耗费大量的时间和金钱去做代码转换的复杂工作,只需要选择Facebook,选择TransCoder,平台迁移即可迎刃而解。

从Java到C++,TransCoder转换准确率超九成!

TransCoder是基于跨语言模型预训练去做的模型初始化,这样的训练不着眼于编程语言的类型,而仅仅将表示相同指令的代码段映射为相同的表示形式。

之所以TransCoder能进行跨语言模型的训练,是因为系统的标记原理着眼于跨语言之间的共同关键字,如「if」,「for」等,以及数字、数学运算符和出现在源代码中的英语字符串。这样反向翻译之后通过源-目标模型和并行训练的目标-源模型耦合,从而提高了训练的质量。

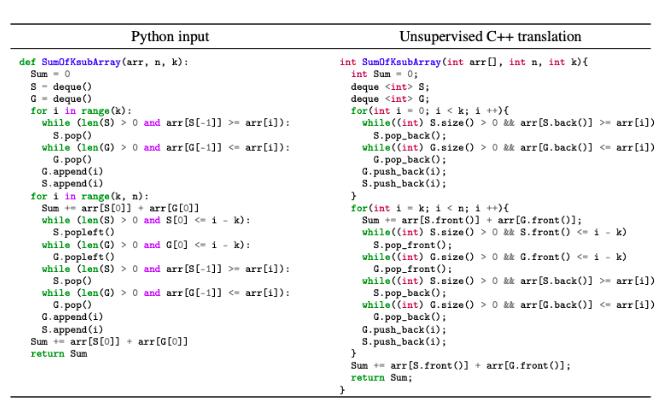

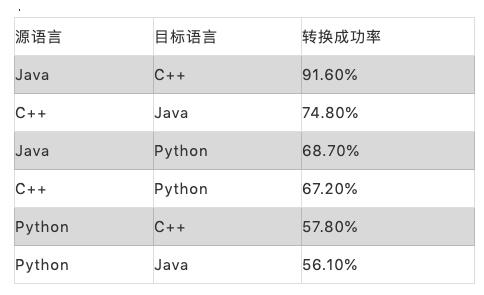

研究人员为了评估TransCoder的性能,从GeeksforGeeks中提取了852个C ++,Java和Python并行函数,利用这些不同语言的转换来测试函数语义是否精准,测试的结果如下:

GeeksforGeeks是一个在线平台,用于收集编写代码时的问题,并提供多种编程语言的解决方案。

研究人员称,TransCoder在实验过程中展示了对每种语言特有语法的理解能力,并且能够适应小范围的修改。尽管这个模型并不完美,但是性能优于已有的利用专家知识手动构建的框架。

从自然语言翻译到代码翻译,seq2seq再立新功

TransCoder使用了经典的序列到序列(seq2seq)模型,该模型由基于Transformer的编码器和解码器组成,seq2seq模型的好处在于,你只需要有对应的输入输出即可,而不需要关心是哪两种编程语言。

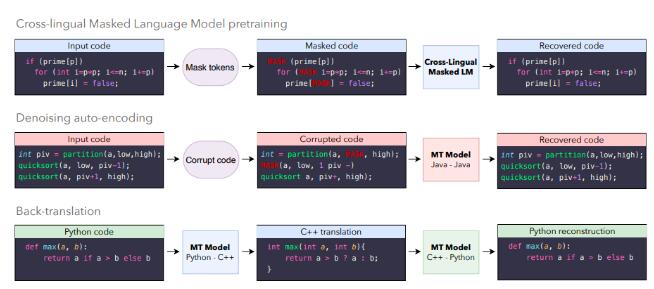

TransCoder仿照Lample等人中确定的无监督机器翻译流程进行训练,包括初始化,语言建模和反向翻译。

实验表明以跨语言方式对整个模型(不仅是单词表示形式)进行预训练显著改善了无监督机器翻译的效果,TransCoder遵循Lample和Conneau 的预训练策略,其中跨语言模型(XLM)在单语言的源代码数据集上,使用遮罩语言建模进行了预训练。

TransCoder的转换原理

其中,跨语言本质来源于多种语言中的大量通用标记(锚点)。在英语-法语翻译的上下文中,锚点主要由数字、城市、人名等组成,而在编程语言中,这些定位点来自常见的关键字(for,while,if,try等),以及源代码中出现的数字,运算符和英语字符串等。

seq2seq模型的编码器和解码器由预训练的XLM模型参数进行初始化。对于编码器而言,初始化非常简单,因为它与XLM模型具有相同的体系结构。但是解码器具有与attention机制有关的额外参数,所以这部分采用了随机初始化。

XLM预训练允许seq2seq模型生成输入序列的高质量表示。然而,解码器缺乏翻译能力,因为从未训练过解码器基于源表示对序列进行解码。为了解决这个问题,TransCoder利用降噪自编码(DAE)对序列进行编码和解码,再对模型进行训练。

在测试时,模型可以对Python序列进行编码,并使用C ++起始符号对其进行解码以生成C ++转换。C ++转换的质量取决于模型的「跨语言」性能:如果Python和C ++转换被编码器映射到相同的表示,则解码器将成功生成对应的C ++代码。

实际上,仅XLM预训练和降噪自编码就足以生成翻译。但是,这些翻译的质量往往很低,因为该模型从未对编程语言实现的功能进行训练。TransCoder为了解决这个问题,使用了反向翻译,这是在弱监督的情况下利用单语言数据的最有效方法。

在无监督的情况下,源到目标模型与后向的目标到源模型是并行训练的。目标到源模型用于将目标序列翻译成源语言,从而产生与真实目标序列相对应的嘈杂源序列。然后以弱监督的方式训练源到目标模型,从前面生成的嘈杂源序列中重建目标序列,反之亦然,并行训练两个模型直到收敛。

作者简介

该论文一作Marie-Anne Lachaux,目前是Facebook人工智能研究院NLP方向研究员,巴黎高等电信学院计算机图像学学士,伦敦国王学院计算机图像学硕士,曾在达索系统(Dassault Systèmes)担任研究员。主要研究方向为计算机视觉和图像识别,计算机神经网络。

在达索担任研究员期间,Marie-Anne Lachaux主要方向为拓扑优化研究。拓扑优化是设计机械零件的一种新方法,其目的是在保持机械性能的同时大量减少零件的质量。拓扑优化的实现方法是基于Visual Studio,c++和许多经典库,这为Marie-Anne Lachaux在Facebook开展NLP研究奠定了基础。

此前,已经有很多基于深度学习的代码自动补全,效果也十分惊艳,而基于规则的代码转换也有不少项目,但大多数泛化能力不强,毕竟能写的规则有限。

TransCoder基于深度学习进行代码转换,无视了这些规则,直接端到端,对相关工作还是有很大的启发,如果TransCoder准确率持续提升,那算法模型工程化的工作量将大幅缩减,程序员的编码效率也将有质的飞跃。