许多国家在与新型冠状病毒作斗争,下令公民在火车站或机场一律接受体温检测。这种情形下所需的设备:手持温度计已从一种专业设备变成了常见设备。

“计算机视觉”是AI的一个分支,专注于自动标记图像。大多数计算机视觉系统使用含有极少量手持温度计图像的数据集加以训练。因而,它们无法正确标记这种设备。

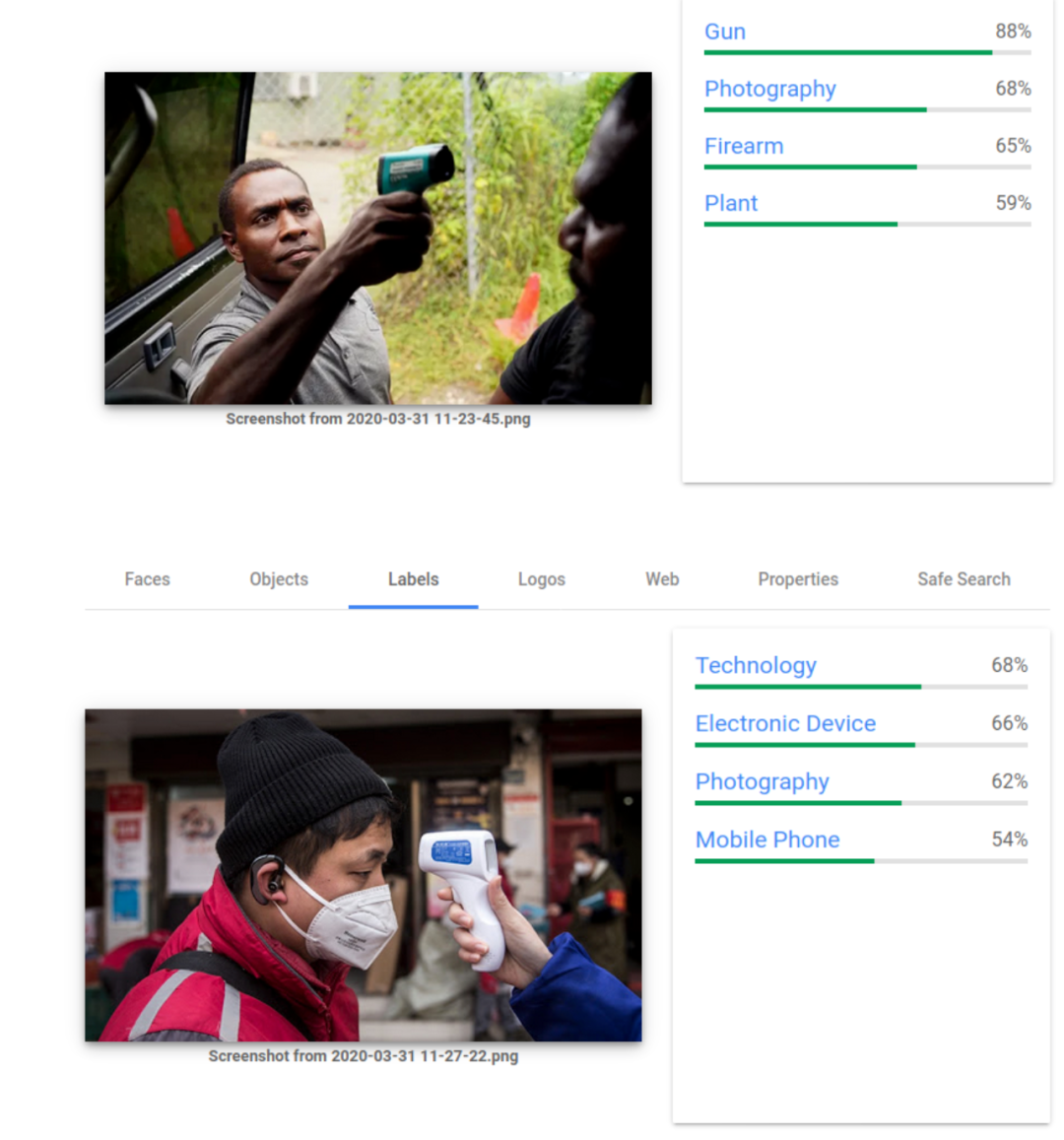

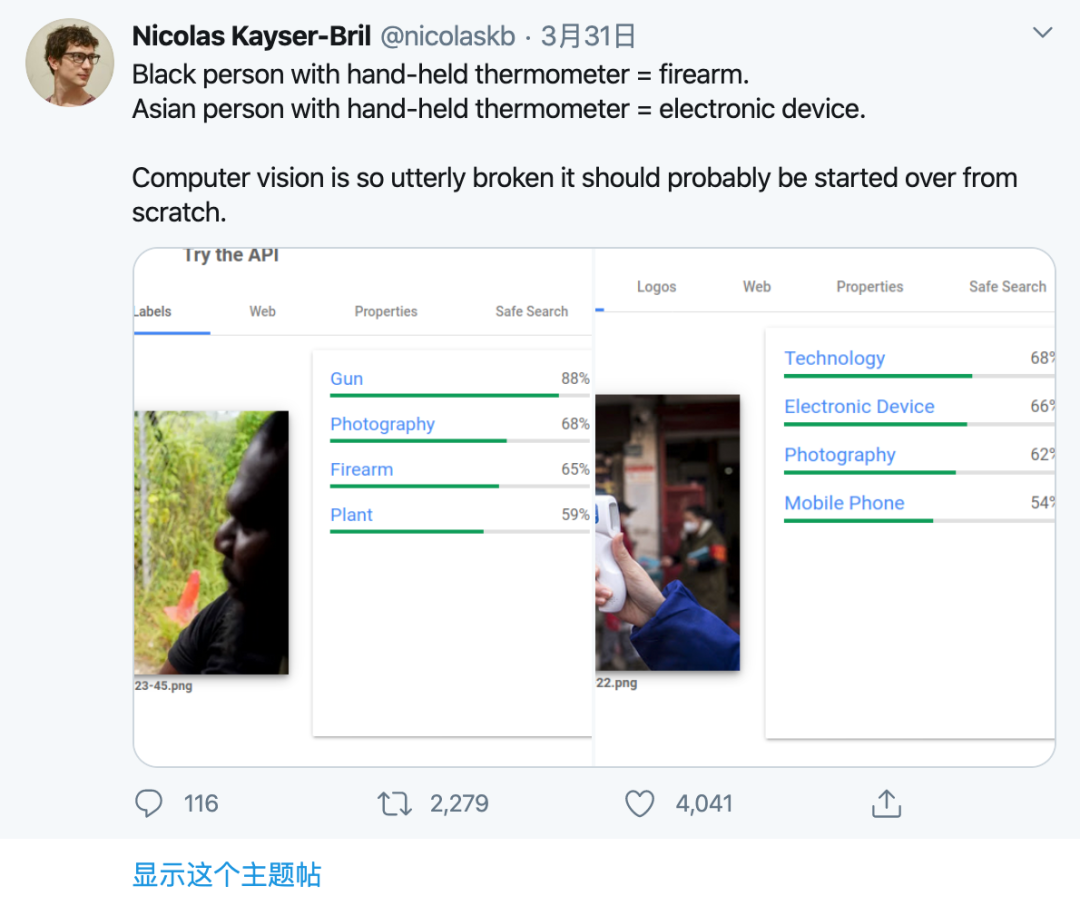

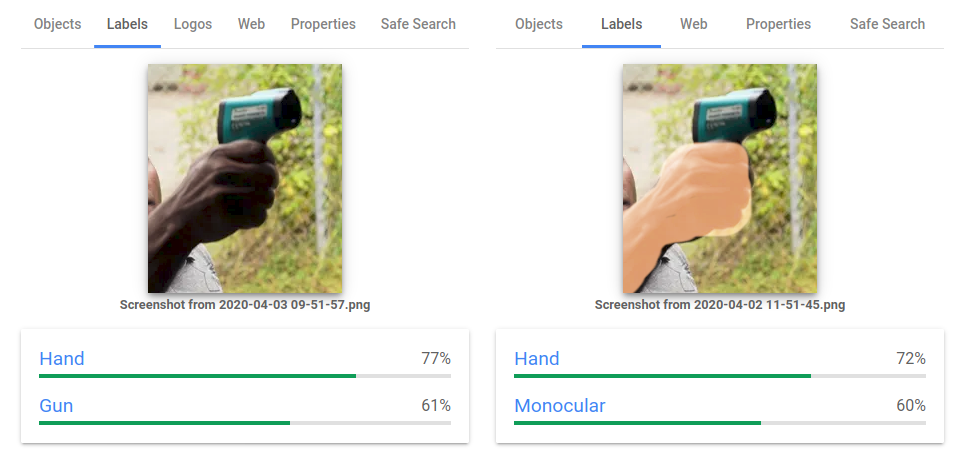

在Twitter上疯传的一个实验中,非营利研究和倡导组织AlgorithmWatch证明,计算机视觉服务Google Vision Cloud将手持测温计的深肤色人员的图像标记为“枪支”,而将浅肤色人员的类似图像标记为“电子设备”。随后的实验表明,持有温度计的深肤色手的图像被标记为“枪支”,而手上覆以浅橙色图案的同一图像足以让计算机将其标记为“单目望远镜”。

4月3日,添加覆盖层后,Google Vision Cloud生成了完全不同的标签。

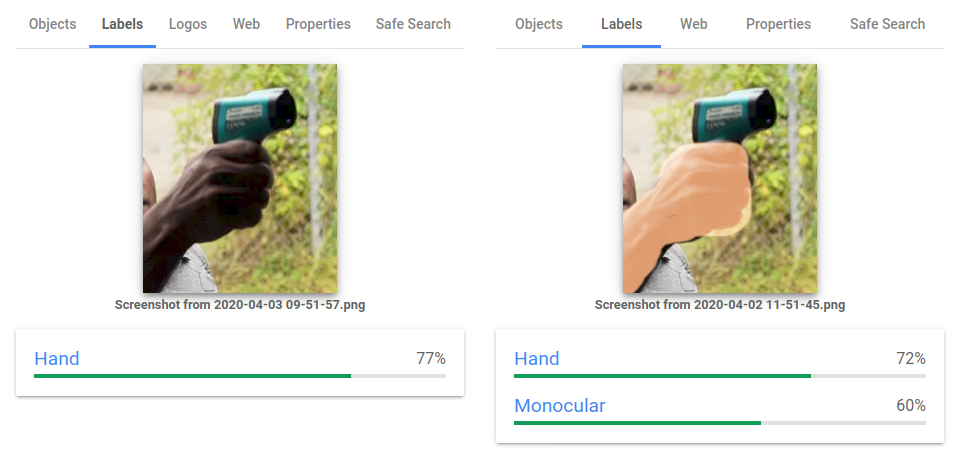

谷歌此后更新了算法。自4月6日起,它不再返回“枪支”标签。

谷歌的产品策略和运营主管Tracy Frey在一份声明中写道:“这个结果是不可接受的。认识到这一结果与种族主义之间的联系很重要;对于由此可能造成的任何伤害,我们深表歉意。”

Frey女士说:“我们的调查发现,一些物体被误标记为枪支;这些结果存在于一系列肤色中。我们已调整了置信度(confidence score),以便图像中有枪支时更准确地返回标签。”她补充道,谷歌发现“没有表明与肤色有关的系统性偏见的证据。”

荷兰代尔夫特理工大学攻读博士的Agathe Balayn表示赞同,她着重研究自动化系统中的偏见这一课题。她在谷歌的服务中测试了几个图像,得出的结论是,示例可能是“不存在统计偏见的不准确例子。”她写道,在缺乏更严格测试的情况下,不能说这个系统存在偏见。

4月6日,深肤色手的结果已经过了更新

背景调查

不难理解为什么计算机视觉会基于肤色生成不同的结果。这类系统处理人们辛苦标记的数百万张图片(比如说,你点击内有汽车或桥梁的方框以证明你不是机器人时所做的工作),并从中得出自动推断。

计算机视觉无法识别人类意义上的任何物体。它依赖训练数据中相关的模式。研究表明,一旦在白雪皑皑的背景下拍照,计算机视觉会将狗标记为狼。如果母牛站在海滩上,它们会被标记为狗。

由于肤色深的人在训练数据集中描绘暴力的场景中出现的频率可能高得多,因此对深肤色手的图像进行自动推断的计算机用暴力方面的词汇加以标记的可能性要大得多。

其他计算机视觉系统出现了类似的偏见。去年12月,Facebook拒绝让巴西的一个Instagram用户可以为图片打广告,理由是图片含有武器。实际上,那幅图片上就一个男孩和一级方程式赛车手Lewis Hamilton。两个人的肤色都很深。

带来的实际影响

标记错误可能会在实际环境下造成影响。纽约大学AI Now研究所的技术研究员、计算机视觉专家Deborah Raji在一封电子邮件中写道,在美国,武器识别工具被用于众多学校、音乐厅、公寓大楼和超市。在欧洲,一些警察队伍部署的自动监视装备也可能使用计算机视觉技术。Raji女士写道,由于这些系统大多数类似Google Vision Cloud,因此“它们很可能存在同样的偏见。”因而,肤色深的人更有可能被标记为危险分子,即使他们手持像手持温度计这样无害的东西。

Nakeema Stefflbauer是专注于包容性的技术专家社区FrauenLoop的创始人兼首席执行官,她在一封电子邮件中写道,计算机视觉软件中的偏见会“绝对”影响深肤色人群的生活。她补充说,由于女性和深肤色人群的误识别率一直偏高,因此用于监视的计算机视觉的普及会对他们造成过大的影响。

Stefflbauer女士提到了Ousmane Bah和Amara K. Majeed这两个例子,由于人脸识别系统出错,Bah这名少年被错误地指控在苹果商店盗窃,而Majeed在人脸被误识别后,被错误地指控参与了2019年斯里兰卡爆炸案。Stefflbauer预料,若缺乏有效的监管,整批人群到头来会避开某些建筑物或社区。她补充道,如果有偏见的计算机视觉得到更广泛的部署,个人可能在行动中面临事实上的限制。

逐步变化

谷歌的主管Frey女士在声明中写道,公平性是谷歌的“核心AI原则”之一,谷歌“致力于在开发机器学习方面取得进步,而公平性是衡量成功机器学习的一个关键指标”。

但是谷歌的图像识别工具之前就返回过带有种族偏见的结果。2015年,谷歌相册(Google Photos)将两个深肤色的人标记为“大猩猩”。谷歌后来表示了歉意,不过据《连线》杂志报道,谷歌并没有解决这个问题。相反,它只是简单地不再返回“大猩猩”这个标签,即便明明是这种哺乳动物的图片也是如此。

据AI Now研究所的Deborah Raji声称,技术公司仍在开发带有种族偏见的产品,至少有两个原因可以解释这种情况。首先,它们的团队以白人和男性为主,这样一来在开发阶段不太可能找到并解决歧视其他群体的结果。其次,“许多公司现在才刚开始制定正式流程,以测试和报告设计这些系统的过程中出现的这类故障,”她写道。她补充道:“外部问责是目前提醒这些工程团队的主要方法。”

“遗憾的是,到有人抱怨时,许多人可能已经受到有偏见的模型的过大影响。”