【51CTO.com原创稿件】 面对突如其来的疫情,大众对于信息的即时性、透明度和传达效率有了更高的关注。相比2003年“非典”时期,此次疫情爆发后,信息洪流也更为汹涌。移动传播时代,人人皆是自媒体,不仅是信息接收端,也是无数舆论的中转站,各种资讯的生产端。形形色色的疫情信息不仅降低了舆论场的“信噪比”,也为各种谣言提供了适宜的温床。

2020年2月上旬,世界卫生组织在一次会议中提出了“infodemic”一词,即information+epidemic,可以直白地理解为“信息疫情”。因为疫情发生至今,在海量信息的轰炸下,人们往往难辨真伪,信息的更新时时牵动着公众神经,催生着不安、担忧、焦虑、恐惧。群体情绪“过载”之下,对于疫情管控的考验无疑更加严峻。值得注意的是,人工智能在本次疫情相关的舆情梳理中开始扮演“沙里淘金”的角色,运用NLP(自然语言处理)技术“提纯”有效信息,关联信息线索,打造公共危机事件里的信息中枢。

进击的LDA:挖掘文本语义的利器

NLP被誉为人工智能皇冠上的明珠 ,因为自然语言是人类智慧的凝练,“让机器理解自然语言”寄托了人们对于AI最初的幻想——让机器听懂人话,和人交谈,甚至理解语言背后的文化、意图与情感。发展到今天,可以说“凡是文本飞舞的地方,NLP技术就会燃烧”。

LDA(潜在狄利克雷分配)主题模型是NLP中非常基础、大众认知度也比较高的模型。当我们写文章时,可能多数人是先确定文章的几个关键主题,然后围绕这几个主题遣词造句成文。这一过程的逆向操作就是LDA做的事。通俗来说,就是根据给定的文档,让计算机反推其主题分布,包括推测分析网上各篇文章分别写了哪些主题,且各篇文章中各个主题出现的概率大小。

在传统的方法中,判断两个文档的相似性是通过识别两个文档中有多少共有词。这种方法的局限性在于没有考虑到语义背后的关联。

比如:

“同人小说站A03获得雨果奖。”

“艺术创作不是孤岛。”

这两句话没有共有词,但事实上,前者是获奖新闻,后者是获奖致辞。两者主题是相似的。可见判断文档相似性时需要考虑到文档中的潜在词或者两篇文档间的联系。在主题模型中,主题就像一个袋子,里面装了出现概率较高的单词,这些单词与这个主题有很强的相关性。可以说,LDA模型是语义挖掘的利器。

疫情期间,使用LDA在数据集中提取主题也有落地应用。今年2月14日,“新冠肺炎疫情AI话题分析平台”正式上线。这个平台由清华大学人工智能研究院、RealAI共同研发推出。在底层算法支持上,平台采用WarpLDA主题提取算法研发。相比传统的Gibbs采样算法,WarpLDA在访存效率、并行度方面更有优势,可用于上亿级别文本的主题提取。

去伪存真:提取有效信息

51CTO记者在调查中了解到,这个平台除了疫情数字的实时播报以外,更侧重对疫情相关的热点话题进行分析。

“无论是疫情一线故事、防控措施,还是科普知识、辟谣信息,只要传播广热度高,都可以在平台上找到。所以我们平台的定位更像一个‘疫情话题热榜’。”RealAI的工作人员这样介绍。

打开移动端的平台界面,可以看到:截止目前,上线的具体板块包括“今日热点”关键词、“热点地区排行”、“实时热点”话题排行、“最近三天”热点排行、“官方发布消息”,这些模块合组合在一起,为公众在海量碎片化内容中构建了一个信息入口。

从这些模块的设置可以看到,针对信息“过载”的困扰,该平台对海量信息进行了自动抓取,识别公众关注的热点新闻、舆论趋势、地区关注度变化,并在这一过程中完成对于消息真实性的甄别,一定程度上保证了输出信息的可靠性。就如何完成有效信息的过滤,RealAI方面给出了具体说明。

首先在新闻源的抓取上,平台会优先抓取官方渠道信息,比如全国各地区卫健委官方网站、新华网、人民网等权威媒体,平台会给予这些渠道的新闻更高的权重。一般来说,在社交网络平台上,“谣言”更容易产生和传播,因此诸如微博、自媒体这类渠道,权重会相对较低。

另外,官方渠道发布的文章内容更为严肃,风格更为一致,在新闻抓取时比较容易集中在一个主题下。相较之下,那些无中生有的谣言,无论是文本呈现还是行文用词通常风格迥异,在做新闻聚合的时候更容易分散,不容易被归纳成一个热点主题。

鉴于当前NLP领域中LDA主题模型的发展还有比较大的外展空间,平台在运营过程中也会有人工把控,补充机器的不足之处。

针对网络谣言和假新闻,AI技术其实在疫情之前就开始崭露头角。2019年,阿里巴巴在愚人节推出了“AI谣言粉碎机”。据悉,这个算法模型要判断信息真伪,首先会找到初始信息源,分析用户画像,辨别发布者的可信度。然后寻找网上所有信息源,分析相关链接的域名来辨别传播载体的可信度,最后将正文里的关键论证进行提炼,与知识图谱里的权威知识库做匹配,验证关联度,如果互为印证,可信度就较高,自相矛盾,可信度就降低。在SemEval全球语义测试中,这项AI技术的识别准确率达到了81%。

见微知著:预警传染轨迹

人工智能除了可以过滤海量信息外,还可以从信息海的蛛丝马迹中预判危机的爆发。这对于提升危机事件的迅速响应能力,控制事件扩散规模有着至关重要的作用。此次新冠肺炎在武汉爆发之初没有得到有效遏制,信息梳理的缺位也是原因之一。事实上,今年1月时就有报道指出,一家致力于公共健康风险评估的加拿大公司BlueDot在2019年12月底就向其客户通报了这种新型冠状病毒。

在外媒采访中,BlueDot创始人解释:“公司的早期预警系统使用AI(包括NLP和ML),通过每天分析65种语言的约10万篇文章,来跟踪100多种传染病爆发情况。这些数据有助于公司知道何时通知客户潜在的传染病爆发和扩散。”

从目前公开的资料来看,BlueDot没有披露使用的算法,他们避开信息比较混乱的社交媒体,通过采集多语种的新闻报道、官方公告和动物疾病报告,综合全球航空动态和天气数据,为客户提供预警。

BlueDot声称,他们的数据源主要来自三方面,一个是全球新闻报道,设置关键词基本与流行疾病、动物疾病、公共卫生有关;一个是航空公司的票务数据,通过全球机票数据库的数据来跟踪疑似感染人口的流动,预测感染可能波及和扩散的城市,及时告知客户相关信息;还有就是监测某个地区一定时期内的气候、温度及牲畜变化情况。此前,BlueDot准确预测了病毒在最初出现的几天内将从武汉传播到泰国曼谷、韩国首尔、中国台北和日本东京。

放眼全球,AI虽然已经在疾病预防中有所建树,未来也可能成为公共健康规划中的可信工具,但目前的疾病预测算法还都需要面对预测模型的缺陷。谷歌在2008年发布的流感趋势预测工具Flu Trends就是一个典型。

Flu Trends可以监测数百万用户的健康数据,提供几十个国家的流感趋势预测。但在2012年的一次流感爆发事件中,疾控中心汇总各地数据后发现谷歌的预测比实际情况夸大了近1倍。后来研究发现,谷歌的工程师们并不了解搜索关键字和流感传播之间有什么关联,对于各种信息背后的关联也没有深入解析,最终导致了荒谬的结果。之后工程师们不断进行着算法的微调,但是每当修正完一处,总有另一处出现了意想不到的误差。在瞬息万变的信息抗疫战场上,可以说,唯一不变的就是一直在变的“算法”。

光影双生:AI带来的舆情风险

在信息战场上,AI可以发挥舆论的积极导向作用,但不可轻忽的是,如果AI被不正当地使用,也可以诱发舆论恐慌。技术本身没有价值观,但技术的使用者有价值取向。在不同的利益方手中,AI技术必然会产生不一样的后果。

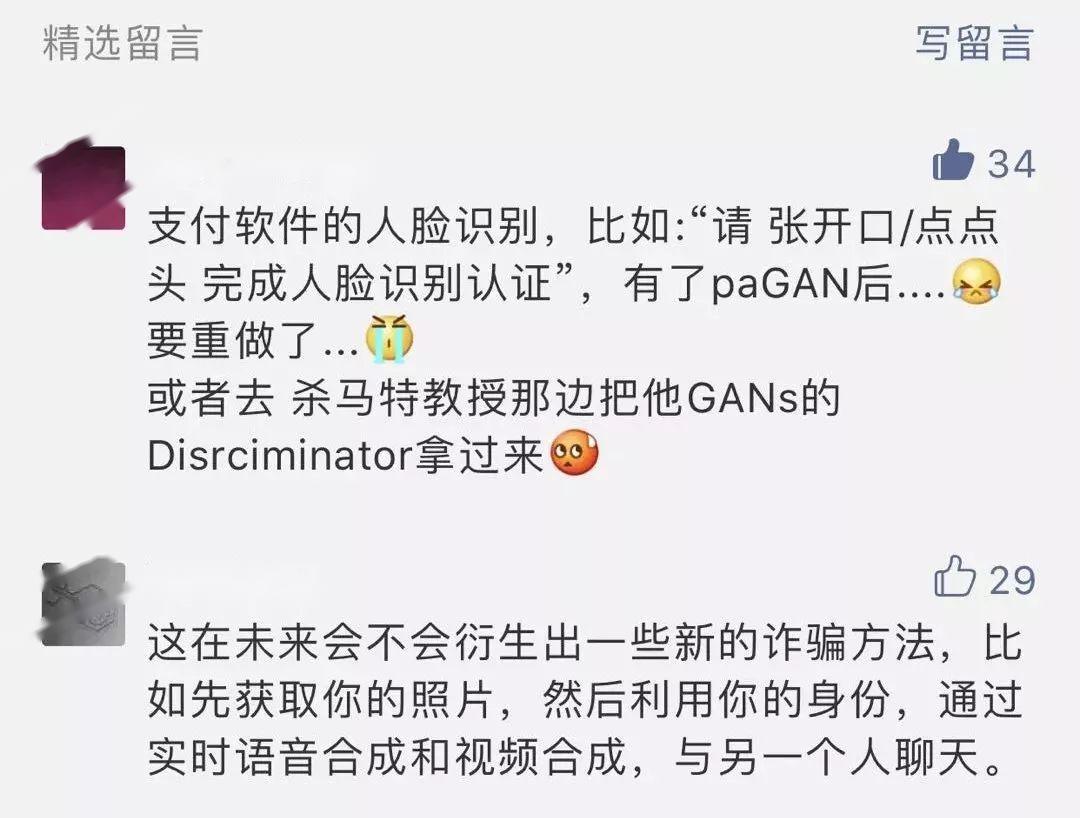

2019年AI换脸app在社交媒体上的火爆一度引发争议。只需要一张人脸照片,就可以用AI换脸技术,“嫁接”到选定视频的某个人物身上,由此生成的视频画面流畅,人物表情自然,几可乱真。合成图像、合成语音,充斥在网络里的合成品使“眼见不一定为实,耳听也不一定为真”。

这些技术给众多使用者带来了有趣的体验,但也有人质疑AI开启了潘多拉魔盒,踩着伦理和法律的底线反复横跳,带来了事关版权、肖像权、个人隐私的隐患,甚至可能引发盗窃、诈骗、情色视频制作等“技术作恶”乱象。

更为严重的是,如果利用AI技术恶意虚构新闻事件大肆传播,极有可能导致谣言的“发酵升级”,甚至影响舆论走向。

一家美国的制片公司“猴爪”在2018年利用AI制作了这样一段视频:奥巴马对美国现任总统特朗普进行严厉批评。但实际上奥巴马的表情和动作合成自“猴爪”创始人皮尔。更极端地考虑,如果官方的新闻发布平台或一些权威机构的媒体号被黑客控制,散播AI合成的文本、视频、音频,就更容易操作舆论,煽动公众情绪,造成舆情风波。

此外,“机器人水军”也值得警惕,其存在本身影响着舆论生态,而且在一些平台上已形成规模。比如网店利用机器人水军刷好评,相比雇人灌水这种操作,机器自动生成的信息密度更大,侵蚀性更强,也更容易将真实评价淹没于无形。可以想象,如果在社会事件中引入机器人水军,那么舆论被裹挟是必然,真相被掩盖,公众被蒙蔽,甚至可能将国家安全置于险地。更讽刺的是,大多数人可能对此一无所觉。长此以往,即使“黑天鹅”不再来,“灰犀牛”也会不期而至。

参考资料:An AI Epidemiologist Sent the First Warnings of the Wuhan Virus https://www.wired.com/story/ai-epidemiologist-wuhan-public-health-warnings/amp

【51CTO原创稿件,合作站点转载请注明原文作者和出处为51CTO.com】