本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

今天早上,离开微软的沈向洋正式续聘清华,在清华讲了第一堂课。

去年11月沈向洋离职微软后,就在本周前几天,沈向洋续聘清华,在清华的title是清华大学高等研究院双聘教授。

清华大学校长邱勇说,这是清华大学历史上第一次以视频会议的形式举行聘任仪式,校长连线发聘任书。

这次聘任仪式的两端分别在中美两地,校长和工作人员们在位于北京的清华大学工字厅,而沈向洋博士在位于西雅图的清华大学全球创新学院(GIX)大楼127室。

邱勇校长还开玩笑说:“我也是第一次跟向洋博士以这种形式见面,向洋博士在屏幕上很帅,比以前都帅。”

之所以是“续聘”,是因为这其实是沈向洋在清华的第二场聘任仪式。2005年,沈向洋首次受聘清华高等研究院双聘教授,距今已经过去了15年。

聘任仪式之后,借助Zoom直播平台,沈向洋进行了主题为Engineering Responsible AI的课程演讲。

沈向洋提到,AI目前在社会各界中都有应用,人们借助AI来做决策。但现在,AI已经在做我们不懂的决策。

许多AI系统就像黑箱一样,AI做了决策,但我们不知道它为什么这样做。

因此,负责任的AI是很重要的,每个创造AI的人都应该了解一些AI创造的原则。

之后沈向洋重点讨论了可解释的AI和AI的偏差(bias)

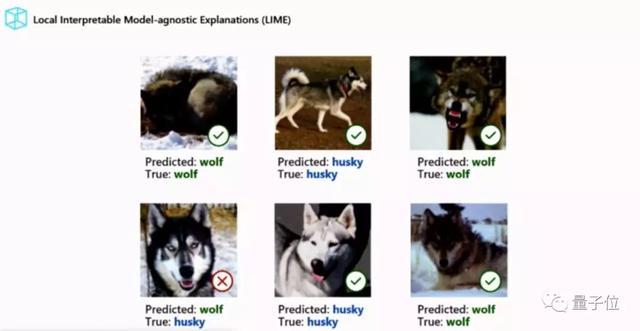

关于可解释的AI,沈向洋举了一个AI分辨哈士奇和狼的例子。

在以下6张照片中,只有左下角的一张被识别错了。

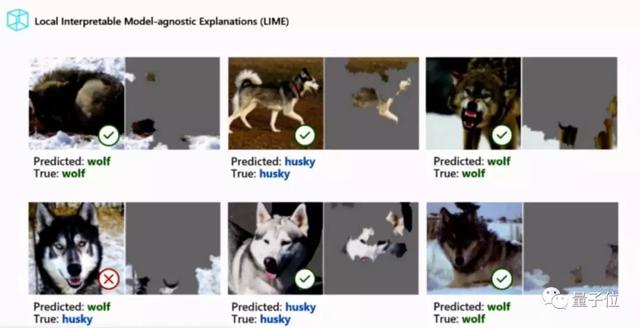

但其实,AI可能并非像我们理解的那样,通过动物的外形来辨别的,它的辨别方法可能是这样:

AI的判断并非通过图片中的动物部分,而是通过图片中除了动物之外的部分进行的。

因此,可解释的AI非常重要,不然你永远都不知道AI可能是用这种作弊的方法来判别哈士奇和狼的。

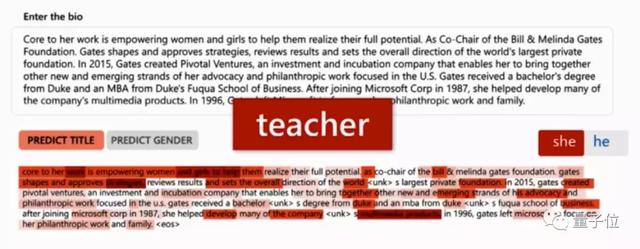

而关于偏差,沈向洋举了性别偏差的例子。

曾经有人发现一个人脸识别系统里,识别不准的都是女性、不化妆、短发、不苟言笑的照片,而其他人就相对更准一些。

而在词嵌入中,问题更为明显。

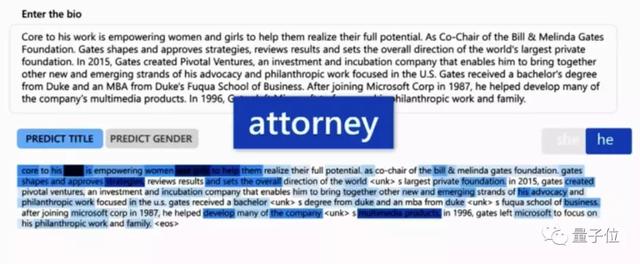

同一段描述,当文中用的是she/her等女性词汇时,AI判断这段文字描述的是老师;

而当里面的she/her变成he/his/him等男性词汇时,AI就会判断这段文字描述的是律师。

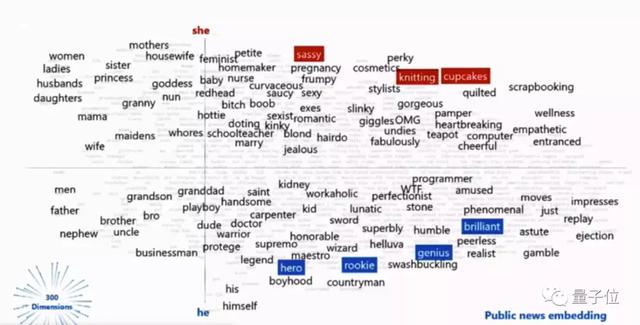

一个典型的例子是“He’s Brilliant, She’s Lovely”。

在一个词嵌入系统中,当主语分别是“她(she)”和“他(he)”时,出现的词是不一样的:

她是“姐妹”,他是“兄弟”;她是“护士”,他是“大夫”,谈到这里,沈向洋吐槽说,你们没发现哪里不对么?她是“家庭主妇”,他是“程序员”;她说“OMG”,他说“WTF”;她是“女权主义者”,他是“现实主义者”;她“怀孕”了,他“肾结石”了;……

这是词嵌入里的偏差,很多时候人们想都不想,就直接用了。

最后,沈向洋教授总结说,我们是第一代和AI共存的人类,我们得决定怎么构建AI、怎么用AI。我们能接受一个AI做的决定、我们人类无法理解的世界吗?

One More Thing

最后,沈向洋还表达了他对NLP领域的期待。

他说,CV现在还很火,但未来十年自己看好NLP:

“懂语言者得天下。”

这是沈向洋全程唯一一句中文。

传送门

如果你想了解沈向洋演讲的具体内容,清华大学微博上可以查看回放:

https://weibo.com/1676317545/Ixadc8PhK?from=page_1002061676317545_profile&wvr=6&mod=weibotime&sudaref=weibo.com&display=0&retcode=6102&type=comment