本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

最新消息,腾讯又围绕王者荣耀AI“绝悟”发表了新论文,已经被AI顶会AAAI 2020收录。

这是继今年8月份绝悟在5v5比赛中击败职业战队后,腾讯首次披露AI背后的技术细节。

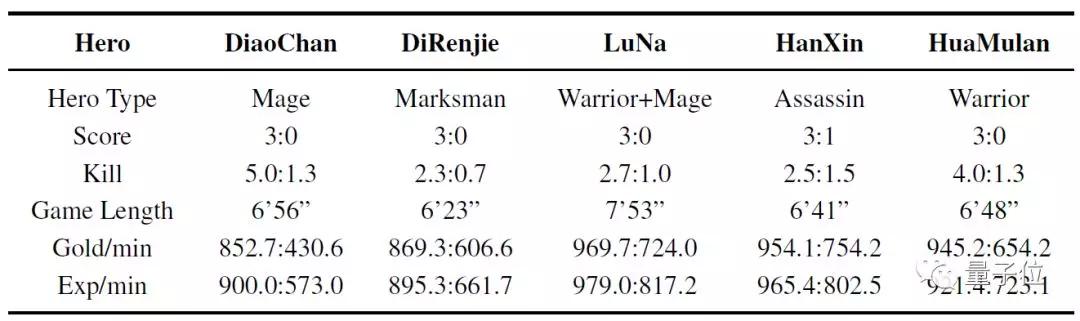

腾讯研究人员表示,将AI执行动作时间限制在业余高手玩家相同的水平上(间隔为133ms),绝悟已经能够单挑顶级职业选手,并在其擅长的英雄上实现碾压,15场比赛中职业选手只赢了1场,并且最多坚持不到8分钟。

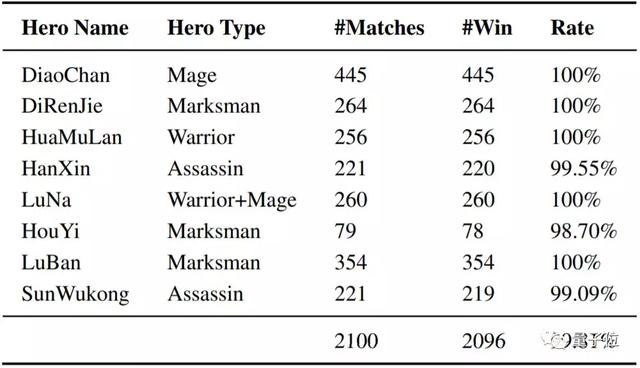

在今年8月份的公开测试中,这一王者荣耀1V1的AI与大量顶级业余玩家进行了2100场对战。AI胜率达到99.81%。

在貂蝉(法师)、狄仁杰(射手)、花木兰(上单/战士)、露娜(打野/刺客)、鲁班(射手)等英雄上,胜率都是100%。

如此AI是怎么训练出来的?我们且看腾讯最新论文中披露的最新细节。

30小时达到王者水平,70小时比肩职业玩家

首先需要指明的是,腾讯的这篇新论文关注的是 1v1 游戏AI,并不是 5v5 游戏AI。

研究人员在论文中解释称,后者更注重所有智能体的团队合作策略,而不是单个智能体的动作决策。

考虑到这一点,1v1游戏更适合用来研究游戏中的复杂动作决策问题,也能够更加全面系统的研究游戏 AI 智能体的构建。

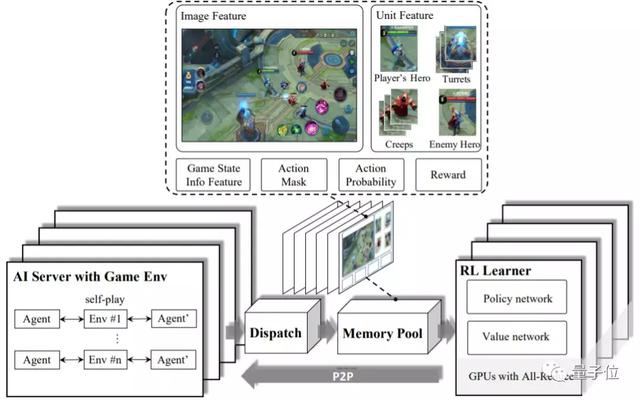

AI的整体架构一共分为4个模块:强化学习学习器(RL Learner)、人工智能服务器(AI Server)、分发模块(Dispatch Module)和记忆池(Memory Pool)。

这是一种高可扩展低耦合的系统架构,可以用来构建数据并行化。主要考虑的是复杂智能体的动作决策问题可能引入高方差的随机梯度,所以有必要采用较大的批大小以加快训练速度。

其中,AI服务器实现的是 AI 模型与环境的交互方式。分发模块是用于样本收集、压缩和传输的工作站。记忆池是数据存储模块,能为 RL 学习器提供训练实例。

这些模块是分离的,可灵活配置,从而让研究者可将重心放在算法设计和环境逻辑上。这样的系统设计也可用于其它的多智能体竞争问题。

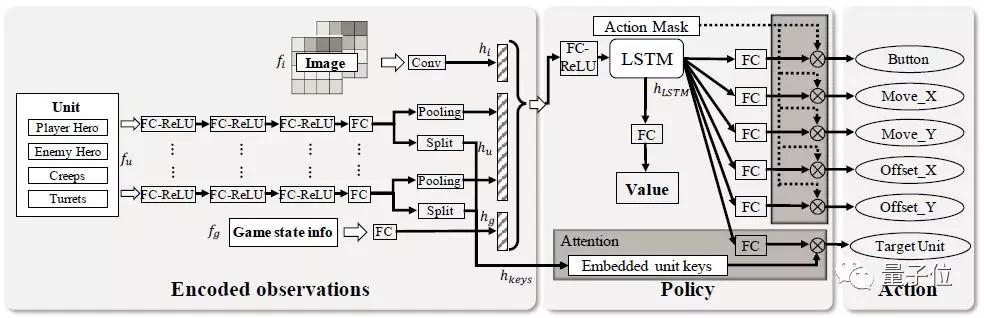

在强化学习学习器中,他们还实现了一个 actor-critic 神经网络,用于建模1v1 游戏中的动作依赖关系。

为了应对游戏中的多个场景决策,研究人员们还提出了一系列算法策略,来实现更高效率的训练:

- 为了帮助AI在战斗中选择目标,引入目标注意力机制;

- 为了学习英雄的技能释放组合,以便AI在序列决策中,快速输出大量伤害,使用了LSTM;

- 用于构建多标签近端策略优化(PPO)目标,采用动作依赖关系的解耦;

- 为了引导强化学习过程中的探索,开发了基于游戏知识的剪枝方法;

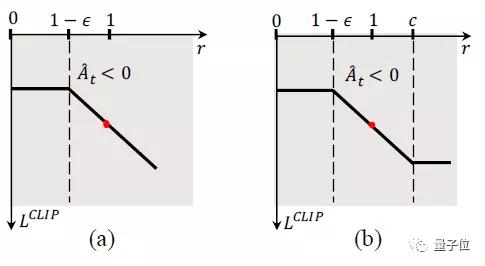

- 为了确保使用大和有偏差的数据批进行训练时的收敛性,改进 PPO 算法提出dual-clip PPO,其示意图如下所示:

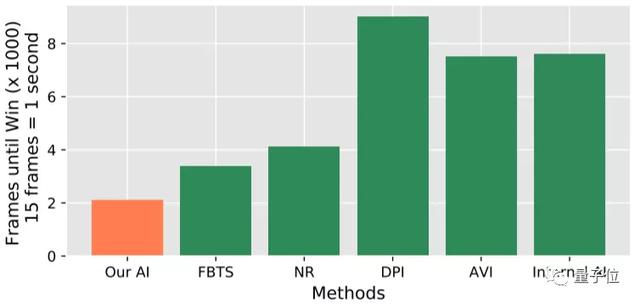

研究人员在论文中指出,基于这样的方法训练一个英雄,使用48个P40 GPU卡和18000个CPU 内核,训练一天相当于人类打500年,训练30个小时就能达到王者段位水平,70个小时比肩职业玩家,其表现要显著优于多种baseline方法。

而且如前所述,在与人类选手交战的测试中,获得了非常亮眼的成绩。

如果你想了解关于这一AI更多的细节,我们将论文链接放到了文末~

来自腾讯AI Lab和天美工作室,还在打造开放平台

与2018年12月份发布的王者荣耀AI论文作者单位相比,这次多了“天美工作室”——王者荣耀的开发团队。

除了研究,腾讯AI Lab与王者荣耀还将联合推出“开悟”AI+游戏开放平台。

王者荣耀会开放游戏数据、游戏核心集群(Game Core)和工具,腾讯AI Lab会开放强化学习、模仿学习的计算平台和算力,邀请高校与研究机构共同推进相关AI研究,并通过平台定期测评,来展示多智能体决策研究实力。

目前“开悟”平台已启动高校内测,预计在2020年5月全面开放高校测试,并且在测试环境上,支持1v1,5v5等多种模式。

腾讯透露,计划在2020年12月举办首届AI在王者荣耀应用的水平测试。