深度学习作为一类机器学习方法,是实现人工智能的重要基础。近日有学者认为,随着人工智能的发展,深度学习的短板日益凸显,“其瓶颈已至”。深度学习的瓶颈是否真的已经到来?就此问题,本文将分为上下篇,对于深度学习的优势与短板、以及改进方式进行探讨,为读者梳理各位专家学者的不同思考。

不久前,全球人工智能计算机视觉领域奠基人之一、约翰霍普金斯大学教授艾伦·尤尔抛出“深度学习(Deep learning)在计算机视觉领域的瓶颈已至”的观点,引发业内许多专家的共鸣和热议。

目前,作为实现人工智能的一种形式,深度学习旨在更密切地模仿人类大脑。那么,业内专家学者是否认同这种说法?作为人工智能技术的重要基础,深度学习在发展中究竟遇到哪些困难?如果深度学习瓶颈已至,我们该如何破解这个难题?带着相关问题,科技日报记者近日采访了中外人工智能的知名专家对尤尔教授的观点深入解读。

深度学习精到之处

最初,深度学习刚刚进入大多数人工智能研究人员的视线时,被嗤之以鼻,但短短几年后,它的触角在诸多高科技领域延伸,横跨谷歌、微软、百度等多家企业。

很多高科技公司热衷探索深度学习的一种特殊形态——卷积神经网络。卷积网络是由相互连通的卷积层组成,与大脑中处理视觉信息的视觉皮层十分类似,不同之处在于,其可以重复使用一张图像中多个位置的相同过滤器。一旦卷积网络学会在某个位置识别人脸,也可以自动在其他位置识别人脸。这种原理也适用于声波和手写文字。

业内人士认为,卷积神经网络可以使得人工神经网络能够快速接受培训,因为“内存占用空间小,不需要对图像中每个位置的过滤器进行单独存储,从而使神经网络非常适合于创建可扩展的深网(Deep nets)”。这也令卷积神经网络具有善于识别图形的优点。正是基于此,谷歌开发出安卓手机的语音识别系统、百度对可视化新型搜索引擎进行研发。

当然,要让卷积神经网络正常运作需要功能强大的计算机和庞大的数据集,而其在收集数据或计算平均值时,效果并非十全十美。

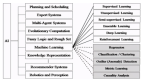

卷积神经网络的力挺者、脸谱(Facebook)人工智能实验室负责人伊恩·勒坤表示,目前使用最广泛的卷积神经网络几乎完全依赖于监督学习。这意味着,如果想让卷积神经网络学会如何识别某一特定对象,必须对几个样本进行标注。而无监督学习(Unsupervised learning)可以从未经标记的数据展开学习,更接近人脑的学习方式。而在此基础上开发的反向传播算法,能有效使错误率最小化,只是不太可能体现出人类大脑的运作机理。

勒坤表示:“我们对大脑如何学习几乎是完全陌生的。尽管人们已经知道神经元突触能够自我调整,但对大脑皮层的机理尚不明晰,所知道的最终答案是无监督学习是一种更接近人脑的学习方式,但对于大脑的认知机制却无力解答。”

瓶颈凸显需警惕

“虽然深度学习优于其他技术,但它不是通用的,经过数年的发展,它的瓶颈已经凸显出来。”不久前,艾伦·尤尔指出。

尤尔认为,深度学习有三大局限:首先,深度学习几乎总是需要大量的标注数据。这使得视觉研究人员的焦点过度集中于容易标注的任务,而不是重要的任务。

其次,深网在基准数据集上表现良好,但在数据集之外的真实世界图像上,可能会出现严重失败。特别是,深网难以应付数据集中不经常发生的“罕见事件”。而在现实世界的应用中,这些情况则会产生潜在风险,因为它们对应的视觉系统故障可能导致可怕的后果。比如,用于训练自动驾驶汽车的数据集几乎从不包含“婴儿坐在路上”的情况。

第三,深网对图像中的变化过度敏感。这种过度敏感不仅反映在对图像中难以察觉变化的标准上,还反映在对上下文的变化上,由于数据集大小的局限,过度敏感会导致系统做出错误判断,但这种因过度敏感而导致的图像变化却难以欺骗人类观察者。

例如,在一张丛林里有只猴子的照片中,PS上一把吉他。这会导致AI将猴子误认为人类,同时将吉他误认为鸟。大概是因为它认为人类比猴子更可能携带吉他,而鸟类比吉他更可能出现在附近的丛林中。

尤尔认为,瓶颈背后的原因是一个叫做“组合爆炸”的概念:就视觉领域而言,从组合学观点来看,真实世界的图像量太大了。任何一个数据集,不管多大,都很难表达出现实的复杂程度。更何况每个人选择物体、摆放物体的方式不一样,搭出的场景数量可以呈指数增长。而这需要无穷大的数据集,无疑对训练和测试数据集提出巨大挑战。

业内专家表示,这三大局限性问题虽还杀不死深度学习,但它们都是亟待需要警惕的信号。

“已死”之说值得商榷

去年,深度学习领域一位知名学者曾在脸谱发布惊人之语——深度学习已死,引起业内一片哗然,以至于现在网上机器学习社区的一些人说,搞深度学习是在走死胡同。

“我认为‘深度学习已死’这种说法,是出自那些曾经极为看好深度学习、后来却意识到其局限的业内人士。而局限并不意味着这个事物已经死亡,我们可以补充一些东西进去。”法国泰雷兹集团CTO马克·厄曼向科技日报记者表示。

“我不赞同‘深度学习已死’的提法。”新一代人工智能产业技术创新战略联盟联合秘书长、科大讯飞副总裁兼AI研究院联席院长李世鹏指出。

李世鹏说,深度学习作为一个新的计算科学领域的方法,当然有其自身的限制和缺陷。这个在外界被炒作成无所不能的AI工具,其实科学界一直都很谨慎地对待,从一开始大家就知道它的一些局限性,比如对标注了的大数据依赖、非解释性、没有推理功能、对训练集里包括的样本就能工作得很好而对没有包括的样本就很差、系统模型处于非稳态等。

“我比较赞成尤尔教授的客观说法——深度学习在计算机视觉领域的瓶颈已至,特别是他讨论问题的这个时间点很有必要,在方向上有矫枉过正的提示作用。现在大家对深度学习热衷得有些过度,在学术界,甚至在产业界,给人一种似乎‘非深度学习非AI’的感觉。实际上这是有很大问题的,因为深度学习确实只是人工智能领域里一个被实现出来的,却比较窄的成功经验。”远望智库人工智能事业部部长、图灵机器人CSO谭茗洲指出。

总而言之,李世鹏表示,深度学习已死之说法值得商榷。在未来相当一段时间里,深度学习会对人工智能发展起着积极推动作用,并具有很大的应用价值,同时,科学家对深度学习天生的缺陷和局限已明晰,正在尝试一些方法补足其现阶段发展的不足,并在各自的领域内探索着下一代人工智能的突破。