本文经AI新媒体量子位(公众号ID:QbitAI)授权转载,转载请联系出处。

“深度学习不是真正的学习。”

英特尔神经形态计算实验室主任Mike Davies在国际固态电路会议(ISSCC)上将深度学习批判了一番。

Davies说,深度学习跟大多数人印象中的并不一样,它只是一种优化程序,实际上并不是真正在“学习”。

受到攻击的重灾区,还是深度学习中的反向传播算法。

他说,反向传播与大脑无关,而只是在深度学习计算机程序中用来优化人工神经元响应的一种数学技术。

自然的反向传播例子,并不存在。

虽然他承认深度学习现在非常有效,但他也坚定地强调里,大脑才是真正智能计算的范例。

Davies死死抓住不放的“不像大脑”这个问题,也正是深度学习教父Hinton一直重视的。

不过对于这次批判本身,美国媒体ZDNet认为,他主要的攻击目标其实是Yann LeCun。

深度学习vs.神经形态计算之争

为何攻击LeCun?

就在周一,这位AI大牛在同一个学术会议上发言时,顺便批判了Davies在搞的神经形态计算。

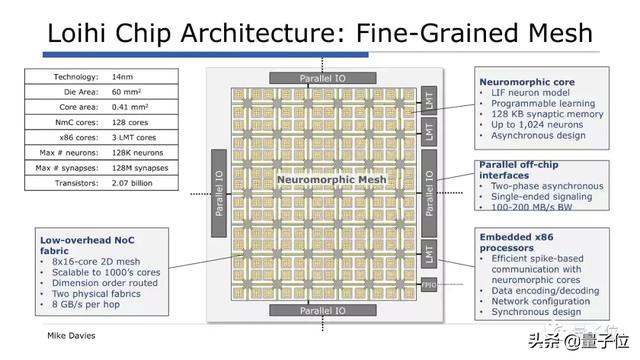

神经形态计算是英特尔布局的一个重要新兴方向,在这个领域,他们推出了芯片样品Loihi。英特尔说,这种芯片可以实现自主学习,而且能耗只有传统芯片的千分之一。

而Davies就是神经形态计算实验室的负责人,主管着英特尔在这一领域的探索。他参加ISSCC会议,也是来讲Loihi的。

Loihi用了一种名叫尖峰神经元(spiking neurons)的技术,这类神经元只有在输入样本后才能被激活。

神经形态计算倡导者们认为,这种方法更好地模拟了大脑的运行机制,比如说信号传递的过程就像大脑一样经济。

在LeCun看来,神经形态计算领域没有产生有实际效果的算法,为何要为一种没用的算法构建芯片?

不过Davies直接表达了反对,他说,神经形态计算产生的算法是有效的,LeCun忽视了神经形态计算的优势。

Davies说:“LeCun反对尖峰神经元,但他却说我们需要解决硬件中的稀疏性,尖峰神经元就是干这个的啊。”

他说,这太讽刺了。

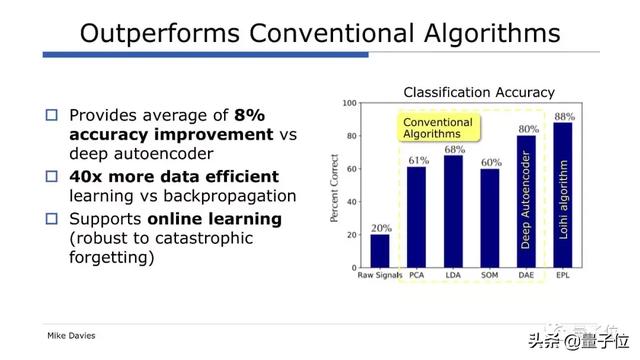

为了驳斥对尖峰神经元的批评,Davies引用了安大略滑铁卢一个名叫应用脑科学(Applied Brain Science)的机构的数据,比较了一种语音检测算法在不同芯片上的表现。

这个算法被要求识别“aloha”这个词,并且拒绝无意义词语,这家机构在CPU、GPU和Loihi芯片上运行了这一算法。

这份数据显示,Loihi在常规处理器上运行常规神经网络性能佳,特别是在计算速度方面,并且能源效率更高,不过精确度会低一些。

在另一个例子中,Davies说Loihi执行的基本分类器任务的速度是传统的基于GPU的深度学习网络的40倍,准确度提高了8%。

因此,Davies认为Loihi效率高得多,可以运行规模越来越大的网络,他认为,机器人控制将会是Loihi这类神经形态芯片的杀手级应用。

Davies还从LeCun的批评挑出了他认同的一点:尖峰神经元的硬件非常充足,提供了很多工具来映射有趣的算法。

针对这句话后边隐含的“但是软件算法层面不行”,Davies说,他的团队当前目标就是在算法上取得进展,算法确实拖了这个领域的后腿。

在Twitter上,也有人隔空参与了这场辩论。

有人认为,神经形态计算就像量子计算一样处在起步阶段,所以没什么可批判的。

也有人觉得深度学习已经在许多领域内取得了成果,量子计算和神经形态计算还差得远,虽然技术很尤其,但两者都没有被证实,而且都没有编程模型。

其实,这场LeCun和Davies的争斗,除了学术方面之外,另外不得不考虑的一点就是Facebook和英特尔的商业竞争。

周一,LeCun表示Facebook内部正在开发AI芯片,一旦Facebook自己的芯片研发成功,那就不需要使用英特尔的芯片了,甚至还会抢走英特尔的客户。

看完这场隔空口水战的来龙去脉,我们把目光收回到Davies指责的核心:反向传播。

训练深度学习模型离不开它,但对它的质疑也接连不断。

反向传播到底行不行?

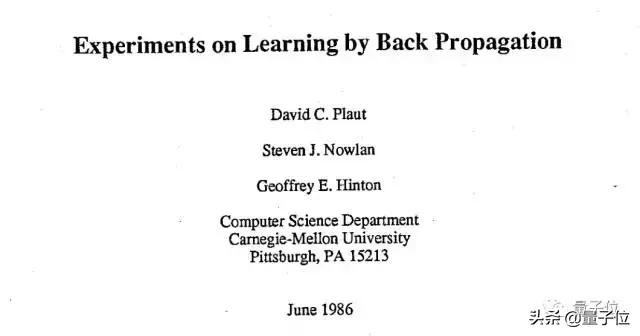

反向传播,生于1986,出自David Plaut、Steven Nowlan、Geoffrey Hinton在卡耐基梅隆大学(CMU)时发表的Nature论文:Experiments on Learning by Back Propagation。

△ www.cs.toronto.edu/~fritz/absps/bptr.pdf

31年后,这一概念已经随着深度学习广泛应用到了各种领域,也遇到了很大的一次危机。

它的的提出者之一、“深度学习之父”Hinton在多伦多举办的一场会议上公开提出了质疑。

他说,他对反向传播“深感怀疑”,甚至想“全部抛掉,重头再来”。因为,大脑的运作机制并不是这样的。

“不像大脑”这个问题,Hinton一直非常重视,他曾在MIT的一次讲座上说,他相信正是这些不像大脑的东西,导致人工神经网络的效果不够好。

在Hinton发出自我质疑之后,反向传播更成了讨论的热点,甚至被称为“今日AI的阿喀琉斯之踵”。

不过现在,可能Hinton应该自己的作品稍微满意一点了。

哈佛大学临床神经科学学院的两位科学家在新一期Cell旗下期刊《认知科学趋势》(Trends in Cognitive Sciences)上发表综述,总结了人工神经网络的反向传播算法,在大脑中是怎样体现的。

这篇综述题为“大脑中误差反向传播的理论”(Theories of Error Back-Propagation in the Brain),综合了近来的一批理论研究,分析几类生物反向传播模型。

作者说,这些理论研究“否定了过去30年来普遍接受的教条,即:误差反向传播算法太复杂,大脑无法实现”。

根据这些研究,脑神经回路中类似反向传播的机制,是基于突触前和突触后神经元活动的简单突触可塑性规则。

论文:https://www.cell.com/trends/cognitive-sciences/fulltext/S1364-6613(19)30012-9

One more thing…

虽然Davies和LeCun在一场学术会议上隔空吵得很热闹,但深度学习和神经形态计算并非势不两立。

有不少学者在研究如何把神经形态芯片和深度学习结合起来。

比如:

美国橡树岭国家实验室、加州理工大学和田纳西大学的学者们,就曾经研究过如何在高性能计算设备、神经形态芯片和量子计算机上运行复杂的深度神经网络。这是他们的研究:

A Study of Complex Deep Learning Networks on High Performance, Neuromorphic, and Quantum Computers

地址:https://arxiv.org/abs/1703.05364

而奥地利格拉茨技术大学的Guillaume Bellec、Franz Scherr等人,最近在arXiv上公开了一项研究,提出了反向传播的一种替代方案。他们的研究题为:

Biologically inspired alternatives to backpropagation through time for learning in recurrent neural nets

地址:https://arxiv.org/abs/1901.09049

供感兴趣的朋友们深入探索~