大数据文摘出品

编译:狗小白、张秋玥、Aileen

人类天生存在许多认知偏差,而这对科学进步危害巨大。科学研究倾向于偏好既有研究方法,进而导致许多研究体系中的内在特性被忽略。

因此,研究者很可能不幸花费毕生追索错误无意义的方向。回顾历史,科学长河中充斥着许多后人证明为错误因而毫无价值的研究。

Sabine Hossenfelder在她粒子物理学领域中写过这认知偏差。她在《迷失在数学中(Lost In Math)》一书中探索了一群世上***天赋的科学家们所具有的认知偏差。

她表示,这些科学家们虽具有优秀的认知能力,但在不懈追求美的道路上,理论物理学家们也走进了科学的误区,物理学在过去的四十来年内没出现任何重大突破。她认为,科学的客观性已屈服于采取具有美学意义的方法论。

这篇文章中,我会探索在人工智能(或强人工智能AGI)领域探索过程中存在的类似偏差。

可能存在的偏差之一即是贝叶斯定理的滥用。贝叶斯定理的产生启发自奥卡姆剃刀定律:“需要假设条件最少的理论解释最可能是正确的理论。”

因而,许多科学家们忠于他们的职业,并信仰“所有的事情都应该尽可能简单,但又不过分简单”的理念。

以上的确是人类理解世界的优秀法则,但也正是Hossenfelder所反对的美学主义。科学研究的重大突破往往依赖于科学家们某个瞬间的第六感,但这些假设不应导致对预感的武断应用。在此引用Richard Feynman的一句:“无论你的理论多么美妙,你又有多么聪明,但如果与实验结果相佐,你的理论就是错的。”

在此我想谈一谈大部分(强)人工智能研究者总是忽视的12个事实:

1. 直觉

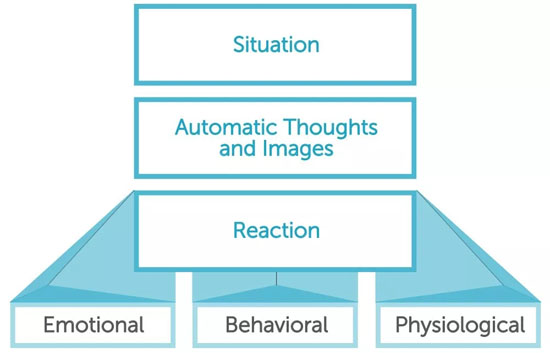

认知心理学家们早已确定,人类认知的运作依赖于两种独立的认知方式,这就是双过程理论。直觉思维与理性意识互为竞争又相互协作,支持着人类认知。老式的人工智能的失败可追溯至当时对人类认知主要基于理性认知系统的理念,虽然诸多证据表明并非如此。直觉认知系统才是驱动所有人类认知的本质发动机,人类认知普遍采用“分期推断”。

2. 睡眠

大自然要求睡眠占人类生***一个不小的部分。缺觉会导致认知障碍,最终可能致死。至少有实证证据表明,睡眠对认知发展具有重要意义。但不幸的是,很多研究者忽视了人类“待机状态下的”认知发展。而事实上,人类掌握抽象概念的能力很可能是在睡眠过程中成长的。

3. 不全面的呈现

很久以来,科学家们都试图找到内部心理的生成呈现出外部世界的存在,因此,老式的人工智能建立符号模型来倒映外部世界的语义。深度学习训练网络学习对世界的内部呈现,这个内部呈现在一个连续的高维空间反应出观察结果的语义。这个空间则允许诸如理性、相似性比较之类的操作。

这有两个问题:***个问题是内部呈现抛出了更深层的问题,绘制外部真实世界的内部呈现仍需要一些用以理解内部呈现的东西。第二个问题是,我们其实只关注我们观察到的世界里的其中一小部分。认知盲区是存在的,不像机器那样能够留下图片般的呈现,我们只关注很小一部分的图景,其它部分靠想象。James Gibson在他生态认知的理论中描述了另一种基于可供性的呈现,也即大脑仅仅捕获环境中可能存在的而非环境真实的反映。

4. 灵敏度

我们是如何仅靠触摸来分辨一个物体的?我们是如何靠摸就能辨认出棕色袋子里的苹果?很明显,感知并不仅靠现实世界的一张快照,而是由多角度的快照组合成一个前后一致的统一。人类拥有异乎寻常的灵巧的手,也许正因此我们才有了高级认知能力。我们对世界有更好的呈现,也许是因为我们与世界的参与度更高,且能够更好地分辨不相干信息。但在如今的研究中,却很少涉及认知方面的探索,以及一体化机制。

5. 有限的理性

人类并非全然的理性动物。大多数人无法同时处理五个以上的事情,几乎所有人都无法探索三层以上的递归信息。但大部分诸如AIXI、梭罗莫诺夫感应、符号计算和概率推理等AGI的议题都要求全然的理性。我想表达的是,简单启发式思维也许就是驱动人类思考的全部了,我们并不需要求助于优雅的数学方法。研究者倾向于从他们的“武器库”里取出那些数学工具来用,于是,要么把问题复杂化了,要么就是由于人类认知能力的问题而选错了工具。莫罗夫复杂度(Kolmogorov complexity) 是一个衡量复杂度的有趣的公式,但这个方法几乎没可能与人类的有限理性却完全的智能程度有任何相关性。

6. 描述性模型v.s.生成性模型

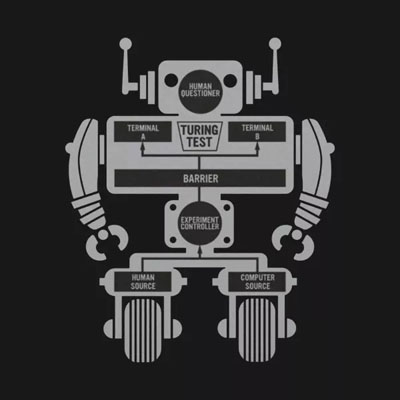

Daniel Dennett将革命和图灵机器人描述成“不能思考的技能拥有者”,因为他们拥有相当的能力来完成很多复杂的流程,但却不明白为什么这么做。当然这也是众所周知了。但这迷惑了许多不能理解复杂设计怎么能从非智能中生成的人们。我怀疑这是因为人类的认知偏差要求从混沌中找出规律,从而找到内在的设计。

关于现实的数学模型或逻辑模型都是描述性模型。这意味着,科学家们通过恒定的定律来分辨世界中的规律,而这些定律被视为现实世界的缩影描述。但是,描述性模型并非现实世界的本质,它们只不过是从复杂生成行为中观察出的规律。

即使不存在规律,人类也还是努力去寻找联系。我们看着天上的云,以为看到复活节兔子。但变化多端的云彩并非有意幻化成复活节兔子的样子,这是人类寻找世界规律过程中的一个主观臆断。这意味着,对世界的描述性模型至多只是在归纳现实行为中的特点,但并非是生成式模型。因此,如同概率模型等描述性模型模拟情景模拟得再好也只是模拟,与生成式模型不同。此外,“停机问题”意味着,通过观测的描述性模型来发现真实的生成式模型是不现实的。

7. 生成自远离均衡过程

生成性而非描述性的规律究竟缘何而起?热力学的第二定理表明了万物倾向于混沌。混沌在此指的是一个测量单位,也即熵值,描述了我们无法从观测中找到描述性的规律。Ilya Prigogine表示,远离均衡的状态下才能找到规律。而现今的机器学习方法论的问题在于,运用的数学总是假设一定的均衡状态。

然而,我们还是不能仅仅考虑自我管理的功能。认知能力会不断通过一个层层嵌套新出现能力的程式来锻炼提升自己。新出现问题的一项数学上的缺陷是,它无法被预先计算出来。这是因为每一项新出现的能力都会使可能组合的数量大大增加,而同时一些先前未知的事件变得已知。人类科技创新既是对此的直观描述。在万维网被发明之前,谁能想象到谷歌的今天呢?

8. 主观性

认知模型中最容易被忽视的信息之一则是关于自身的信息。所有生物学上的反应都与生物自身原始概念相关。也就是说,生物们的行为都由其生存与繁衍的基本目标驱动。所有的生物学原理都由这种维持自我边界的概念所驱动。因此当我们开始探索更高级的存在(比如我们自己)的时候,我们必须在模型中囊括自我的概念。这样做将导致自我模型需要被嵌入于某生态系统中。一个有认知的个体必须与能够意识到自我行为以及其行为如何与生态系统所交互的***人称视角模型相结合。

9. 纳米意向性

最简单的生物细胞中都存在维持自我的复杂认知行为。Michael Levin的研究表明,在缺少中央神经系统时,形态发生过程中会需要复杂的认知(也即生物电计算)。这个观点大大扭转了我们针对人类大脑建立的描述性模型。如果每一个神经元都与真核细胞拥有一致的复杂行为,那么深度学习发现的协调操作模型可能并不足以捕捉基本能力(比如协调能力与自我修复能力)。

10. 非静态认知模型

我们目前拥有的认知模型均为静态模型,并且适用于单件任务。然而,若想实现生物学级别的协调适应性,我们的认知模型并不能为静态模型;它们需要变得连续、及时并且可对话。我们需要最适合的启发式算法支持的持续场景切换以保证模型随着生态系统变化而调整。

结构是如何在一个复杂且动态的生态系统中被保存的呢?生物个体能够自我调节,拥有许多有意图的成员的生态系统也能够自我调节——存在防止事物偏离平衡点的更高一层机制。这将会是允许我们跟踪复杂对话的那项机制吗?

11. 集合而非个体

自我模型不能与其成长的生态分离。实际上,各项能力基本只能在与其成长的生态非常不同的环境中被培养出来。比如,生命需要氨基酸、DNA与脂质。这三项物质到底是如何各自进化成为互相必不可少的成分呢?它们很可能在不同的生态系统内各自进化直到在目前的生物圈内进入一个协同关系。总体来说,生命无法脱离其归属的生态系统。这可能也意味着,高级认知能力——比如语言能力——无法脱离人类存在的文化环境而成长。人们并非与生俱来地拥有语言能力,而是我们独特的文化教育了我们语言能力。

12. 产前发展与幼态持续发展

你有思考过为什么哺乳动物(比起更为原始的有袋类动物)会使其后代在子宫中发育吗? 你知道人类婴儿会在离开子宫真正出生之前数周就已拥有完整的认知能力了吗?我们假设人类认知发展在出生之后才开始,然而实际上关于它在出生之前就已开始的证据非常充足;也正因于此,许多母亲与世界的反应与交互反映在她子宫中的孩子身上。孩子在子宫中学到了什么呢?

另一项人类的独特之处在于,比起其他生物我们保持孩童外表的时间相对较长。2.5岁至3岁的人类与大猩猩认知水平类似。动物保持年幼外表的这一特性被称为幼态持续。以狗类为例,相较其狼类表亲,它们保持较大的眼睛、松弛的耳朵以及更短的鼻吻。蝾螈在其整个”人生“中都保持其婴儿时期的状态;他们拥有一项惊人的能力——重新长出其身体的一部分。

一项近期研究表明,在人类体内299项与年龄相关的基因中,有40项基因在人生后期才会被表达。实际上,为大众所知,成熟相对较快的人类会丧失部分认知能力。保持年轻确实对认知能力有好处。年轻人拥有比成年人更强的脑可塑性;更久地保持年轻能够使人们拥有更多时间来发展那些从社会中获得的认知技能(即模仿能力、语言能力与共情能力)。

人类可能比其他物种更有智慧是因为我们保持了更久的好奇与探索心这样的学习能力。

这***一点旨在告诉你,那些僵化的学习策略——比如依赖于其”武力、宗教或仇恨“的策略——是很难创新的。而那些试图探索新道路的则是最可能发掘出新事物的策略。

敲黑板总结一下!

你可能已经注意到了,这些盲点之间相互联系。它们并非毫不相关;结合在一起,它们为前沿AGI研究揭示了一种新颖的完整角度。上文有趣之处在于它与常见的过度注重技术问题的那些AGI研究截然不同。这可能是由大多数STEM课程带来的认知偏差导致的。

你不能搭建空中楼阁式的AGI模型;相反,你得从根基开始搭建——这意味着你得一步步培育它。因此我们需要一种自然而有逻辑的方法。尽管,”成长智慧“这一概念看起来显而易见,其实有大量研究者坚持走相反的道路(非常令人吃惊!)。很多人都有这样的偏见:AI就是工程学。而实际上它与心理学与生物学更为相关。

在Beyond Efficiency一文中,Dave Ackley讨论了为什么我们的计算系统如此脆弱这一问题。他认为这应归咎于”只能正确、只能高效“的心态。经常发生的计算机安全漏洞告诉我们,我们应当在其中应用生物学告诉我们的鲁棒性知识。Ackley怪罪于我们没有强调”系统性思考“。

系统性思考着重于一种关注结构的整体性方法;这与控制论相关(控制论学习控制、反馈、管制与交互)。高级AGI将需要我们更好地理解人类认知,以及对生物学复杂性的认识。因此我将在这里重述Arthur C. Clarke关于科技的名言。更精确地说这句话将为:任何足够先进的科技都与生物学密不可分。

相关报道:

https://medium.com/intuitionmachine/12-blind-spots-about-human-cognition-1883d0d58e0a

【本文是51CTO专栏机构大数据文摘的原创译文,微信公众号“大数据文摘( id: BigDataDigest)”】