亚马逊AI招聘工具被曝歧视女性,官方宣布解散团队,这事就完了吗?

这不禁让我想起,1911年辛亥革命后,上海外滩公园外立着的一块写有几行字的告示牌——“华人与狗不得入内”被拆除,上海人民稍微松了一口气。

但歧视不会缺席,也不会迟到。

直到今天,职场对女性的歧视依然严重,虽然少有用人单位明目张胆的声张只招男性不找女性,但招聘女性时设置的门槛却无不写着歧视,除了考察工作能力,还要考量婚姻状况,家庭状况、生育状态等等。并且,这些问题在入职前,这些你一直以为的隐私的都会被赤裸裸的直接提问。

更让人感到无力的是,随着人工智能技术的进步,这种职场歧视似乎在不断加深。这两天,亚马逊AI招聘工具被曝性别歧视,该系统会给予包含“女性”这个词的简历以低星评级。即使技术人员修改程序使得系统在特定术语上秉持中立的原则,但是接下机器还会有什么新的歧视,无人知晓。

数据是社会的产物,技术中立是不可能的

技术中立是不可能中立的,这辈子都不可能。

你以为的技术中立是什么?不含偏见,不偏不倚,人人都能平等的享受科技带来的便捷。

这是企业的宣传语但不是事实。任何一种技术的发明一定免不了沾满了有血有肉的人的“色彩”,它由人塑造,受当下的社会环境影响,是社会的产物。而人工智能技术,它由数据驱动,由于数据具有一定的社会属性,所以数据里的歧视,会完整的反射到了人工智能招聘机器上甚至会被成倍放大。

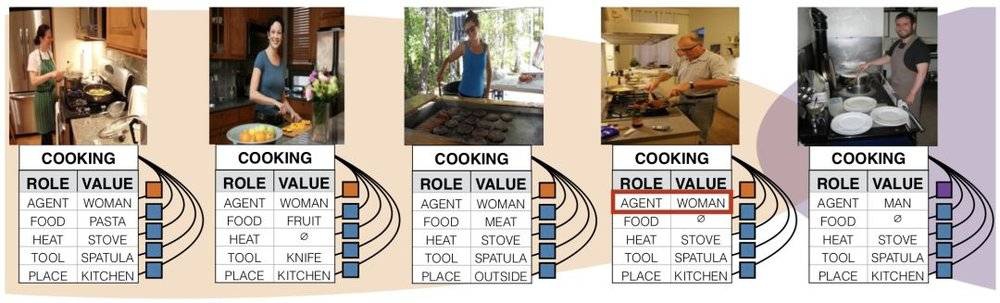

果壳网文章《当AI学会性别歧视》里提到一个案例,有一位研究人员的研究内容是辨认场景复杂生活照,她发现,男人被认成女人的图片有一些共同点——都是站在厨房里,或者在做家务。

这并不是哪里出现了问题,而是机器从大数据里得到的认知就是女人和某些特定的元素有关,比如厨房,比如家务。看来不管哪个国家,女性都多于家庭联系在一起。

波伏娃说,一个人不是生来就是女人,她是变成女人的。

我们毫无知觉的变成了女人,又不自觉的向女性身份看齐表示认同。机器仿佛是《皇帝的新衣》里那个天真小孩,敏锐的察觉我们身为女人所带有的标签(主动或被动),最后以一种近乎残酷的方式呈现出来。就像人们常常觉得男生比女生更适合理科一样,人们固有的观念是男性比女性更适合领导岗位,男性比女性更擅于决策等等。在谷歌的广告服务中,男性会比女性看到更多的高薪招聘广告,这些既定的事实使得女性的职场天花板愈加明显。

乐观一点说,随着社会的进步,职场对女性的歧视将会慢慢改变,悲观一点,……还是不说了吧。在实际的机器训练中,数据驱动的技术如果能全面反映数据本身的内在联系,人们无疑会认可这门技术,但是如果这门技术反应的内在联系是人们不希望它反应的呢?这些明晃晃、大剌剌、冷冰冰的职场歧视,一句所谓的技术中立,就能解释吗?

正如剑桥大学教授鲁恩•奈如普(Rune Nyrup)所言,“没有事实上的技术中立。对机器来说,中立的就是占统治地位的。”

在AI招聘上,有公平算法吗?

关于人工智能歧视的问题已经发生多起,比如谷歌的图片软件曾错将黑人标记为“大猩猩”,微软的Tay 仅仅上线一天, 就变成了一个集反犹太人、性别歧视、种族歧视等于一身的“不良少女”等等。那么在未来,人工智能招聘是否可以实现真正的公平呢?

实际上AI可应用于招聘的很多环节,比如筛选简历,视频面试,聊天面试等。筛选简历是一个大工程,少则几十份,多则几百份。曾有一个做HR的朋友说,有时候简历实在太多就分成两半,另一半直接扔垃圾桶……因此,这种重复且琐碎的活最适合人工智能来干。但人工智能筛选简历需要将公平量化,使公平被翻译成可操作性的算法。

而利用人工智能聊天机器人,不管是视频聊天还是其他形式的聊天,机器人都需要具备一定的分析能力,比如分析求职者的语调、眼神和回答的表情,来判断求职者是否对工作富有热情。但这同样需要公平算法,毕竟智能相对论(aixdlun)分析师雷宇的眯眯眼被人认定为打瞌睡也不是一两次了。

那么公平可以被量化吗?

2011年《科学》杂志上的一项研究显示,情绪可以被数据化,来自世界上不同文化背景的人们每天、每周的心情都遵循着相似的模式。这项研究建立在两年多来对84个国家240万人的5.09亿条微博的数据分析上。

但是公平比情绪要抽象得多,而且如果人工智能需要研究公平算法,谁来决定公平的考量因素呢?这似乎陷入了一个死循环。

我们很难将公平量化,也就不说公平算法了。现阶段的人工智能招聘官一般用在低水平入门级别的工作招聘中,而稍微要求高一点的招聘,AI最多能起辅助作用,也就是科大讯飞所说的“人机耦合”。

歧视无处不在,子子孙孙无穷尽也

在发生人工智能招聘歧视之后,亚马逊拒绝对于该招聘引擎或面临的挑战作出评论,并表示自己一直致力于保证公司的员工多样性和平等。

但智能相对论想要提醒大家的是,亚马逊也致力于成为“地球上最以消费者为中心的公司“,但有研究发现,亚马逊的购物推荐系统却一直偏袒其自己及其合作伙伴的商品,即使其他卖家的商品的价格更低。而在购物比价服务中,亚马逊隐瞒了其自己以及其合作伙伴的商品的运费,导致消费者不能得到一个公正的比价结果。

商家为了自身利益最大化,会有无数歧视的手段和理由。同样,职场中的女性,会被无数看似正当的理由歧视,未婚未孕?企业方担心你休婚假产假,未婚已孕?企业方担心你生小孩要耽误一年,其中最可怕的就是大龄未婚的女青年了……

100多年过去了,上海已经俨然成了一个像模像样的大都市,但也成了这个时代歧视外地人的典型。

这样看上海的我,又何尝不是歧视呢。