神经网络的基本思想是模拟计算机“大脑”中多个相互连接的细胞,这样它就能从环境中学习,识别不同的模式,进而做出与人类相似的决定。

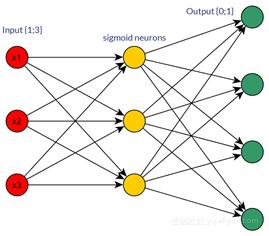

典型的神经网络是由数千互连的人工神经元组成,神经元是构成神经网络的基本单位。这些神经元按顺序堆叠在一起,以称为层的形式形成数百万个连接。单位划分如下:

- 输入单元:用于接收外部环境的信息;

- 隐藏单元:隐藏层将所需的计算及输出结果传递给输出层;

- 输出单元:输出信号表明网络是如何响应最近获得的信息。

多数神经网络都是“全连接的”,也就是说,每一个隐藏单元和输出单元都与另一边的所有单元相连接。每个单元之间的连接称为“权重”,权重可正可负,这取决于它对另一个单元的影响程度。权重越大,对相关单元的影响也就越大。

前馈神经网络是一种最简单的神经网络,各神经元分层排列。每个神经元只与前一层的神经元相连。接收前一层的输出,并输出给下一层,各层间没有反馈。是目前应用最广泛、发展最迅速的人工神经网络之一。

下面将就神经网络与深度学习发展的几大重要趋势进行讨论:

1. 胶囊网络(Capsule Networks)

胶囊网络是一种新兴的深层神经网络,其处理信息的方式类似于人脑。

胶囊网络与卷积神经网络相反,虽然卷积神经网络是迄今为止应用最广泛的神经网络之一,但其未能考虑简单对象和复杂对象之间存在的关键空间层次结构。这导致了误分类并带来了更高的错误率。

在处理简单的识别任务时,胶囊网络拥有更高的精度,更少的错误数量,并且不需要大量的训练模型数据。

2. 深度强化学习(Deep Reinforcement Learning, DRL)

深度强化学习是神经网络的一种形式,它的学习方式是通过观察、行动和奖励,与周围环境进行交互。深度强化学习已经被成功地用于游戏策略的制定,如Atari和Go。AlphaGo击败了人类冠军棋手,是深度强化学习最为著名的应用。

3. 数据增强(Lean and augmented data learning)

到目前为止,机器学习与深度学习遇到的***挑战是:需要大量使用带标签的数据来训练系统。目前有两种应用广泛的技巧可以帮助解决这个问题:

- 合成新的数据

- 迁移学习

“迁移学习”,即把从一个任务或领域学到的经验迁移到另一个任务或领域,“一次学习”指迁移学习应用到极端情况下,在只有一个相关例子,甚至没有例子的情况下学习。由此它们成为了“精简数据”的学习技巧。与之相仿,当使用模拟或内插合成新的数据时,它有助于获取更多的训练数据,因而能够增强现有数据以改进学习。

通过运用上述技巧,我们能够解决更多的问题,尤其是在历史数据较少的情况下。

4. 监督模型(Supervised Model)

监督模型时一种学习形式,它根据预先标记的训练数据学到或建立一个模式,并依此模式推断新的实例。监督模型使用一种监督学习的算法,该算法包括一组输入和标记正确的输出。

将标记的输入与标记的输出进行比较。给定两者之间的变化,计算一个误差值,然后使用一个算法来学习输入和输出之间的映射关系。

5. 网络记忆模型(Networks With Memory Model)

人类和机器的一个典型区别在于工作和严谨思考的能力。我们可以对计算机进行编程,使其以极高的准确率完成特定的任务。但是如果我们想要它在不同的环境中工作,还有需要解决很多问题。

要想使机器适应现实世界的环境,神经网络必须能够学习连续的任务且不产生“灾难性忘却(catastrophic forgetting)”,这便需要许多方法的帮助,如:

- 长期记忆网络(Long-Term Memory Networks):它能够处理和预测时间序列

- 弹性权重巩固算法(Elastic Weight Consolidation, EWC):该方法能够选择性地减慢对这些任务而言比较重要的权重的学习速率

- 渐进式神经网络(Progressive Neural Networks):不会产生“灾难性忘却”,它能够从已经学会的网络中提取有用的特征,用于新的任务

6. 混合学习模式(Hybrid Learning Models)

不同类型的深度神经网络,例如生成式对抗网络(GANs)以及深度强化学习(DRL),在性能提升和广泛应用方面展现了了巨大的潜力。不过,深度学习模型不能像贝叶斯概率那样为不确定性的数据场景建模。

混合学习模式结合了这两种方法的优势,典型的混合学习模式包括贝叶斯生成对抗网络(Bayesian GANs)以及贝叶斯条件生成对抗网络(Bayesian Conditional GANs)。

混合学习模式将商业问题的范围扩大,使其能够解决具有不确定性的深度学习问题,从而提高模型的性能,增强模型的可解释性,实现更加广泛的运用。