【51CTO.com快译】近年来,深度学习的大潮席卷了互联网的各个角落。从金融科技到电商,从反欺诈到推荐系统,随处都可以见到深度学习的身影。深度学习的本质是神经网络,而由于神经网络的深度较深,如何能够快速高效的进行计算成为了深度学习很重要的课题。针对训练神经网络的随机梯度下降问题,学者们分别提出了亚当方法(Adam)和夏娃(Eve)方法,成为了解决深度学习问题的利器。

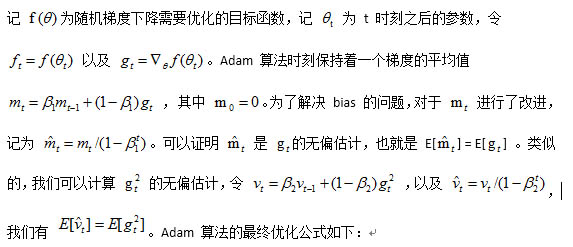

我们先来看一下什么是亚当(Adam)方法:

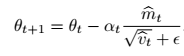

Hiroaki Hiyashi , Jayanth Koushik , Graham Neubig 在论文 Eve: A Gradient Based Optimization Method with Locally and Globally Adaptive Learning Rates 中提出了一种改进 Adam (亚当) 算法的方法,命名为 Eve (夏娃)方法。 夏娃方法是在亚当算法的基础上进行了改进,我们先来看一下算法的伪代码:

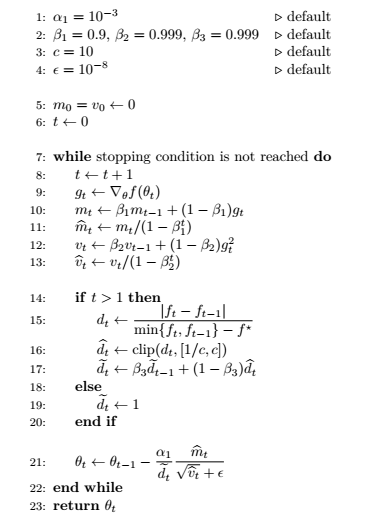

***,在针对数据的稳定性问题和平滑性问题,我们对学习速率进行处理,就得到了***在算法伪代码中展示的步骤。

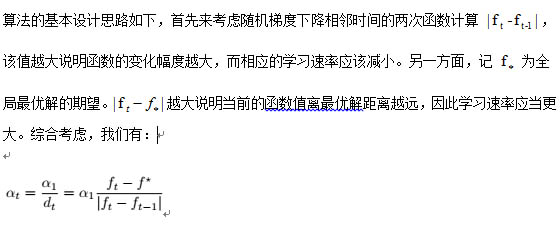

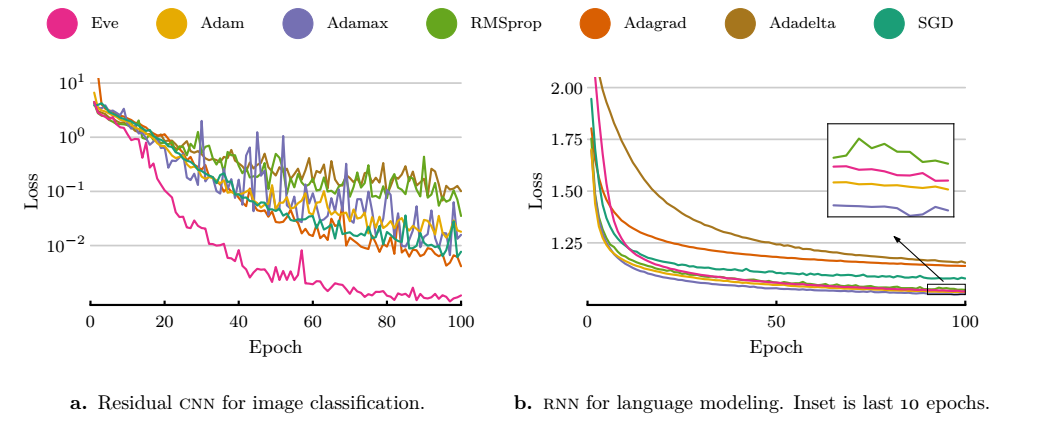

Adam 算法和 Eve 算法在 CNN 和 RNN 模型的测评结果如下图所示:

可以看到 Eve 算法在 CNN 上取得了比其他算法都要好的效果,而在 RNN 上的效果也表现不错。

机器学习和数据挖掘流行了这么多年,其实离不开统计概率和***化的根基。平常大多数机器学习和数据挖掘的从业者都是在工业界深耕,因此对于数学本身的掌握程度要求没有那么高深。特别是在中国的企业,一般能做到跟进国际***的潮流就可以了。

然而有的时候沉寂下来,用心钻研一下数学对于自己技术上的理解和深造是很有帮助的。Adam 算法和 Eve 算法本身的数学原理并不复杂,用到的唯一的统计学概念是无偏统计量,值得广大从业者认真学习其简单优美的思路。

汪昊,恒昌利通大数据部负责人/资深架构师,美国犹他大学本科/硕士,对外经贸大学在职MBA。曾在百度,新浪,网易,豆瓣等公司有多年的研发和技术管理经验,擅长机器学习,大数据,推荐系统,社交网络分析等技术。在 TVCG 和 ASONAM 等国际会议和期刊发表论文 8 篇。本科毕业论文获国际会议 IEEE SMI 2008 ***论文奖。

【51CTO译稿,合作站点转载请注明原文译者和出处为51CTO.com】